《持续交付》好评推荐

“如果你需要更频繁地部署软件,这本书就是为你准备的。应用书中的内容将帮助你降低风险、消除繁琐工作并增强信心。我会在我所有的当前项目中使用这里的原则和实践。”

—Kent Beck, Three Rivers Institute

“无论你的软件开发团队是否已经理解持续集成和源代码控制一样必不可少,这都是必读书籍。这本书的独特之处在于将整个开发和交付过程联系在一起,提供了哲学和原则,而不仅仅是技术和工具。作者让从测试自动化到自动化部署的主题对广大读者都易于理解。开发团队中的每个人,包括程序员、测试人员、系统管理员、数据库管理员和经理,都需要阅读这本书。”

—Lisa Crispin,《敏捷测试》合著者

“对于许多组织来说,持续交付不仅仅是一种部署方法,它对业务运营至关重要。这本书向你展示如何在你的环境中使持续交付成为有效的现实。”

—James Turnbull,《Puppet实战》作者

“一本清晰、精确、写得很好的书,让读者了解发布过程中的期望。作者对软件部署的期望和障碍进行了循序渐进的说明。这本书是任何软件工程师藏书的必备品。”

—Leyna Cotran, 加州大学欧文分校软件研究所

“Humble 和 Farley 阐述了使快速增长的Web应用成功的要素。持续部署和交付已经从有争议变为普遍,这本书对此进行了出色的介绍。它真正体现了开发和运维在多个层面的交叉,这些作者把握得非常准确。”

—John Allspaw, Etsy.com技术运营副总裁,《容量规划的艺术》和《Web运维》作者

“如果你从事构建和交付基于软件的服务业务,深入理解《持续交付》中如此清晰解释的概念将使你受益匪浅。但除了概念之外,Humble 和 Farley 还提供了一个出色的快速可靠交付变更的行动手册。”

—Damon Edwards, DTO Solutions总裁和dev2ops.org联合编辑

“我相信任何处理软件发布的人都能够拿起这本书,翻到任何章节并快速获得有价值的信息;或者从头到尾阅读这本书,并能够以适合其组织的方式简化他们的构建和部署流程。在我看来,这是构建、部署、测试和发布软件的必备手册。”

—Sarah Edrie, 哈佛商学院质量工程总监

“持续交付是任何现代软件团队在持续集成之后的合乎逻辑的下一步。这本书采用了持续向客户交付有价值软件这一公认雄心勃勃的目标,并通过一套清晰有效的原则和实践使其可实现。”

—Rob Sanheim, Relevance公司首席顾问

Jez Humble 和 David Farley 著

Upper Saddle River, NJ •

Boston • Indianapolis • San Francisco New York • Toronto • Montreal •

London • Munich • Paris • Madrid Cape Town • Sydney • Tokyo • Singapore

• Mexico City

Upper Saddle River, NJ •

Boston • Indianapolis • San Francisco New York • Toronto • Montreal •

London • Munich • Paris • Madrid Cape Town • Sydney • Tokyo • Singapore

• Mexico City

制造商和销售商用于区分其产品的许多名称被声明为商标。当这些名称出现在本书中,且出版商知晓商标声明时,这些名称已用首字母大写或全部大写字母印刷。

作者和出版商在本书的准备过程中已尽力谨慎,但不做任何明示或暗示的保证,也不对错误或遗漏承担责任。对于因使用本书中包含的信息或程序而产生或引起的附带或间接损害,不承担任何责任。

当批量购买或特别销售本书时,出版商提供优惠折扣,其中可能包括电子版本和/或针对您的业务、培训目标、营销重点和品牌利益定制的封面和内容。有关更多信息,请联系:

美国企业和政府销售 (800) 382-3419 corpsales@pearsontechgroup.com

美国以外的销售请联系:

国际销售 international@pearson.com

访问我们的网站:informit.com/aw

国会图书馆出版物编目数据:

Humble, Jez.

持续交付:通过构建、测试和部署自动化实现可靠的软件发布 / Jez Humble, David Farley. p. cm.

包括参考文献和索引。

ISBN 978-0-321-60191-9 (精装 : alk. paper) 1. 计算机软件–开发。2. 计算机软件–可靠性。3. 计算机软件–测试。I. Farley, David, 1959-II. 书名。

QA76.76.D47H843 2010

005.1–dc22

版权所有 © 2011 Pearson Education, Inc.

保留所有权利。在美国印刷。本出版物受版权保护,在进行任何禁止的复制、存储在检索系统中或以任何形式或方式(电子、机械、影印、录制或类似方式)传输之前,必须获得出版商的许可。有关权限的信息,请写信至:

Pearson Education, Inc Rights and Contracts Department 501 Boylston Street, Suite 900 Boston, MA 02116 传真 (617) 671 3447

ISBN-13: 978-0-321-60191-9 ISBN-10: 0-321-60191-2 文本在美国印第安纳州克劳福兹维尔的RR Donnelley用再生纸印刷。

首次印刷 2010年8月

本书献给我的父亲,他一直给予我无条件的爱和支持。 —Jez

本书献给我的父亲,他总是为我指引正确的方向。 —Dave

前言

序言

致谢

关于作者

第一部分:基础

第1章:软件交付的问题

引言

一些常见的发布反模式

反模式:手动部署软件

反模式:仅在开发完成后才部署到类生产环境

反模式:生产环境的手动配置管理

我们能做得更好吗?

我们如何实现目标?

每次变更都应触发反馈过程

必须尽快收到反馈

交付团队必须接收反馈并据此采取行动

这个过程能扩展吗?

有哪些好处?

赋能团队

减少错误

降低压力

部署灵活性

熟能生巧

发布候选版本

每次检入都会产生一个潜在发布版本

软件交付原则

创建可重复、可靠的软件发布流程

几乎一切都自动化

将所有内容纳入版本控制

如果某事很痛苦,就更频繁地做它,并将痛苦提前

内建质量

完成意味着已发布

每个人都对交付过程负责

持续改进

总结

第2章:配置管理

引言

使用版本控制

将所有内容都纳入版本控制

定期检入主干

使用有意义的提交信息

管理依赖关系

管理外部库

管理组件

管理软件配置

配置与灵活性

配置类型

管理应用程序配置

跨应用程序管理配置

管理应用程序配置的原则

管理您的环境

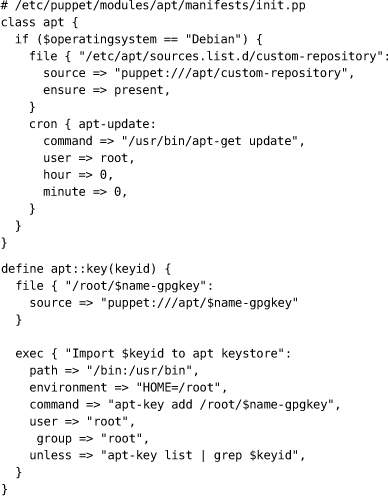

管理环境的工具

管理变更过程

总结

第3章:持续集成

引言

实施持续集成

开始之前需要什么

基本的持续集成系统

持续集成的先决条件

定期检入

创建全面的自动化测试套件

保持构建和测试过程简短

管理您的开发工作空间

使用持续集成软件

基本操作

附加功能

基本实践

不要在构建失败时检入

在提交前始终在本地运行所有提交测试,或让您的CI服务器为您执行此操作

等待提交测试通过后再继续

永远不要在构建失败时下班回家

始终准备好恢复到先前的版本

在恢复前设定修复时间限制

不要注释掉失败的测试

对您的更改导致的所有故障负责

测试驱动开发

建议实践

极限编程(XP)开发实践

架构违规时使构建失败

测试缓慢时使构建失败

警告和代码风格违规时使构建失败

分布式团队

对流程的影响

集中式持续集成

技术问题

替代方法

分布式版本控制系统

总结

第4章:实施测试策略

引言

测试类型

支持开发过程的面向业务测试

支持开发过程的面向技术测试

评估项目的面向业务测试

评估项目的面向技术测试

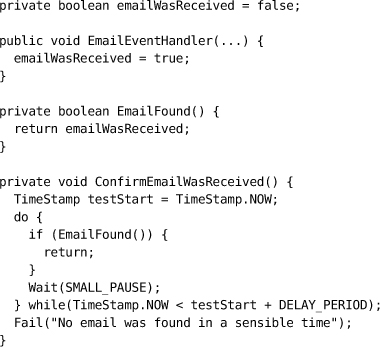

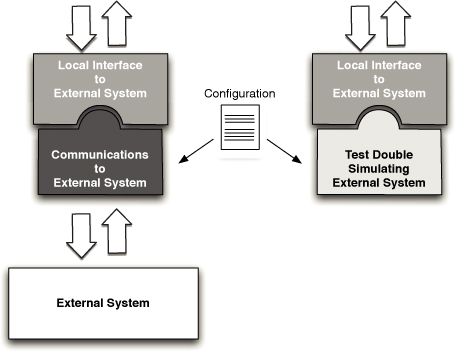

测试替身(Test Doubles)

实际情况和策略

新项目

项目中期

遗留系统

集成测试

流程

管理缺陷积压

总结

第二部分:部署流水线

第5章:部署流水线剖析

引言

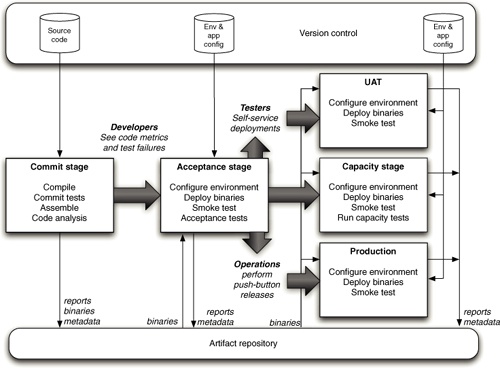

什么是部署流水线?

基本的部署流水线

部署流水线实践

只构建一次二进制文件

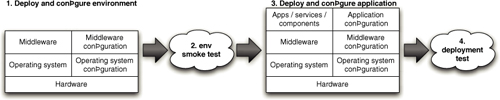

以相同方式部署到每个环境

对您的部署进行冒烟测试

部署到生产环境的副本

每次变更应立即通过流水线传播

如果流水线的任何部分失败,停止生产线

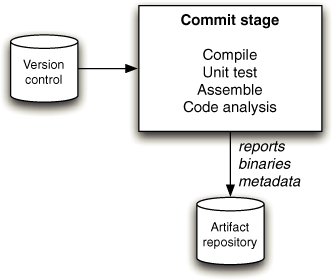

提交阶段

提交阶段最佳实践

自动化验收测试关卡

自动化验收测试最佳实践

后续测试阶段

手动测试

非功能性测试

准备发布

自动化部署和发布

回退变更

在成功的基础上构建

实施部署流水线

建模您的价值流并创建行走骨架

自动化构建和部署过程

自动化单元测试和代码分析

自动化验收测试

演进您的流水线

度量指标

总结

第6章:构建和部署脚本

引言

构建工具概览

Make

Ant

NAnt和MSBuild

Maven

Rake

Buildr

Psake

构建和部署脚本的原则与实践

为部署流水线中的每个阶段创建脚本

使用适当的技术部署您的应用程序

使用相同的脚本部署到每个环境

使用操作系统的打包工具

确保部署过程是幂等的

增量演进您的部署系统

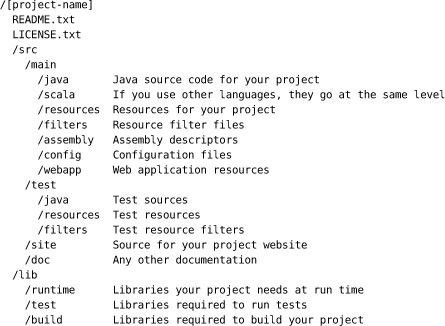

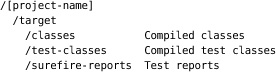

面向JVM的应用程序项目结构

项目布局

部署脚本

在90年代末,我拜访了Kent Beck,当时他在瑞士为一家保险公司工作。他向我展示了他的项目,他那支高度自律的团队的一个有趣之处在于他们每天晚上都会将软件部署到生产环境。这种定期部署给他们带来了许多优势:编写的软件不会无用地等待部署,他们可以快速响应问题和机遇,快速的周转导致他们与业务客户和最终客户之间建立了更深入的关系。

在过去十年中,我在ThoughtWorks工作,我们项目的一个共同主题是缩短从想法到可用软件之间的周期时间。我看到很多项目案例,几乎所有项目都涉及坚定地缩短这个周期。虽然我们通常不会每天部署到生产环境,但现在看到团队进行双周发布已经很常见了。

Dave和Jez是这场巨变的一部分,他们积极参与了建立频繁、可靠交付文化的项目。他们和我们的同事已经将那些每年难以部署一次软件的组织带入了持续交付的世界,在这个世界里,发布变成了例行公事。

至少对于开发团队来说,这种方法的基础是持续集成(Continuous Integration, CI)。CI使整个开发团队保持同步,消除了集成问题导致的延迟。几年前,Paul Duvall在这个系列中写了一本关于CI的书。但CI只是第一步。成功集成到主线代码流中的软件仍然不是在生产环境中执行其工作的软件。Dave和Jez的书从CI继续讲述这个故事,描述如何构建将集成代码转变为生产软件的部署流水线。

这种交付思维长期以来一直是软件开发中被遗忘的角落,陷入开发团队和运维团队之间的空白地带。因此,本书中的技术基于将这些团队聚集在一起也就不足为奇了——这是新兴但不断增长的DevOps运动的先兆。这个过程还涉及测试人员,因为测试是确保无错误发布的关键要素。贯穿所有这些的是高度的自动化,因此可以快速且无错误地完成工作。

让所有这些运作起来需要付出努力,但好处是深远的。漫长、高强度的发布成为过去。软件的客户看到想法迅速转变为他们每天可以使用的工作代码。也许最重要的是,我们消除了软件开发中最大的压力源之一。没有人喜欢那些紧张的周末,试图在周一黎明之前完成系统升级发布。

在我看来,一本能向你展示如何频繁且无需通常压力地交付软件的书是必读的。为了你的团队,我希望你同意这一点。

昨天你的老板要求你向客户演示系统的强大新功能,但你无法展示任何内容。你的所有开发人员都在开发新功能的中途,现在没有人能运行应用程序。你有代码,它可以编译,持续集成服务器上的所有单元测试都通过了,但将新版本发布到可公开访问的UAT环境需要几天时间。在如此短的通知时间内期待演示是不是不合理?

你的生产环境中有一个严重的bug。它每天都在给你的业务造成损失。你知道修复方法是什么:在三层系统的所有三层中使用的库中改一行代码,以及对一个数据库表进行相应的更改。但上次你将软件的新版本发布到生产环境时,花了整个周末工作到凌晨3点,而且负责部署的人在那之后不久就因厌恶而辞职了。你知道下次发布将会超过周末,这意味着应用程序将在工作日期间停机一段时间。要是业务部门能理解我们的问题就好了。

这些问题虽然太常见了,但并不是软件开发过程不可避免的结果:它们表明出了问题。软件发布应该是一个快速、可重复的过程。如今,许多公司一天内发布多个版本。即使是具有复杂代码库的大型项目,这也是可能的。在本书中,我们将向你展示如何做到这一点。

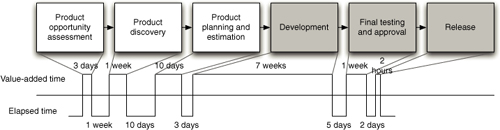

Mary和Tom Poppendieck问道:“你的组织部署一个只涉及一行代码的更改需要多长时间?你是否在可重复、可靠的基础上做到这一点?”从决定需要进行更改到将其部署到生产环境的时间称为周期时间(cycle time),它是任何项目的重要指标。

在许多组织中,周期时间以周或月为单位来衡量,发布过程肯定不是可重复或可靠的。它是手动的,通常需要一个团队来将软件部署到测试或预发环境,更不用说部署到生产环境了。然而,我们遇到过同样复杂的项目,这些项目一开始是这样的,但在经过广泛的重新设计后,团队能够将关键修复的周期时间缩短到几小时甚至几分钟。这是可能的,因为创建了一个完全自动化、可重复、可靠的过程,用于将更改通过构建、部署、测试和发布过程的各个阶段。自动化是关键。它允许开发人员、测试人员和运维人员通过按下按钮来执行创建和部署软件所涉及的所有常见任务。

本书描述了如何通过缩短从想法到实现业务价值的路径(周期时间),使其更短、更安全,从而彻底改变软件交付。

软件在到达用户手中之前不会产生收入。这是显而易见的,但在大多数组织中,将软件发布到生产环境是一个手动密集、容易出错且风险高的过程。虽然以月为单位衡量的周期时间很常见,但许多公司的情况要糟糕得多:超过一年的发布周期并非闻所未闻。对于大公司来说,从有想法到发布实现它的代码之间的每一周延迟都可能代表数百万美元的机会成本,然而这些公司往往是周期时间最长的。

尽管如此,允许低风险交付软件的机制和流程尚未成为当今大多数软件开发项目的组成部分。

我们的目标是使软件从开发人员手中交付到生产环境成为一个可靠、可预测、可见且在很大程度上自动化的过程,具有充分理解、可量化的风险。使用我们在本书中描述的方法,可以在几分钟或几小时内从有想法到将实现它的工作代码交付到生产环境,同时提高交付软件的质量。

交付成功软件的大部分相关成本是在首次发布后产生的。这是支持、维护、添加新功能和修复缺陷的成本。对于通过迭代过程交付的软件来说尤其如此,其中首次发布包含为客户提供价值的最少功能。因此本书的标题为《持续交付》(Continuous Delivery),取自敏捷宣言的第一原则:“我们的最高优先级是通过早期和持续交付有价值的软件来满足客户”。这反映了现实:对于成功的软件,首次发布只是交付过程的开始。

我们在本书中描述的所有技术都减少了向用户交付软件新版本的时间和风险。它们通过增加反馈并改善负责交付的开发、测试和运维人员之间的协作来实现这一点。这些技术确保当你需要修改应用程序时,无论是修复bug还是交付新功能,从进行修改到将结果部署并投入使用的时间尽可能短,问题在容易修复的早期就被发现,并且相关风险被充分理解。

本书的主要目标之一是改善负责交付软件的人员之间的协作。特别是,我们考虑的是开发人员、测试人员、系统和数据库管理员以及管理人员。

我们涵盖的主题包括:从传统的配置管理、源代码控制、发布规划、审计、合规性和集成,到构建、测试和部署过程的自动化。我们还描述了诸如自动化验收测试、依赖管理、数据库迁移以及测试和生产环境的创建和管理等技术。

许多参与软件创建的人认为这些活动是编写代码的次要工作。然而,根据我们的经验,这些活动会占用大量时间和精力,并且对成功交付软件至关重要。当围绕这些活动的风险没有得到充分管理时,它们最终可能会花费大量资金,通常超过最初构建软件的成本。本书提供您需要的信息来理解这些风险,更重要的是,描述了缓解这些风险的策略。

这是一个雄心勃勃的目标,当然我们无法在一本书中详细涵盖所有这些主题。实际上,我们可能会疏远我们的每一个目标受众:开发人员,因为未能深入讨论架构、行为驱动开发和重构等主题;测试人员,因为没有花足够时间讨论探索性测试和测试管理策略;运维人员,因为没有充分关注容量规划、数据库迁移和生产监控。

然而,已经有书籍详细讨论了这些主题。我们认为文献中缺少的是一本讨论所有活动部分如何协同工作的书:配置管理、自动化测试、持续集成和部署、数据管理、环境管理和发布管理。精益软件开发运动教给我们的一点是,优化整体很重要。为了做到这一点,需要采用整体方法,将交付过程的每个部分以及参与其中的每个人联系在一起。只有当您能够控制每个变更从引入到发布的进展时,您才能开始优化和提高软件交付的质量和速度。

我们的目标是提出一种整体方法,以及这种方法所涉及的原则。我们将为您提供所需的信息,以决定如何在自己的项目中应用这些实践。我们不认为软件开发的任何方面都有”一刀切”的方法,更不用说像企业系统的配置管理和运营控制这样庞大的主题领域了。然而,我们在本书中描述的基本原理广泛适用于各种不同的软件项目——无论是大型、小型、高度技术性的项目,还是快速冲刺以实现早期价值的项目。

当您开始将这些原则付诸实践时,您将发现针对您特定情况需要更多细节的领域。本书末尾有参考书目,以及在线其他资源的指引,您可以在其中找到有关我们涵盖的每个主题的更多信息。

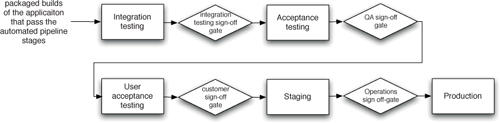

本书由三个部分组成。第一部分介绍持续交付背后的原则以及支持它所需的实践。第二部分描述了本书的核心范式——我们称之为部署流水线(deployment pipeline)的模式。第三部分更详细地介绍了支持部署流水线的生态系统——实现增量开发的技术;高级版本控制模式;基础设施、环境和数据管理;以及治理。

这些技术中的许多可能看起来只适用于大规模应用程序。虽然我们的大部分经验确实来自大型应用程序,但我们相信即使是最小的项目也能从这些技术的全面掌握中受益,原因很简单:项目会增长。您在启动小型项目时做出的决策将不可避免地影响其演进,通过以正确的方式开始,您将为自己(或后来者)节省后续过程中的大量痛苦。

本书作者拥有精益和迭代软件开发哲学的背景。这意味着我们的目标是快速迭代地向用户交付有价值的、可工作的软件,持续努力从交付过程中消除浪费。我们描述的许多原则和技术最初是在大型敏捷项目的背景下开发的。然而,我们在本书中介绍的技术具有普遍适用性。我们的大部分重点是通过更好的可见性和更快的反馈来改善协作。这将对每个项目产生积极影响,无论它是否使用迭代软件开发过程。

我们努力确保章节甚至章节内的部分都可以独立阅读。至少,我们希望您需要了解的任何内容以及对更多信息的引用都清晰地标示出来并且易于访问,以便您可以将本书用作参考。

我们应该提到,我们在处理所涵盖的主题时并不追求学术严谨性。市场上有很多更理论化的书籍,其中许多提供了有趣的阅读和见解。特别是,我们不会在标准上花费太多时间,而是专注于在软件项目中工作的每个人都会发现有用的经过实战检验的技能和技术,并清晰简单地解释它们,以便它们可以在现实世界中每天使用。在适当的情况下,我们将提供一些实战案例来说明这些技术,以帮助将它们置于背景中。

我们知道并非每个人都想从头到尾阅读这本书。我们在编写时考虑到了这一点,一旦你阅读完引言部分,就可以通过几种不同的方式来学习本书。这涉及一定程度的重复,但希望不会让那些决定从头到尾阅读的读者感到乏味。

本书由三个部分组成。第一部分,章节1到4,带你了解规律的、可重复的、低风险发布的基本原则以及支持这些原则的实践。第二部分,章节5到10,描述部署流水线(deployment pipeline)。从第11章开始,我们深入探讨支持持续交付的生态系统。

我们建议每个人都阅读第1章。我们相信那些刚接触软件发布流程的人,即使是经验丰富的开发人员,也会发现大量材料挑战他们对专业软件开发的理解。本书的其余部分可以在闲暇时翻阅—或者在紧急情况下查阅。

第一部分描述了理解部署流水线的前提条件。每一章都建立在前一章的基础上。

第1章,“软件交付的问题”,首先描述了我们在许多软件开发团队中看到的一些常见反模式(antipatterns),然后描述我们的目标以及如何实现它。最后,我们阐述了本书其余部分所基于的软件交付原则。

第2章,“配置管理”,阐述如何管理构建、部署、测试和发布应用程序所需的一切,从源代码和构建脚本到环境和应用程序配置。

第3章,“持续集成”,涵盖了针对应用程序的每次变更构建和运行自动化测试的实践,以便确保软件始终处于可工作状态。

第4章,“实施测试策略”,介绍了构成每个项目不可或缺部分的各种手动和自动化测试,并讨论如何决定哪种策略适合你的项目。

本书的第二部分详细介绍部署流水线,包括如何实现流水线中的各个阶段。

第5章,“部署流水线剖析”,讨论了构成本书核心的模式—一个从签入(check-in)到发布的每次变更的自动化流程。我们还讨论如何在团队和组织层面实施流水线。

第6章,“构建和部署脚本”,讨论可用于创建自动化构建和部署流程的脚本技术,以及使用它们的最佳实践。

第7章,“提交阶段”,涵盖流水线的第一阶段,这是一组应该在应用程序引入任何变更时立即触发的自动化流程。我们还讨论如何创建快速、有效的提交测试套件。

第8章,“自动化验收测试”,介绍从分析到实施的自动化验收测试。我们讨论为什么验收测试对持续交付至关重要,以及如何创建一个具有成本效益的验收测试套件来保护应用程序的重要功能。

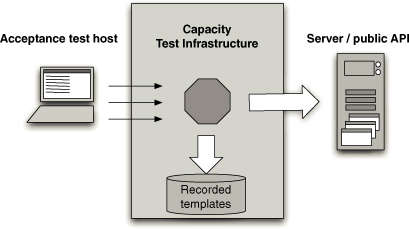

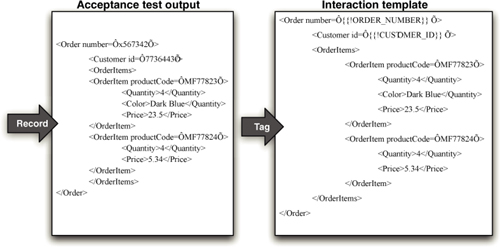

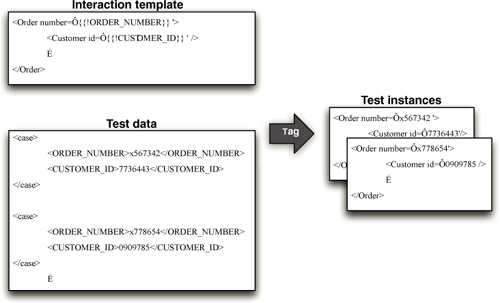

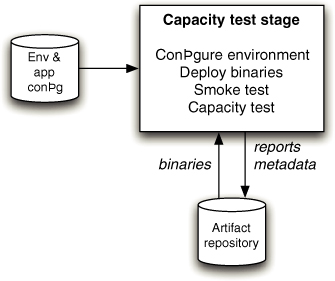

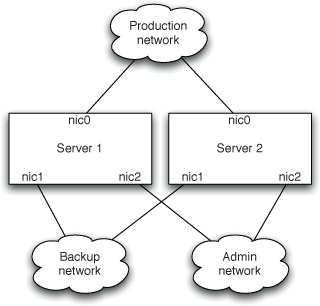

第9章,“测试非功能性需求”,讨论非功能性需求,重点是容量测试。我们描述如何创建容量测试,以及如何建立容量测试环境。

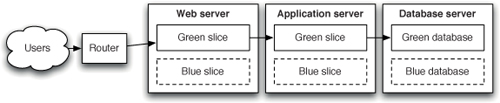

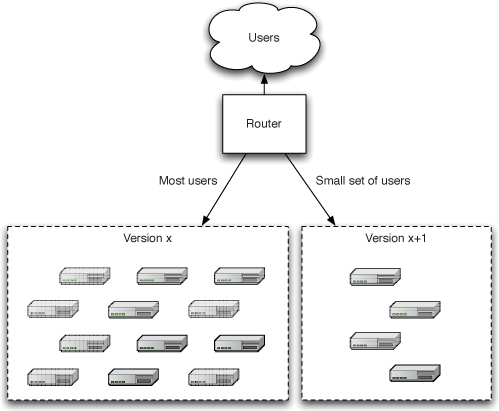

第10章,“部署和发布应用程序”,涵盖自动化测试之后发生的事情:按钮式将候选版本(release candidates)推送到手动测试环境、UAT、预发布(staging),最后是发布,涉及诸如持续部署、回滚和零停机发布等重要主题。

本书的最后部分讨论支持部署流水线的横切实践和技术。

第11章,“管理基础设施和环境”,涵盖环境的自动化创建、管理和监控,包括虚拟化和云计算的使用。

第12章,“管理数据”,展示如何在应用程序的整个生命周期中创建和迁移测试数据和生产数据。

第13章,“管理组件和依赖项”,首先讨论如何在不使用分支的情况下使应用程序始终处于可发布状态。然后我们描述如何将应用程序组织为组件集合,以及如何管理构建和测试它们。

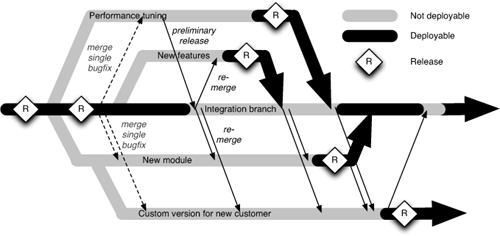

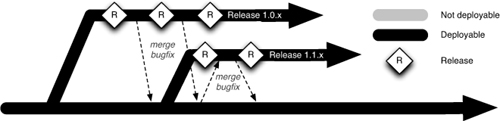

第14章,“高级版本控制”,概述了最流行的工具,并详细介绍了使用版本控制的各种模式。

第15章,“管理持续交付”,阐述了风险管理和合规性的方法,并提供了配置和发布管理的成熟度模型。在此过程中,我们讨论持续交付对业务的价值,以及以增量方式交付的迭代项目的生命周期。

我们没有完整地提供外部网站链接,而是将它们缩短并以此格式放入关键字:[bibNp0]。你可以通过两种方式访问链接。使用 bit.ly,这种情况下示例键的 URL 将是 http://bit.ly/bibNp0。或者,你可以使用我们安装在 http://continuousdelivery.com/go/ 的 URL 缩短服务,它使用相同的键——因此示例键的 URL 是 http://continuousdelivery.com/go/bibNp0。这样做的目的是,如果 bit.ly 因某种原因关闭,链接仍然可以保留。如果网页地址更改,我们将尽力保持 http://continuousdelivery.com/go/ 的缩短服务更新,所以如果 bit.ly 的链接无法使用,请尝试这个。

Martin Fowler 签名系列中的所有书籍封面上都有一座桥。我们最初计划使用铁桥(Iron Bridge)的照片,但它已经被该系列的另一本书选用。因此,我们选择了另一座英国桥梁:福斯铁路桥(Forth Railway Bridge),这里展示的是 Stewart Hardy 拍摄的精美照片。

福斯铁路桥是英国第一座使用钢材建造的桥梁,采用新的西门子-马丁平炉法(Siemens-Martin open-hearth process)制造,由苏格兰的两家钢厂和威尔士的一家钢厂供应。钢材以制成的管状桁架形式交付——这是英国桥梁首次使用批量生产的部件。与早期桥梁不同,设计师 John Fowler 爵士、Benjamin Baker 爵士和 Allan Stewart 对架设应力的发生率、降低未来维护成本的措施、风压以及温度应力对结构的影响进行了计算——就像我们在软件中制定的功能性和非功能性需求一样。他们还监督了桥梁的建造,以确保满足这些要求。

这座桥的建造涉及 4,600 多名工人,其中不幸约有一百人死亡,数百人致残。然而,最终成果是工业革命的奇迹之一:在 1890 年完工时,它是世界上最长的桥梁,到 21 世纪初,它仍然是世界第二长的悬臂桥。就像一个长期运行的软件项目一样,这座桥需要持续维护。这在设计时就已规划,桥梁的辅助工程不仅包括维护车间和场地,还包括在 Dalmeny 站的一个约 50 座房屋的铁路”社区”。这座桥的剩余使用寿命估计超过 100 年。

本书直接用 DocBook 编写。Dave 在 TextMate 中编辑文本,Jez 使用 Aquamacs Emacs。图表使用 OmniGraffle 创建。Dave 和 Jez 通常不在世界的同一地方,通过将所有内容提交到 Subversion 进行协作。我们还使用了持续集成(continuous integration),使用 CruiseControl.rb 服务器,每次我们其中一人提交更改时,它都会运行 dblatex 生成书籍的 PDF。

在本书付印前一个月,Dmitry Kirsanov 和 Alina Kirsanova 开始制作工作,通过他们的 Subversion 仓库、电子邮件和共享的 Google Docs 表格与作者协作协调。Dmitry 在 XEmacs 中对 DocBook 源代码进行文字编辑,Alina 完成了其他所有工作:使用自定义 XSLT 样式表和 XSL-FO 格式化程序排版页面,从源代码中作者的索引标签编译和编辑索引,以及对书籍进行最终校对。

许多人为本书做出了贡献。特别要感谢我们的审稿人:David Clack、Leyna Cotran、Lisa Crispin、Sarah Edrie、Damon Edwards、Martin Fowler、James Kovacs、Bob Maksimchuk、Elliotte Rusty Harold、Rob Sanheim 和 Chris Smith。我们还要特别感谢 Addison-Wesley 的编辑和制作团队:Chris Guzikowski、Raina Chrobak、Susan Zahn、Kristy Hart 和 Andy Beaster。Dmitry Kirsanov 和 Alina Kirsanova 在文字编辑、校对和使用他们的全自动系统排版方面做了出色的工作。

我们的许多同事在发展本书的思想方面发挥了重要作用,包括(排名不分先后)Chris Read、Sam Newman、Dan North、Dan Worthington-Bodart、Manish Kumar、Kraig Parkinson、Julian Simpson、Paul Julius、Marco Jansen、Jeffrey Fredrick、Ajey Gore、Chris Turner、Paul Hammant、Hu Kai、Qiao Yandong、Qiao Liang、Derek Yang、Julias Shaw、Deepthi、Mark Chang、Dante Briones、Li Guanglei、Erik Doernenburg、Kraig Parkinson、Ram Narayanan、Mark Rickmeier、Chris Stevenson、Jay Flowers、Jason Sankey、Daniel Ostermeier、Rolf Russell、Jon Tirsen、Timothy Reaves、Ben Wyeth、Tim Harding、Tim Brown、Pavan Kadambi Sudarshan、Stephen Foreshew、Yogi Kulkarni、David Rice、Chad Wathington、Jonny LeRoy 和 Chris Briesemeister。

Jez 要感谢他的妻子 Rani,她是他所能期望的最有爱心的伴侣,在他写作本书时脾气暴躁时为他加油打气。他还感谢他的女儿 Amrita,感谢她的咿呀学语、拥抱和灿烂的笑容。他还深深感谢 ThoughtWorks 的同事们,让它成为一个鼓舞人心的工作场所,并感谢 Cyndi Mitchell 和 Martin Fowler 对本书的支持。最后,向 Jeffrey Fredrick 和 Paul Julius 创建 CITCON 致敬,并感谢他在那里遇到的人们进行的许多精彩对话。

Dave 感谢他的妻子 Kate 以及孩子 Tom 和 Ben,感谢他们在这个项目以及许多其他项目中每一刻的坚定支持。他还要特别提到 ThoughtWorks,虽然不再是他的雇主,但该公司为在那里工作的人们提供了一个充满启迪和鼓励的环境,从而培育了一种寻找解决方案的创造性方法,其中许多方法都体现在本书的页面中。此外,他还要感谢他目前的雇主 LMAX,特别感谢 Martin Thompson,感谢他们的支持、信任以及在世界级高性能计算这一极具挑战性的技术环境中积极采用本书所述的技术。

Jez Humble 自从 11 岁时获得第一台 ZX Spectrum 以来,就对计算机和电子设备着迷,并花了数年时间用 6502 和 ARM 汇编语言以及 BASIC 在 Acorn 机器上进行黑客编程,直到他年龄足够大可以找到一份正式工作。他在 2000 年进入 IT 行业,正好赶上互联网泡沫破裂。从那时起,他担任过开发人员、系统管理员、培训师、顾问、经理和演讲者。他使用过各种平台和技术,为非营利组织、电信、金融服务和在线零售公司提供咨询。自 2004 年以来,他在北京、班加罗尔、伦敦和旧金山的 ThoughtWorks 和 ThoughtWorks Studios 工作。他拥有牛津大学物理学和哲学学士学位,以及伦敦大学东方与非洲研究学院民族音乐学硕士学位。他目前与妻子和女儿住在旧金山。

Dave Farley 从事计算机工作近 30 年,乐在其中。在此期间,他从事过大多数类型的软件工作——从固件、修改操作系统和设备驱动程序,到编写游戏和各种规模的商业应用程序。大约二十年前,他开始从事大规模分布式系统的工作,研究松耦合、基于消息的系统的开发——这是 SOA(面向服务架构)的先驱。他在英国和美国领导大小团队开发复杂软件方面拥有丰富的经验。Dave 是敏捷开发技术的早期采用者,从 1990 年代初开始在商业项目中采用迭代开发、持续集成和大量自动化测试。他在 ThoughtWorks 工作的四年半期间磨练了他的敏捷开发方法,在那里他担任技术负责人,负责一些最大、最具挑战性的项目。Dave 目前在伦敦多资产交易所(LMAX)工作,该组织正在构建世界上性能最高的金融交易所之一,他们依赖本书中描述的所有主要技术。

作为软件专业人员,我们面临的最重要问题是:如果有人想到一个好主意,我们如何尽快将其交付给用户?本书展示了如何解决这个问题。

我们专注于构建、部署、测试和发布过程,关于这些方面的文献相对较少。这并不是因为我们认为软件开发方法不重要;而是因为,如果不关注软件生命周期的其他方面——这些方面通常被视为整体问题的次要部分——就不可能实现可靠、快速、低风险的软件发布,从而高效地将我们的劳动成果交到用户手中。

软件开发方法有很多,但它们主要关注需求管理及其对开发工作的影响。有许多优秀的书籍详细介绍了软件设计、开发和测试的不同方法;但这些书籍也只涵盖了价值流(Value Stream)的一部分,而价值流才是为赞助我们工作的人员和组织交付价值的完整过程。

当需求被识别、解决方案被设计、开发和测试后会发生什么?如何将这些活动连接在一起并进行协调,以使流程尽可能高效和可靠?我们如何让开发人员、测试人员、构建和运维人员有效地协同工作?

本书描述了一种将软件从开发到发布的有效模式。我们描述了有助于实现这种模式的技术和最佳实践,并展示了这种方法如何与软件交付的其他方面相结合。

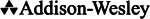

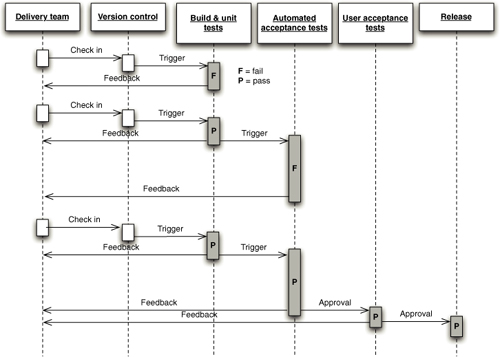

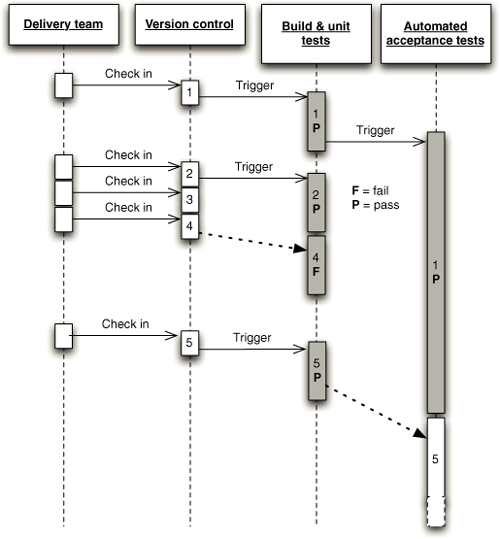

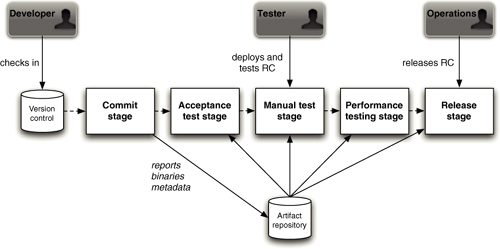

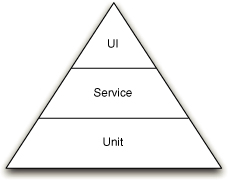

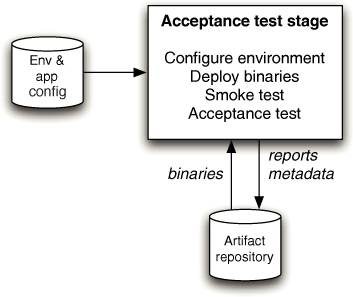

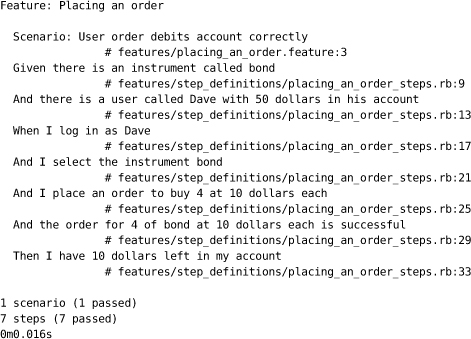

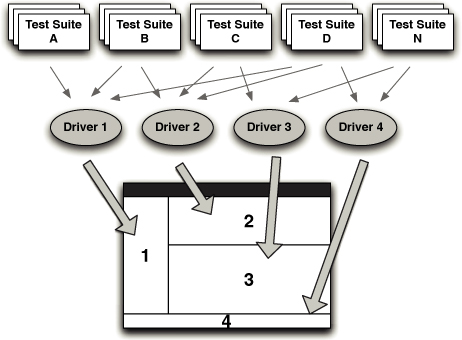

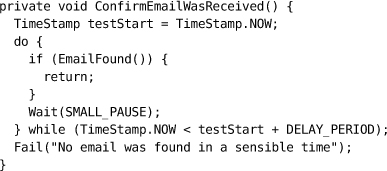

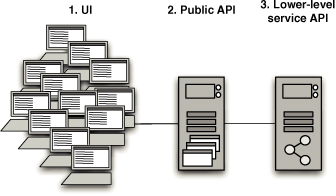

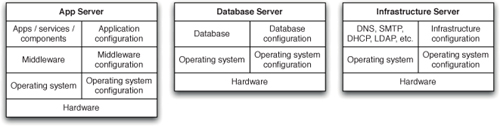

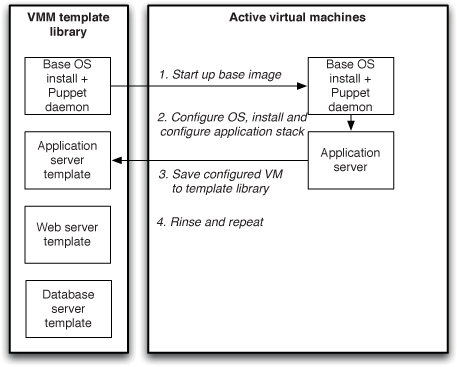

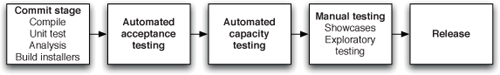

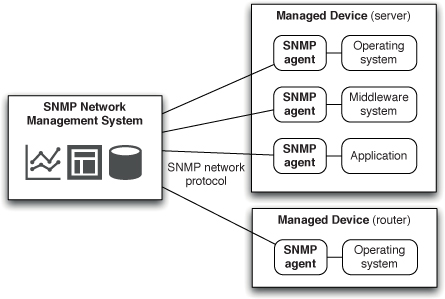

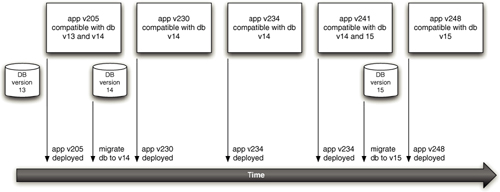

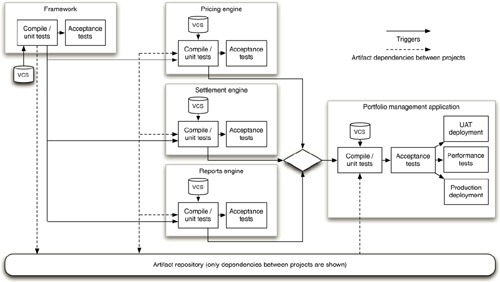

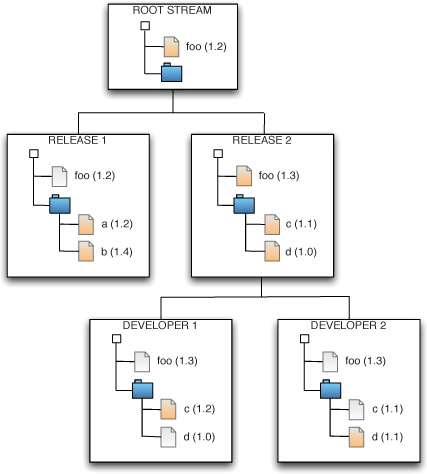

图 1.1 部署流水线

本书的核心模式是部署流水线(Deployment Pipeline)。部署流水线本质上是应用程序构建、部署、测试和发布过程的自动化实现。每个组织在实现其部署流水线时都会有所不同,这取决于他们发布软件的价值流,但支配它们的原则是不变的。图 1.1 给出了一个部署流水线的示例。

部署流水线的工作方式可以用一段话概括如下。对应用程序的配置、源代码、环境或数据所做的每一次更改,都会触发创建一个新的流水线实例。流水线的第一步是创建二进制文件和安装程序。流水线的其余部分会对这些二进制文件运行一系列测试,以证明它们可以发布。候选发布版本通过的每一项测试都会增强我们的信心,证明这个特定的二进制代码、配置信息、环境和数据的组合能够正常工作。如果候选发布版本通过了所有测试,它就可以被发布。

部署流水线的基础是持续集成流程,本质上是持续集成原则的逻辑延伸。

部署流水线的目标有三个方面。首先,它使构建、部署、测试和发布软件过程的每个部分对所有相关人员可见,从而促进协作。其次,它改善反馈,使问题能够在流程中尽早被识别并解决。最后,它使团队能够通过完全自动化的流程,随时将任何版本的软件部署和发布到任何环境。

软件发布日往往是紧张的一天。为什么会这样?对于大多数项目来说,是与流程相关的风险程度使得发布成为一个令人担忧的时刻。

在许多软件项目中,发布是一个需要大量手工操作的过程。托管软件的环境通常由运维或信息系统团队单独搭建。应用程序依赖的第三方软件会被安装。应用程序本身的软件制品会被复制到生产主机环境。配置信息通过Web服务器、应用服务器或其他第三方组件的管理控制台进行复制或创建。参考数据被复制,最后应用程序启动——如果是分布式或面向服务的应用程序,则需要逐个启动。

紧张的原因应该很清楚:这个过程中有很多可能出错的地方。如果任何一步没有完美执行,应用程序将无法正常运行。此时可能根本不清楚错误在哪里,或者哪一步出了问题。

本书的其余部分将讨论如何避免这些风险——如何减少发布日的压力,以及如何确保每次发布都具有可预测的可靠性。

在此之前,让我们明确我们试图避免的流程失败类型。以下是一些常见的反模式,它们会阻碍可靠的发布流程,但在我们的行业中却非常普遍,甚至已成为常态。

大多数有一定规模的现代应用程序部署起来都很复杂,涉及许多活动部件。许多组织以手动方式发布软件。我们的意思是,部署此类应用程序所需的步骤被视为独立且原子性的,每个步骤由个人或团队执行。这些步骤中必须做出判断,使它们容易出现人为错误。即使不是这种情况,这些步骤的顺序和时间上的差异也可能导致不同的结果。这些差异很少是好事。

这种反模式的迹象包括:

• 制作大量详细的文档,描述要执行的步骤以及步骤可能出错的方式

• 依赖手动测试来确认应用程序是否正常运行

• 在发布日频繁致电开发团队,以解释为什么部署出现问题

• 在发布过程中频繁修正发布流程

• 集群中的环境配置不同,例如应用服务器具有不同的连接池设置、文件系统具有不同的布局等

• 发布需要超过几分钟才能完成

• 发布结果不可预测,经常需要回滚或遇到意外问题

• 在发布日后的凌晨2点,睁着疲惫的眼睛坐在显示器前,试图找出如何使其正常工作

相反…

随着时间的推移,部署应该趋向于完全自动化。人类在将软件部署到开发、测试或生产环境时应该只需要执行两项任务:选择版本和环境,然后按下”部署”按钮。发布打包软件应该涉及一个创建安装程序的单一自动化流程。

在本书的过程中,我们大量讨论了自动化,我们知道有些人并不完全认同这个想法。让我们解释一下为什么我们将自动化部署视为不可或缺的目标。

• 当部署未完全自动化时,每次执行都会发生错误。唯一的问题是错误是否重要。即使有出色的部署测试,错误也可能难以追踪。

• 当部署流程未自动化时,它就不可重复或不可靠,导致在调试部署错误上浪费时间。

• 手动部署流程必须有文档记录。维护文档是一项复杂且耗时的任务,涉及多人协作,因此文档在任何给定时间通常都是不完整或过时的。一组自动化部署脚本可以作为文档,并且它始终是最新和完整的,否则部署将无法工作。

• 自动化部署促进协作,因为所有内容都在脚本中明确表达。文档必须对读者的知识水平做出假设,实际上通常是作为执行部署人员的备忘录编写的,这使得其他人难以理解。

• 上述观点的推论:手动部署依赖于部署专家。如果他或她在度假或离职,你就会陷入困境。

• 执行手动部署既枯燥又重复,却需要相当程度的专业知识。要求专家做枯燥、重复但技术要求高的任务,是我们能想到的最确定会导致人为错误的方式,仅次于睡眠不足或醉酒。自动化部署可以让你昂贵的、高技能的、工作过度的员工去从事更高价值的活动。

• 测试手动部署流程的唯一方法就是执行它。这通常既耗时又昂贵。自动化部署流程测试起来既便宜又简单。

• 我们听说过有人认为手动流程比自动化流程更易于审计。我们对这种说法完全困惑。对于手动流程,无法保证文档已被遵循。只有自动化流程才是完全可审计的。还有什么比可运行的部署脚本更易于审计的呢?

自动化部署流程必须被所有人使用,并且应该是部署软件的唯一方式。这种纪律确保部署脚本在需要时能够正常工作。我们在本书中描述的原则之一是使用相同的脚本部署到每个环境。如果你使用相同的脚本部署到每个环境,那么生产环境的部署路径在发布日之前已经被测试了数百甚至数千次。如果发布时出现任何问题,你可以确定这些是特定环境配置的问题,而不是脚本的问题。

我们确信,偶尔手动密集型发布会顺利进行。我们可能只是不幸地主要看到了糟糕的情况。然而,如果这不被认为是软件生产过程中可能容易出错的步骤,为什么会有如此多的仪式?为什么有这么多流程和文档?为什么要在周末召集团队?为什么要让人们待命以防出现问题?

在这种模式中,软件第一次部署到类生产环境(例如预发布环境)是在大部分开发工作完成之后——至少是开发团队定义的”完成”。

这种模式看起来有点像这样。

• 如果测试人员在此之前参与了这个过程,他们是在开发机器上测试系统的。

• 发布到预发布环境是运维人员第一次与新版本交互。在某些组织中,使用独立的运维团队将软件部署到预发布环境和生产环境。在这种情况下,运维人员第一次看到软件是在发布到生产环境的那天。

• 要么类生产环境成本高昂以至于对其访问受到严格控制,要么没有及时准备好,要么根本没人费心创建一个。

• 开发团队组装正确的安装程序、配置文件、数据库迁移脚本和部署文档,交给实际执行部署的人员——所有这些都没有在类似生产或预发布的环境中测试过。

• 开发团队和实际执行部署的人员之间几乎没有任何协作来创建这些材料。

当部署到预发布环境时,会组建一个团队来执行部署。有时这个团队具备所有必要的技能,但在非常大型的组织中,部署职责通常在几个组之间分配。数据库管理员(DBA)、中间件团队、Web团队和其他人都参与部署应用程序的最新版本。由于各个步骤从未在预发布环境中测试过,它们经常出错。文档遗漏了重要步骤。文档和脚本对目标环境的版本或配置做出了错误的假设,导致部署失败。部署团队不得不猜测开发团队的意图。

在部署到预发布环境时造成如此多问题的协作不良,通常通过临时电话、电子邮件和快速修复来弥补。一个非常有纪律的团队会将所有这些沟通纳入部署计划——但这个过程很少有效。随着压力增加,为了在分配给部署团队的时间内完成部署,开发团队和部署团队之间定义的协作流程会被破坏。

在执行部署的过程中,经常会发现关于生产环境的错误假设已经被固化到系统设计中。例如,我们参与部署的一个应用程序使用文件系统来缓存数据。这在开发人员工作站上运行良好,但在集群环境中效果不佳。解决这类问题可能需要很长时间,在这些问题解决之前,不能说应用程序已经部署完成。

一旦应用程序部署到预发布环境(staging),通常会发现新的bug。不幸的是,往往没有时间修复所有bug,因为截止日期即将到来,而且在项目的这个阶段,推迟发布日期是不可接受的。因此,最关键的bug会被匆忙修补,项目经理会保存一份已知缺陷清单,以便在下一个版本开始时降低优先级。

有时情况可能更糟。以下是一些可能加剧发布相关问题的因素:

• 开发新应用程序时,首次部署到预发布环境可能是最麻烦的。

• 发布周期越长,开发团队在部署发生之前做出错误假设的时间就越长,修复这些问题所需的时间也就越长。

• 在大型组织中,交付流程被划分到不同的团队,如开发、数据库管理员(DBA)、运维、测试等,这些孤岛之间的协调成本可能是巨大的,有时会使发布流程陷入工单地狱。在这种情况下,开发人员、测试人员和运维人员不断地互相提交工单(或发送电子邮件)以执行任何给定的部署——更糟糕的是,解决部署期间出现的问题。

• 开发环境和生产环境之间的差异越大,开发过程中必须做出的假设就越不切实际。这可能难以量化,但可以肯定的是,如果你在Windows机器上开发并部署到Solaris集群,你将会遇到一些意外。

• 如果你的应用程序由用户安装或包含由用户安装的组件,你可能无法完全控制他们的环境,特别是在企业环境之外。在这种情况下,需要进行大量额外的测试。

更好的做法是…

解决方案是将测试、部署和发布活动集成到开发过程中。使它们成为开发过程中正常且持续的一部分,这样当你准备将系统发布到生产环境时,几乎没有风险,因为你已经在越来越接近生产环境的一系列测试环境中多次演练过。确保参与软件交付流程的每个人,从构建和发布团队到测试人员再到开发人员,从项目开始就共同协作。

我们是测试狂热者,广泛使用持续集成(continuous integration)和持续部署(continuous deployment)作为测试软件和部署流程的手段,是我们所描述方法的基石。

许多组织通过运维团队来管理其生产环境的配置。如果需要进行更改,例如更改数据库连接设置或增加应用服务器上线程池中的线程数,则会在生产服务器上手动执行。如果记录了这样的更改,可能只是在变更管理数据库中的一个条目。

这种反模式的迹象包括:

• 尽管已经成功多次部署到预发布环境,但部署到生产环境时却失败了。

• 集群的不同成员表现不同——例如,一个节点承受的负载较小或处理请求所需的时间比另一个节点更长。

• 运维团队需要很长时间来为发布准备环境。

• 你无法回退到系统的早期配置,这可能包括操作系统、应用服务器、Web服务器、关系型数据库管理系统(RDBMS)或其他基础设施设置。

• 集群中的服务器无意中拥有不同版本的操作系统、第三方基础设施、库或补丁级别。

• 系统的配置是通过直接修改生产系统上的配置来执行的。

更好的做法是…

每个测试、预发布和生产环境的所有方面,特别是系统中任何第三方元素的配置,都应该通过自动化流程从版本控制中应用。

我们在本书中描述的一个关键实践是配置管理,其中一部分意味着能够重复创建应用程序使用的每一个基础设施组件。这意味着操作系统、补丁级别、操作系统配置、应用程序栈、其配置、基础设施配置等都应该被管理。你应该能够精确地重新创建生产环境,最好是以自动化方式。虚拟化可以帮助你开始实现这一点。

你应该确切地知道生产环境中有什么。这意味着对生产环境所做的每一项更改都应该被记录并可审计。部署经常失败是因为有人在上次部署时修补了生产环境,但没有记录这一更改。实际上,不应该可以手动更改测试、预发布和生产环境。更改这些环境的唯一方式应该是通过自动化流程。

应用程序通常依赖于其他应用程序。应该能够一目了然地看到每个软件的当前发布版本。

虽然发布可能令人兴奋,但也可能令人疲惫和沮丧。几乎每次发布都涉及最后一刻的更改,例如修复数据库登录详细信息或更新外部服务的URL。应该有一种方法来引入这样的更改,以便它们既被记录又被测试。同样,自动化是必不可少的。更改应该在版本控制中进行,然后通过自动化流程传播到生产环境。

如果部署出现问题,应该可以使用相同的自动化流程回滚到生产环境的先前版本。

当然可以,本书的目标就是描述如何做到这一点。我们描述的原则、实践和技术旨在让发布变得平淡无奇,即使在复杂的”企业”环境中也是如此。软件发布可以——也应该——是一个低风险、频繁、成本低、快速且可预测的过程。这些实践是在过去几年中发展起来的,我们已经看到它们在许多项目中产生了巨大的影响。本书中的所有实践都已在拥有分布式团队的大型企业项目以及小型开发团队中得到了验证。我们知道它们是有效的,我们也知道它们可以扩展到大型项目。

我们的一个客户过去每次发布都需要一个庞大的专门团队。该团队连续工作七天,包括整个周末,才能将应用程序部署到生产环境。他们的成功率很低,许多发布都会引入错误或在发布当天需要大量干预,而且通常还需要在随后几天打补丁和修复,以纠正发布引入的错误或配置新软件时的人为错误。

我们帮助他们实现了一个复杂的自动化构建、部署、测试和发布系统,并引入了支持该系统所需的开发实践和技术。我们见证的最后一次发布只用了七秒钟就将应用程序部署到了生产环境。除了发布实现的新行为突然可用之外,没有人注意到发生了什么。如果这个主要网站背后的系统部署因任何原因失败,我们可以在同样的时间内回滚这个变更。

我们的目标是描述如何使用部署流水线(deployment pipeline),结合高度自动化的测试和部署,以及全面的配置管理,来实现一键式软件发布。也就是说,一键式软件发布到任何部署目标——开发环境、测试环境或生产环境。

在此过程中,我们将描述这个模式本身以及您需要采用的技术才能使其发挥作用。我们将为您可能面临的一些问题提供不同解决方法的建议。我们发现,这种方法的优势远远超过了实现它的成本。

这一切都在任何项目团队的能力范围之内。它不需要僵化的流程、大量的文档或很多人员。在本章结束时,我们希望您能够理解这种方法背后的原则。

正如我们所说,作为软件专业人员,我们的目标是尽快向用户交付有用的、可工作的软件。

速度至关重要,因为不交付软件会带来机会成本。只有在软件发布后,您才能开始获得投资回报。因此,本书的两个首要目标之一就是找到减少周期时间的方法,即从决定进行变更(无论是错误修复还是功能开发)到用户可用的时间。

快速交付也很重要,因为它可以让您验证您的功能和错误修复是否真正有用。我们将应用程序创建背后的决策者称为客户(customer),他们对哪些功能和错误修复对用户有用做出假设。然而,在这些假设交到用户手中,用户通过选择使用软件来投票之前,它们仍然只是假设。因此,最小化周期时间以建立有效的反馈循环至关重要。

有用性的一个重要部分是质量。我们的软件应该适合其目的。质量不等于完美——正如伏尔泰所说,“完美是好的敌人”——但我们的目标应该始终是交付足够质量的软件,为用户带来价值。因此,虽然尽快交付软件很重要,但保持适当的质量水平是必不可少的。

所以,稍微细化我们的目标,我们希望找到以高效、快速和可靠的方式交付高质量、有价值软件的方法。

我们和我们的同行实践者发现,为了实现这些目标——低周期时间和高质量——我们需要频繁、自动化地发布软件。为什么呢?

• 自动化。如果构建、部署、测试和发布过程没有自动化,那么它就不可重复。每次执行时都会不同,因为软件、系统配置、环境和发布过程都在变化。由于步骤是手动的,所以容易出错,而且无法准确审查所做的操作。这意味着无法控制发布过程,因此无法确保高质量。发布软件经常是一门艺术;它应该是一门工程学科。

• 频繁。如果发布频繁,发布之间的增量将会很小。这显著降低了与发布相关的风险,并使回滚变得更容易。频繁发布也会带来更快的反馈——事实上,它们需要这样的反馈。本书的大部分内容集中在尽快获得对应用程序及其相关配置(包括其环境、部署过程和数据)的变更反馈上。

反馈对于频繁的自动化发布至关重要。反馈要有用,需要满足三个标准。

• 任何类型的变更都需要触发反馈过程。

• 反馈必须尽快交付。

• 交付团队必须接收反馈并采取行动。

让我们详细审视这三个标准,并考虑如何实现它们。

一个可运行的软件应用程序可以有效地分解为四个组件:可执行代码、配置、宿主环境和数据。如果其中任何一个发生变更,都可能导致应用程序行为的改变。因此,我们需要控制这四个组件,并确保对其中任何一个的变更都得到验证。

当源代码发生变更时,可执行代码也会随之改变。每次对源代码进行变更时,都必须构建并测试生成的二进制文件。为了控制这个过程,应该自动化构建和测试二进制文件。每次签入时构建和测试应用程序的做法被称为持续集成(continuous integration);我们将在第3章详细描述。

这个可执行代码应该是部署到每个环境中的相同可执行代码,无论是测试环境还是生产环境。如果您的系统使用编译型语言,您应该确保构建过程的二进制输出——可执行代码——在需要的地方被重用,而不是重新构建。

任何在不同环境之间变化的内容都应作为配置信息捕获。应用程序配置的任何变更,无论在哪个环境中,都应该进行测试。如果软件要由用户安装,则应在具有代表性的示例系统范围内测试可能的配置选项。配置管理将在第2章讨论。

如果应用程序要部署到的环境发生变更,则应该用环境的变更对整个系统进行测试。这包括操作系统配置的变更、支持应用程序的软件栈、网络配置以及任何基础设施和外部系统的变更。第11章处理基础设施和环境的管理,包括测试和生产环境的创建和维护的自动化。

最后,如果数据的结构发生变更,这种变更也必须经过测试。我们将在第12章讨论数据管理。

什么是反馈过程?它涉及尽可能以完全自动化的方式测试每次变更。测试会因系统而异,但通常至少包括以下检查。

• 创建可执行代码的过程必须成功。这验证了源代码的语法是否有效。

• 软件的单元测试必须通过。这检查您的应用程序代码是否按预期运行。

• 软件应满足某些质量标准,如测试覆盖率和其他特定技术的指标。

• 软件的功能验收测试必须通过。这检查您的应用程序是否符合其业务验收标准——是否交付了预期的业务价值。

• 软件的非功能性测试必须通过。这检查应用程序在容量、可用性、安全性等方面是否表现良好,以满足用户的需求。

• 软件必须经过探索性测试以及向客户和部分用户的演示。这通常在手动测试环境中完成。在这部分过程中,产品负责人可能会决定有缺失的功能,或者我们可能会发现需要修复的缺陷以及需要创建的自动化测试以防止回归。

运行这些测试的环境必须尽可能与生产环境相似,以验证对环境的任何变更是否影响了应用程序的工作能力。

快速反馈的关键是自动化。通过完全自动化的流程,您唯一的限制就是可以用于解决问题的硬件资源量。如果使用手动流程,您就依赖于人来完成工作。人需要更长时间,会引入错误,并且不可审计。此外,执行手动构建、测试和部署过程是枯燥且重复的——远非人的最佳用途。人是昂贵且宝贵的,他们应该专注于生产令用户愉悦的软件,然后尽快交付这些令人愉悦的功能——而不是枯燥、容易出错的任务,如回归测试、虚拟服务器配置和部署,这些最好由机器来完成。

然而,实施部署流水线需要大量资源,特别是一旦拥有了全面的自动化测试套件。它的一个关键目标是优化人力资源的使用:我们希望解放人们去做有趣的工作,将重复性工作留给机器。

我们可以将流水线提交阶段(图1.1)中的测试特征描述如下。

• 它们运行速度快。

• 它们尽可能全面——也就是说,它们覆盖了代码库的75%以上,这样当它们通过时,我们对应用程序工作正常有很好的信心。

• 如果其中任何一个失败,意味着我们的应用程序存在严重故障,在任何情况下都不应发布。这意味着检查UI元素颜色的测试不应包含在这组测试中。

• 它们尽可能与环境无关——也就是说,环境不必是生产环境的精确副本,这意味着它可以更简单、成本更低。

另一方面,后期阶段的测试具有以下一般特点:

• 运行速度较慢,因此适合并行化处理。

• 其中一些可能会失败,但在某些情况下我们仍可能选择发布应用程序(可能是候选版本中有一个关键修复导致性能低于预定义阈值——但我们可能仍决定发布)。

• 应在尽可能接近生产环境的环境中运行,因此除了测试的直接重点外,它们还测试部署流程和生产环境的任何变更。

这种测试流程的组织方式意味着,在第一组测试后,我们对软件有很高的信心,这些测试在最便宜的硬件上运行最快。如果这些测试失败,候选版本不会进入后续阶段。这确保了资源的最优使用。关于流水线的更多内容请参见第5章“部署流水线剖析”,以及后续的第7章、第8章和[第9章],它们分别描述了提交测试阶段、自动化验收测试和非功能性需求测试。

我们方法的基本原则之一是需要快速反馈。确保对变更的快速反馈要求我们关注软件开发过程——特别是如何使用版本控制以及如何组织代码。开发人员应该频繁地将变更提交到版本控制系统,并将代码拆分为独立的组件,以此作为管理大型或分布式团队的方法。在大多数情况下,应该避免分支。我们在[第13章]“管理组件和依赖项”中讨论增量交付和组件的使用,在[第14章]“高级版本控制”中讨论分支和合并。

所有参与软件交付过程的人员都参与反馈过程至关重要。这包括开发人员、测试人员、运维人员、数据库管理员、基础设施专家和管理人员。如果这些角色的人员不能每天一起工作(尽管我们建议团队应该是跨职能的),那么他们必须经常会面并努力改进软件交付过程。基于持续改进的流程对于快速交付高质量软件至关重要。迭代流程有助于为这类活动建立常规节奏——至少每次迭代举行一次回顾会议,每个人都讨论如何改进下一次迭代的交付过程。

能够对反馈做出反应也意味着广播信息。使用大型可视化仪表板(不一定是电子的)和其他通知机制对于确保反馈确实被反馈并最终进入某人的脑海至关重要。仪表板应该无处不在,每个团队室至少应该有一个。

最后,除非采取行动,否则反馈没有用。这需要纪律和计划。当需要做某事时,整个团队有责任停下手头的工作并决定行动方案。只有完成这一步,团队才应继续他们的工作。

我们听到的一个常见反对意见是,我们描述的流程过于理想化。这些批评者说,它可能在小团队中有效,但不可能在我庞大的分布式项目中工作!

多年来,我们在多个不同行业的许多大型项目中工作过。我们也很幸运能够与拥有丰富经验的同事一起工作。本书中描述的所有技术和原则都已在各种组织的实际项目中得到验证,无论大小,在各种情况下。在这些项目中一次又一次地遇到相同的问题,这驱使我们写这本书。

读者会注意到,本书的大部分内容受到精益运动的哲学和思想的启发。精益制造(lean manufacturing)的目标是确保快速交付高质量产品,专注于消除浪费和降低成本。精益制造在多个行业带来了巨大的成本和资源节约、更高质量的产品以及更快的上市时间。这一哲学也开始在软件开发领域成为主流,并为本书讨论的大部分内容提供了指导。精益的应用当然不局限于小型系统。它是在大型组织甚至整个经济体中创建和应用的。

这些理论和实践与大型团队的相关性与小型团队一样,我们的经验表明它们是有效的。但是,我们不要求您相信我们所说的。自己尝试并找出答案。保留有效的,丢弃无效的,并写下您的经验,以便其他人可以受益。

我们在前面部分描述的方法的主要好处是,它创建了一个可重复、可靠且可预测的发布流程,从而大大缩短了周期时间,从而快速将功能和错误修复交付给用户。仅成本节约就不仅值这本书的定价,而且值得投入时间来建立和维护这样一个发布系统。

除此之外还有许多其他好处,其中一些是我们事先预测到的,而另一些则更像是我们观察到它们时的惊喜。

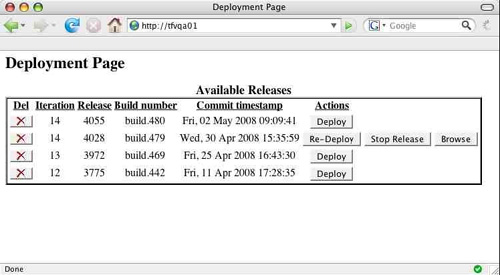

部署流水线(deployment pipeline)的核心原则之一是它是一个拉取系统——它允许测试人员、运维人员或支持人员自助获取他们想要的应用程序版本并部署到他们选择的环境中。根据我们的经验,交付周期时间的一个主要影响因素是交付流程中的人员等待获得应用程序的”良好构建版本”。获取良好的构建版本通常需要发送无数的电子邮件、提交工单或其他低效的沟通方式。当交付团队分布在不同地点时,这就成为效率低下的主要来源。通过实施部署流水线,这个问题被彻底解决了——每个人都应该能够查看哪些构建版本可以部署到他们关心的环境中,并能够通过按下按钮来执行部署。

我们经常看到的结果是,随着团队不同成员进行各自的工作,在不同环境中会同时运行多个不同版本。能够轻松地将任何版本的软件部署到任何环境中有许多优势。

• 测试人员可以选择应用程序的旧版本来验证新版本中行为的变化。

• 支持人员可以将已发布的应用程序版本部署到环境中以重现缺陷。

• 运维人员可以选择已知的良好构建版本部署到生产环境,作为灾难恢复演练的一部分。

• 可以通过按下按钮来执行发布。

我们的部署工具为他们提供的灵活性改变了他们的工作方式——变得更好。总的来说,团队成员对自己的工作有了更多的控制权,因此他们的工作质量得到提高,应用程序的质量也随之提高。他们更有效地协作,减少了被动反应,工作效率更高,因为他们不再花那么多时间等待良好的构建版本推送给他们。

错误可能从各种地方渗入软件中。最初委托软件的人可能要求了错误的东西。捕获需求的分析师可能理解错误,开发人员可能编写有缺陷的代码。然而,我们这里讨论的错误是那些由于糟糕的配置管理而引入到生产环境中的错误。我们将在第2章中更详细地描述配置管理的含义。现在,想想那些必须完全正确才能使典型应用程序正常工作的东西——正确的代码版本,当然,但还有正确的数据库模式版本,负载均衡器的正确配置,用于查询价格的Web服务的正确URL,等等。当我们谈论配置管理时,我们指的是允许您识别和控制完整信息集的流程和机制,每一个比特和字节。

几年前,Dave在为一家知名零售商开发大规模销售点系统。那是我们开始思考自动化部署流程的早期阶段,所以虽然某些方面已经相当自动化,但其他方面还没有。生产环境中出现了一个非常严重的错误。在某些未知的、难以确定的情况组合下,我们的日志中突然出现了大量错误跟踪。我们无法在任何测试环境中重现这个问题。我们尝试了各种方法:在性能环境中进行负载测试,试图模拟看起来像生产环境中的病理情况——但我们就是无法重现问题。最后,经过比这里描述的更多的调查后,我们决定审查所有我们能想到的可能在两个系统之间不同的东西。我们最终发现,我们的应用程序依赖的一个二进制库(属于我们使用的应用服务器软件)在生产环境和测试环境中是不同的。我们更改了生产环境中二进制文件的版本,问题就消失了。

这个故事的重点不是我们不够勤奋,或不够谨慎,甚至也不是因为我们想到审查系统而很聪明。真正的重点是软件可能非常脆弱。这是一个相当大的系统,有数万个类、数千个库,以及许多与外部系统的集成点。然而,由于第三方二进制文件版本之间几个字节的差异,就将一个严重错误引入了生产环境。

在现代软件系统中,集体包含的许多千兆字节的信息中,没有任何一个人——或一组人——能够在没有机器辅助的情况下发现前面侧边栏示例中描述的规模的变化。与其等到问题发生,为什么不利用机器辅助首先防止它发生呢?

通过主动管理版本控制中可能改变的所有内容——例如配置文件、创建数据库及其模式的脚本、构建脚本、测试工具,甚至开发环境和操作系统配置——我们让计算机做它们擅长的事情:确保每一个比特和字节都在我们期望的位置,至少在我们的代码开始运行之前是这样。

我们参与的另一个项目拥有大量专用的测试环境。每个环境都运行着一个流行的 EJB 应用服务器。这个应用是以敏捷项目的方式开发的,具有良好的自动化测试覆盖率。本地构建管理得很好,因此开发人员可以相对容易地在本地快速运行代码以便进行开发。然而,这是在我们开始更加谨慎地自动化应用部署之前。每个测试环境都是手动配置的,使用的是应用服务器供应商提供的基于控制台的工具。尽管开发人员用于配置本地安装的配置文件副本保存在版本控制系统中,但每个测试环境的配置却没有。每个环境都与其他环境不同。它们的属性顺序不同,有些缺失,有些设置为不同的值,有些名称不同,有些具有其他环境没有的属性。没有两个测试环境是相同的,而且它们都与生产环境不同。要确定哪些属性是必需的、哪些是冗余的、哪些应该在环境之间通用、哪些应该是唯一的,这非常困难。因此,该项目雇用了一个由五人组成的团队来负责管理这些不同环境的配置。

根据我们的经验,这种对手动配置管理的依赖很常见。在我们合作过的许多组织中,无论是生产系统还是测试环境都是如此。有时,服务器 A 的连接池限制为 100 而服务器 B 的连接池设置为 120 可能并不重要。但在其他时候,这可能非常重要。

哪些配置差异重要、哪些不重要,这不是你想要在最繁忙的交易时段意外发现的事情。这类配置信息定义了代码运行的环境,并且经常实际上指定了通过代码的新路径。对此类配置信息的更改需要认真考虑,代码运行的环境需要像代码本身的行为一样被明确定义和控制。如果我们能访问你的数据库、应用服务器或 Web 服务器的配置,我们保证能让你的应用失败的速度比你给我们访问编译器和源代码更快。

当这些配置参数是手动定义和管理时,它们容易受到人类在重复性任务中犯错误倾向的影响。仅在错误的地方打一个错字就可能让应用停止运行。更糟糕的是,编程语言有语法检查,也许还有单元测试来验证没有错字。而对于配置信息,特别是直接输入到某个控制台的配置信息,很少有任何类型的检查。

将配置信息添加到版本控制系统这一简单行为就是一个巨大的进步。最简单的情况下,版本控制系统会提醒你无意中更改了配置。这至少消除了一个非常常见的错误来源。

一旦所有配置信息都存储在版本控制系统中,下一个显而易见的步骤就是消除中间人,让计算机来应用配置而不是手动输入。某些技术比其他技术更适合这样做,但如果你仔细考虑,即使是最难处理的第三方系统的配置,你(通常还有基础设施供应商)也会惊讶于能做到什么程度。我们将在第 4 章中详细讨论这一点,并在第 11 章中进行深入探讨。

在显而易见的好处中,最令人愉快的是减少了与发布相关的各方的压力。大多数曾经接触过接近发布日期的软件项目的人都知道,这些确实是压力很大的事件。根据我们的经验,这本身就可能成为问题的来源。我们见过理智、保守、注重质量的项目经理问他们的开发人员:“你就不能直接修改代码吗?”或者其他正常的数据库管理员在他们不了解的应用的数据库表中输入数据。在这两种情况下,以及许多其他类似的情况下,这些更改都是直接响应”让某些东西工作起来”的压力。

不要误解我们,我们也经历过这些。我们甚至不是说这总是错误的响应:如果你刚刚发布了一些导致组织流失资金的代码到生产环境,几乎任何能止血的方法都可能是合理的。

我们这里的观点不同。这两个快速修复新部署的生产系统的例子都不是由这种直接的商业需求驱动的,而是由按计划发布日期发布的更微妙的压力驱动的。这里的问题是发布到生产环境是重大事件。只要这是事实,它们就会伴随着大量的仪式和紧张。

想象一下,你即将进行的发布可以通过按下按钮来完成。想象一下它可以在几分钟甚至几秒钟内完成,如果最坏的情况发生,你可以在同样的几分钟或几秒钟内回退发布。想象一下你经常发布,因此当前生产环境中的内容与新发布之间的差异很小。如果这是真的,那么发布的风险将大大降低,你把职业生涯押在其成功上的不愉快感觉也会显著减少。

对于一小部分项目来说,这个理想可能无法实际实现。然而,在大多数项目中这确实是可以做到的,尽管需要付出一定的努力。减少压力的关键是拥有我们所描述的那种自动化部署流程,频繁地执行它,并在最坏情况发生时有良好的回滚能力。第一次进行自动化时会很痛苦——但它会变得越来越容易,而对项目和你自己的好处几乎是无法估量的。

在新环境中启动应用程序应该是一项简单的任务——理想情况下只需要准备好机器或虚拟镜像,并创建一些描述该环境独特属性的配置信息。然后你应该能够使用自动化部署流程来为新环境做好部署准备,并将选定版本的应用程序部署到该环境中。

我们最近参与的一个项目,因政府立法的意外变化而导致其商业案例失效。该项目旨在为一家新企业创建核心企业系统。该业务将分布在国际范围内,软件被设计为在大量异构的昂贵计算机上运行。当然,项目存在的理由突然消失的消息让每个人都有些沮丧。

不过对我们来说有一个小小的亮点。我们为之开发软件的组织进行了一次精简分析。“新系统的最小硬件占用是什么,我们如何限制资本成本?”他们问道。“嗯,它可以在这台笔记本电脑上运行,”我们回答。他们很惊讶,因为这是一个复杂的多用户系统。“你怎么知道它能工作?”他们思考后问道。“嗯,我们可以像这样运行所有验收测试……”,然后我们演示给他们看。“它需要承受什么样的负载?”我们问他们。他们告诉我们负载量,我们对性能测试的扩展参数做了一行修改并运行了测试。我们证明笔记本电脑太慢了,但差距并不大。一台配置合理的服务器就能满足他们的需求,当这台服务器可用时,只需几分钟就能让应用程序在上面运行起来。

这种部署灵活性不仅是我们在本书中描述的自动化部署技术的功能;应用程序本身也设计得相当好。然而,我们能够按需将软件部署到任何需要的地方,这给了我们和客户极大的信心,相信我们能够在任何时候管理任何发布。随着发布变得不那么令人担忧,考虑敏捷理念中在每次迭代结束时发布就变得更容易了。即使这对特定项目不合适,也意味着我们可以夺回自己的周末时间。

在我们参与的项目中,我们尝试为每个开发者或开发者对提供一个专用的开发环境。然而,即使在没有做到这一点的项目中,任何使用持续集成(Continuous Integration)或迭代、增量开发技术的团队都需要频繁部署应用程序。

最佳策略是无论部署目标是什么,都使用相同的部署方法。不应该有特殊的QA部署策略,或特殊的验收测试,或生产部署策略。这样,每次部署应用程序时,我们都在确认部署机制工作正常。本质上,最终的生产部署在每次软件部署到任何目标时都在被演练。

有一个特殊情况可以允许一些变化:开发环境。开发者需要构建二进制文件而不是使用在其他地方构建好的预制二进制文件是合理的,因此这个约束可以在这些部署中放宽。不过即使在开发者工作站上,我们也尽可能以相同的方式部署和管理。

什么是发布候选版本(Release Candidate)?对代码的更改可能可以发布,也可能不可以。如果你查看一个更改并问”我们应该发布这个更改吗?“那么答案只能是猜测。正是我们应用于该更改的构建、部署和测试流程验证了该更改是否可以发布。这个流程让我们对更改可以安全发布越来越有信心。我们采用那个小的更改——无论是新功能、错误修复,还是为实现某些性能变化而对系统进行的调整——并验证我们是否能够以高度的信心发布带有该更改的系统。为了进一步降低风险,我们希望在尽可能短的时间内完成这个验证。

虽然任何更改都可能产生可以发布给用户的制品(Artifact),但它们一开始并不是这样的。每个更改都必须评估其适用性。如果最终产品被发现没有缺陷,并且满足客户设定的验收标准,那么它就可以发布。

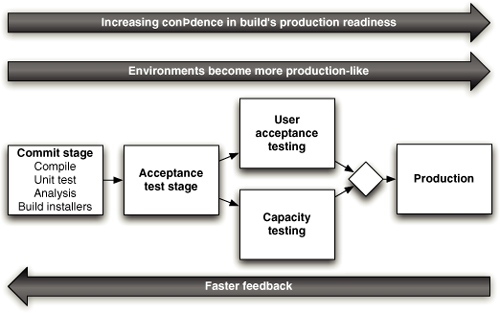

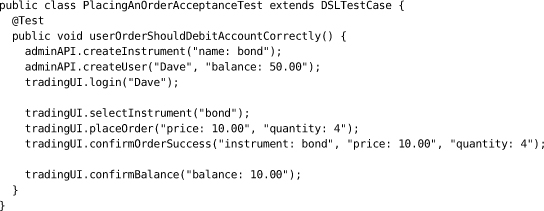

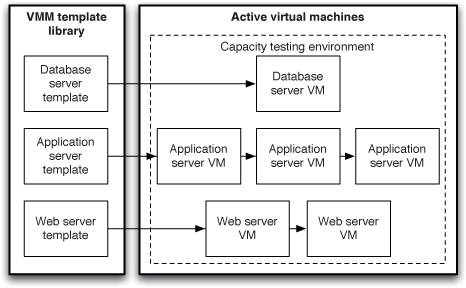

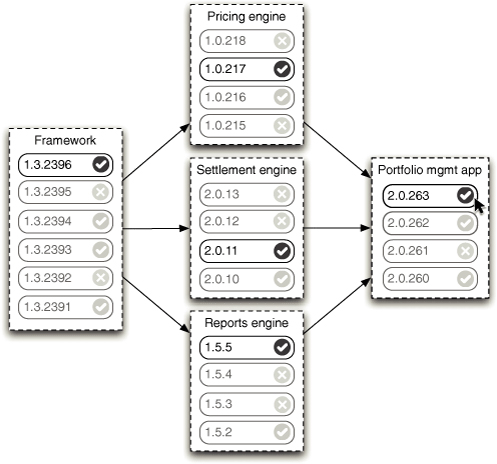

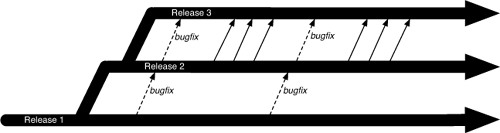

图1.2 发布候选版本的传统视图

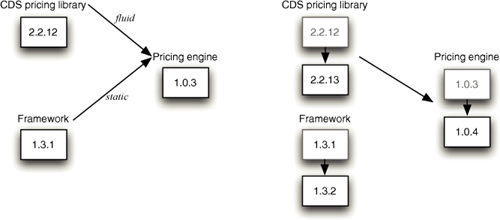

大多数软件发布方法都是在流程末期才确定候选发布版本。当需要进行跟踪工作时,这样做有一定道理。在撰写本文时,维基百科关于开发阶段的条目将”候选发布版本”作为流程中的一个独立步骤([图1.2])。我们的看法略有不同。

传统的软件开发方法会推迟候选发布版本的确定,直到完成几个漫长且昂贵的步骤以确保软件具有足够的质量并在功能上完整。然而,在积极追求构建和部署自动化以及全面自动化测试的环境中,无需在项目末期花费时间和金钱进行漫长的手动密集型测试。在这个阶段,应用程序的质量通常已经显著提高,因此手动测试只是对功能完整性的确认。

实际上,根据我们的经验,将测试推迟到开发流程之后,是降低应用程序质量的可靠方法。缺陷最好在引入时就被发现和修复。当它们在后期被发现时,修复成本总是更高。开发人员已经忘记了引入缺陷时正在做什么,而且功能可能在此期间已经发生了变化。将测试留到最后通常意味着没有时间真正修复bug,或者只能修复其中的一小部分。因此,我们希望在最早的时机发现并修复它们,最好是在它们被提交到代码之前。

开发人员对代码库的每次更改都旨在以某种方式增加价值。提交到版本控制的每次更改都应该增强我们正在开发的系统。我们如何知道这是否属实?唯一的方法是通过运行软件来查看它是否实现了我们所期望的价值。大多数项目将流程的这一部分推迟到正在开发的功能的后期。这意味着据任何人所知,系统在测试或使用时被发现正常工作之前是处于故障状态的。如果在这个时候发现系统有问题,通常需要大量工作才能使系统正常运行。这个阶段通常被称为集成,往往是开发过程中最不可预测和最难管理的部分。由于它如此痛苦,团队会推迟它,不频繁地集成,这只会让情况变得更糟。

在软件开发中,当某件事很痛苦时,减少痛苦的方法是更频繁地做它,而不是更少。因此,我们不应该不频繁地集成,而应该频繁地集成;实际上,我们应该在系统的每次更改后都进行集成。这种持续集成(Continuous Integration)的实践将频繁集成的理念发挥到极致。这样做会在软件开发流程中创造范式转变。持续集成会在破坏系统或不满足客户验收标准的任何更改被引入系统时检测到它。然后团队会在问题发生时立即修复它(这是持续集成的第一条规则)。遵循这种实践时,软件始终处于工作状态。如果您的测试足够全面,并且您在足够类似生产环境的环境中运行测试,那么软件实际上始终处于可发布状态。

每次更改实际上都是一个候选发布版本。每次将更改提交到版本控制时,期望是它将通过所有测试,生成可工作的代码,并且可以发布到生产环境。这是起始假设。持续集成系统的工作是推翻这个假设,证明特定的候选发布版本不适合进入生产环境。

本书背后的理念来自作者多年来参与的大量项目。当我们开始综合我们的想法并将其记录在这些页面上时,我们注意到相同的原则反复出现。我们在此列举了它们。我们所说的某些内容需要解释或附加说明;但以下原则不需要。如果我们希望交付流程有效,这些是我们无法想象缺少的东西。

这个原则实际上是我们撰写本书的目标声明:发布软件应该很容易。之所以容易,是因为您之前已经测试了发布流程的每个部分数百次。它应该像按下按钮一样简单。可重复性和可靠性源于两个原则:几乎自动化一切,并将构建、部署、测试和发布应用程序所需的一切都保存在版本控制中。

部署软件最终涉及三件事:

• 配置和管理应用程序将运行的环境(硬件配置、软件、基础设施和外部服务)。

• 将应用程序的正确版本安装到其中。

• 配置您的应用程序,包括它所需的任何数据或状态。

应用程序的部署可以通过版本控制实现完全自动化的流程。应用程序配置也可以是完全自动化的过程,必要的脚本和状态保存在版本控制或数据库中。显然,硬件无法保存在版本控制中;但是,特别是随着廉价虚拟化技术和Puppet等工具的出现,配置过程也可以实现完全自动化。

本书的其余部分主要描述实现这一原则的策略。

有些事情是不可能自动化的。探索性测试依赖于经验丰富的测试人员。向用户社区代表演示工作软件无法由计算机执行。出于合规目的的审批按定义需要人工干预。然而,无法自动化的事情清单比许多人想象的要少得多。一般来说,你的构建过程应该自动化到需要具体人工指导或决策的程度。你的部署过程以及实际上你的整个软件发布过程也是如此。验收测试可以自动化。数据库升级和降级也可以自动化。甚至网络和防火墙配置也可以自动化。你应该尽可能地自动化一切。

作者可以诚实地说,他们还没有发现无法通过足够的工作和智慧实现自动化的构建或部署过程。

大多数开发团队不自动化他们的发布过程,因为这似乎是一项艰巨的任务。手动操作更容易。也许第一次执行流程中的某个步骤时确实如此,但到第十次执行该步骤时肯定不是这样,到第三或第四次时可能也不是这样。

自动化是部署流水线(deployment pipeline)的前提条件,因为只有通过自动化,我们才能保证人们只需按下按钮就能获得他们需要的东西。然而,你不需要一次自动化所有内容。你应该首先关注构建、部署、测试和发布过程中当前的瓶颈部分。你可以而且应该随着时间逐步自动化。

构建、部署、测试和发布应用程序所需的一切都应该保存在某种形式的版本存储中。这包括需求文档、测试脚本、自动化测试用例、网络配置脚本、部署脚本、数据库创建、升级、降级和初始化脚本、应用程序栈配置脚本、库、工具链、技术文档等等。所有这些东西都应该进行版本控制,并且任何给定构建的相关版本都应该是可识别的。也就是说,这些变更集应该有一个单一标识符,例如构建号或版本控制变更集号,引用每一部分。

新团队成员应该能够坐在新工作站前,检出项目的版本控制仓库,并运行单个命令来构建和部署应用程序到任何可访问的环境,包括本地开发工作站。

还应该能够看到各种应用程序的哪个构建部署到每个环境中,以及这些构建来自版本控制中的哪些版本。

这是我们列表中最通用的原则,或许最好描述为启发式方法(heuristic)。但它可能是我们在交付软件的背景下所知道的最有用的启发式方法,它为我们所说的一切提供了依据。集成通常是一个非常痛苦的过程。如果你的项目中确实如此,那么每次有人签入时就进行集成,并从项目开始时就这样做。如果测试是一个在发布前才发生的痛苦过程,不要在最后才做。相反,从项目开始就持续进行。

如果发布软件很痛苦,那就争取在每次有人签入通过所有自动化测试的更改时发布它。如果你无法在每次更改时发布给真实用户,那就在每次签入时发布到类生产环境。如果创建应用程序文档很痛苦,那就在开发新功能时就做,而不是留到最后。将功能的文档作为完成定义(definition of done)的一部分,并尽可能地自动化该过程。

根据你当前的专业水平,达到这个目标可能需要大量的努力,当然你仍然需要在此期间交付软件。设定中间目标,例如每几周进行一次内部发布,或者如果你已经在这样做,就每周一次。逐步努力接近理想状态——即使是小步前进也会带来巨大的好处。

极限编程(extreme programming)本质上是将这一启发式方法应用于软件开发过程的结果。本书中的大部分建议来自我们将相同原则应用于软件发布过程的经验。

这个原则和本节中我们提到的最后一个原则——持续改进——是从精益运动(lean movement)中借鉴的。“构建质量”是W. Edwards Deming的座右铭,他除了其他成就外,还是精益运动的先驱之一。越早发现缺陷,修复成本越低。如果缺陷从一开始就没有签入版本控制,那么修复成本最低。

我们在本书中描述的技术,如持续集成(continuous integration)、全面自动化测试和自动化部署,旨在尽早在交付过程中捕获缺陷(这是”将痛苦前移”原则的应用)。下一步是修复它们。如果每个人都忽视火警,那么火警就毫无用处。交付团队必须严格遵守一旦发现缺陷就立即修复的纪律。

“构建质量”还有两个推论。首先,测试不是一个阶段,当然也不是在开发阶段之后才开始的阶段。如果将测试留到最后,就为时已晚。将没有时间修复缺陷。其次,测试也不纯粹是、甚至不主要是测试人员的领域。交付团队中的每个人始终都对应用程序的质量负责。

你多久听到一次开发人员说某个故事或功能”完成了”?也许你听过项目经理问那个开发人员它是否”真正完成了”?“完成”是什么意思?实际上,只有当功能向用户交付价值时,它才算完成。这是持续部署实践背后的部分动机(见第10章,“部署和发布应用程序”)。

对于一些敏捷交付团队来说,“完成”意味着发布到生产环境。这是软件开发项目的理想状态。然而,使用这个标准来衡量完成并不总是切实可行的。软件系统的初始发布可能需要一段时间才能达到真正的外部用户从中获益的状态。因此,我们将退而求其次,选择次优方案,即一旦功能成功展示,也就是说,在类生产环境中向用户社区的代表演示并由其试用后,该功能就算”完成”了。

没有”80%完成”这回事。事情要么完成了,要么没有完成。可以估算某件事完成之前剩余的工作——但这些永远只是估算。使用估算来确定剩余工作总量会导致指责和相互推诿,因为那些引用百分比的人最终总会被证明是错误的。

这个原则有一个有趣的推论:让某件事完成不在一个人的能力范围内。需要交付团队中的许多人共同合作才能完成任何事情。这就是为什么每个人——测试人员、构建和运维人员、支持团队、开发人员——从一开始就一起工作如此重要。这也是为什么整个交付团队对交付负责——这个原则如此重要,以至于它有自己的专门章节…

理想情况下,组织内的每个人都与其目标保持一致,人们共同努力帮助彼此实现目标。最终,团队作为一个整体成功或失败,而不是作为个人。然而,在太多项目中,现实是开发人员将工作抛给测试人员。然后测试人员在发布时将工作抛给运维团队。当出现问题时,人们花在相互指责上的时间和修复缺陷的时间一样多,而这些缺陷不可避免地源于这种孤岛式(siloed)的方法。

如果你在一个小型组织或相对独立的部门工作,你可能完全控制发布软件所需的资源。如果是这样,太好了。如果不是,实现这一原则可能需要长期的艰苦工作,以打破隔离不同角色人员的孤岛之间的障碍。

首先,从新项目开始时就让所有参与交付过程的人聚在一起,并确保他们有机会定期频繁地沟通。一旦障碍被打破,这种沟通应该持续进行,但你可能需要逐步朝着这个目标前进。建立一个系统,让每个人都能一目了然地看到应用程序的状态、其健康状况、各种构建、它们通过了哪些测试,以及可以部署到的环境的状态。该系统还应该使人们能够执行他们完成工作所需的操作,例如部署到他们控制的环境。

这是DevOps运动的核心原则之一。DevOps运动专注于我们在本书中设定的同一目标:鼓励所有参与软件交付的人员之间进行更多协作,以便更快、更可靠地发布有价值的软件 [aNgvoV]。

值得强调的是,应用程序的首次发布只是其生命周期的第一阶段。所有应用程序都会演进,并且会有更多发布跟进。重要的是,你的交付过程也要随之演进。

整个团队应该定期聚集在一起,对交付过程进行回顾。这意味着团队应该反思哪些进展顺利、哪些进展不顺利,并讨论如何改进的想法。应该指定某人负责每个想法,并确保付诸实施。然后,下次团队聚集时,他们应该汇报发生了什么。这被称为戴明循环(Deming cycle):计划、执行、研究、行动。

组织中的每个人都参与这个过程至关重要。只允许在孤岛内部而不是跨孤岛进行反馈是灾难的根源:它导致以牺牲整体优化为代价的局部优化——最终导致相互指责。

传统上,软件发布一直是一个充满压力的时刻。同时,与代码创建和管理相关的规范相比,发布被视为一个未经验证的手动过程,依赖于临时的配置管理技术来处理系统配置的关键方面。在我们看来,与软件发布相关的压力及其手动、易出错的特性是相关因素。

通过采用自动化构建、测试和部署技术,我们获得了许多好处。我们能够验证变更,使流程在各种环境中可重复,并在很大程度上消除了错误进入生产环境的机会。我们能够部署变更,从而更快地带来业务收益,因为发布过程本身不再是障碍。实施自动化系统鼓励我们实施其他良好实践,如行为驱动开发和全面的配置管理。

我们还能够花更多的周末与家人和朋友在一起,以更少的压力生活,同时提高工作效率。这有什么不好的呢?生命太短暂,不应该把周末花在服务器机房部署应用程序上。

开发、测试和发布流程的自动化对发布软件的速度、质量和成本产生了深远影响。本书作者之一负责一个复杂的分布式系统。该系统发布到生产环境,包括大规模数据库中的数据迁移,根据特定发布相关的数据迁移规模,需要5到20分钟。迁移数据需要很长时间。我们所知的一个密切相关且可比的系统,同样的流程部分需要30天。

本书的其余部分将在我们提供的建议和推荐方面更加具体,但我们希望这一章能让您从两万英尺高空俯瞰本书的范围——一个理想但现实的视角。我们在这里提到的项目都是真实项目,虽然我们可能稍微掩饰了一些以保护当事人,但我们非常努力地不夸大任何技术细节或任何技术的价值。

配置管理是一个广泛使用的术语,通常作为版本控制的同义词。值得用我们自己的非正式定义为本章设定背景:

配置管理是指一个过程,通过该过程,与您的项目相关的所有工件及其之间的关系被存储、检索、唯一标识和修改。

您的配置管理策略将决定如何管理项目中发生的所有变更。因此,它记录了系统和应用程序的演变。它还将管理团队如何协作——这是任何配置管理策略的一个重要但有时被忽视的后果。

尽管版本控制系统是配置管理中最明显的工具,但决定使用版本控制系统(每个团队都应该使用,无论多小)只是制定配置管理策略的第一步。

最终,如果您有一个良好的配置管理策略,您应该能够对以下所有问题回答”是”:

• 我能否准确重现我的任何环境,包括操作系统版本、补丁级别、网络配置、软件栈、部署到其中的应用程序及其配置?

• 我能否轻松地对这些单个项目中的任何一个进行增量更改,并将更改部署到我的任何或所有环境?

• 我能否轻松地看到特定环境发生的每个更改,并追溯以准确了解更改是什么、谁进行了更改以及何时进行的?

• 我能否满足我所遵守的所有合规法规?

• 团队的每个成员是否容易获得他们需要的信息,并进行他们需要进行的更改?还是该策略妨碍了高效交付,导致周期时间增加和反馈减少?

最后一点很重要,因为我们经常遇到配置管理策略,它们解决了前四点,但在团队之间的协作方面设置了各种障碍。这是不必要的——只要足够小心,最后这个约束不需要与其他约束相矛盾。我们不会在本章告诉您如何回答所有这些问题,尽管我们在整本书中都会解决它们。在本章中,我们将问题分为三个部分:

做好管理应用程序构建、部署、测试和发布过程的先决条件。我们分两部分解决这个问题:将所有内容纳入版本控制和管理依赖关系。

管理应用程序的配置。

整个环境的配置管理——应用程序依赖的软件、硬件和基础设施;环境管理背后的原则,从操作系统到应用服务器、数据库和其他商业现成(COTS)软件。

版本控制系统,也称为源代码控制、源代码管理系统或修订控制系统,是一种保存文件多个版本的机制,因此当您修改文件时,您仍然可以访问以前的修订版本。它们也是参与软件交付的人员进行协作的机制。

最早流行的版本控制系统是一个名为 SCCS(Source Code Control System,源代码控制系统)的专有 UNIX 工具,可以追溯到 1970 年代。它后来被 RCS(Revision Control System,修订控制系统)取代,再后来是 CVS(Concurrent Versions System,并发版本系统)。这三个系统至今仍在使用,尽管市场份额越来越小。如今有大量更好的版本控制系统,包括开源和专有的,专为各种不同环境设计。特别是,我们相信在很少的情况下,开源工具——Subversion、Mercurial 或 Git——无法满足大多数团队的需求。我们将在第 14 章”高级版本控制”中花更多时间探讨版本控制系统及其使用模式,包括分支和合并。

本质上,版本控制系统的目标是双重的:首先,它保留并提供对存储在其中的每个文件的每个版本的访问。这类系统还提供了一种方法,可以将元数据(metadata)——即描述所存储数据的信息——附加到单个文件或文件集合。其次,它允许可能在空间和时间上分布的团队进行协作。

你为什么想这样做?有几个原因,但最终是为了能够回答这些问题:

• 什么构成了软件的特定版本?你如何重现生产环境中存在的软件二进制文件和配置的特定状态?

• 什么时候做了什么,由谁做的,出于什么原因?这不仅在出错时很有用,而且还讲述了你的应用程序的故事。

这些是版本控制的基础。大多数项目使用版本控制。如果你的项目还没有,请阅读接下来的几节,然后放下这本书并立即添加它。以下几节是我们关于如何最有效地使用版本控制的建议。

我们使用术语”版本控制”而不是”源代码控制”的一个原因是,版本控制不仅仅用于源代码。与创建软件相关的每一个工件都应该在版本控制之下。开发人员当然应该用它来管理源代码,还应该用于测试、数据库脚本、构建和部署脚本、文档、库和应用程序的配置文件、编译器和工具集等——这样团队的新成员可以从零开始工作。

同样重要的是存储重新创建应用程序运行的测试和生产环境所需的所有信息。这应该包括应用程序软件栈和构成环境的操作系统的配置信息、DNS 区域文件、防火墙配置等。至少,你需要重新创建应用程序二进制文件及其运行环境所需的所有内容。

目标是以受控的方式存储在项目生命周期中任何时候可能发生变化的所有内容。这使你能够恢复整个系统状态的精确快照,从开发环境到生产环境,在项目历史的任何时刻。甚至将开发团队的开发环境配置文件保存在版本控制中也很有帮助,因为这使团队中的每个人都可以轻松使用相同的设置。分析师应该存储需求文档。测试人员应该将他们的测试脚本和流程保存在版本控制中。项目经理应该在这里保存他们的发布计划、进度图表和风险日志。简而言之,团队的每个成员都应该将与项目相关的任何文档或文件存储在版本控制中。

多年前,其中一位作者在一个项目上工作,该项目由来自三个不同地点的三个不同团队开发。每个团队正在开发的子系统通过 IBM MQSeries 使用专有消息协议相互通信。这是在我们开始使用持续集成作为配置管理问题的防护措施之前。

我们对源代码的版本控制非常严格。我们在职业生涯的早期就学到了这一课。然而,我们的版本控制仅限于源代码。

当接近项目第一次发布,需要集成三个独立的子系统时,我们发现其中一个团队使用的是描述消息协议的功能规范的不同版本。实际上,他们实现的文档已经过时了六个月。自然,我们在试图解决由此引起的问题并保持项目进度时熬了很多夜。

如果我们只是将文档签入版本控制系统,我们就不会遇到这个问题,也不会有那些熬夜!如果我们使用了持续集成,项目会提前很多完成。

我们真的无法过分强调良好的配置管理有多重要。它使本书中的所有其他内容成为可能。如果你的项目没有将所有源工件放入版本控制,你将无法享受我们在本书中讨论的任何好处。我们讨论的所有减少软件周期时间和提高质量的实践,从持续集成和自动化测试到一键式部署,都依赖于将与项目相关的所有内容放在版本控制存储库中。

除了存储源代码和配置信息外,许多项目还在版本控制中存储应用服务器、编译器、虚拟机和工具链其他部分的二进制镜像。这非常有用,可以加快新环境的创建速度,更重要的是,确保基础配置被完全定义,从而确保其可靠性。只需从版本控制仓库中检出所需的所有内容,就能为开发、测试甚至生产环境提供稳定的平台。然后,你可以将整个环境(包括应用了配置基线的基础操作系统)存储为虚拟镜像,以获得更高级别的保障和部署简便性。

这种策略提供了最终的控制和有保障的行为。在如此严格的配置管理下,系统不可能在后续流程阶段添加错误。这种级别的配置管理确保,只要保持仓库完整,你就始终能够检索到软件的可用版本。即使与项目相关的编译器、编程语言或其他工具已经陷入被遗忘的深渊,这也能保护你。

我们不建议在版本控制中保存的一件事是应用程序编译的二进制输出。原因有几个。首先,它们体积大,而且与编译器不同,它们增长迅速(我们为每次编译并通过自动提交测试的检入创建新的二进制文件)。其次,如果你有自动化构建系统,你应该能够通过重新运行构建脚本从源代码轻松重新创建它们。请注意:我们不建议将重新编译作为构建过程的常规部分。但是,构建系统和源代码的组合应该是在紧急情况下重新创建应用程序实例所需的全部内容。最后,存储构建的二进制输出违背了为每个应用程序版本识别仓库单一版本的理念,因为同一版本可能有两次提交,一次用于源代码,另一次用于二进制文件。这可能看起来晦涩难懂,但在创建部署流水线时变得极其重要——这是本书的核心主题之一。

将每个文件的每个版本都放在版本控制中的一个推论是,它允许你主动删除你认为不需要的东西。有了版本控制,你可以用”可以!“来回答”我们应该删除这个文件吗?“这个问题,而且没有风险;如果你做了错误的决定,通过从早期配置集中检索文件就能轻松修复。

这种删除的自由本身就是大型配置集可维护性的重大进步。一致性和组织性是保持大型团队高效工作的关键。清理旧想法和实现的能力使团队能够自由尝试新事物并改进代码。

在使用版本控制时存在一个核心矛盾。一方面,为了获得版本控制的许多好处,例如能够回退到最近的已知良好版本的工件,频繁检入很重要。

另一方面,一旦你将更改检入版本控制,它们就变成公开的,立即对团队中的其他所有人可用。此外,如果你正在使用我们推荐的持续集成(continuous integration),你的更改不仅对团队中的其他开发人员可见;你刚刚创建了一个可能最终进入验收测试甚至生产环境的构建。

由于检入是一种发布形式,重要的是确保你的工作(无论是什么)已经为检入所暗示的公开程度做好准备。这尤其适用于开发人员,鉴于他们工作的性质,他们需要谨慎对待检入的影响。如果开发人员正在系统的复杂部分工作,他们不会希望在完成之前提交代码;他们希望确信代码处于良好状态,不会对系统的其他功能产生不利影响。

在某些团队中,这可能导致检入之间间隔数天甚至数周,这是有问题的。当你定期提交时,版本控制的好处会得到增强。特别是,除非每个人都频繁提交到主线(mainline),否则无法安全地重构应用程序——合并会变得太复杂。如果你频繁提交,你的更改对其他人可见并可以互动,你会得到清楚的指示表明你的更改没有破坏应用程序,并且合并总是小而可管理的。

有些人用来解决这个困境的一个解决方案是在版本控制系统中为新功能创建一个单独的分支。在某个时候,当更改被认为令人满意时,它们将被合并到主开发分支中。这有点像两阶段检入;实际上,一些版本控制系统自然地以这种方式工作。

然而,我们反对这种做法(除了三个例外,在第14章中讨论)。这是一个有争议的观点,尤其是对ClearCase等工具的用户而言。这种方法存在几个问题。

• 它与持续集成相悖,因为创建分支推迟了新功能的集成,并且只有在合并分支时才会发现集成问题。

• 如果多个开发人员创建分支,问题会呈指数级增长,合并过程可能变得极其复杂。

• 尽管有一些优秀的自动合并工具,但它们无法解决语义冲突,例如有人在一个分支中重命名了一个方法,而另一个人在另一个分支中添加了对该方法的新调用。

• 重构代码库变得非常困难,因为分支往往会涉及许多文件,这使得合并变得更加困难。

我们将在第14章”高级版本控制”中更详细地讨论分支和合并的复杂性。

更好的解决方案是增量开发新功能,并定期频繁地将它们提交到版本控制的主干 (trunk) 中。这使软件始终保持工作和集成状态。这意味着您的软件始终经过测试,因为每次签入时,持续集成 (CI) 服务器都会在主干上运行自动化测试。它减少了重构导致的大型合并冲突的可能性,确保集成问题在成本较低时立即被发现和修复,并产出更高质量的软件。我们将在第13章”管理组件和依赖”中更详细地讨论避免分支的技术。

为了确保签入时不会破坏应用程序,有两种实践很有用。一种是在签入之前运行提交测试套件。这是一组运行快速(少于十分钟)但相对全面的测试,用于验证您没有引入任何明显的回归问题。许多持续集成服务器都有一个称为预测试提交 (pretested commit) 的功能,允许您在签入之前在类生产环境中运行这些测试。

第二种是增量引入更改。我们建议您在完成每个单独的增量更改或重构后,将更改提交到版本控制系统。如果您正确使用此技术,您应该每天至少签入一次,通常是每天多次。如果您不习惯这样做,这可能听起来不现实,但我们向您保证,这会带来更高效的软件交付流程。

每个版本控制系统都有添加提交描述的功能。很容易忽略这些消息,许多人养成了这样做的坏习惯。编写描述性提交消息的最重要原因是,当构建失败时,您可以知道是谁破坏了构建以及原因。但这不是唯一的原因。我们的作者因没有使用足够描述性的提交消息而被困扰过好几次,最常见的是在紧迫的截止日期下尝试调试复杂问题时。通常的场景是这样的:

您发现一个 bug,它归因于一行相当晦涩的代码。

您使用版本控制系统查找是谁在什么时候添加了那行代码。

那个人正在休假或已经下班回家,并留下了一条提交消息说”修复了一个晦涩的 bug”。

您更改那行晦涩的代码以修复 bug。

其他东西出问题了。

您花了几个小时试图让应用程序重新工作。

在这些情况下,一条提交消息解释那个人提交更改时正在做什么,可以为您节省数小时的调试时间。这种情况发生得越多,您就越希望自己使用了良好的提交消息。写最短的提交消息没有奖励。一两句中长句概述您正在做什么,通常会在以后为您节省数倍的精力。

我们喜欢的一种风格是多段落提交消息,其中第一段是摘要,后续段落添加更多细节。第一段是在每行一个提交的显示中显示的内容——把它想象成报纸标题,给读者足够的信息来判断她是否有兴趣继续阅读。

您还应该包含项目管理工具中您正在处理的功能或 bug 的标识符链接。在我们工作过的许多团队中,系统管理员会锁定他们的版本控制系统,使得不包含此信息的提交会失败。

应用程序中最常见的外部依赖是它使用的第三方库,以及组织内其他团队正在开发的组件或模块之间的关系。库通常以二进制文件的形式部署,从不被应用程序的开发团队更改,并且很少更新。组件和模块通常由其他团队积极开发,并且变化相当频繁。

我们在第13章”管理组件和依赖”中花费了大量时间讨论依赖关系。然而,在这里,我们将触及依赖管理的一些关键问题,因为它影响配置管理。

外部库通常以二进制形式提供,除非您使用的是解释型语言。即使使用解释型语言,外部库通常也会通过包管理系统(如 Ruby Gems 或 Perl 模块)全局安装在您的系统上。

关于是否对库进行版本控制存在一些争论。例如,Maven 是一个 Java 构建工具,允许您指定应用程序依赖的 JAR 文件,并从互联网上的仓库(或本地缓存,如果您有的话)下载它们。

这并不总是理想的;新团队成员可能被迫”下载整个互联网”(或至少相当大的部分)才能开始项目工作。然而,这确实使版本控制检出变得更小。

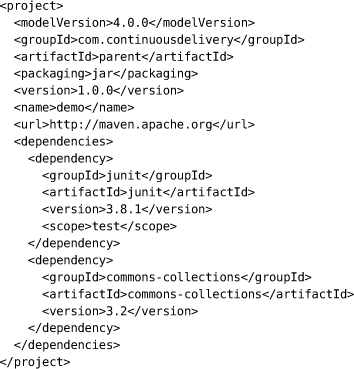

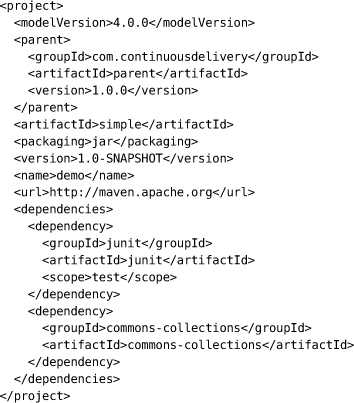

我们建议您在本地保留外部库的副本(对于 Maven,您应该为组织创建一个仓库,其中包含批准使用的库版本)。如果您必须遵守合规法规,这一点至关重要,同时也能加快项目启动速度。这也意味着您始终有能力重现构建。此外,我们强调您的构建系统应该始终指定所使用外部库的确切版本。如果不这样做,就无法重现构建。未能绝对明确还会导致偶尔出现漫长的调试会话,追踪由于人员或构建系统使用不同版本库而导致的奇怪错误。

是否将外部库保存在版本控制中涉及一些权衡。这使得将软件版本与用于构建它们的库版本关联起来变得容易得多。然而,这会使版本控制仓库变大,检出时间更长。

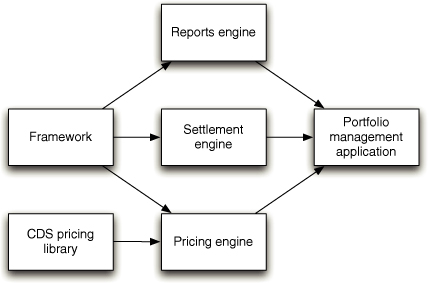

除了最小的应用程序外,将应用程序拆分为组件是一个良好实践。这样做可以限制应用程序变更的范围,减少回归缺陷。它还鼓励重用,并在大型项目中实现更高效的开发流程。

通常,您会从单体构建开始,在一个步骤中为整个应用程序创建二进制文件或安装程序,通常同时运行单元测试。根据您使用的技术栈,单体构建通常是构建中小型应用程序最高效的方式。

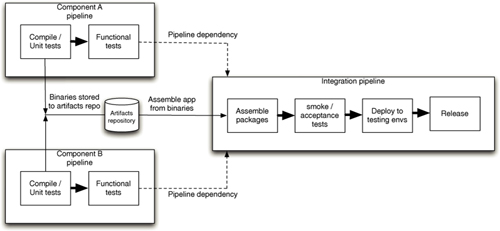

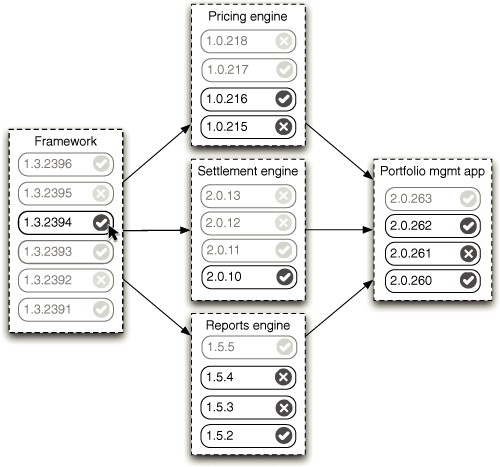

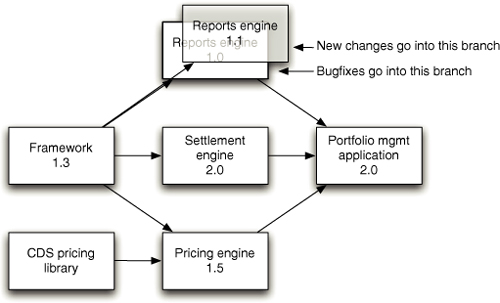

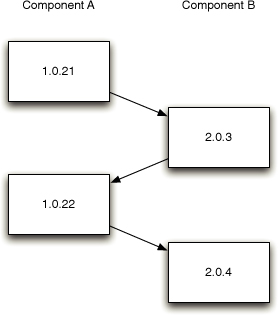

然而,如果您的系统增长或您有多个项目依赖的组件,您可以考虑将组件构建拆分为单独的流水线。如果这样做,重要的是在流水线之间建立二进制依赖而不是源代码依赖。重新编译依赖项不仅效率较低;它还意味着您创建的制品可能与您已经测试过的制品不同。使用二进制依赖可能使追溯故障到导致它的源代码变更变得困难,但优秀的 CI 服务器会帮助您解决这个问题。

虽然现代 CI 服务器在管理依赖方面做得相当好,但它们通常以使在开发人员工作站上重现整个端到端构建过程变得更困难为代价。理想情况下,如果我的机器上检出了几个组件,应该相对简单地在其中一些组件中进行更改,然后运行单个命令,以正确的顺序重建必要的部分,创建适当的二进制文件,并运行相关测试。遗憾的是,这超出了大多数构建系统的能力,至少在没有构建工程师进行大量巧妙处理的情况下是这样,尽管像 Ivy 和 Maven 这样的工具以及 Gradle 和 Buildr 这样的脚本技术确实使生活比以前更容易。

关于管理组件和依赖的更多内容请参见第 13 章。

配置是构成应用程序的三个关键部分之一,另外两个是二进制文件和数据。配置信息可用于在构建时、部署时和运行时改变软件的行为。交付团队需要仔细考虑应该提供哪些配置选项,如何在应用程序的整个生命周期中管理它们,以及如何确保配置在组件、应用程序和技术之间得到一致管理。我们认为您应该像对待代码一样对待系统的配置:使其接受适当的管理和测试。

如果被问到,每个人都想要灵活的软件。为什么不呢?但灵活性通常是有代价的。

显然存在一个连续体:一端是单一用途的软件,它能很好地完成一项工作,但几乎没有修改其行为的能力。频谱的另一端是编程语言,您可以用它来编写游戏、应用服务器或库存控制系统——这就是灵活性!然而,大多数应用程序都不在这两个极端。相反,它们是为特定目的而设计的,但在该目的的范围内,通常会有一些可以修改其行为的方式。

实现灵活性的愿望可能导致常见的反模式”终极可配置性”,这在软件项目中经常被作为需求提出。这充其量是无益的,最坏的情况下,这一个需求就可能扼杀一个项目。

任何时候,当您改变应用程序的行为时,您就是在编程。您编程更改所使用的语言可能或多或少受到约束,但它仍然是编程。您打算为用户提供的可配置性越多,根据定义,您对系统配置施加的约束就越少,因此编程环境需要变得越复杂。

根据我们的经验,认为配置信息的更改风险比源代码更低是一个持久的误区。我们敢打赌,如果同时可以访问这两者,我们通过更改配置就能像更改源代码一样轻松地停止你的系统。如果我们更改源代码,有多种方式可以保护我们自己不犯错;编译器会排除无意义的内容,自动化测试应该能捕获大多数其他错误。另一方面,大多数配置信息是自由格式且未经测试的。在大多数系统中,没有任何机制能阻止我们将URI从”http://www.asciimation.co.nz/“更改为”this is not a valid URI”。大多数系统直到运行时才会捕获这样的更改——到那时,你的用户看到的不是《星球大战》的ASCII版本,而是一个令人讨厌的异常报告,因为URI类无法解析”this is not a valid URI”。

在通往高度可配置软件的道路上有许多重大陷阱,但最糟糕的可能是以下几点。

• 它经常导致分析瘫痪(analysis paralysis),问题看起来如此庞大且如此棘手,以至于团队把所有时间都花在思考如何解决它上,而没有时间真正解决任何问题。

• 系统变得如此复杂以至于难以配置,灵活性的许多好处都丧失了,配置所需的工作量与定制开发的成本相当。

我们曾经遇到过一个客户,他们花了三年时间与一个在其特定垂直市场的打包应用程序供应商合作。这个应用程序被设计得非常灵活,可以配置以满足客户的需求,尽管需要由配置专家来完成。

我们的客户担心该系统仍然远未准备好投入生产使用。我们的组织用Java从头开始实现了一个定制构建的等效系统,只用了八个月。

可配置软件并不总是看起来那样便宜的解决方案。几乎总是更好的做法是专注于以很少的配置交付高价值功能,然后在必要时再添加配置选项。

不要误解我们:配置本身并不邪恶。但它需要被仔细且一致地管理。现代计算机语言已经发展出各种特性和技术来帮助减少错误。在大多数情况下,这些保护机制对配置信息并不存在,而且往往甚至没有任何测试来验证你的软件在测试和生产环境中是否被正确配置。部署冒烟测试(deployment smoke tests),如第117页”冒烟测试你的部署”一节所述,是缓解这个问题的一种方法,应该始终使用。

配置信息可以在构建、部署、测试和发布过程的多个点注入到你的应用程序中,通常会在多个点包含配置。

• 你的构建脚本可以在构建时拉取配置并将其合并到二进制文件中。

• 你的打包软件可以在打包时注入配置,例如在创建assemblies、ears或gems时。

• 你的部署脚本或安装程序可以获取必要的信息或向用户询问,并在部署时作为安装过程的一部分将其传递给你的应用程序。

• 你的应用程序本身可以在启动时或运行时获取配置。

一般来说,我们认为在构建或打包时注入配置信息是不好的做法。这源于这样一个原则:你应该能够将相同的二进制文件部署到每个环境,这样你就可以确保发布的东西与测试的东西是相同的。由此推论,任何在部署之间发生变化的东西都需要作为配置捕获,而不是在应用程序编译或打包时烘焙进去。

J2EE规范的一个严重问题是配置必须与应用程序的其余部分一起打包在war或ear中。除非你使用另一种配置机制而不是规范提供的机制,否则这意味着如果存在任何配置差异,你必须为部署到的每个环境创建不同的war或ear文件。如果你陷入这种情况,你需要找到另一种方式在部署时或运行时配置你的应用程序。我们在下面提供了一些建议。

通常能够在部署时配置你的应用程序是很重要的,这样你就可以告诉它所依赖的服务(如数据库、消息服务器或外部系统)位于何处。例如,如果你的应用程序的运行时配置存储在数据库中,你可能希望在部署时将数据库的连接参数传递给应用程序,以便它在启动时可以检索它。

如果你控制生产环境,通常可以安排部署脚本获取此配置并将其提供给你的应用程序。对于打包软件的情况,默认配置通常是包的一部分,但需要有某种方式在部署时覆盖它以用于测试目的。

最后,您可能需要在启动时或运行时配置应用程序。启动时配置可以通过环境变量或启动系统的命令参数来提供。或者,您可以使用与运行时配置相同的机制:注册表设置、数据库、配置文件或外部配置服务(例如通过 SOAP 或 REST 风格的接口访问)。

无论您选择哪种机制,我们强烈建议,在实际可行的范围内,您应该尝试通过相同的机制为组织中的所有应用程序和环境提供所有配置信息。这并非总是可行,但如果可以做到,这意味着只有一个配置源需要更改、管理、版本控制和覆盖(如有必要)。在没有遵循这一实践的组织中,我们看到人们经常花费数小时在其环境中追踪某个特定设置的来源。

管理应用程序配置时需要考虑三个问题:

如何表示配置信息?

部署脚本如何访问它?

它在不同环境、应用程序和应用程序版本之间如何变化?

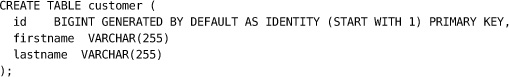

配置信息通常被建模为一组名称-值字符串。

有时在配置系统中使用类型并以层次结构组织它是有用的。包含按标题组织的名称-值字符串的 Windows 属性文件、Ruby 世界中流行的 YAML 文件以及 Java 属性文件都是相对简单的格式,在大多数情况下提供了足够的灵活性。复杂度的有用上限可能是将配置存储为 XML 文件。

存储应用程序配置有几个明显的选择:数据库、版本控制系统或目录或注册表。版本控制可能是最简单的——您只需签入配置文件,就可以免费获得配置随时间变化的历史记录。值得将应用程序的可用配置选项列表保存在与其源代码相同的仓库中。

请注意,存储配置的位置与应用程序访问配置的机制不同。您的应用程序可以通过本地文件系统上的文件访问其配置,或通过更特殊的机制(如 Web 或目录服务)或通过数据库访问;下一节将详细介绍。

通常重要的是将特定于应用程序每个测试和生产环境的实际配置信息保存在与源代码分离的仓库中。这些信息通常以不同于其他版本控制工件的速率变化。但是,如果采用这种方式,您必须小心跟踪哪些版本的配置信息与哪些版本的应用程序匹配。这种分离对于安全相关的配置元素(如密码和数字证书)尤其重要,对这些元素的访问应该受到限制。

如果运维人员发现您这样做,他们会用勺子挖出您的眼睛。不要给他们这个机会。如果必须将密码存储在大脑之外的某个地方,您可以尝试将它们以加密形式放在主目录中。

这种技术的一个严重变体是将应用程序某一层的密码存储在访问它的层的代码或文件系统中的某个位置。密码应该始终由执行部署的用户输入。有几种可接受的方法来处理多层系统的身份验证。您可以使用证书、目录服务或单点登录系统。

数据库、目录和注册表是存储配置的便利位置,因为它们可以远程访问。但是,请确保保留配置更改的历史记录,以便审计和回滚。要么使用自动处理此问题的系统,要么将版本控制视为配置的参考系统,并使用脚本在需要时将适当版本加载到数据库或目录中。

访问配置

管理配置最有效的方法是拥有一个中央服务,每个应用程序都可以通过它获取所需的配置。这对打包软件和内部企业应用程序以及托管在互联网上的软件即服务(SaaS)都同样适用。这些场景之间的主要区别在于何时注入配置信息——对于打包软件是在打包时,否则是在部署时或运行时。

应用程序访问其配置的最简单方法可能是通过文件系统。这具有跨平台和每种语言都支持的优势——尽管它可能不适合沙箱运行时(如小程序)。如果需要在集群上运行应用程序,还存在保持文件系统上配置同步的问题。

另一种替代方案是从集中式存储库(如 RDBMS、LDAP 或 Web 服务)获取配置。一个名为 ESCAPE [apvrEr] 的开源工具使得通过 RESTful 接口管理和访问配置信息变得简单。应用程序可以执行 HTTP GET 请求,在 URI 中包含应用程序名称和环境名称来获取其配置。当在部署时或运行时配置应用程序时,这种机制最有意义。你可以通过属性、命令行开关或环境变量将环境名称传递给部署脚本,然后脚本从配置服务获取相应的配置,并将其提供给应用程序,可能以文件系统上的文件形式。

无论配置信息存储的性质如何,我们建议你使用一个简单的外观类(Façade)将技术细节与应用程序隔离开来,提供

getThisProperty() getThatProperty()

风格的接口,这样你可以在测试中模拟它,并在需要时更改存储机制。

配置建模

每个配置设置都可以建模为一个元组(Tuple),因此应用程序的配置由一组元组组成。然而,可用元组的集合及其值通常取决于三个因素:

• 应用程序

• 应用程序的版本

• 运行环境(例如:开发、UAT、性能测试、预发布或生产)

例如,报表应用程序的 1.0 版本将拥有一组与 2.2 版本或投资组合管理应用程序 1.0 版本不同的元组。这些元组的值又会根据部署的环境而变化。例如,应用程序在 UAT 中使用的数据库服务器通常与生产环境中使用的不同,甚至可能在开发人员机器之间有所不同。这同样适用于打包软件或外部集成点——应用程序使用的更新服务在运行集成测试时与从客户端桌面访问时会有所不同。

无论你使用什么来表示和提供配置信息——源代码控制中的 XML 文件或 RESTful Web 服务——都应该能够处理这些不同的维度。以下是建模配置信息时要考虑的一些用例。

• 添加新环境(也许是新的开发人员工作站或容量测试环境)。在这种情况下,你需要能够为部署到这个新环境的应用程序指定一组新的值。

• 创建应用程序的新版本。通常,这会引入新的配置设置并删除一些旧的配置。你应该确保将这个新版本部署到生产环境时,它能获取新的设置,但如果必须回滚到旧版本,它将使用旧的设置。

• 将应用程序的新版本从一个环境提升到另一个环境。你应该确保任何新设置在新环境中可用,但为这个新环境设置了适当的值。

• 迁移数据库服务器。你应该能够非常简单地更新引用此数据库的每个配置设置,使其指向新的数据库。

• 使用虚拟化管理环境。你应该能够使用虚拟化管理工具创建特定环境的新实例,其中所有虚拟机都正确配置。你可能希望将此信息作为部署到该环境的应用程序特定版本的配置设置的一部分。

跨环境管理配置的一种方法是将预期的生产配置作为默认值,并在其他环境中适当覆盖此默认值(确保设置防火墙,以免生产系统被误操作)。这意味着任何特定环境的定制都减少到只需更改软件在该特定环境中工作所必需的那些配置属性。这简化了需要在何处配置什么的全貌。然而,这也取决于你的应用程序的生产配置是否具有特权——一些组织期望将生产配置保存在与其他环境分离的存储库中。

测试系统配置

与应用程序和构建脚本需要测试一样,配置设置也需要测试。测试配置有两个部分。

第一阶段是确保配置设置中对外部服务的引用是有效的。作为部署脚本的一部分,你应该确保配置使用的消息总线(Messaging Bus)确实在配置的地址上运行,并且应用程序在功能测试环境中期望使用的模拟订单履行服务(Mock Order Fulfillment Service)正在工作。至少,你可以 ping 所有外部服务。如果应用程序依赖的任何内容不可用,部署或安装脚本应该失败——这可以作为配置设置的绝佳冒烟测试(Smoke Test)。

第二阶段是在安装应用程序后实际运行一些冒烟测试,以确保它按预期运行。这应该只涉及几个测试,测试依赖于配置设置正确的功能。理想情况下,如果结果不符合预期,这些测试应该停止应用程序并使安装或部署过程失败。

管理配置的问题在中大型组织中尤其复杂,因为需要同时管理许多应用程序。通常在这类组织中,存在着配置选项晦涩难懂的遗留应用程序。最重要的任务之一是维护一个目录,记录每个应用程序的所有配置选项、它们的存储位置、生命周期以及修改方式。

如果可能,此类信息应该在构建过程中从每个应用程序的代码中自动生成。但如果无法实现,则应该将其收集到wiki或其他文档管理系统中。

在管理非完全用户安装的应用程序时,了解每个运行中应用程序的当前配置非常重要。目标是能够通过运维团队的生产监控系统查看每个应用程序的配置,该系统还应显示每个应用程序的哪个版本部署在哪个环境中。Nagios、OpenNMS和HP OpenView等工具都提供了记录此类信息的服务。或者,如果以自动化方式管理构建和部署过程,配置信息应始终通过该过程应用,因此应存储在版本控制或像Escape这样的工具中。

当应用程序相互依赖且必须协调部署时,实时访问这些信息尤为重要。无数时间浪费在一个应用程序的几个配置选项设置错误,从而导致整套服务瘫痪。这类问题极难诊断。

每个应用程序的配置管理都应该在项目启动阶段进行规划。考虑生态系统中其他应用程序如何管理配置,如果可能的话使用相同的方法。太多情况下,如何管理配置的决策是临时做出的,结果是每个应用程序将配置打包在不同位置,使用不同的机制访问。这使得确定环境配置变得不必要地困难。

像对待代码一样对待应用程序的配置。妥善管理并测试它。以下是创建应用程序配置系统时需要考虑的原则列表:

• 考虑在应用程序生命周期的哪个阶段注入特定配置项才有意义—是在打包发布候选版本的组装阶段,部署或安装时,启动时,还是运行时。与运维和支持团队沟通以了解他们的需求。

• 将应用程序的可用配置选项保存在与源代码相同的仓库中,但将具体值保存在其他地方。配置设置的生命周期与代码完全不同,而密码和其他敏感信息根本不应该检入版本控制。

• 配置应始终由自动化流程使用从配置仓库中获取的值来执行,这样您就可以随时识别每个环境中每个应用程序的配置。

• 您的配置系统应该能够根据应用程序、其版本以及部署的环境,为应用程序(包括其打包、安装和部署脚本)提供不同的值。任何人都应该能够轻松查看特定版本的应用程序在将要部署的所有环境中有哪些可用配置选项。

• 为配置选项使用清晰的命名约定。避免晦涩或隐晦的名称。试着想象有人在没有手册的情况下阅读配置文件—应该能够理解配置属性是什么。

• 确保配置信息是模块化和封装的,这样一处更改不会对其他看似无关的配置部分产生连锁影响。

• 使用DRY(不要重复自己)原则。定义配置元素时,让每个概念在配置信息集合中只有一个表示。

• 保持极简主义:使配置信息尽可能简单和专注。除非有需求或确实有意义,否则避免创建配置选项。

• 避免过度设计配置系统。保持尽可能简单。

• 确保有针对配置的测试,并在部署或安装时运行。检查应用程序依赖的服务是否可用,并使用冒烟测试(smoke test)来断言依赖配置设置的任何功能是否按预期工作。

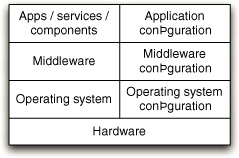

没有应用程序是孤岛。每个应用程序都依赖于硬件、软件、基础设施和外部系统才能工作。在本书中,我们将其称为应用程序的环境。我们在第11章”管理基础设施和环境”中详细讨论了环境管理主题,但该主题在配置管理的背景下值得一些讨论,因此我们将在此介绍。

在管理应用程序运行环境时要牢记的原则是:环境配置与应用程序配置同样重要。例如,如果您的应用程序依赖于消息总线,总线必须正确配置,否则应用程序将无法工作。操作系统的配置也很重要。例如,您可能有一个依赖大量文件描述符的应用程序。如果操作系统默认的文件描述符数量限制较低,您的应用程序就无法工作。

管理配置信息最糟糕的方法是以临时方式处理。这意味着手动安装必需的软件并编辑相关配置文件。这是我们遇到的最常见策略。尽管看似简单,但这种策略在除最简单系统之外的所有系统中都会出现几个常见问题。最明显的陷阱是,如果新配置因任何原因无法工作,很难确定地返回到已知的良好状态,因为没有先前配置的记录。问题可以总结如下:

• 配置信息的集合非常庞大

• 一个小改动就可能破坏整个应用程序或严重降低其性能

• 一旦出现问题,找到并修复它需要不确定的时间,并且需要高级人员参与

• 极难精确复现手动配置的环境用于测试

• 难以维护这样的环境而不使不同节点的配置和行为发生偏离

在《The Visible Ops Handbook》(可见运维手册)中,作者将手动配置的环境称为”艺术品”。为了降低管理环境的成本和风险,必须将我们的环境转变为可重复创建且耗时可预测的批量生产对象。我们参与过太多项目,糟糕的配置管理意味着巨大的开支——仅为处理系统这一方面就要支付团队人员的费用。它还持续拖累开发流程的生产力,使测试环境、开发环境和生产环境的部署比必要的复杂和昂贵得多。

管理环境的关键是使其创建成为完全自动化的过程。创建新环境应该总是比修复旧环境更便宜。能够复现环境至关重要,原因如下:

• 消除了存在随机基础设施的问题,这些基础设施的配置只有已离职且无法联系的人才了解。当这些东西停止工作时,通常意味着严重的停机时间。这是一个巨大且不必要的风险。

• 修复一个环境可能需要许多小时。能够在可预测的时间内重建它以恢复到已知良好状态总是更好。

• 必须能够为测试目的创建生产环境的副本。在软件配置方面,测试环境应该是生产环境的精确复制品,这样可以及早发现配置问题。

您应该关注的环境配置信息类型包括:

• 环境中的各种操作系统,包括其版本、补丁级别和配置设置

• 支持应用程序所需安装在每个环境上的其他软件包,包括其版本和配置

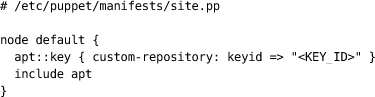

• 应用程序工作所需的网络拓扑

• 应用程序依赖的任何外部服务,包括其版本和配置

• 其中存在的任何数据或其他状态(例如生产数据库)

我们发现有两个原则构成了有效配置管理策略的基础:将二进制文件与配置信息分开,并将所有配置信息集中在一个地方。将这些基本原则应用于系统的每个部分,将为创建新环境、升级系统部分以及在不使系统不可用的情况下推出新配置铺平道路,使其成为一个简单的自动化过程。

所有这些都需要考虑。虽然将操作系统签入版本控制显然不合理,但对其配置进行版本控制肯定是合理的。远程安装系统和环境管理工具(如Puppet和CfEngine)的组合使操作系统的集中管理和配置变得简单。第11章”管理基础设施和环境”详细介绍了这个主题。

对于大多数应用程序,将此原则应用于它们依赖的第三方软件堆栈更为重要。好的软件具有可以从命令行运行而无需任何用户干预的安装程序。它具有可以在版本控制中管理且不需要手动干预的配置。如果您的第三方软件依赖项不符合这些标准,您应该寻找替代方案——这些第三方软件选择标准非常重要,应该成为每个软件评估工作的核心。在评估第三方产品和服务时,首先要问以下问题:

• 我们能部署它吗?

• 我们能有效地对其配置进行版本控制吗?

• 它将如何融入我们的自动化部署策略?

如果这些问题中的任何一个答案是否定的,都有各种可能的应对方法——我们在[第11章]中会更详细地讨论它们。

处于正确部署状态的环境在配置管理(Configuration Management)术语中被称为基线(Baseline)。您的自动化环境配置系统应该能够建立或重新建立项目最近历史中存在过的任何给定基线。每当您更改应用程序宿主环境的任何方面时,都应该存储这个更改,创建基线的新版本,并将该版本的应用程序与新版本的基线关联起来。这样可以确保下次部署应用程序或创建新环境时,会包含这个更改。

本质上,您应该像对待代码一样对待您的环境——以增量方式更改它并将更改检入版本控制。每个更改都应该经过测试,以确保它不会破坏在新版本环境中运行的任何应用程序。

我们最近参与的两个项目突出展示了配置管理的有效使用与不太有效方法之间的差异。

在第一个项目中,我们决定替换项目所基于的消息传递基础设施。我们有非常有效的配置管理和良好的模块化设计。在替换基础设施之前,我们尝试升级到供应商向我们保证能解决大部分问题的最新版本。

我们的客户和供应商显然认为这次升级是件大事。他们已经为此计划了几个月,并担心对开发团队的破坏性影响。结果,我们团队的两名成员按照本节所述的方式准备了一个新的基线。我们在本地进行了测试,包括在试用版本上运行完整的验收测试包。我们的测试发现了许多问题。

我们修复了最明显的问题,但没有让所有验收测试都通过。然而,我们已经到达了一个可以确信修复应该是直接的点,而且我们的最坏情况是必须恢复到之前的基线镜像,所有这些都安全地存储在版本控制中。在获得开发团队其他成员的同意后,我们提交了我们的更改,这样整个团队就可以一起修复消息传递基础设施版本更改带来的错误。整个过程花了一天时间,包括运行所有自动化测试来验证我们的工作。在随后的迭代中,我们在手动测试期间仔细观察是否有更多错误,但一个也没有。我们的自动化测试覆盖率被证明是足够好的。

在第二个项目中,我们被要求对一个已经在生产环境中运行了几年的老旧遗留系统进行一些修复工作,该系统缓慢且容易出错。当我们到达时,它没有任何自动化测试,只有源代码级别的最基本配置管理。我们的任务之一是更新应用服务器的版本,因为系统运行的版本已经不再被供应商支持。对于处于这种状态的应用程序,没有支持的持续集成系统,也没有任何自动化测试,这个过程进行得还算顺利。然而,一个六人小团队花了两个月才完成更改、测试并部署到生产环境。

与软件项目一样,不可能进行直接比较。所涉及的技术完全不同,代码库也是如此。然而,两者都涉及升级核心中间件基础设施。一个花了六人团队两个月,另一个花了两个人半天时间。

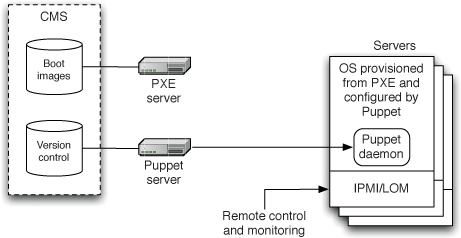

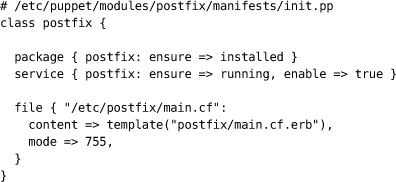

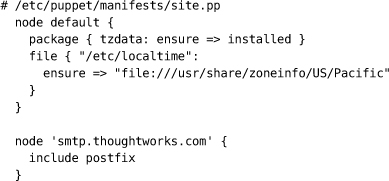

Puppet和CfEngine是两个可以自动化方式管理操作系统配置的工具示例。使用这些工具,您可以声明式地定义诸如哪些用户应该有权访问您的服务器以及应该安装什么软件之类的内容。这些定义可以存储在您的版本控制系统中。在您的系统上运行的代理程序会定期拉取最新配置并更新操作系统和安装在其上的软件。有了这样的系统,就没有理由登录到服务器上进行修复:所有更改都可以通过版本控制系统启动,因此您拥有每个更改的完整记录——何时进行的以及由谁进行的。

虚拟化也可以提高环境管理过程的效率。您可以简单地复制环境中每个服务器的副本并将其存储为基线,而不是使用自动化过程从头创建新环境。然后创建新环境就变得微不足道了——只需点击一个按钮即可完成。虚拟化还有其他好处,例如能够整合硬件以及标准化您的硬件平台,即使您的应用程序需要异构环境。

我们在[第11章]“管理基础设施和环境”中更详细地讨论这些工具。

最后,能够管理对环境进行更改的过程至关重要。生产环境应该完全锁定。在不经过组织的变更管理流程的情况下,任何人都不可能对其进行更改。原因很简单:即使是微小的更改也可能破坏它。更改必须在进入生产环境之前进行测试,为此应该将其脚本化并检入版本控制。然后,一旦更改获得批准,就可以以自动化的方式将其推广到生产环境。

从这个意义上说,对环境的更改就像对软件的更改一样。它必须以与应用程序代码更改完全相同的方式经过构建、部署、测试和发布流程。

在这方面,测试环境应该与生产环境一样对待。审批流程通常会更简单——它应该掌握在管理测试环境的人员手中——但在所有其他方面,它们的配置管理是相同的。这至关重要,因为这意味着您正在测试用于管理生产环境的流程,而测试是在更频繁地部署到测试环境期间进行的。值得重申的是,测试环境在软件配置方面应该与生产环境非常相似——这样在部署到生产环境时就不会出现意外。这并不意味着测试环境必须是昂贵的生产环境的克隆;而是说它们应该通过相同的机制进行管理、部署和配置。

配置管理是本书中所有其他内容的基础。没有它,就不可能进行持续集成、发布管理和部署流水线。它还对交付团队内部的协作产生巨大的积极影响。正如我们希望已经说清楚的那样,这不仅仅是选择和实施工具的问题,尽管这很重要;至关重要的是,这也是将良好实践付诸实施的问题。

如果您的配置管理流程是健全的,您应该能够对以下问题回答”是”:

• 您能否从存储的版本控制资产中从头开始完全重新创建生产系统(不包括生产数据)?

• 您能否回退到应用程序的早期已知良好状态?

• 您能否确保生产、预发布和测试中部署的每个环境都以完全相同的方式设置?

如果不能,那么您的组织就面临风险。特别是,我们建议制定一个策略来存储基线并控制以下内容的更改:

• 应用程序的源代码、构建脚本、测试、文档、需求、数据库脚本、库和配置文件

• 开发、测试和运维工具链

• 开发、测试和生产中使用的所有环境

• 与应用程序关联的整个应用程序栈——包括二进制文件和配置

• 在整个应用程序生命周期(构建、部署、测试、运维)中,应用程序在其运行的每个环境中的配置

许多软件项目的一个极其奇怪但常见的特征是,在开发过程中的很长一段时间内,应用程序并不处于工作状态。事实上,大型团队开发的大多数软件在其开发时间中有相当大的一部分处于不可用状态。原因很容易理解:在应用程序完成之前,没有人有兴趣尝试运行整个应用程序。开发人员检入更改,甚至可能运行自动化单元测试,但没有人尝试实际启动应用程序并在类似生产的环境中使用它。

对于使用长期存在的分支或将验收测试推迟到最后的项目来说,这一点更是如此。许多此类项目在开发结束时安排冗长的集成阶段,以便让开发团队有时间合并分支并使应用程序正常工作,以便可以进行验收测试。更糟糕的是,一些项目发现,当他们进入这个阶段时,他们的软件不适合目的。这些集成期可能需要极长的时间,最糟糕的是,没有人能够预测需要多长时间。

另一方面,我们见过一些项目,它们最多只有几分钟处于应用程序无法使用最新更改的状态。区别在于使用持续集成。持续集成要求每次有人提交任何更改时,都要构建整个应用程序,并对其运行一套全面的自动化测试。至关重要的是,如果构建或测试过程失败,开发团队会停止正在做的任何事情,并立即修复问题。持续集成的目标是软件始终处于工作状态。

持续集成最早在 Kent Beck 的《解析极限编程》(Extreme Programming Explained) 一书中被提及(首次出版于 1999 年)。与其他极限编程实践一样,持续集成背后的理念是,如果定期集成代码库是好的,为什么不一直这样做呢?在集成的背景下,“一直”意味着每次有人向版本控制系统提交任何更改时。正如我们的一位同事 Mike Roberts 所说,“持续比你想象的更频繁” [aEu8Nu]。

持续集成代表了一种范式转变。没有持续集成时,你的软件在被证明可以工作之前一直是损坏的,这通常发生在测试或集成阶段。有了持续集成,你的软件在每次新变更时都被证明是可以工作的(假设有一套足够全面的自动化测试)——而且你能在软件出问题的那一刻就知道,并立即修复它。有效使用持续集成的团队能够比不使用的团队更快地交付软件,并且bug更少。bug在交付过程的早期就被发现,修复成本更低,从而显著节省了成本和时间。因此,我们认为持续集成是专业团队的一项基本实践,可能与使用版本控制一样重要。

本章其余部分描述了如何实施持续集成。我们将解释随着项目变得更加复杂时出现的常见问题的解决方法,列出支持持续集成的有效实践及其对设计和开发过程的影响。我们还将讨论更高级的主题,包括如何在分布式团队中进行持续集成。

持续集成在本书的配套书籍中有详细论述:Paul Duvall的《Continuous Integration》(持续集成)(Addison-Wesley, 2006)。如果你想要比我们在本章提供的更多细节,那就是你应该去的地方。

本章主要面向开发人员。然而,它也包含一些我们认为对想要更多了解持续集成实践的项目经理有用的信息。

持续集成的实践依赖于某些先决条件。我们将介绍这些先决条件,然后看看可用的工具。也许最重要的是,持续集成依赖于团队遵循一些基本实践,所以我们将花一些时间讨论这些。

在开始持续集成之前,你需要三样东西。

1. 版本控制

项目中的所有内容都必须签入单个版本控制仓库:代码、测试、数据库脚本、构建和部署脚本,以及创建、安装、运行和测试应用程序所需的任何其他内容。这可能听起来很明显,但令人惊讶的是,仍然有项目不使用任何形式的版本控制。有些人认为他们的项目不够大,不值得使用版本控制。我们不相信有小到可以不使用版本控制的项目。当我们在自己的计算机上为自己的需求编写代码时,我们仍然使用版本控制。现在存在几种简单、强大、轻量级且免费的版本控制系统。

我们在第32页的”使用版本控制”部分和第14章”高级版本控制”中更详细地描述了修订控制系统的选择和使用。

2. 自动化构建

你必须能够从命令行启动构建。你可以从一个命令行程序开始,该程序告诉你的IDE构建软件,然后运行测试,或者它可以是一组复杂的多阶段构建脚本相互调用。无论是什么机制,人或计算机都必须能够通过命令行以自动化方式运行你的构建、测试和部署过程。

如今,IDE和持续集成工具已经变得相当复杂,你通常可以在不接近命令行的情况下构建软件并运行测试。但是,我们认为你仍然应该有可以通过命令行运行的构建脚本,而不需要IDE。这可能看起来有争议,但有几个原因:

• 你需要能够从持续集成环境以自动化方式运行构建过程,以便在出现问题时可以进行审计。

• 你的构建脚本应该像代码库一样对待。它们应该被测试并不断重构,以便保持整洁和易于理解。使用IDE生成的构建过程是不可能做到这一点的。随着项目变得越来越复杂,这一点变得越来越重要。

• 它使理解、维护和调试构建变得更容易,并允许与运维人员更好地协作。

3. 团队的共识

持续集成是一种实践,而不是工具。它需要开发团队一定程度的承诺和纪律。你需要每个人频繁地将小的增量变更签入主线,并同意项目的最高优先级任务是修复任何破坏应用程序的变更。如果人们不采用使其工作所必需的纪律,你尝试持续集成将不会带来你希望的质量改进。

你不需要持续集成软件来进行持续集成——正如我们所说,它是一种实践,而不是工具。James Shore在一篇名为”Continuous Integration on a Dollar a Day”(一美元一天的持续集成)的文章[bAJpjp]中描述了开始持续集成的最简单方法,只使用一台闲置的开发机器、一只橡皮鸡和一个铃铛。这篇文章值得一读,因为它很好地展示了持续集成的基本要素,除了版本控制之外没有任何工具。

然而实际上,如今的持续集成工具安装和运行都非常简单。有几个开源选项可供选择,例如 Hudson 和久负盛名的 CruiseControl 家族(CruiseControl、CruiseControl.NET 和 CruiseControl.rb)。特别是 Hudson 和 CruiseControl.rb 的启动和运行极其简单。CruiseControl.rb 非常轻量级,任何具备一定 Ruby 知识的人都可以轻松扩展它。Hudson 拥有大量插件,可以与构建和部署生态系统中的几乎所有工具集成。

在撰写本文时,有两款商业持续集成服务器提供了面向小型团队的免费版本:ThoughtWorks Studios 的 Go 和 JetBrains 的 TeamCity。其他流行的商业持续集成服务器包括 Atlassian 的 Bamboo 和 Zutubi 的 Pulse。也可用于简单持续集成的高端发布管理和构建加速系统包括 UrbanCode 的 AntHillPro、ElectricCloud 的 ElectricCommander 和 IBM 的 BuildForge。市面上还有更多系统可供选择;完整列表请访问持续集成功能对比表 [bHOgH4]。

一旦安装了你选择的持续集成工具,在满足上述前提条件的情况下,只需几分钟即可开始使用,只需告诉工具在哪里找到源代码控制仓库、运行什么脚本来编译(如有必要)以及为应用程序运行自动化提交测试,以及如何在最新一组更改破坏软件时通知你。

第一次在持续集成工具上运行构建时,你可能会发现运行持续集成工具的机器缺少一堆软件和设置。这是一个独特的学习机会——记下你为使其正常工作所做的一切,并将其放在项目的 wiki 上。你应该花时间将系统依赖的任何软件或设置检入版本控制,并自动化配置新机器的过程。

下一步是让每个人都开始使用持续集成服务器。以下是一个简单的流程。

准备检入最新更改时:

检查构建是否已在运行。如果是,等待它完成。如果失败,需要与团队其他成员一起使构建通过,然后再检入。

构建完成且测试通过后,从版本控制仓库的此版本更新开发环境中的代码以获取任何更新。

在开发机器上运行构建脚本和测试,确保一切在你的计算机上仍然正常工作,或者使用持续集成工具的个人构建功能。

如果本地构建通过,将代码检入版本控制。

等待持续集成工具使用你的更改运行构建。

如果失败,停止手头工作并立即在开发机器上修复问题——转到步骤 3。

如果构建通过,庆祝并继续下一个任务。

如果团队中的每个人在每次提交任何更改时都遵循这些简单步骤,你就能知道软件在任何与持续集成机器配置相同的机器上始终可以工作。

持续集成本身不会修复你的构建过程。事实上,如果在项目中期才开始实施,可能会非常痛苦。要使持续集成有效,在开始之前需要具备以下实践。

要使持续集成正常工作,最重要的实践是频繁检入主干或主线。你应该每天至少检入几次代码。

定期检入带来许多其他好处。它使你的更改更小,因此不太可能破坏构建。这意味着当你犯错或走错路时,可以恢复到最近的已知良好版本。它帮助你更加自律地进行重构,坚持保持行为不变的小更改。它有助于确保修改大量文件的更改不太可能与其他人的工作冲突。它允许开发人员更具探索性,尝试想法并通过回退到最后提交的版本来放弃它们。它迫使你定期休息并伸展肌肉,帮助避免腕管综合征(carpal tunnel syndrome)或重复性劳损(RSI)。这也意味着如果发生灾难性事件(例如误删除某些内容),你不会丢失太多工作。

我们特意提到检入主干。许多项目使用版本控制中的分支来管理大型团队。但在使用分支时不可能真正进行持续集成,因为根据定义,如果你在分支上工作,你的代码就没有与其他开发人员的代码集成。使用长期分支的团队面临着与本章开头描述的完全相同的集成问题。除非在非常有限的情况下,否则我们不建议使用分支。关于这些问题的更详细讨论请参见第 14 章“高级版本控制”。

如果没有全面的自动化测试套件,构建通过只意味着应用程序可以编译和组装。虽然对某些团队来说这是一大进步,但必须具备一定程度的自动化测试才能提供应用程序实际运行的信心。自动化测试有多种类型,我们将在下一章详细讨论。然而,我们感兴趣的是从持续集成构建中运行三种测试:单元测试(unit tests)、组件测试(component tests)和验收测试(acceptance tests)。

单元测试用于测试应用程序中小部分代码的行为(例如一个方法、一个函数,或者它们之间的少量交互)。单元测试通常不需要启动整个应用程序就可以运行。它们不访问数据库(如果你的应用程序有数据库)、文件系统或网络。它们不需要应用程序在类生产环境中运行。单元测试应该运行得非常快——即使是大型应用程序,整个测试套件也应该能在十分钟内完成。

组件测试测试应用程序中多个组件的行为。与单元测试类似,它们并不总是需要启动整个应用程序。但是,它们可能会访问数据库、文件系统或其他系统(这些系统可能被打桩处理)。组件测试通常运行时间较长。

验收测试测试应用程序是否满足业务决定的验收标准,包括应用程序提供的功能及其特性,如容量、可用性、安全性等。验收测试最好以能够在类生产环境中针对整个应用程序运行的方式编写。验收测试可能需要很长时间运行——验收测试套件顺序运行超过一天的情况并不罕见。

这三组测试结合起来,应该能够提供极高的信心,确保任何引入的变更都没有破坏现有功能。

如果编译代码和运行单元测试花费的时间太长,你会遇到以下问题:

• 人们在签入代码前将不再进行完整构建和运行测试。你会开始遇到更多构建失败的情况。

• 持续集成过程将花费很长时间,以至于在你再次运行构建之前,已经发生了多次提交,因此你无法知道是哪次签入破坏了构建。

• 人们会减少签入频率,因为他们必须等待很长时间来编译软件和运行测试。

理想情况下,你在签入前和在CI服务器上运行的编译和测试过程应该只需要几分钟。我们认为十分钟是极限,五分钟更好,大约九十秒是理想的。对于习惯于小型项目的人来说,十分钟似乎很长。对于经历过长达一小时编译的老手来说,这似乎是非常短的时间。这大约是你可以用来泡杯茶、快速聊天、查看电子邮件或伸展肌肉的时间。

这个要求似乎与前一个要求——拥有全面的自动化测试集——相矛盾。但是你可以使用许多技术来缩短构建时间。首先要考虑的是让测试运行得更快。XUnit类型的工具,如JUnit和NUnit,在输出中提供了每个测试所花费时间的详细信息。找出运行缓慢的测试,看看是否有办法优化它们,或者用更少的处理获得同样的覆盖率和对代码的信心。这是你应该定期执行的实践。

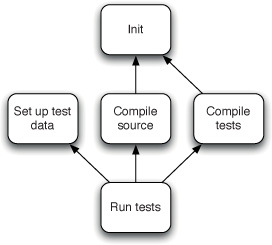

但是,在某个时候你需要将测试过程分成多个阶段,如第5章”部署流水线剖析”中详细描述的那样。如何拆分它们?你的第一个行动应该是创建两个阶段。一个阶段应该编译软件,运行测试组成应用程序的各个类的单元测试套件,并创建可部署的二进制文件。这个阶段称为提交阶段。我们在第7章中详细介绍了构建的这个阶段。

第二阶段应该从第一阶段获取二进制文件并运行验收测试,以及集成测试,如果有的话还包括性能测试。现代CI服务器可以轻松地以这种方式创建分阶段构建,并发运行多个任务,并汇总结果,以便你可以一目了然地看到构建的状态。

提交阶段应该在签入前运行,并且应该在CI服务器上为每次签入运行。运行验收测试的阶段应该在签入测试套件通过后运行,但可以花费更长的时间。如果你发现第二次构建花费的时间超过半小时左右,你应该考虑在更大的多处理器机器上并行运行这个测试套件,或者建立一个构建网格。现代CI系统使这变得简单。将一个简单的冒烟测试套件纳入提交阶段通常很有用。这个冒烟测试应该执行一些简单的验收和集成测试,以确保最常用的功能没有被破坏——如果有问题则快速报告。

通常需要将验收测试按功能区域分组。这允许你在该区域进行更改后运行关注系统行为特定方面的测试集合。许多单元测试框架允许你以这种方式对测试进行分类。

你可能会达到这样一个阶段:你的项目需要被拆分成几个模块,每个模块在功能上都是独立的。这需要你仔细考虑如何在版本控制和CI服务器上组织这些子项目。我们将在第13章”管理组件和依赖项”中更详细地讨论这个问题。

对开发者的生产力和理智来说,仔细管理他们的开发环境至关重要。开发者在开始一项新工作时,应该始终从一个已知良好的起点开始。他们应该能够运行构建、执行自动化测试,并在自己控制的环境中部署应用程序。通常情况下,这应该是在他们自己的本地机器上。只有在特殊情况下,才应该使用共享环境进行开发。在本地开发环境中运行应用程序应该使用与持续集成和测试环境中相同的自动化流程,最终也与生产环境中使用的流程相同。

实现这一目标的第一个先决条件是仔细的配置管理,不仅仅是源代码,还包括测试数据、数据库脚本、构建脚本和部署脚本。所有这些都必须存储在版本控制中,并且这些内容的最新已知良好版本应该是编码开始时的起点。在这个语境中,“已知良好”意味着你正在使用的修订版本已经通过了持续集成服务器上的所有自动化测试。

第二步是对第三方依赖项、库和组件进行配置管理。至关重要的是,你拥有所有库或组件的正确版本,这意味着与你正在使用的源代码版本已知可以配合工作的相同版本。有开源工具可以帮助管理第三方依赖项,Maven和Ivy是最常见的。然而,在使用这些工具时,你需要小心确保它们配置正确,这样你就不会总是在本地工作副本中获得某些依赖项的最新可用版本。

对于大多数项目来说,它们所依赖的第三方库不会频繁更改,因此最简单的解决方案是将这些库与源代码一起提交到版本控制系统中。关于这些的更多信息请参见[第13章]“管理组件和依赖项”。

最后一步是确保自动化测试,包括冒烟测试(smoke tests),可以在开发者机器上运行。在大型系统上,这可能涉及配置中间件系统并运行内存数据库或单用户版本的数据库。这可能需要一定程度的努力,但使开发者能够在每次检入之前在开发者机器上对工作系统运行冒烟测试,可以极大地提高应用程序的质量。事实上,良好应用程序架构的一个标志是它允许应用程序在开发机器上轻松运行。

市场上有许多产品可以为你的自动化构建和测试流程提供基础设施。持续集成软件的最基本功能是轮询你的版本控制系统以查看是否发生了任何提交,如果有,则检出软件的最新版本,运行构建脚本来编译软件,运行测试,然后通知你结果。

本质上,持续集成服务器软件有两个组件。第一个是一个长期运行的进程,可以定期执行一个简单的工作流。第二个提供已运行进程结果的视图,通知你构建和测试运行的成功或失败,并提供对测试报告、安装程序等的访问。

通常的CI工作流会定期轮询你的版本控制系统。如果检测到任何更改,它将把项目的副本检出到服务器上的目录,或构建代理(build agent)上的目录。然后它将执行你指定的命令。通常,这些命令会构建你的应用程序并运行相关的自动化测试。

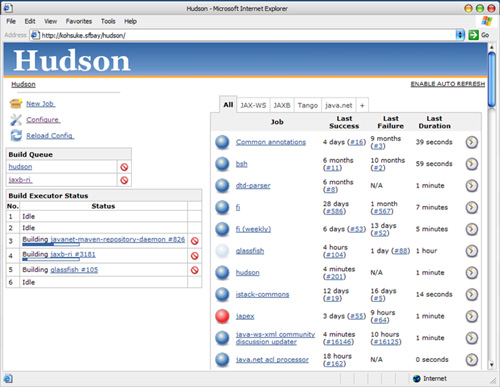

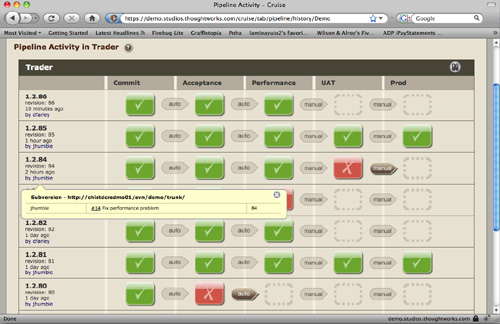

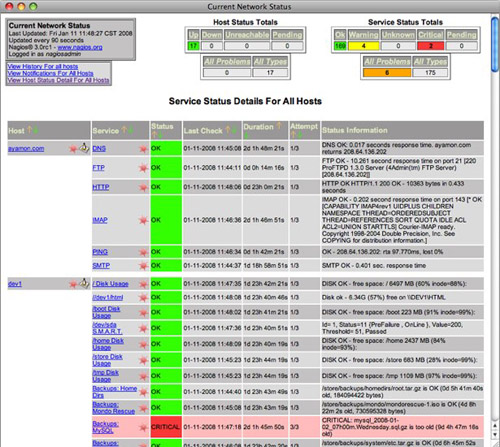

大多数CI服务器包含一个web服务器,向你显示已运行的构建列表([图3.1]),并允许你查看定义每个构建成功或失败的报告。这一系列构建指令应该以生成和存储结果产物(如二进制文件或安装包)而告终,以便测试人员和客户可以轻松下载软件的最新良好版本。大多数CI服务器可以通过web界面或简单脚本进行配置。

你可以使用CI包的工作流功能来做很多超出基本功能的其他事情。例如,你可以将最近构建的状态发送到外部设备。我们见过有人使用红色和绿色的熔岩灯来显示最后一次构建的状态,或者将状态发送到Nabaztag无线电子兔的CI系统。我们认识的一位在电子技术方面有一定技能的开发者,创建了一座华丽的闪光灯和警报器塔,它会爆发出行动来指示复杂项目上各种构建的进度。另一个技巧是使用文本转语音(text-to-speech)来读出破坏构建的人的名字。一些持续集成服务器可以显示构建状态,以及检入人员的头像——这可以显示在大屏幕上。

项目使用这些小工具的原因很简单:它们是让每个人一目了然地看到构建状态的绝佳方式。可见性是使用 CI 服务器最重要的好处之一。大多数 CI 服务器软件都附带一个小部件,你可以将其安装在开发机器上,在桌面的角落显示构建状态。这类工具对于分布式团队,或者至少不在同一房间工作的团队特别有用。

这种可见性的唯一缺点是,如果你的开发团队与客户紧密协作,就像大多数敏捷项目应该做的那样,构建失败——这是过程中很自然的一部分——可能会被视为应用程序质量有问题的标志。事实上,情况恰恰相反:每次构建失败,都表明发现了一个可能在生产环境中出现的问题。然而,这有时很难解释。经历过多次这种情况,包括在构建中断的时间比我们任何人希望的都长时与客户进行一些艰难的对话,我们只能建议你保持高可见性的构建监视器,并努力解释其真正的好处。当然,最好的答案是努力保持构建绿色。

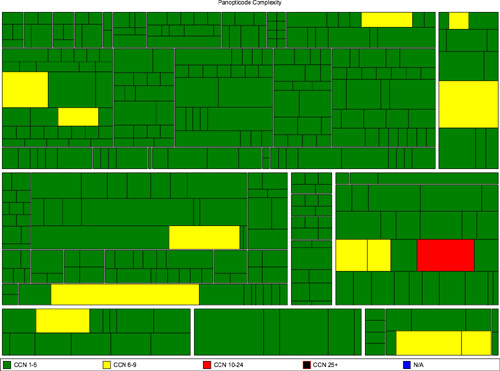

你还可以让构建过程对源代码进行分析。团队通常会确定测试覆盖率、代码重复、遵守编码标准、圈复杂度(cyclomatic complexity)和其他健康指标,并在每次构建的摘要页面上显示结果。你还可以运行程序来生成对象模型或数据库模式的图表。这都是关于可见性的。

如今先进的 CI 服务器可以在构建网格中分配工作,管理协作组件集合的构建和依赖关系,直接报告到你的项目管理跟踪系统,以及做很多其他有用的事情。

在持续集成引入之前,许多开发团队使用每夜构建。这在微软是多年的常见做法。任何破坏构建的人都需要留下来监视后续构建,直到下一个人导致破坏。

许多项目仍然有每夜构建。这个想法是,当每个人下班回家时,批处理过程会在每晚编译和集成代码库。这是朝着正确方向迈出的一步,但当团队第二天早上到达时却发现代码没有编译,这并不是很有帮助。第二天他们进行新的更改——但无法验证系统是否集成,直到第二天晚上。所以构建会持续红色好几天——直到,你猜对了,集成时间再次到来。此外,当你有一个地理分散的团队从不同时区工作在一个共同的代码库时,这种策略就不太有用了。

下一个演进步骤是添加自动化测试。我们第一次尝试这个是很多年前。当时的测试是最基本的冒烟测试(smoke test),只是断言应用程序在编译后能够运行。这在当时是我们构建过程中的一大步,我们对自己非常满意。如今,即使是最基本的自动化构建,我们也期望更多。单元测试已经走了很长的路,即使是简单的单元测试套件也能为最终构建提供显著提高的信心水平。

下一个复杂度级别在一些项目中使用(尽管我们承认最近没有见过),是一个”滚动构建”过程,其中构建不是在夜间运行的计划批处理过程,而是持续运行。每次构建完成后,就从版本控制中收集最新版本,然后重新开始整个过程。Dave 在 1990 年代初期很好地使用了这个方法;它比夜间构建好得多。这种方法的问题是,特定的检入和构建之间没有直接联系。所以,虽然为开发人员提供了有用的反馈循环,但它没有提供足够的可追溯性来追溯到破坏构建的原因,无法真正扩展到更大的团队。

到目前为止,我们描述的大部分内容都与构建和部署的自动化有关。然而,这种自动化存在于人类过程的环境中。持续集成是一种实践,而不是工具,它依赖于纪律来使其有效。保持持续集成系统运行,特别是在处理大型和复杂的 CI 系统时,需要整个开发团队有相当程度的纪律。

我们 CI 系统的目标是确保我们的软件在本质上一直处于工作状态。为了确保这一点,以下是我们在团队中执行的实践。稍后我们将讨论可选但理想的实践,但这里列出的是持续集成工作所必需的。

持续集成的致命错误是在构建失败时仍然提交代码。如果构建失败,负责的开发人员应该等待并修复它。他们应该尽快找出失败的原因并进行修复。如果我们采用这个策略,我们将始终处于最佳位置来找出导致失败的原因并立即修复它。如果我们的同事提交了代码并导致构建失败,为了有最好的机会修复它,他们需要专注于这个问题。他们不希望我们提交更多的更改,触发新的构建,并让更多的问题使失败更加复杂。

当这条规则被打破时,修复构建不可避免地需要更长的时间。人们会习惯看到构建失败,很快你就会陷入构建一直处于失败状态的局面。这种情况会持续到团队中有人决定受够了,付出巨大的努力让构建变绿,然后整个过程重新开始。就在这项工作完成后,这是一个很好的时机,让大家聚在一起提醒他们,遵循这个原则将确保构建保持绿色状态,从而始终拥有可工作的软件。

正如我们已经确定的,一次提交会触发创建一个候选发布版本。这是一种发布形式。大多数人在以任何形式发布他们的工作之前都会检查他们的工作,提交代码也不例外。

我们希望提交足够轻量,这样我们可以很乐意每二十分钟左右定期提交一次,但也要足够正式,这样我们在提交之前会短暂地思考一下。在本地运行提交测试是提交前的合理性检查。这也是一种确保我们认为可以工作的东西确实可以工作的方法。

当开发人员完成工作并准备提交时,他们应该从版本控制系统更新来刷新本地项目副本。然后他们应该启动本地构建并运行提交测试。只有当这成功时,开发人员才准备好将更改提交到版本控制系统。

如果你以前没有遇到过这种方法,你可能会想知道为什么我们在提交前在本地运行提交测试,如果提交后第一件事就是代码将被编译并重新运行提交测试。这种方法有两个原因:

在你上次从版本控制更新后,其他人可能已经提交了代码,你的新更改和他们的更改组合可能会导致测试失败。如果你检出代码并在本地运行提交测试,你将在不破坏构建的情况下发现这个问题。

提交时常见的错误来源是忘记将一些新的文件添加到仓库中。如果你遵循这个过程,你的本地构建通过了,然后你的CI管理系统在提交阶段失败了,你就知道要么是因为在此期间有人提交了代码,要么是因为你忘记将刚刚处理的新类或配置文件添加到版本控制系统中。

遵循这个实践可以确保构建保持绿色状态。

许多现代CI服务器提供一个被称为预测试提交(pretested commit)、个人构建(personal build)或预检构建(preflight build)的功能。使用这个功能,你的CI服务器将获取你的本地更改并在CI网格上使用它们运行构建,而不是你自己提交。如果构建通过,CI服务器将为你提交更改。如果构建失败,它会让你知道出了什么问题。这是一个很好的方式来遵循这个实践,而不必等到提交测试通过后才开始处理下一个功能或错误修复。

在撰写本文时,CI服务器Pulse、TeamCity和ElectricCommander都提供此功能。这个实践最好与分布式版本控制系统结合使用,它允许你在本地存储提交而不将它们推送到中央服务器。这样,如果你的个人构建失败,通过创建补丁来搁置你的更改并回滚到你发送给CI服务器的代码版本就非常容易。

CI系统是团队的共享资源。当团队有效地使用CI,遵循我们的建议并频繁提交时,构建的任何失败对团队和整个项目来说都是一个小的绊脚石。

然而,构建失败是过程中正常和预期的一部分。我们的目标是尽快发现错误并消除它们,而不期望完美和零错误。

在提交时,进行提交的开发人员负责监控构建的进度。在他们的提交编译完成并通过提交测试之前,开发人员不应该开始任何新任务。他们不应该出去吃午饭或开始开会。他们应该足够关注构建,以便在提交阶段完成后几秒钟内知道其结果。

如果提交成功,开发人员才可以继续他们的下一个任务。如果失败,他们应该立即开始确定问题的性质并修复它—通过另一次提交或回滚到版本控制中的先前版本,也就是说,撤销他们的更改,直到他们了解如何使它们工作。

现在是周五下午5点30分。你的所有同事都走出了办公室,而你刚刚提交了你的变更。构建失败了。你有三个选择。你可以接受自己将会晚走的事实,并尝试修复它。你可以回滚你的变更,下周再尝试签入。或者你现在就离开,让构建保持失败状态。

如果你让构建保持失败状态,当你周一返回时,你对所做变更的记忆将不再清晰,理解问题并修复它将花费你更长的时间。如果你不是周一早上第一个回来修复构建的人,当团队其他成员到达时发现构建失败且他们的工作能力受到影响,你的名声将会很糟糕。如果你周末生病了,第二天无法上班,那么要么会接到几个电话询问你如何搞砸构建以及如何修复它,要么你的修订版本会被某位同事毫不客气地丢弃。不管怎样,你的名声都会很糟糕。

构建失败的影响,特别是在一天工作结束时留下失败构建的影响,如果你在一个分布式开发团队中工作,团队成员分布在不同时区,这种影响会被放大。在这种情况下,在构建失败时回家可能是疏远远程同事的最有效方式之一。

为了绝对明确,我们不建议你在工作时间之后加班修复构建。相反,我们建议你定期签入,并且足够早地签入以便有时间处理可能出现的问题。或者,将签入留到第二天;许多有经验的开发者特意不在下班前一小时内签入,而是留到第二天早上第一件事做。如果所有方法都失败了,只需从源代码控制中回滚你的变更,将其保留在本地工作副本中。一些版本控制系统,包括所有分布式系统,通过允许你在本地仓库中累积签入而不将其推送给其他用户,使这变得更容易。

你的作者曾经参与过一个我们认为在当时是世界上最大的敏捷项目。这是一个地理分布式项目,共享一个代码库。整个团队在项目生命周期的不同时期,同时在美国的旧金山和芝加哥、英国的伦敦以及印度的班加罗尔工作。在任何给定的24小时内,只有大约3个小时世界上某个地方没有人在处理代码。在剩余时间里,有源源不断的变更提交到版本控制系统,并有源源不断的新构建被触发。

如果印度团队破坏了构建并回家了,伦敦团队的一天工作可能会受到严重影响。同样,如果伦敦团队在构建失败时回家了,他们在美国的同事将在接下来的八小时里暗自咒骂。

严格的构建纪律至关重要,以至于我们有一名专职的构建管理员(build master),他不仅维护构建,有时还监督构建,确保破坏构建的人正在努力修复它。如果没有,构建工程师会回滚他们的签入。

如前所述,虽然我们努力保持勤勉,但我们都会犯错,所以我们预期每个人都会不时地破坏构建。在大型项目上,这通常是每天都会发生的事情,尽管预测试提交(pretested commits)会大大缓解这一问题。在这些情况下,修复通常是我们会立即识别并通过提交一个小的单行变更来修复的简单事情。然而,有时我们会犯更严重的错误,要么找不到问题所在,要么在签入失败后才意识到我们遗漏了刚做的变更的一些重要内容。

无论我们对失败的提交阶段有何反应,重要的是我们要快速让一切恢复正常。如果我们不能快速修复问题,无论出于什么原因,我们都应该回滚到修订控制中保存的之前的变更集,并在本地环境中修复问题。毕竟,我们首先需要修订控制系统的原因之一,就是允许我们精确地拥有这种回滚的自由。

飞行员被教导,每次着陆时都应该假设会出现问题,所以应该准备好中止着陆尝试并”复飞”进行另一次尝试。签入时使用同样的思维方式。假设你可能会破坏某些需要超过几分钟才能解决的东西,并知道如何回滚变更并返回到版本控制中已知良好的修订版本。你知道之前的修订版本是良好的,因为你不在构建失败时签入。

经验丰富的开发人员通常会执行这条规则,愉快地回退其他人中断了十分钟或更长时间的构建。

一旦你开始执行前面的规则,结果往往是开发人员为了签入他们的更改而注释掉失败的测试。这种冲动可以理解,但是错误的。当一直通过的测试开始失败时,可能很难找出原因。真的发现了回归问题吗?也许测试的某个假设不再有效,或者应用程序确实出于正当理由改变了被测试的功能。弄清楚适用哪种情况可能需要与很多人交谈并花费时间,但必须投入精力找出发生了什么,然后要么修复代码(如果发现了回归问题),要么修改测试(如果某个假设已经改变),要么删除它(如果被测试的功能不再存在)。

注释掉失败的测试应该始终是最后的手段,很少且不情愿地使用,除非你有足够的纪律立即修复它。偶尔注释掉一个测试等待一些需要安排的严肃开发工作或与客户的长期讨论是可以的。然而,这可能会让你走下坡路。我们见过一半测试都被注释掉的代码。建议跟踪被注释测试的数量,并将其显示在一个大的、可见的图表或屏幕上。如果被注释测试的数量超过某个阈值(也许是总数的2%),你甚至可以让构建失败。

如果你提交了一个更改,你编写的所有测试都通过了,但其他测试中断了,构建仍然是中断的。通常这意味着你在应用程序中引入了回归bug。因为是你做了更改,所以你有责任修复因你的更改而未通过的所有测试。在持续集成的背景下,这似乎很明显,但实际上在许多项目中并不是常见做法。

这种做法有几个含义。这意味着你需要访问任何可能因你的更改而中断的代码,以便在它中断时可以修复它。这意味着你不能让开发人员拥有只有他们才能处理的代码子集。为了有效地进行持续集成,每个人都需要访问整个代码库。如果出于某些原因,你被迫进入无法与整个团队共享代码访问权限的情况,你可以通过与拥有必要访问权限的人进行良好协作来管理。然而,这是次优选择,你应该努力消除这些限制。

拥有全面的测试套件对持续集成至关重要。虽然我们在下一章中详细讨论了自动化测试的策略,但值得强调的是,快速反馈(这是持续集成的核心成果)只有通过出色的单元测试覆盖率才能实现(出色的验收测试覆盖率也很重要,但这些测试运行时间更长)。根据我们的经验,获得出色单元测试覆盖率的唯一方法是通过测试驱动开发。虽然我们试图避免在本书中对敏捷开发实践持教条态度,但我们认为测试驱动开发对于实现持续交付的实践至关重要。

对于不熟悉测试驱动开发的人来说,其理念是在开发新功能或修复bug时,开发人员首先创建一个测试,该测试是对将要编写的代码的预期行为的可执行规范。这些测试不仅驱动应用程序的设计,还可以作为回归测试以及代码和应用程序预期行为的文档。

关于测试驱动开发的讨论超出了本书的范围。然而,值得注意的是,与所有此类实践一样,对测试驱动开发既要有纪律又要务实是很重要的。我们有两本书推荐进一步阅读这个主题:Steve Freeman和Nat Pryce的《测试驱动的面向对象软件开发》(Growing Object-Oriented Software, Guided by Tests),以及Gerard Meszaros的《xUnit测试模式:重构测试代码》(xUnit Test Patterns: Refactoring Test Code)。

以下实践不是必需的,但我们发现它们很有用,你至少应该考虑在项目中使用它们。

持续集成是Kent Beck书中描述的十二个核心XP实践之一,它与其他XP实践相辅相成。即使团队没有使用其他任何实践,持续集成也能带来巨大改变,但与其他实践结合使用会更加有效。特别是,除了我们在前一节中描述的测试驱动开发和共享代码所有权之外,你还应该将重构视为有效软件开发的基石。

重构意味着进行一系列小的、增量的更改来改进代码,而不改变应用程序的行为。CI和测试驱动开发通过确保你的更改不会改变应用程序的现有行为来支持重构。因此,团队可以自由地进行可能涉及大范围代码的更改,而不用担心会破坏应用程序。这种实践还支持频繁签入——开发人员在每次小的增量更改后就进行签入。

有时系统架构的某些方面很容易被开发人员忽略。我们使用过的一种技术是放置一些提交时测试来证明没有违反这些规则。

这种技术实际上只是一种战术性的方法,除了通过示例之外很难描述。

我们能回忆起的最佳示例来自一个作为分布式服务集合实现的项目。这是一个真正的分布式系统,因为它在客户端系统中执行重要的业务逻辑,在服务器端也执行真正的业务逻辑——这是因为真实的业务需求,而不仅仅是糟糕的编程。

我们的开发团队在开发环境中部署了客户端系统和服务器系统的所有代码。开发人员很容易从客户端向服务器或从服务器向客户端进行本地调用,而没有意识到如果他们真的想要这种行为,就必须进行远程调用。

我们将代码组织成代表分层策略的包来帮助部署。我们使用这些信息和一些开源软件来评估代码依赖关系,并使用grep搜索依赖工具的输出,查看包之间是否存在违反我们规则的依赖关系。

这防止了在功能测试时出现不必要的破坏,并帮助强化了系统架构——提醒开发人员注意两个系统之间进程边界的重要性。

这种技术可能看起来有点重量级,并不能替代开发团队对正在开发的系统架构的清晰理解。然而,当有重要的架构问题需要维护时——那些可能很难及早发现的问题——它会非常有用。

正如我们之前所说,CI在小的、频繁的提交下工作得最好。如果提交测试需要很长时间才能运行,由于等待构建和测试过程完成所花费的时间,可能会对团队的生产力产生严重的不利影响。这反过来会阻碍频繁签入,因此团队会开始积累签入,使每次签入变得更加复杂——更有可能出现合并冲突,更有可能引入错误,从而导致测试失败。所有这些都会进一步减慢一切。

为了让开发团队专注于保持测试快速的重要性,如果发现某个测试的运行时间超过某个指定时间,你可以使提交测试失败。上次我们使用这种方法时,对于任何运行时间超过两秒的测试,我们都会使构建失败。

我们倾向于喜欢小改变能产生更广泛影响的实践。这就是这样一种实践。如果开发人员编写的提交测试运行时间过长,当他们准备提交更改时构建就会失败。这鼓励他们仔细考虑使测试快速运行的策略。如果测试运行得很快,开发人员会更频繁地签入。如果开发人员更频繁地签入,合并问题的可能性就更小,即使出现问题也可能很小且易于解决,因此开发人员的生产力更高。

不过有一个警告:这种实践可能有点像双刃剑。你需要警惕创建不稳定的间歇性测试,如果你的CI环境由于某种原因处于异常负载下,这些测试就会失败。我们发现使用这种方法最有效的方式是作为让大型团队专注于特定问题的策略,而不是在每次构建中都采用。如果你的构建变慢了,你可以使用这种方法让团队在一段时间内专注于加快速度。

请注意:我们在这里讨论的是测试性能,而不是性能测试。容量测试在第9章”测试非功能性需求”中介绍。

编译器警告通常是有充分理由的。我们采用的一个颇为成功的策略(尽管开发团队常称其为”代码纳粹”)是在出现警告时使构建失败。这在某些情况下可能有点严苛,但作为一种强制执行良好实践的方式,它是有效的。

你可以根据需要强化这种技术,添加对特定或一般性编码疏漏的检查。我们已经成功使用了几个开源代码质量工具:

• Simian 是一个识别大多数流行语言(包括纯文本)重复代码的工具。

• JDepend 用于 Java,它的商业版 .NET 表亲 NDepend,能生成大量有用的(也有一些不太有用的)设计质量度量指标。

• CheckStyle 可以测试不良编码实践,如工具类中的公共构造函数、嵌套块和过长的代码行。它还能捕获常见的错误源和安全漏洞。它很容易扩展。FxCop 是其 .NET 表亲。

• FindBugs 是一个基于 Java 的系统,提供 CheckStyle 的替代方案,包括一套类似的验证规则。

如前所述,对某些项目来说,在任何警告出现时就让构建失败可能听起来太严苛了。我们用来逐步引入这一实践的一种方法是棘轮机制(ratcheting)。这意味着将警告或 TODO 的数量与上一次提交的数量进行比较。如果数量增加,我们就让构建失败。使用这种方法,你可以轻松强制执行一项策略:每次提交至少应将警告或 TODO 的数量减少一个。

在我们的一个项目中,我们将 CheckStyle 测试添加到提交测试集合中,结果我们都对它的过度唠叨感到有点厌烦。我们是一个经验丰富的开发团队,大家都认为忍受一段时间的唠叨是值得的,这能让我们养成良好习惯,为项目打下良好基础。

运行几周后,我们移除了 CheckStyle 测试。这加快了构建速度,也摆脱了唠叨。然后团队规模扩大了一些,几周后我们开始在代码中发现更多”代码坏味道”(smells),发现自己花在简单清理重构上的时间比以前多了。

最终我们意识到,尽管有代价,CheckStyle 帮助我们的团队掌控那些几乎微不足道的事情,而这些事情累积起来就是高质量代码和普通代码之间的差别。我们重新启用了 CheckStyle,不得不花时间纠正它提出的所有小问题,但这是值得的,至少对那个项目来说,我们学会了不再抱怨那种被唠叨的感觉。

在分布式团队中使用持续集成,从流程和技术角度来看,与其他环境基本相同。然而,团队成员不在同一个房间里工作(甚至可能在不同时区工作)这一事实确实会在其他一些方面产生影响。

从技术角度看最简单、从流程角度看最有效的方法是保留一个共享的版本控制系统和持续集成系统。如果你的项目使用后续章节描述的部署流水线(deployment pipelines),这些也应该简单地平等地提供给团队所有成员。

当我们说这种方法最有效时,应该强调它确实有效得多。值得努力实现这一理想状态;这里描述的所有其他方法都明显次于这种方法。

对于同一时区的分布式团队,持续集成基本相同。当然你不能使用物理签入令牌(check-in tokens)——尽管一些 CI 服务器支持虚拟令牌——而且稍微缺乏人情味,所以当你提醒某人修复构建时更容易冒犯对方。个人构建(personal builds)等功能变得更有用。但总体而言,流程是相同的。

对于不同时区的分布式团队,需要处理的问题更多。如果旧金山团队破坏了构建并下班回家,这对刚开始工作的北京团队来说可能是一个严重障碍。流程不会改变,但遵守流程的重要性被放大了。

在拥有分布式团队的大型项目中,VoIP(如 Skype)和即时消息等工具对于实现保持平稳运行所需的细粒度沟通至关重要。与开发相关的每个人——项目经理、分析师、开发人员、测试人员——都应该能够通过 IM 和 VoIP 访问并被访问到所有其他人。定期让人员来回飞行对于交付流程的顺畅运行至关重要,这样每个本地团队都能与其他团队的成员有个人接触。这对于在团队成员之间建立信任很重要——这往往是分布式团队中最先受损的东西。可以使用视频会议进行回顾会议、展示会、站会和其他定期会议。另一个很好的技巧是让每个开发团队使用屏幕录制软件录制一段简短视频,讲述他们当天所做的功能。

自然,这是一个比持续集成更广泛的话题。我们想表达的观点很简单:保持流程不变,但在应用时要更加自律。

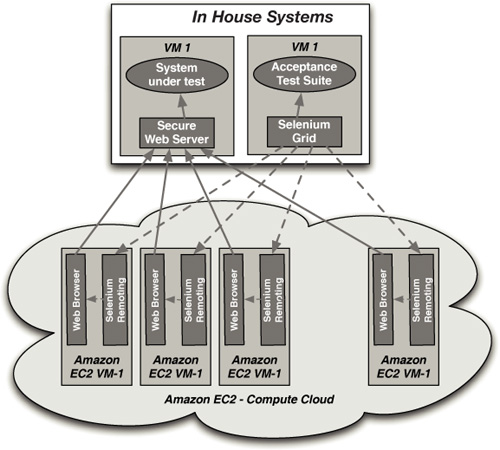

一些更强大的持续集成服务器提供了集中管理的构建农场(build farms)和复杂的授权方案等功能,允许你为大型分布式团队提供集中式持续集成服务。这些系统使团队能够轻松自助获取持续集成服务,而无需获得自己的硬件。它们还允许运维团队整合服务器资源,控制持续集成和测试环境的配置以确保它们都保持一致并与生产环境相似,并强制执行良好实践,例如管理第三方库的配置和提供预装工具来收集代码覆盖率和质量的一致性指标。最后,它们允许跨项目收集和监控标准指标,为管理者和交付团队提供创建仪表板的能力,以在项目层面监控代码质量。

虚拟化也可以与集中式CI服务很好地配合使用,提供按下按钮就能从存储的基线镜像启动新虚拟机的能力。你可以使用虚拟化使配置新环境成为完全自动化的过程,交付团队可以自助完成。它还确保构建和部署始终在这些环境的一致基线版本上运行。这带来了一个好的效果,即消除了那些”艺术品”般的持续集成环境——它们经过数月积累了软件、库和配置设置,与测试和生产环境中的内容毫无关系。

集中式持续集成可以是一个双赢的局面。然而,为了实现这一点,开发团队必须能够以自动化的方式轻松自助获取新环境、配置、构建和部署,这一点至关重要。如果一个团队必须发送几封电子邮件并等待数天才能为他们的最新发布分支获得一个新的CI环境,他们将绕过这个流程,回到使用桌子下的备用机器来进行真正的持续集成——或者更糟的是,根本不做持续集成。

根据版本控制系统的选择,对于全球分布式团队来说,当团队之间存在缓慢链接时,共享版本控制系统以及构建和测试资源的访问可能会相当痛苦。

当持续集成运行良好时,整个团队会定期提交更改。这意味着与版本控制系统的交互往往保持在相当高的水平。尽管每次交互在交换的字节数方面通常相对较小,但由于提交和更新的频率,糟糕的通信会严重拖累生产力。值得投资在开发中心之间建立足够高带宽的通信。也值得考虑迁移到分布式版本控制系统,如Git或Mercurial,它们允许人们即使在没有连接到传统指定的”主”服务器时也能进行检入。

几年前,我们在一个项目中遇到过这个问题。到我们在印度的同事那里的通信基础设施如此缓慢且不可靠,以至于有些天他们根本无法检入,这会在之后的几天产生连锁反应。最终,我们对损失时间的成本进行了分析,发现升级通信的成本可以在几天内收回。在另一个项目中,根本不可能获得足够快速和可靠的连接。团队从使用集中式VCS的Subversion迁移到分布式VCS的Mercurial,生产力有了明显提升。

版本控制系统应该与托管运行自动化测试的构建基础设施相当接近,这是合理的。如果这些测试在每次检入后都运行,这意味着系统之间跨网络会有相当多的交互。

托管版本控制系统、持续集成系统以及部署流水线中各种测试环境的物理机器需要能够从每个开发站点平等访问。如果印度的版本控制系统因为磁盘已满而停止工作,印度办公室的所有人都已下班回家,而伦敦的开发团队无法访问系统,他们将处于相当不利的地位。应从每个位置提供对所有这些系统的系统管理员级别访问。确保每个站点的团队不仅有访问权限,而且具备管理其班次期间可能发生的任何问题的知识。

如果存在一些无法克服的问题,阻止你花费更多资金在开发中心之间建立更高带宽的通信,那么可以使用本地持续集成和测试系统,甚至在极端情况下使用本地版本控制系统。正如你所料,我们真的不建议采用这种方法。尽一切努力避免它;它在时间和精力方面成本高昂,而且效果远不如共享访问。

简单的部分是持续集成系统。完全可以拥有本地持续集成服务器和测试环境,甚至是功能完整的本地部署流水线(deployment pipeline)。当站点需要进行大量手动测试时,这可能很有价值。当然,这些环境需要仔细管理以确保跨区域的一致性。唯一需要注意的是,理想情况下,二进制文件或安装程序应该只构建一次,然后分发到所有需要它们的全球位置。然而,由于大多数安装程序的体积庞大,这通常不切实际。如果必须在本地构建二进制文件或安装程序,就更需要严格管理工具链(toolchain)的配置,以确保在各处创建完全相同的二进制文件。强制执行此操作的一种方法是使用md5或类似算法自动生成二进制文件的哈希值,并让CI服务器自动将它们与”主”二进制文件的哈希值进行比较,以确保没有差异。

在某些极端情况下,例如版本控制系统是远程的并通过慢速或不可靠的链接连接,在本地托管持续集成系统的价值会受到严重影响。我们在使用持续集成时经常提到的目标是能够在最早的时机发现问题。如果版本控制系统以任何方式分离,我们就会削弱这种能力。在被迫这样做的情况下,我们分离版本控制系统的目标必须是尽量减少从引入错误到我们能够发现它之间的时间。

主要有两种选择可以为分布式团队提供版本控制系统的本地访问:将应用程序划分为组件以及使用分布式或支持多主拓扑的版本控制系统。

在基于组件的方法中,版本控制仓库和团队都按组件或功能边界进行划分。第13章”管理组件和依赖关系”中更详细地讨论了这种方法。

我们看到的另一种技术是拥有团队本地仓库和构建系统,以及一个共享的全局主仓库。按功能分离的团队在整个工作日中提交到他们的本地仓库。每天在固定时间,通常是在另一个时区的分布式团队结束一天的工作后,本地团队的一名成员负责提交整个团队的所有更改,并承担合并大量更改的痛苦。显然,如果使用专门为此类任务设计的分布式版本控制系统,这会容易得多。然而,这个解决方案绝非理想,我们已经看到它因引入重大合并冲突而惨败。

总之,我们在本书中描述的所有技术都已在许多项目的分布式团队中得到充分验证。事实上,我们将CI的使用视为地理分布团队有效协作能力的两三个最重要因素之一。持续集成的持续性很重要;如果确实没有其他选择,有一些变通方法,但我们的建议是将钱花在通信带宽上——从中长期来看,这样更便宜。

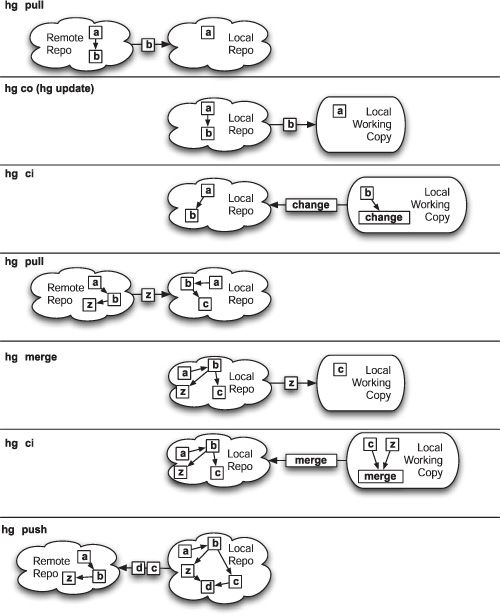

分布式版本控制系统(DVCS)的兴起正在彻底改变团队协作的方式。开源项目曾经通过电子邮件发送补丁或在论坛上发布它们,而Git和Mercurial等工具使开发人员和团队之间来回拉取补丁以及分支和合并工作流变得非常容易。DVCS允许您轻松离线工作,在本地提交更改,并在将它们推送给其他用户之前进行变基(rebase)或搁置(shelve)。DVCS的核心特征是每个仓库都包含项目的完整历史记录,这意味着除了按约定外,没有任何仓库具有特权。因此,与集中式系统相比,DVCS具有额外的间接层:对本地工作副本的更改必须先检入本地仓库,然后才能推送到其他仓库,并且来自其他仓库的更新必须与本地仓库协调,然后才能更新工作副本。

DVCS提供了新的强大协作方式。例如,GitHub开创了开源项目协作的新模式。在传统模式中,提交者(committer)充当项目权威仓库的守门人,接受或拒绝贡献者的补丁。项目的分叉(fork)只在提交者之间存在不可调和的争论时才会发生这种极端情况。在GitHub模式中,这被颠倒了。贡献是通过首先分叉您希望贡献的项目仓库,进行更改,然后请求原始仓库的所有者拉取您的更改来完成的。在活跃的项目中,分叉网络迅速激增,每个分叉都有各种新功能集。偶尔这些分叉会出现分歧。这种模式比传统模式更具活力,在传统模式中,补丁被忽视,在邮件列表存档中无人问津。因此,GitHub上的开发速度往往更快,拥有更大的贡献者群体。

然而,这种模式挑战了持续集成实践的一个基本假设:存在一个单一的、权威的代码版本(通常称为主线或主干),所有变更都提交到这个版本。需要指出的是,你完全可以使用版本控制的主线模型,并使用分布式版本控制系统(DVCS)完美地进行持续集成。你只需指定一个仓库作为主仓库,让你的持续集成服务器在该仓库发生变更时触发构建,并让每个人都将变更推送到这个仓库以共享它们。这是一种完全合理的方法,我们在许多项目中都看到过成功的应用。它保留了分布式版本控制系统的许多优势,例如能够非常频繁地提交变更而不共享它们(就像保存游戏进度),这在探索新想法或执行一系列复杂重构时非常有用。然而,分布式版本控制系统的某些使用模式会阻碍持续集成。例如,GitHub模式违反了代码共享的主线/主干模型,因此无法实现真正的持续集成。

在GitHub中,每个用户的变更集存在于单独的仓库中,并且没有简单的方法来确定哪些用户的哪些变更集能够成功集成。你可以采用创建一个仓库来监视所有其他仓库的方法,并在检测到任何仓库发生变更时尝试将它们全部合并在一起。然而,这几乎总是会在合并阶段失败,更不用说运行自动化测试了。随着贡献者数量以及仓库数量的增长,问题会呈指数级恶化。没有人会关注持续集成服务器的反馈,因此持续集成作为传达应用程序当前是否正常工作(如果不正常,是谁和什么导致的)的方法就失效了。

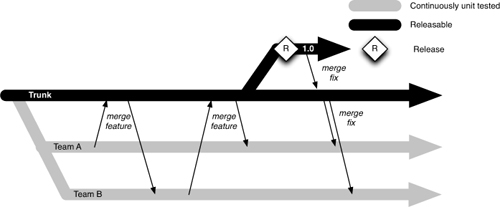

图3.2 集成分支

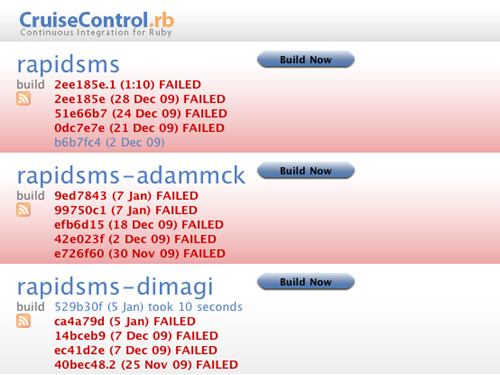

可以退回到一个更简单的模型,它能提供持续集成的部分好处。在这个模型中,你为每个仓库创建一个持续集成构建。每次发生变更时,你尝试从指定的主仓库合并并运行构建。图3.2展示了CruiseControl.rb为Rapidsms项目的主仓库以及它的两个分支构建。

为了创建这个系统,使用命令

git remote add core git://github.com/rapidsms/rapidsms.git

将指向主项目仓库的分支添加到CC.rb的每个Git仓库中。每次触发构建时,CC.rb尝试合并并运行构建:

git fetch core

git merge –no-commit core/master

[运行构建的命令]

构建完成后,CC.rb运行 git reset --hard

将本地仓库重置到它所指向的仓库的HEAD。这个系统并不提供真正的持续集成。然而,它确实能告诉分支的维护者——以及主仓库的维护者——他们的分支原则上是否可以与主仓库合并,以及合并结果是否会是应用程序的一个可工作版本。有趣的是,图3.2显示主仓库的构建当前是失败的,但Dimagi分支不仅成功地与它合并,而且还修复了失败的测试(并且可能添加了一些额外的功能)。

距离持续集成更远一步的是Martin Fowler所说的”混杂集成”(promiscuous integration) [bBjxbS]。在这个模型中,贡献者不仅在分支和中央仓库之间拉取变更,还在分支之间拉取变更。这种模式在使用GitHub的大型项目中很常见,当一些开发者在实际上是长期存在的特性分支上工作,并从其他从该特性分支派生的仓库拉取变更时。实际上,在这个模型中甚至不需要一个特权仓库。软件的特定发布版本可以来自任何分支,只要它通过了所有测试并被项目负责人接受。这种模式将分布式版本控制系统的可能性发挥到了逻辑上的极致。

这些持续集成的替代方案可以创建高质量、可工作的软件。然而,这只有在以下条件下才可能:

• 一个小型且经验丰富的提交者团队,他们管理拉取补丁、维护自动化测试并确保软件质量。

• 定期从分支拉取,以避免在分支上积累大量难以合并的库存。如果有严格的发布计划,这个条件尤其重要,因为人们的倾向是将合并留到发布前进行,此时会变得极其痛苦——这正是持续集成旨在解决的问题。

• 一组相对较小的核心开发者,可能由一个以相对较慢速度贡献的更大社区来补充。这使得合并变得可行。

这些条件适用于大多数开源项目以及一般的小型团队。然而,对于中型或大型全职开发者团队来说,这些条件很少能够满足。

总结:总体而言,分布式版本控制系统是一个巨大的进步,为协作提供了强大的工具,无论你是否在从事分布式项目。分布式版本控制系统可以作为传统持续集成系统的一部分非常有效,在这种系统中,有一个指定的中央仓库,每个人都定期(至少每天一次)向其推送变更。它们也可以用于其他不允许持续集成的模式,但这些模式仍可能是交付软件的有效模式。然而,我们建议不要在不满足上述正确条件时使用这些模式。第14章”高级版本控制”包含了对这些模式和其他模式以及它们有效的条件的完整讨论。

如果让你从本书中选择一个实践在开发团队中实施,我们建议你选择持续集成。我们一次又一次地看到它对软件开发团队的生产力产生了质的飞跃。

实施持续集成就是在团队中创造一种范式转变(paradigm shift)。没有持续集成时,你的应用处于损坏状态,直到你证明它是正常的。有了持续集成,你的应用的默认状态是可工作的,尽管信心水平取决于自动化测试覆盖率的程度。持续集成创建了一个紧密的反馈循环(feedback loop),让你在问题引入时就能发现它们,此时修复成本很低。

实施持续集成会迫使你遵循另外两个重要实践:良好的配置管理以及创建和维护自动化构建和测试流程。对某些团队来说,这似乎需要完成很多工作,但它们可以逐步实现。我们在前一章讨论了良好配置管理的步骤。关于构建自动化的更多内容在第6章”构建和部署脚本”中。我们在下一章更详细地介绍测试。

应该清楚的是,持续集成需要良好的团队纪律——但任何流程都需要这样。持续集成的不同之处在于,你有一个简单的指标来判断是否遵循了纪律:构建保持绿色。如果你发现构建是绿色的但缺乏足够的纪律,例如单元测试覆盖率低,你可以轻松地在持续集成系统中添加检查来强化更好的行为。

这让我们得出最后一点。一个成熟的持续集成系统是一个基础,你可以在此之上构建更多基础设施:

• 大型可视化显示屏,聚合来自构建系统的信息以提供高质量反馈

• 为测试团队提供报告和安装程序的参考系统

• 为项目经理提供应用质量数据的提供者

• 一个可以扩展到生产环境的系统,使用部署流水线(deployment pipeline),为测试人员和运维人员提供一键部署

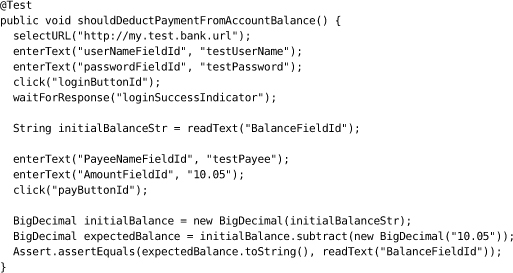

太多项目仅依赖手工验收测试来验证软件是否符合其功能性和非功能性需求。即使存在自动化测试,它们通常也维护不善且过时,需要大量手工测试来补充。本章以及本书第二部分的相关章节旨在帮助你规划和实施有效的自动化测试系统。我们为常见场景中的自动化测试提供策略,并描述支持和启用自动化测试的实践。

戴明(W. Edwards Deming)的十四要点之一是:“停止依赖大规模检查来实现质量。改进流程并从一开始就把质量构建到产品中”。测试是一项跨职能活动,涉及整个团队,应该从项目开始就持续进行。构建质量意味着在多个层次(单元、组件和验收)编写自动化测试,并将它们作为部署流水线的一部分运行,该流水线在每次对应用程序、其配置或运行环境和软件栈进行更改时触发。手工测试也是构建质量的重要组成部分:展示、可用性测试和探索性测试需要在整个项目中持续进行。构建质量还意味着不断努力改进你的自动化测试策略。

在我们的理想项目中,测试人员从项目开始就与开发人员和用户协作编写自动化测试。这些测试在开发人员开始开发它们所测试的功能之前编写。这些测试共同构成了系统行为的可执行规范(executable specification),当它们通过时,就证明客户所需的功能已经完整且正确地实现了。自动化测试套件由持续集成系统在每次对应用进行更改时运行——这意味着该套件也充当回归测试集。

这些测试不仅测试系统的功能方面。容量、安全性和其他非功能性需求在早期就已确立,并编写自动化测试套件来强化它们。这些自动化测试确保任何危及这些需求实现的问题在修复成本低的早期就被发现。这些对系统非功能性行为的测试使开发人员能够基于经验证据进行重构和重新架构:“最近对搜索的更改导致应用性能下降——我们需要修改解决方案以确保满足容量需求。”

这个理想世界在早期采用适当纪律的项目中是完全可以实现的。如果你需要在已经运行一段时间的项目中实施它们,事情会稍微困难一些。达到高水平的自动化测试覆盖率需要时间和仔细规划,以确保在团队学习如何实施自动化测试的同时开发可以继续进行。遗留代码库(legacy codebase)肯定会从许多这些技术中受益,尽管可能需要很长时间才能达到从一开始就使用自动化测试构建的系统的质量水平。我们在本章后面讨论如何将这些技术应用于遗留系统。

测试策略的设计主要是一个识别和优先排序项目风险,并决定采取何种措施来缓解这些风险的过程。良好的测试策略会产生许多积极效果。测试建立了软件按预期工作的信心,这意味着更少的缺陷、降低的支持成本和更好的声誉。测试还为开发过程提供了约束,促进良好的开发实践。全面的自动化测试套件甚至提供了最完整和最新的应用程序文档形式,以可执行规范的形式,不仅说明系统应该如何工作,还说明它实际上是如何工作的。

最后,值得注意的是,我们在这里只能触及测试的表面。我们的目的是涵盖自动化测试的基础知识,为本书的其余部分提供足够的背景知识,并使您能够为项目实施合适的部署流水线。特别是,我们不会深入研究测试实现的技术细节,也不会详细涵盖探索性测试等主题。有关测试的更多详细信息,我们建议您查看本书的配套书籍之一:Lisa Crispin 和 Janet Gregory 的《敏捷测试》(Agile Testing)(Addison-Wesley,2009)。

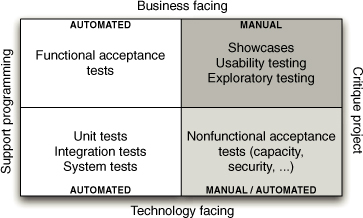

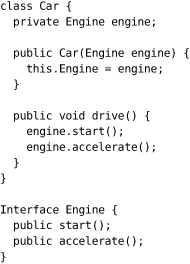

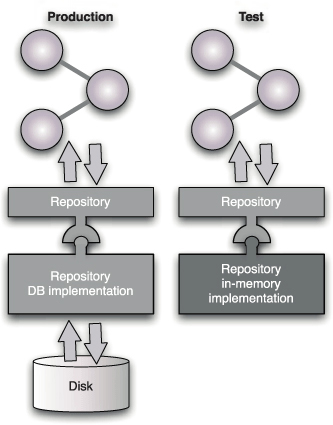

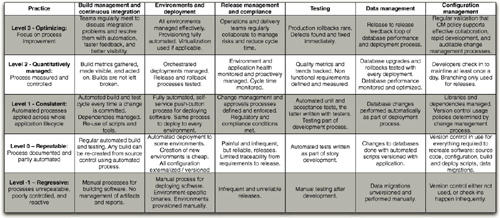

图4.1 测试象限图,来自 Brian Marick,基于当时”流行”的想法

存在许多种测试。Brian Marick 提出了图4.1,该图被广泛用于建模您应该实施的各种类型的测试,以确保交付高质量的应用程序。

在此图中,他根据测试是面向业务还是面向技术,以及它们是支持开发过程还是用于评判项目来对测试进行分类。

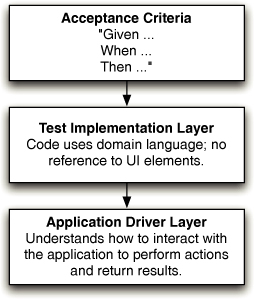

此象限中的测试通常称为功能测试或验收测试。验收测试确保满足故事的验收标准。验收测试应该在故事开发开始之前编写,理想情况下是自动化的。验收测试与验收标准一样,可以测试正在构建的系统的各种属性,包括功能性、容量、可用性、安全性、可修改性、可用性等。涉及系统功能的验收测试称为功能验收测试——非功能验收测试属于图表的第四象限。有关功能测试和非功能测试之间有些模糊且经常被误解的区别的更多信息,请查看我们下面关于评判项目的面向技术的测试的内容。

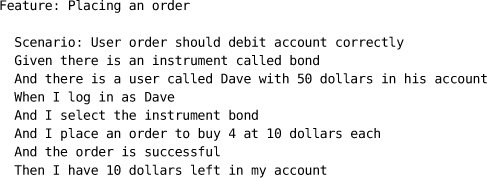

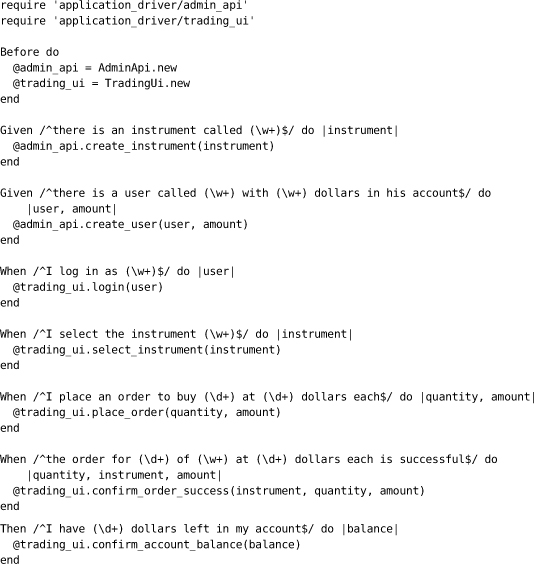

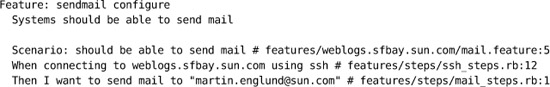

验收测试在敏捷环境中至关重要,因为它们回答了以下问题:对于开发人员来说”我如何知道我完成了?“,对于用户来说”我得到了我想要的吗?“。当验收测试通过时,它们正在测试的任何需求或故事都可以被认为是完成的。因此,在理想世界中,客户或用户会编写验收测试,因为它们定义了每个需求的成功标准。现代自动化功能测试工具,如 Cucumber、JBehave、Concordion 和 Twist,旨在通过将测试脚本与实现分离,同时提供一种机制使它们保持同步变得简单,从而实现这一理想。通过这种方式,用户可以编写测试脚本,而开发人员和测试人员共同完成实现它们的代码。

一般来说,对于每个故事或需求,在用户将执行的操作方面,通过应用程序有一条规范路径。这被称为快乐路径(happy path)。这通常使用以下形式表达:“给定(Given)[测试开始时系统状态的几个重要特征],当(when)[用户执行某些操作集],那么(then)[系统新状态的几个重要特征]将产生。”这有时被称为测试的”给定-当-那么”模型。

然而,除了最简单的系统之外,任何用例都将允许初始状态、要执行的操作和应用程序最终状态的变化。有时,这些变化构成了不同的用例,然后被称为替代路径(alternate paths)。在其他情况下,它们应该导致错误条件,从而产生所谓的悲伤路径(sad paths)。对于这些变量的不同值,显然可以执行许多可能的测试。等价类划分分析和边界值分析将把这些可能性减少到一组较小的案例,这些案例将完全测试所讨论的需求。然而,即便如此,您仍需要使用直觉来选择最相关的案例。