作者:Addy Osmani

版权所有 © 2025 Addy Osmani。保留所有权利。

在美国印刷。

由 O’Reilly Media, Inc. 出版,地址:141 Stony Circle, Suite 195, Santa Rosa, CA 95401。

O’Reilly 图书可用于教育、商业或销售促销用途。大多数书籍也提供在线版本 (http://oreilly.com)。如需更多信息,请联系我们的企业/机构销售部门:800-998-9938 或 corporate@oreilly.com。

采购编辑: Louise Corrigan

开发编辑: Sarah Grey

制作编辑: Katherine Tozer

文字编辑: nSight, Inc.

校对: Piper Content Partners

索引: Ellen Troutman-Zaig

内页设计: David Futato

封面设计: Susan Brown

封面插画: José Marzan Jr.

内页插画: Kate Dullea

2025年8月: 第一版

有关发布详情,请参阅 http://oreilly.com/catalog/errata.csp?isbn=9798341634756。

O’Reilly 标志是 O’Reilly Media, Inc. 的注册商标。《超越氛围编程》、封面图片及相关商业外观是 O’Reilly Media, Inc. 的商标。

本书中表达的观点为作者观点,不代表出版商的观点。尽管出版商和作者已尽诚信努力确保本书中包含的信息和说明准确无误,但出版商和作者对所有错误或遗漏不承担任何责任,包括但不限于因使用或依赖本书而造成的损害。使用本书中包含的信息和说明风险自负。如果本书包含或描述的任何代码示例或其他技术受开源许可或他人的知识产权约束,您有责任确保您的使用符合此类许可和/或权利。

本书不作为法律建议。如需法律建议,请咨询合格的专业人士。

979-8-341-63475-6

LSI

我们正处于软件构建方式深刻转变的时代。专业的氛围编程(vibe coding)——与AI协作创建软件的艺术——正在将开发者从代码工匠转变为产品愿景家和编排者。

氛围编程是关于利用AI的能力来处理编码的繁重工作,让开发者能够更多地专注于想法、设计和高层次的问题解决。正如 Andrej Karpathy 所言,这就像”忘记代码的存在”,只需构建——描述你需要什么,让AI填充实现细节。这可以带来数量级的生产力提升,使传说中的”10x工程师” 可能成为100x的现实。

本书面向三类核心读者。第一类是希望倍增其影响力的经验丰富的开发者和工程领导者。如果你已经编码多年并感受到重复性任务的负担,本书将向你展示如何将平凡的工作委托给AI,同时将你的角色提升为架构师和战略家。你将学会在不牺牲多年职业生涯中形成的质量标准的情况下更快地构建。

第二类是具有产品思维的工程师,他们将代码视为达成目的的手段而非目的本身。如果你对愿景与实现之间的差距感到沮丧,氛围编程可以极大地缩短这一距离。你将发现如何快速原型设计、迭代并交付使用传统方法需要数月时间的产品。

关于AI工具,我发现了一件最违反直觉的事情:它们对经验丰富的开发者的帮助大于初学者。这似乎很矛盾——AI不应该使编程民主化吗?

现实是,AI就像团队中有一个非常热心的初级开发者。他们可以快速编写代码,但需要持续的监督和纠正。你知道的越多,就越能更好地指导他们。

这产生了我所说的知识悖论(knowledge paradox):高级工程师和开发者使用AI来加速他们已经知道如何做的事情,而初学者试图用它来学习应该做什么,结果截然不同。

我观察到高级工程师使用AI来:

与此同时,初学者通常:

第三类是应对AI对其团队和流程影响的工程经理和CTO。你将深入了解如何在一个单个工程师可以完成过去需要团队完成的工作的时代里,构建团队、评估人才并保持代码质量。这里的策略将帮助你在保持工程文化完整性的同时顺利过渡。

你在这里找不到的是编程入门指南。虽然AI使编程更易于访问,但有效地使用它仍然需要来自经验的判断力。将本书视为为那些准备超越传统编程并拥抱软件创建新范式的人提供的高级培训。

本书探讨了开发者角色如何演变,从动手编程转向产品工程。这意味着运用人类判断来引导AI,确保质量、架构和用户需求得到满足。我们仍然提供创造力、系统思维和共情能力,将功能性程序转化为优秀产品。AI不会取代我们;它会增强我们——如果我们明智地使用它。

在第一部分中,我将识别氛围编码(vibe coding)擅长的领域:启动新产品、原型设计功能、生成标准的CRUD应用或集成代码——所有这些领域中,速度和模式匹配胜过深度原创性。相反,我也会审视我们对依赖AI仍需谨慎的地方:真正复杂、底层或新颖的算法,AI可能会在这些地方出错。认识到AI当前的局限性可以防止挫折和失败;仍有大量工作只有人类的创造力才能完成。

人的因素仍然是关键。我们确保架构合理、调试棘手的错误,并判断代码质量是否超越”能运行”。关键的是,我们将以用户为中心的思维融入开发——这是AI无法做到的。由我们来确保软件不仅能工作,而且能以有意义的方式为用户工作。简而言之,开发者成为AI输出的策展人和编辑者,始终使其与现实需求和高标准保持一致。

第二部分关注氛围编码的实践方面。采用新工作流程至关重要。“重新生成而非修复”这样的技术提醒我们不要陷入困境——有时重新生成代码比调试更快。并行提示(parallel prompting)让我们同时从多个角度解决问题。我们必须平衡快速迭代与最终改进,确保不会积累难以维护的混乱。模块化AI代码、全面测试和迭代改进等最佳实践有助于在高速开发的情况下保持代码库的整洁和健壮。

随着项目规模扩大,我们必须管理加速流入的代码和潜在的技术债务。AI可能让你的代码仓库充斥代码;只有纪律和良好的工程实践(加上可能的AI辅助重构)才能保持其可维护性。在人员方面,我们将招聘和培训擅长使用AI工具的工程师,重视适应性和系统设计技能。我们还会知道何时退回到传统模式——比如为了长期维护而巩固产品,或处理谨慎胜过速度的关键系统时。

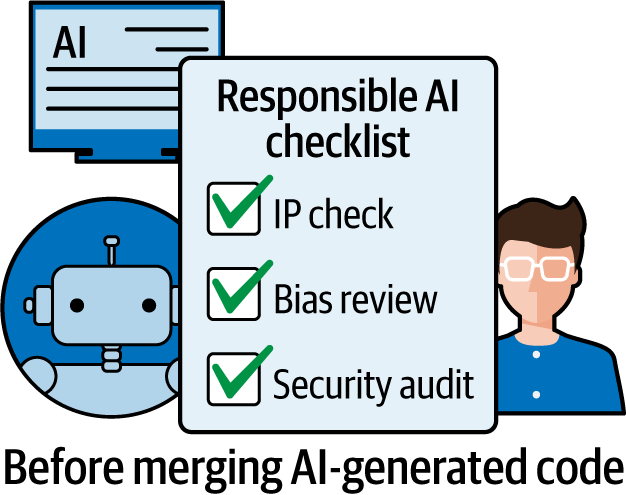

第三部分涵盖安全性和可靠性、伦理,以及一系列使氛围编码成为可能的工具:像Cursor和Windsurf这样的AI增强IDE,它们集成了Anthropic、Google的Gemini和OpenAI的模型,以理解你的整个代码库并在每个环节提供帮助。知道应用哪些工具和模型(Claude的各种变体用于不同任务,ChatGPT用于一般问答)是新开发者技能集的一部分。它们各有优势:Cursor用于交互式编辑,Windsurf用于上下文密集型任务,聊天界面用于头脑风暴和故障排除等。

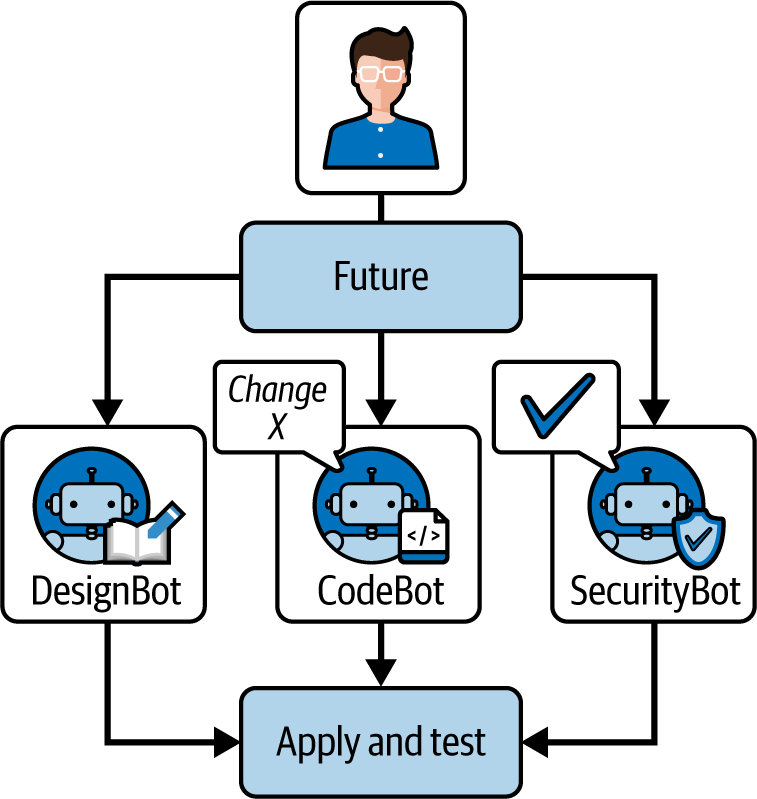

展望未来,我预计会有更抽象的软件构建方式(通过GUI和更高级别的输入进行”氛围设计”),对通用库的依赖会减少,因为AI会生成更多定制代码,甚至软件会基于AI反馈循环自主演进。在这个未来中,软件领域的成功将严重依赖于人类的创造力、分发能力和利用网络效应的能力,因为编码的暴力破解门槛将非常低。新的用户体验范式可能会出现,由AI的普遍性驱动——从对话界面到自适应UI等等。

在所有这些中,有一个主题突出:人类和AI优势的融合。单独任何一方都不如两者结合强大。AI带来速度、广泛的知识和不知疲倦的执行力。人类带来方向、深度理解和价值观。未来的最佳工作流程是一种共生关系——想象一下将大师级工匠与能够即时获取任何工具或参考资料的超级学徒配对。工匠的专业知识对于创造真正卓越的作品仍然至关重要。

对于阅读本书的开发者:是时候拥抱这些工具和范式了。本书将鼓励你在下一个项目中尝试AI编码助手,练习将问题分解让AI解决部分问题,并培养制作提示和策展结果的技能。但它也会敦促你加倍投入你的独特价值——你设计系统、与用户共情以及做出使软件与现实保持一致的判断的能力。

本书使用以下排版约定:

表示新术语、URL、电子邮件地址、文件名和文件扩展名。

等宽字体用于程序清单,以及段落中引用程序元素,如变量或函数名、数据库、数据类型、环境变量、语句和关键字。

此元素表示一般注释。

此元素表示警告或注意事项。

40多年来,O’Reilly Media一直提供技术和商业培训、知识和见解,帮助公司取得成功。

我们独特的专家和创新者网络通过书籍、文章和在线学习平台分享他们的知识和专业技能。O’Reilly 的在线学习平台为您提供按需访问的实时培训课程、深入的学习路径、交互式编码环境,以及来自 O’Reilly 和 200 多家其他出版商的大量文本和视频资源。如需了解更多信息,请访问 https://oreilly.com。

请将有关本书的意见和问题发送给出版商:

我们为本书建立了一个网页,在那里我们列出了勘误表和任何补充信息。您可以访问此页面:https://oreil.ly/BeyondVibeCoding。

有关我们的书籍和课程的新闻和信息,请访问 https://oreilly.com。

在 LinkedIn 上找到我们:https://linkedin.com/company/oreilly-media。

在 YouTube 上观看我们:https://youtube.com/oreillymedia。

AI 正在重塑我们构建软件的方式,引入了从自由形式提示(prompting)到结构化辅助的新编程范式(paradigm)。想象一下,通过简单地描述你想要做什么来编写软件——几乎就像和队友交谈一样——而 AI 将这些想法转化为代码。这就是氛围编程的本质,一种提示优先的探索性方法,你用自然语言描述你想要什么,让大语言模型(LLM)来填补空白。这个术语最近由 AI 先驱 Andrej Karpathy 提出,用来描述这种新的编程方式,开发人员”完全顺应 AI 辅助的氛围”。

在本书中,我将深入探讨氛围编程对专业开发人员的意义,以及它如何与我所说的 AI 辅助工程(AI-assisted engineering)——一种更正式的增强编码过程——进行比较和互补。我将探讨在这个 AI 优先的时代,开发人员的角色如何演变,哪些工具和工作流可以最大化你的效率,以及如何应对让 AI 在你的代码库中自由发挥的独特挑战。我还将研究氛围编程在哪些方面表现出色,在哪些方面遇到困难,以及如何平衡 AI 生成的速度与人类监督的智慧。最后,你应该清楚地了解如何在自己的编码实践中负责任且有效地利用”氛围”——在 AI 时代成为不仅更快,而且更具创造力和影响力的软件产品工程师。

在本章中,我们探讨开发人员的角色如何从为机器编写详细指令转变为通过表达意图(intent)与 AI 协作(见图 1-1)。我们将看到为什么编程中的这种”氛围转变”如此重要,它在高层次上如何工作,以及它带来了哪些机遇和挑战。

在过去的一年里,我观察到开发人员——尤其是中高级 Web 开发人员——在工作流程中接受 AI 的方式出现了有趣的分化。谱系的一端是氛围编程。另一端是我所说的 AI 辅助工程:一种有纪律的方法,在明确的约束下,将 AI 融入软件开发的各个阶段,从设计到测试。这两种方法都利用了强大的 AI,但它们的目标、受众和期望明显不同。在本书中,我将探讨这两个极端及其对现代 Web 开发的意义。

在 vibe coding 中,你利用强大的大语言模型(LLM)作为编程伙伴,让它们处理代码生成的繁重工作,这样你就可以专注于更高层次的目标。正如《商业内幕》的一篇总结所说,vibe coding “意味着使用 AI 工具……来处理编码中的繁重工作,从而快速构建软件。” 正如英伟达(NVIDIA)首席执行官黄仁勋所说,得益于 AI,“最热门的新编程语言”是英语,而不是 Java 或 Python。你不需要手动输入每个函数和错误修复,而是用自然语言与 AI 交互——勾勒出功能、审查建议,并根据 AI 的输出进行迭代。

这种方法代表了从传统编程到 AI 辅助开发的巨大转变。传统编码需要仔细规划、精确的语法,以及经常令人痛苦的调试过程。Vibe coding 颠覆了这一模式:“这不是真正的编码——我只是看东西、说东西、运行东西、复制粘贴东西,大部分情况下都能正常工作,”Karpathy 在接受《商业内幕》采访时开玩笑说,强调了 AI 如何将高层次的指令转化为可工作的代码,而只需最少的手动工作。

开发者从为计算机编写详细指令转变为在 AI 的帮助下编排结果。例如,Karpathy 描述了通过不断接受 AI 的建议来构建 Web 应用:“我总是’全部接受’,我不再阅读差异了……当我收到错误消息时,我只是复制粘贴进去……有时候大语言模型无法修复错误,所以我就绕过它或要求随机更改直到错误消失。” 代码”增长”超出了他通常自己编写的范围,但通过迭代提示和修复,项目很快就完成了。本质上,vibe coding 将编码视为与你的 AI 配对程序员进行的互动对话,而不是独自在语法和堆栈跟踪中艰难前行。目标是速度和探索——以最小的阻力获得可工作的解决方案。

几个趋势汇聚在一起,使 vibe coding 成为可能。首先,现代 AI 编码助手(如 OpenAI 的 Codex、ChatGPT、Anthropic 的 Claude 等)在生成和纠正代码方面变得惊人地出色。在同一篇文章中,Karpathy 指出这”之所以可能,是因为大语言模型……变得太好了”——它们已经消化了 GitHub 代码的大量内容,可以为许多任务生成合理的解决方案。

其次,新的开发者工具已经出现,可以将这些模型无缝集成到编码工作流程中(稍后会详细介绍这些工具)。最后,开发者社区的心态正在演变,越来越信任 AI 协助处理越来越大的工作块。这不再只是增强版的自动补全;而是将整个函数或文件交给 AI。实际上,vibe coding 通常感觉就像拥有无限供应的热心初级开发者来实现你要求的任何东西——只不过他们以云计算的速度工作。

Vibe coding 最令人瞩目的承诺之一是生产力的提升。早期采用者报告说,他们能够比以前快十到一百倍地创建软件功能或原型。例如,Codeium Windsurf 工程师 John Hoestje 思考道:“为什么要成为 10 倍工程师,而你可以成为 100 倍工程师呢?” 这表明,使用正确的 AI 驱动的集成开发环境(IDE),超凡的生产力是触手可及的。像 Windsurf 这样的工具,一个 AI 增强的 IDE,“可以显著加快开发时间,让你实现那 100 倍的生产力。” 虽然 100 倍可能是一个极端场景,但即使是更保守的研究也发现了巨大的收益。

开发者可以在几秒钟内生成样板代码,在眨眼间修复错误,甚至让 AI 编写测试或文档,将过去需要几天的工作流程压缩到几个小时。不再受打字速度或内存的限制,一个配备 AI 的开发者通常可以在一个周末内原型化一个全栈应用程序——这在过去可能需要一个小团队花费数周才能完成。这不仅仅是炒作;正如我在 2025 年 1 月为《务实工程师》撰写的博客文章中指出的那样,调查显示 75% 的开发者已经将某种形式的 AI 整合到他们的工作流程中,许多公司报告开发速度提高了两位数或三位数的百分比。简而言之,AI 配对程序员正在将神话般的”10 倍工程师”变成一个非常真实(且可达到的)100 倍工程师现象。

要理解这有多革命性,让我们看一个具体的例子。一位开发者想要构建一个简单的网页应用,用于统计播客脚本的字数并估算阅读时间。他们不是从零开始,而是打开一个AI驱动的编程环境,向AI描述自己的想法。几分钟内,AI就生成了一个可用的原型。然后开发者说:“把统计计数器改成亮色,并添加PDF导出功能”,AI就相应地更新了代码。结果是一个功能完整的工具,一键部署——所有这些在10分钟内完成。这个真实场景(由一位使用Replit AI的创作者报告)展示了vibe coding如何实现由高层次需求驱动的极快速迭代开发。同样,非工程师也加入进来:同一篇文章描述了一位被裁员的营销人员,没有任何编程背景,使用AI编程助手构建了100个简单的网页工具,这些工具集体登上了Product Hunt榜首。当创建软件的门槛降到如此之低时,我们不仅仅是在提高资深开发者的生产力——我们从根本上扩大了谁能够开发软件。

然而,vibe coding也有严重的注意事项。因为你将太多工作委托给AI,你最终可能得到一个在正常路径下”能用”但隐藏着大量bug或糟糕设计决策的代码。没有可靠的计划或约束,LLM可能会生成缺乏适当错误处理、安全检查或可扩展性的解决方案。事实上,AI生成的代码有时可能是建立在沙子上的:它看起来很稳固,但有隐藏的问题,只有在实际条件下才会暴露出来。我见过这样的案例:开发者以创纪录的速度通过vibe的方式完成了一个完整的功能,却在后来发现代码效率低下且难以维护。这种”纸牌屋”代码在压力下会崩溃。

例如,想象一下要求AI”快速搭建一个用户登录系统”。AI可能会快速生成一个可用的身份验证流程,但也许它使用了简化的加密方法或已知有漏洞的库。如果你在没有深入检查的情况下部署它,你就是在盲目相信一切都是健全的。资深工程师知道这是有风险的:在生产环境中运行的代码必须是被理解和信任的。正如一位专家所说:“通过vibe coding方式构建生产代码库显然是有风险的。我们作为软件工程师所做的大部分工作涉及演进现有系统,其中底层代码的质量和可理解性至关重要。”极端的vibe coding可能会绕过这些质量关卡。

另一个挑战是vibe coding倾向于轻视前期规划。传统软件工程重视为清晰和约束而设计——思考数据模型,选择适当的模式,并至少写出最小化的规格说明。Vibe coding颠覆了这一点:它从没有脚手架开始,通过提示直接投入实现。这可能导致曲折的开发过程。你可能通过提示把自己逼入困境——比如AI选择了你不打算使用的状态管理方法或库,现在你要么引导它回到正轨,要么接受它。没有初始蓝图,最终的架构可能是杂乱无章的。这对于快速的概念验证(proof of concept)来说还好,但在需要一致性的大型代码库中就有问题了。

Vibe coding本质上并不”坏”。事实上,它的出现是编程民主化(democratization of programming)持续进程的一部分。它降低了创建软件的门槛,就像早期的低代码平台或脚本语言所做的那样。一个有明确想法的积极的非工程师可能仅通过vibe就能构建一个简单的应用。对于经验丰富的开发者来说,vibe coding可以是一个强大的头脑风暴工具——它就像伪代码但能立即得到可运行的结果。关键是要认识到它的局限性。没有纪律的速度可能导致脆弱的软件,所以vibe coding需要一个警觉的人在循环中。我经常提醒开发者(和我自己)“vibe coding不是低质量工作的借口”。它应该是解决方案的起点,而不是终点。

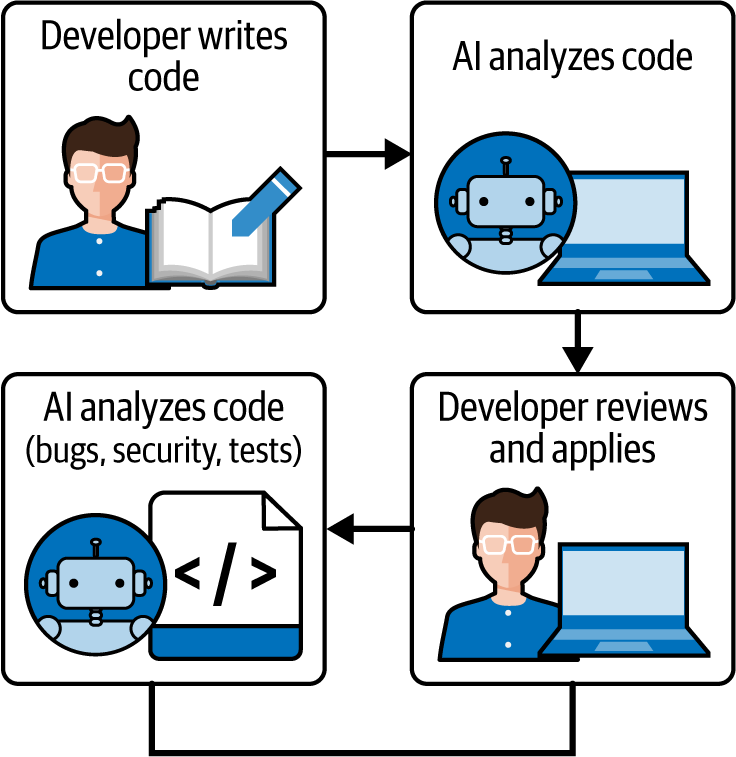

在我们的范围的另一端是AI辅助工程——一种更结构化、更有条理的软件构建方式,AI在每一步都作为副驾驶。在这里,开发者仍然牢牢地坐在驾驶座上。AI辅助工程包括在传统软件开发生命周期(SDLC)中使用AI,例如AI驱动的自动补全、聊天、代码迁移、bug检测、测试生成,以及细粒度(函数、模块、组件)和完整代码生成(见图1-2)。

你从一个计划开始(即使是轻量级的),概述你需要构建什么,并预先定义约束和验收标准。然后你以有针对性的方式融入AI工具来加速或增强计划的某些部分。与提示优先的氛围编码相反,我们可以称之为”计划优先”的AI支持开发。这可以正式到像一个迷你产品需求文档(功能的简短PRD),也可以简单到像一个任务清单。关键区别在于,在让AI开始工作之前,你将工作建立在明确的意图和约束之上。

考虑一个React开发者被要求创建一个新的交互式仪表板组件。在AI辅助工程方法中,他们可能会从写下组件的职责和API开始:

仪表板组件显示分析卡片列表,支持按日期范围过滤,并有刷新和导出按钮。它应该从我们的API获取数据(具有适当的错误处理),并且必须遵循我们的设计系统进行样式设置。

这个大纲本质上就是一个规范。开发者甚至可能快速勾画一个数据模型或识别要重用的现有实用函数。只有在那之后,他们才引入AI:例如,使用支持AI的IDE或编码助手根据该描述生成组件的框架。AI可能会提供React组件的初始实现,包含数据获取的占位符和存根事件处理程序。因为开发者提供了清晰的指导,AI的输出更有可能与项目需求保持一致(例如使用正确的设计系统类或调用正确的API端点)。代码不是意外的产物;它是精心设计的请求的产物。

AI辅助工程不会止步于单个组件的代码生成。它以受控的方式渗透到整个开发生命周期中。对于日常编码任务,像GitHub Copilot这样的AI自动补全工具可以在你输入时建议接下来的几行,当你实现已知模式时节省击键次数。例如,当你编写单元测试时,你的AI助手可能会根据函数名自动建议断言。说到测试,一旦功能就位,你可能会使用AI生成测试用例——将组件的规范或代码输入提示中,以获得你应该检查的边缘情况的建议。这个想法是增强工程师的工作,而不是取代它。你仍然在思考逻辑并验证正确性;AI只是减轻了一些繁重的工作。

当涉及到代码迁移或重构时,AI可以是天赐之物。想象一下需要将基于类的React组件转换为带有hooks的现代函数组件。与其全部手动完成,你可以要求AI助手转换代码或至少概述步骤。通过对旧模式和新模式的良好理解,LLM可以生成重构代码的草稿,然后你进行审查和完善。这种结构化的AI使用逐个处理明确定义的任务(例如”将此代码从Redux迁移到React Context API”),而不是给AI一个开放式的”构建任何东西”的任务。

也许AI辅助工程最引人注目的形式是使用AI从详细规范生成完整的迷你应用程序或功能。现在有几个工具允许你输入应用程序的描述,类似于迷你PRD,并返回一个工作代码库或原型。例如,开发者可以提供以下规范:

一个带有React前端和Node.js后端的待办事项列表应用,支持用户认证和实时更新

这个 AI 工具将搭建(scaffold)项目、创建关键组件并设置数据库模式(schema)。

这并非魔法,而是一个勤勉的工程师在启动新项目时可能会做的事情的加速版本(设置目录、选择库、编写样板代码)。重要的是,AI 的创造力受到规格说明中给出的约束条件的限制。结果是一个遵循您提供的需求的最小可行产品(MVP)。有经验的开发者正确对待这个输出时,不会假设它在第一次生成时就已经可以投入生产。相反,他们会将其视为初稿。他们会运行应用程序、编写或重新生成测试来验证每个功能、检查代码是否存在任何不一致或不安全的配置,并根据需要进行优化。简而言之,他们会应用所有常规的工程严谨性——只是通过 AI 从蓝图生成大量代码的能力来加速。

AI 辅助工程的目标与随性编码不同。这里的目标不仅仅是快速获得能用的代码,而是更高效地获得高质量的代码。这是在保持(甚至改善)结果可靠性的同时提升生产力。实践 AI 辅助工程的团队可能会说:“我们希望以两倍的速度交付这个功能,但在我们的标准上零妥协。”

这种方法的受众通常是专业开发者和已经建立了流程(代码审查、测试、部署流水线)且不愿放弃的团队。这些是中高级工程师,他们将 AI 视为工具箱中一个强大的新工具,而非工具箱的替代品。他们可能见过走捷径的后果,因此重视保持软件可维护性的实践。(相比之下,随性编码的受众包括拼凑演示的独立开发者、具有一定编码知识的产品导向人士,甚至是利用 AI 来弥补专业知识空白的相对较新的程序员。)

AI 辅助工程的预期是人类保持对决策的控制,而 AI 提供建议或加速器。代码质量、性能和安全性仍然至关重要,因此每一段 AI 生成的代码都要接受与初级开发者编写的代码相同的审查。将 AI 视为您的实习生,而非您的替代者。您可能会将任务委派给它,但必须审查它的工作。正如您永远不会在没有代码审查的情况下部署人类实习生编写的代码,您也不应该在不理解的情况下部署 AI 编写的代码。这种思维方式将工程纪律置于首要位置。

随性编码和 AI 辅助工程是两种截然不同的思维方式。随性编码是自上而下和探索性的:您从一个宽泛的想法开始,通过与 AI 的交互让实现逐渐显现。这有点像即兴爵士乐——结构最少,大量创意即兴空间,您在演奏过程中发现曲子的形态。AI 辅助工程是系统化和迭代的:更像古典作曲,您从一个主题或动机(您的需求)开始,有条不紊地发展它,可能在乐谱的小节内使用一些即兴创作(AI 建议)。两者都能产生”音乐”,但过程和结果类型会有所不同。

对于中高级 Web 开发者来说,您对每种方法的预期是关键。如果您在进行随性编码,您预期会有惊喜。AI 可能会想出一种您自己不会编写的方法——也许它使用了不同的库或您不太熟悉的编程习语。部分吸引力在于从这些惊喜中学习,或快速越过您觉得乏味的事情。但您也需要预期会有小波折。随性编码爱好者应该睁大眼睛意识到他们将对那段棘手的最后阶段负责。魔力是真实的,但不是全面的。

如果您在实践 AI 辅助工程,您的预期会更加谨慎,对于长期项目来说可以说更加现实。您期望 AI 为您节省时间,也许启发一两个解决方案,但不会做您的全部工作。事实上,一个优秀的 AI 辅助工程师可能会在更大的框架内小剂量使用随性风格的提示。例如,在实现一个明确指定的模块时,他们可能会暂时切换到”随性模式”问:“嘿 AI,生成一个快速的实用函数来格式化这些日期”,然后立即切换回工程师模式来集成和检查该函数。这种思维方式是将 AI 视为在您指导下工作的协作者。您将任务分配给它擅长的地方(如样板代码、重复性代码、粗略实现),而您自己处理其余部分(关键逻辑、集成、最终审查)。

这里的期望包括提高生产力,减少机械性错误(例如,AI 不太可能拼错变量名),以及可能更广泛的解决方案搜索空间(AI 可能会建议你没有想到的算法)。但你也需要投入时间进行验证。调试 AI 辅助代码仍然是调试:你运行测试,必要时在调试器中逐步执行代码。不同之处在于,你可能会发现自己在调试 AI 为你编写的代码,这是一种新体验,伴随着学习曲线。第 5 章将详细讨论这一体验。

这两种方法的目标突出了它们之间的根本差异:氛围编程(vibe coding)优化的是短期速度,而 AI 辅助工程优化的是持续速度和可靠性。氛围编程者可能会说:“我需要在今晚之前让这个应用运行起来,看看这个想法是否可行。”AI 辅助工程师则会说:“我需要快速构建这个功能,但它应该足够健壮,能够在我们的代码库中存在多年。”前者只要代码基本能运行就满意;后者关心的是代码是否足够清晰,以便其他人在此基础上继续构建。

这些差异自然会吸引不同的受众。经验较少的开发者或工程学科之外的人可能倾向于氛围编程,因为它降低了入门门槛并提供了即时满足感。我遇到过产品经理和设计师通过氛围提示(vibe prompts)涉足编码,将 AI 几乎当作一个超强版的 Stack Overflow,为他们提供完整的解决方案。另一方面,经验丰富的开发者和工程团队往往更青睐 AI 辅助工程。他们曾因脆弱的代码吃过亏,所以他们从”让我们做对,即使我们使用新工具来加快速度”的立场出发。他们在前期投入更多努力(编写那个迷你 PRD,设置项目结构),以换取长期回报。

人们很容易问:哪种方法更好?事实上,氛围编程和 AI 辅助工程并不是互相排斥的类别:它们代表了光谱的两端,现实世界的工作流程通常会融合两者的元素。开发者可能以一阵氛围编程开始项目,以搭建一些新颖的东西,然后切换到工程模式来巩固它。或者他们可能通常遵循 AI 辅助规范,但偶尔——对于一个微不足道的一次性脚本或一个临时原型——会说:“你知道吗,我就用氛围编程来做这个,看看会得到什么。”关键是理解权衡,并在正确的情境中使用正确的方法。

把氛围编程想象成一辆高速探索车:它可以快速带你离开既定路径,非常适合探索发现。AI 辅助工程更像是轨道上的可靠列车:你必须先铺设轨道(计划),但这是一个更安全的选择,更有可能到达既定目的地而不脱轨。中级和高级开发者应该能够驾驭这两种工具,但他们会根据手头的任务进行选择。如果目标是快速创新或构思(比如在黑客马拉松中或验证想法的可行性时),氛围编程提供了动力。只需记住,如果你计划重用该代码,要加以完善。如果目标是在专业环境中构建可维护的产品功能,倾向于 AI 辅助工程可确保你不会在代码库中留下一个没人真正理解的黑盒代码块。

我观察到的一个有趣现象是,随着开发者使用 AI 工具的经验增加,他们的使用往往自然地从氛围端转向工程端。最初,让 AI 从单个提示生成整个代码块的新奇感很诱人——谁不想尝试本质上”谈话”出一个应用程序呢?

但在蜜月期之后,实用主义开始发挥作用。开发者开始看到 AI 的优势所在以及它的不足之处。他们学会分解问题,并将它们分块提供给 AI,而不是在一次性要求整个解决方案。实际上,他们从”提示艺术家”转变为 AI “管弦乐团指挥”——仍然利用 AI 的创造力,但用熟练的手引导它,并遵循清晰的乐谱。在我自己的实践中,我在提示方面变得更加deliberate(深思熟虑),经常编写小段伪代码或注释,并要求 AI 完成它们,而不是只是提出开放式问题。这样,我在自己控制的结构内获得了类似氛围的流畅性的好处。

值得注意的是,工具正在演进以支持整个谱系。一方面,我们有基于聊天的界面和自然语言编码环境,专门为氛围式编码设计,你甚至可能在询问之前都看不到代码。另一方面,IDE 正在添加 AI 功能,无缝融入传统编码:例如,建议改进的 AI 代码检查工具(linter)、解释代码的文档生成器,以及可以自动创建拉取请求并建议审查更改的版本控制机器人。这些工具通过融入常规开发工作流程(编辑、审查、测试等)来鼓励工程思维,同时仍然利用 AI。

随着最佳实践的出现,氛围式编码和 AI 辅助工程之间的区别甚至可能会随着时间的推移而模糊。我们可能会发现,今天感觉像”氛围式”的方式将获得更多护栏,而感觉像”结构化工程”的方式将变得更加流畅。事实上,我认为理想的未来是我们可以毫不费力地在这个谱系上下移动:当我们想要时与 AI 一起探索创造性解决方案,但在需要强化和交付软件时始终用扎实的工程实践加以约束。

这种方法谱系代表了我们今天使用 AI 工具方式的重大演变。然而,即使我们改进了与 AI 协作的技术——无论是通过快速的氛围式编码还是结构化的工程工作流程——一个更根本的转变正在形成。编程本身的本质正在发生变化。我们正在从传统的范式转变,在传统范式中,开发人员必须将他们的想法转化为明确的指令,而转向未来,我们可以直接表达我们的意图,让 AI 处理到代码的转换。

这种转变挑战了我们关于成为程序员意味着什么的最基本假设。几代人以来,我们的价值一直与我们像机器一样思考的能力相关——将问题分解为计算机可以执行的离散逻辑步骤。但是,当机器能够理解我们想要什么,而不仅仅是我们告诉它们做什么时,会发生什么?这就是意图编程进入画面的地方,它不仅代表了一个新工具或技术,而是对开发人员角色的根本重新构想。

几十年来,编程意味着编写指令:一行又一行的代码告诉计算机如何做某事。每个函数、循环和条件语句都必须由人类精心制作。意图编程翻转了这个脚本。开发人员不再关注底层实现,而是关注结果或目标:你希望程序完成什么。你以高层次的方式(通常用自然语言)表达这种意图,AI 系统会找出实现它的代码。

这样想:传统编码就像给某人一步一步的指示,而基于意图的编码就像告诉他们你的目的地,让他们找出最佳路线。通过关注什么而不是如何,开发人员可以在更高的抽象级别上工作。这种方法并不完全是新的——可视化编程、低代码平台和代码生成器等工具长期以来一直承诺提高抽象级别。但今天的 AI 进步终于使用简单语言描述复杂行为并获得可工作的代码变得切实可行。

这种转变的核心是简单的提示词。提示词是你提供给 AI 编码系统的输入或问题。本质上,它是对你希望程序做什么的描述,而不是如何做的指令。这与编写代码的感觉可能非常不同。例如,与其编写一个循环来解析文件,你可能会提示:

读取这个 CSV 文件并提取所有年龄大于 18 岁的用户的电子邮件地址。

AI 将尝试生成完成该描述的代码。

为什么现在会发生这种情况?LLM 在理解和生成文本(包括编程语言)方面的快速进步一直是一个改变游戏规则的因素。这些 AI 模型已经在大量代码和自然语言文本上进行了训练。它们可以解释看起来像软件行为描述的提示词,并将其转换为实现该行为的实际代码。换句话说,它们已经学会了人类如何描述任务以及这些任务如何转化为代码的模式。

基于提示词的开发的兴起意味着,作为开发者,你越来越多地用自然语言或伪代码来描述功能和逻辑,让 AI 来处理编写语法正确代码的繁重工作。提示词成为你的新思维单元。它是意图的简洁表达。我们已经从告诉计算机”先做 X,然后做 Y,再做 Z”转变为说”我需要完成 X、Y 和 Z”,并相信 AI 会填补空白。

重要的是要注意,编写好的提示词本身就是一项技能(我们将在[第3章]中深入探讨)。模糊的提示词可能导致错误或低效的代码,就像模糊的需求会让人类程序员感到困惑一样。你越能清楚地表达你的意图,AI 的输出就越能满足你的需求。这就是为什么许多人称提示词编写为新的编程素养(programming literacy)。

那么 AI 是如何从你的自由形式描述转化为实际的、可运行的代码的呢?魔力在于大语言模型(LLM)解释上下文和生成文本的能力。“大语言模型”中的”大”指的是它拥有的参数数量(内部配置),通常是数十亿或更多,这使它能够捕捉自然语言和编程语言的复杂性。这些模型已经在公共代码仓库、论坛、文档和问答网站上进行了训练,学习了编程语言的语法以及如何使用代码解决问题的语义。当你与 AI 编码器交互时,你正在利用这种广泛的学习知识。让我们用简单的术语分解一下:

当你提供提示词时(例如,“生成一个检查数字是否为质数的函数”),AI 模型会分析该提示词的文本。Google、OpenAI 和 Anthropic 的现代模型已经在无数语言和代码示例上进行了训练,因此它们使用统计模式来推断你在问什么。本质上,AI 试图预测最有可能用有意义的代码完成提示词。

这些 AI 系统通常会考虑除单行提示词之外的额外上下文。例如,如果你在带有 AI 助手的 IDE 中工作,模型可能还会考虑当前文件内容、你的编码风格、注释,甚至相关文件。所有这些上下文都有助于 AI 生成适合你项目的代码。这类似于人类开发者阅读周围的代码和文档来理解下一步该做什么。

一旦模型理解了(或至少对你的意图做出了最佳猜测),它就会开始生成代码。在底层,它使用训练期间学到的概率一次生成一个标记(token)(标记是单词或代码符号的一部分)。该模型不会以传统意义上”思考”;它没有编译器或运行时来检查代码。它只是非常擅长以一种很有可能是正确代码的方式继续文本,因为它之前见过很多例子。如果提示词和上下文清晰,它生成的代码可能非常准确,甚至遵循它在训练数据中看到的最佳实践。

重要的是,AI 不会自行运行并为你部署应用程序。你仍然在循环中。你审查生成的代码,测试它,可以接受或修改它。在许多情况下,如果被问到,AI 还可能提供代码的解释,帮助你理解结果。AI 的角色就像一个为你起草代码的助手——但你,开发者,仍然是决策者,确保代码正确并符合项目的需求。

真正令人印象深刻的是,这个过程在几秒钟或更短的时间内就能完成。高层概述是,你的描述(提示词)进入预测引擎(大语言模型),它产生可能的代码作为输出。虽然模型的内部工作涉及复杂的数学和神经网络层,但在用户层面,它感觉几乎像是在与一位能够立即回忆起如何实现几乎任何东西的专家合作。

关于氛围编码(vibe coding)(基于意图的编程)要理解的关键之一是,它是人类和 AI 之间的迭代协作过程。你不只是写一个完美的提示词,然后坐等 AI 完美无瑕地编写整个程序。在实践中,你进行来回交流,一个反馈循环,逐渐将模糊的想法转化为完善的代码。

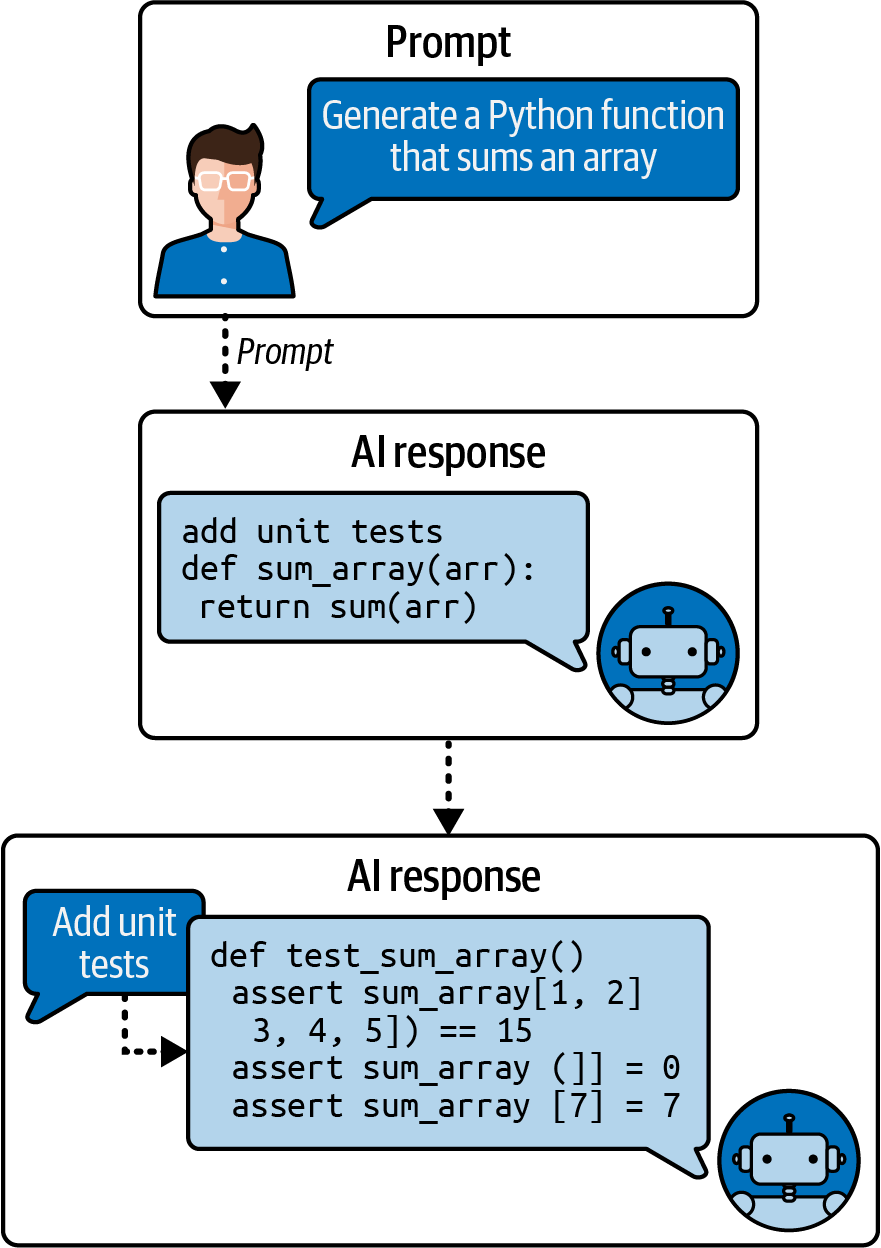

以下是一个典型的循环:

这是你的初始提示词或请求。例如:

生成一个函数,根据本金、利率和期限计算月度贷款还款额。

AI 为该函数生成代码,包括参数和贷款还款公式。它甚至可能包含解释公式的注释。

你查看代码。它合理吗?它处理边缘情况(edge case)了吗?你快速测试:如果利率为0会怎样?它能正确运行吗?你注意到它可能无法很好地处理这种情况。

如果代码不完美(通常第一次尝试都不会完美),就优化它。也许你再次提示AI(“修改函数以优雅地处理0%利率”),或者自己编辑代码并告诉AI,“解释这部分”,如果有什么不清楚的话。这种指导有助于纠正任何误解。

AI接受你的反馈或新提示并调整代码。现在函数检查零利率并适当地处理它。

你继续这个循环直到满意。也许接下来你要求AI为这个函数生成单元测试(unit test)以确保它正常工作。它这样做了,然后你运行它们来验证一切正常。

这种协作非常像结对编程(pair-programming)场景,其中一个伙伴是人类,另一个是AI助手。人类设定方向并了解高层需求,而AI提供建议,编写样板代码(boilerplate),并加快繁琐的部分。对于复杂任务,两者单独都不够有效:AI依赖人类提供方向和验证,而人类将一些工作卸载给AI以更快地推进。

至关重要的是,迭代不仅仅是修复错误;它也是关于演化解决方案。你可能从一个非常粗略的提示开始,然后随着你看到AI产生的内容,逐步优化你的意图。

这鼓励了一种实验心态。如果第一次尝试不对,你没有浪费太多时间——只需优化提示或调整代码并再次尝试。在传统编码中,编写一个模块却只能丢弃它可能令人沮丧,但使用AI生成的代码,错误开始的成本很低,这鼓励探索不同的方法。

为什么带有意图的编程(programming with intent)如此重要?这种转变有几个深远的影响:

: 也许最直接的好处是速度。当AI处理日常工作时,开发者可以更快地完成任务。手工编写可能需要数小时的常规代码(如设置数据库模型、API端点或数据清理脚本)通常可以在几分钟内生成。关于AI编码助手的早期研究支持这一点:使用GitHub Copilot等工具的开发者被证明可以显著更快地完成任务(一项研究发现,在Copilot协助下,给定任务的时间减少了55%)。当你将这些收益乘以整个项目时,它暗示了一个软件开发周期大幅缩短、团队可以更快迭代的未来。

: 除了原始速度之外,还有心理上的好处。编写样板代码或查找语法可能会打断程序员的心流和思路。有了AI处理许多这些中断,开发者可以专注于他们正在解决的问题。许多用户报告说,在AI的帮助下,他们对繁琐任务感到不那么沮丧,可以专注于编码的创意和设计方面。换句话说,它可以通过卸载无聊的部分使编码更有趣,这反过来可以提高工作质量(更快乐的编码者通常会产生更好的代码)。

: 传统上,编程需要学习严格的代码语法以及各种库和框架(framework)的怪癖。通过基于意图的编程,其中一些负担转移到AI身上。新手可能不记得打开文件的确切语法或绘图函数的参数,但如果他们能描述他们想要什么,AI可以填充这些细节。这并不意味着任何人都可以在零知识的情况下编写复杂系统(你仍然需要理解程序应该做什么),但这确实意味着产生有用结果的学习曲线更短。可以想象,领域专家(如生物学家或经济学家)可以通过描述他们的需求在他们的领域编写原型(prototype),即使他们不是专业开发者。从这个意义上说,编程对那些有想法和意图但没有深厚编码技能的人来说变得更容易获得。

随着 AI 承担更多代码生成工作,人类开发者的角色正在演变。架构设计、问题分解和验证等技能变得更加重要。你可能会发现自己花更多时间决定要构建什么,以及审查代码为什么有效(或无效),而不是敲出语法。“懂得如何编码”的本质可能会转向”懂得如何让 AI 编码”。这可能会使软件开发的某些方面民主化,同时也会提升专业人士的操作层次。我们可能会看到围绕如何有效引导 AI 的新最佳实践(我将在[第3章]中介绍这个主题,并在整本书中重新审视)。

有趣的是,随着 AI 处理更多常规编码工作,人类开发者可以专注于更高层次的创造性任务,比如优化用户体验、头脑风暴新功能,或解决 AI 可能无法很好独立解决的棘手算法问题。在这种理想情况下,AI 提高了 80% 重复性编码工作的生产力,释放你的精力用于那 20% 的创造性工作。这是我们分配精力方式的转变。

然而,这并不全是好消息。这种新的开发方式也带来了挑战:

你能信任 AI 编写的代码吗?如果你没有看到每一行代码,就有可能会忽略错误。开发者需要彻底测试和审查 AI 生成的代码。确保输出正确、安全和高效的责任在人类身上。盲目信任 AI 输出是有风险的,我们将讨论这一点。

如果你依赖 AI 进行常规编码,你是否会逐渐失去从头编写代码或深入调试问题的能力?这种担忧类似于过度依赖计算器会削弱算术能力。开发者需要有意识地在便利性和保持对基础知识的扎实理解之间取得平衡。

随着意图编程(programming with intent)变得普遍,行业可能会重视不同的技能。对那些只擅长编写样板逻辑的人的需求可能会减少,而对那些能够设计系统、集成组件和验证正确性的人的需求会更多。软件工作的性质可能会转变,AI 处理更多实现工作,而人类专注于设计和监督。

此外,“vibe coding”中最关键的因素之一是上下文窗口(context window)大小。Gemini 提供了所有 AI 模型中最长的上下文窗口,这在处理大型项目时可能改变游戏规则。一些模型现在支持超过一百万个 token 的上下文窗口,使它们能够保持对整个应用程序的感知。开发者可以将整个代码库提供给 AI 以获得全面的理解。

我们将在本章末尾更深入地探讨这些权衡。但首先,让我们熟悉一下支持这种新编码方式的新兴工具。

Vibe coding 可能是一种哲学,但它是由新一代 AI 驱动的工具实现的。想要采用这种工作流程的经验丰富的开发者需要熟悉一些使 AI 辅助编码有效的关键平台和模型。

本节快速介绍 vibe coder 工具包中的基本工具。这些工具包括 Visual Studio Code (VSCode) 及其不断增长的 AI 功能和扩展生态系统、像 Cursor 和 Windsurf 这样的下一代 AI 集成 IDE、像 Claude(各种版本)这样的 LLM,以及 ChatGPT。本节不涵盖后台编码代理(background coding agents),但我会在[第10章]中详细讨论它们。

当你阅读本节时,不要担心记住特定的工具名称或功能;格局正在快速发展。目标是了解可用解决方案的类型。

VSCode 已经从世界上最受欢迎的代码编辑器转变为一个全面的 AI 辅助开发平台,通过与 GitHub Copilot 的深度集成。这种演变代表了微软的愿景,即在数百万开发者每天已经使用的熟悉的 VSCode 环境中保持 AI 能力。

GitHub Copilot 是一个集成到 VSCode 中的 AI 驱动编码助手。它基于自然语言提示和现有代码上下文提供代码建议、解释和自动化实现。这种集成的独特之处在于其无缝性——Copilot 不仅仅是一个附加组件,而且感觉像是编辑器本身的自然延伸。

VSCode的AI能力核心围绕三种主要的交互模式。首先是内联代码自动补全,Copilot在您输入时提供内联代码建议,从单行补全到整个函数实现。当您编写代码时,会出现带有建议的幽灵文本,您可以用Tab键接受或逐字部分接受。

其次是聊天界面,通过侧边栏面板访问,您可以在其中就代码进行对话、提问或请求特定实现。第三个,也许是最强大的,是agent模式,它使用工具调用(tool calling)来访问Visual Studio内不断增长的能力集。当给定一个目标时,它会逐步选择并执行正确的工具。这个agent模式可以分析您的代码库,跨多个文件提出编辑,运行终端命令,响应构建错误,并在循环中自我纠正直到任务完成。

VSCode的Copilot实现特别引人注目的是它对模型上下文协议(Model Context Protocol, MCP)的支持。MCP为AI模型提供了一种标准化的方式来发现和与外部工具、应用程序和数据源交互。这意味着VSCode中的Copilot可以连接到数据库、调用API、访问文档,并与您的整个开发生态系统集成。例如,启用GitHub MCP服务器后,您可以要求Copilot”为我们讨论的每个bug创建一个issue”,它将直接与GitHub的API交互来创建这些issue。通过MCP的可扩展性(extensibility)将Copilot从代码生成器转变为一个全面的开发助手,它不仅理解您的代码,还理解您的整个工作流。

要在专业开发中有效利用VSCode和Copilot,首先根据任务复杂性探索不同的交互模式。对于简单的代码补全和重构,依赖内联建议和出现在错误附近的闪光图标—点击它获取AI驱动的修复。

对于更复杂的任务,通过打开聊天面板并从下拉菜单中选择”Agent”来切换到agent模式。Agent模式针对在项目中跨多个文件进行自主编辑进行了优化。它特别适用于不仅需要代码编辑还需要调用工具和终端命令的复杂任务。VSCode熟悉的界面与Copilot不断发展的AI能力的结合,为希望在不离开其既有开发环境的情况下获得企业级AI辅助的团队提供了一个引人注目的选择。

在探索专用AI IDE之前,值得研究Cline(以前称为Claude Dev)如何将VSCode转变为强大的AI辅助开发环境。Cline代表了与Microsoft的Copilot不同的理念。它不是一个紧密集成的助手,而是作为一个自主编码agent运行,可以从头到尾承担复杂的多步骤开发任务。这个开源扩展为VSCode带来的能力通常超过专有AI编辑器中的能力,同时保持了VSCode用户期望的灵活性和可扩展性。

Cline的独特之处在于其真正的代理式(agentic)软件开发方法。当您给Cline一个高级请求,如”创建一个带身份验证的用户管理REST API”时,它不会简单地生成样板代码。相反,它会分析您的项目结构,规划跨多个文件的实现,创建适当的文件夹层次结构,安装必要的依赖项,甚至可以运行测试来验证实现。在整个过程中,Cline通过向您展示每个计划的操作—文件创建、修改和终端命令—并让您有机会批准或修改每个步骤来保持透明度。这种人在回路中(human-in-the-loop)的设计在自动化和控制之间提供了完美的平衡,允许开发人员利用AI的能力,同时保持对代码库的监督。

Cline的技术能力远远超出了代码生成。它可以使用浏览器自动化来研究API文档,通过分析跨多个文件的错误跟踪来调试复杂问题,甚至可以通过其MCP支持与外部服务交互。对于调试,您可以粘贴错误消息,Cline将跟踪您的代码库以识别根本原因,提出修复方案,实现它,并添加适当的错误处理以防止类似问题。它的MCP集成意味着Cline可以连接到您的数据库以在生成查询之前理解模式(schema),访问您的项目管理工具以使实现与需求保持一致,或与任何其他兼容MCP的服务交互。这种可扩展性将Cline从代码生成器转变为一个全面的开发伙伴,它理解您的整个技术生态系统。

对于团队而言,Cline 提供了几个引人注目的优势。作为开源项目,团队可以检查其代码、贡献改进或为定制需求进行分支——这对于有特定安全性或合规性要求的组织至关重要。它支持多个 AI 提供商,包括 Anthropic 的 Claude、OpenAI 的模型、Google 的 Gemini,甚至可以通过 Ollama 支持本地模型,让团队能够根据性能、成本或数据驻留要求灵活选择模型。

要有效使用 Cline,需要编写包含项目上下文和约束条件的详细提示词(prompt),利用其在进行更改前分析整个代码库的能力,并充分利用其迭代开发能力。在 Cline 实现某个功能后,你可以立即测试并在同一对话上下文中请求改进。VSCode 成熟的生态系统与 Cline 的自主能力相结合,为团队提供了一条强大、灵活且成本效益高的 AI 辅助开发路径,而无需放弃现有的工具和工作流程。

氛围编程(vibe-coding)运动的旗舰工具之一是 Cursor,这是一个 AI 增强的 IDE,在寻求更流畅编程体验的开发者中迅速流行起来。Cursor 本质上是一个 AI 优先的代码编辑器(实际上是 VSCode 的一个分支),它将最先进的代码生成和理解功能直接内置到你的开发环境中。

它的标语是”AI 代码编辑器”,旨在让你使用纯语言指令来编写和修改代码。例如,你可以高亮显示一个函数并要求 Cursor”优化这个函数”或”在这里添加错误处理”,它会立即建议代码更改。Cursor 的 AI 具有项目感知能力——它会索引你的代码库并理解文件的上下文,因此可以提供更相关的建议(远超简单的自动完成)。Cursor IDE 将 LLM 能力集成到其核心界面中。它就像是了解你代码库的 ChatGPT。

在底层,Cursor 利用先进的语言模型(通常是 Anthropic 的 Claude 或 OpenAI 的模型,取决于你的设置)来支持其功能。它有一个聊天侧边栏,你可以在其中与代码进行对话,甚至还有一个用于多步骤代码生成的”Composer”模式。Andrej Karpathy 本人在他的氛围编程实验中使用了 Cursor 的 Composer 配合一个名为”Sonnet”的模型。这种设置允许他真正地与编辑器对话(通过”SuperWhisper”使用语音转文本),然后代码就会出现,他随后可以接受或改进。

Cursor 不仅可以生成代码,还可以在收到指令时编辑现有代码。例如,你可以询问:

你能让传输监听器中切换证书变得更容易吗?

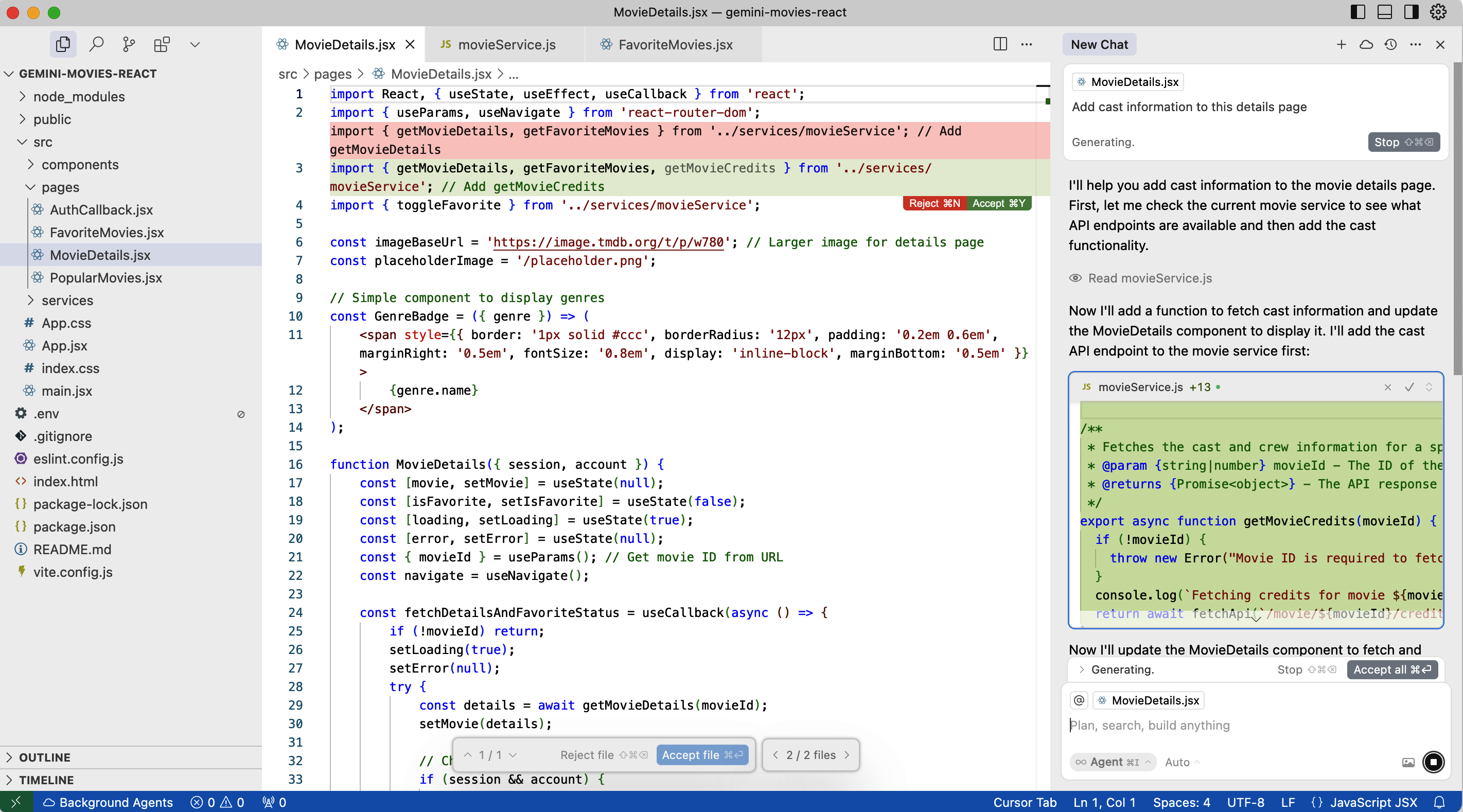

Cursor 会理解你指的是你的代码,并在相关文件中提出直接编辑建议,或从相关文件(如规范 markdown 文件)中读取(见图 1-3)。在免费版本中,它通常会在聊天中提供差异(diff)供你批准;在专业版中,它可以自动将更改应用到你的工作区。

要在专业工作流中高效使用 Cursor,你应该系统地利用其功能。首先在 Cursor 中打开聊天窗口,描述你想要的功能或修复。例如:添加一个用户登录表单,包含电子邮件和密码,以及验证和错误信息。Cursor 会生成所需的代码(创建新文件或修改现有文件),并以草稿状态呈现。你可以审查这些更改(它会显示差异或预览),然后点击”应用”将它们合并到你的代码库中。许多开发者遵循这个循环:提示 → 审查 → 接受。如果建议不够完美,你可以优化提示(例如,“使用 Tailwind CSS 来设置表单样式”)或直接要求 Cursor 修复你发现的任何问题(“现在处理电子邮件已被注册的情况”)。本质上,你与代码进行对话,直到它看起来满意为止。

Cursor 在理解错误和日志方面也表现出色。如果你运行代码并遇到错误追踪或错误信息,你可以将其粘贴到 Cursor 聊天中,AI 通常会分析它并建议修复方案。这将调试转变为一种协作体验:你不再需要手动搜索 Google 或 Stack Overflow,Cursor 的 AI 通常能够精准定位问题,甚至编写补丁。也就是说,明智的做法是验证修复方案,因为 AI 可能不会总是第一次就做对。

另一个专业提示:利用 Cursor 考虑多个文件的能力。你可以选择一组文件(或在提示中告知项目上下文),这样它在生成代码时会考虑整个代码库。例如:在后端添加一个新的 API 端点以支持登录表单,并将其连接到我们刚刚创建的前端表单。Cursor 会回忆起刚刚编写的前端代码,并帮助制作相应的后端逻辑。这种项目级的上下文理解能力,相比早期只能逐个文件工作的编码助手来说,是一个游戏规则改变者(game changer)。

总之,Cursor 就像在你的 IDE 内部拥有一个全天候的 AI 结对编程员。它直观(你用简单的语言与它对话),可以直接更新你的代码。你越是练习分解任务并用清晰的指令提示 Cursor,就会发现在短时间内能完成更多工作。它特别适合迭代开发:你构建一点,运行并查看输出,然后立即要求 Cursor 调整或扩展代码,然后重复这个过程。

在 vibe-coding 工具箱中另一个冉冉升起的新星是 Windsurf,这是一个 AI 驱动的开发环境,将代码理解提升到了新的水平。Windsurf 由 Codeium 团队构建,它通过索引整个代码库并使用检索技术在你工作时将相关部分提供给 AI 模型来实现差异化。实际上,这意味着 Windsurf 在处理大型项目时表现极佳,即使问题的答案可能分散在多个文件中。其核心使用了所谓的检索增强生成(RAG, retrieval-augmented generation),这是一种巧妙的方式,即它查找与你的提示相关的代码部分,并将该上下文提供给 AI,使其建议与你现有的代码保持一致。

对开发者来说这意味着什么?假设你刚接触一个大型代码库并需要添加功能。使用 Windsurf,你可以用自然语言询问:

代码库中用户身份验证逻辑在哪里处理?

它会搜索索引并指向正确的文件甚至函数。然后,你可以打开聊天(Windsurf 称之为”Cascade”视图,通过 Cmd+L 触发)并说:

在登录流程中添加基于手机的双因素身份验证。

因为 Windsurf 拥有你的身份验证逻辑的上下文,它可以生成跨多个文件(数据库、API、前端)的更改来实现这个功能,做出与你的系统结构一致的明智选择。

Windsurf 的写入模式(Write mode)可以大胆地为你应用更改:它会自动创建新文件或编辑现有文件,而不仅仅是在侧边栏中建议差异。这可以极大地节省时间:你不必从建议中复制粘贴,而是看到项目在原地演变。Windsurf 本质上试图在有信心时代表你采取行动,表现得像一个自主的初级开发人员在代码库中实现功能。(Cursor 的理念更加保守,会要求确认,尽管其 Pro 版本也有”自动应用”功能。)

要有效利用 Windsurf,理解其优势会很有帮助:

代码库问答

您可以用简单的英语查询您的代码库,几乎就像一个为您的项目定制的 Stack Overflow。这对于大型遗留项目非常有用,在这些项目中查找某个定义可能需要数小时。Windsurf 将通过从索引代码中提取信息,在几秒钟内给出答案。

因为它会将相关文件提供给模型,Windsurf 可以很好地处理诸如”将支付模块重构为使用我们编写的新日志工具”之类的任务,因为它同时了解支付模块和日志工具。

Windsurf 有多种模式(如前所述的自动完成、聊天、命令和级联)。级联模式类似于超级聊天,它可以考虑更广泛的上下文。写入模式(在聊天中)实际执行更改。作为工程师,您可以决定给予它多少自主权。

对于团队而言,Windsurf 可以像 Cursor 一样集成到日常开发中。在两者之间选择时,一些开发人员更喜欢 Windsurf,因为它的速度和大胆性(注意到它生成和应用更改的速度感觉更快),以及由于其索引功能而适合处理非常大的项目。另一方面,Cursor 的界面对 VSCode 用户来说可能感觉更熟悉。这不一定是非此即彼的选择——一些工程师会同时使用两者,或者团队可能会标准化使用其中一个。

总之,如果您想要一个在编写代码之前真正”阅读文档/代码”的 AI 编程助手,Windsurf 是一个出色的工具。它最大限度地减少了函数幻觉或变量名错误的机会,因为它可以查找信息。要充分利用它,请向它提供清晰的指令,并在写入模式下让它处理大任务,但对于细微的更改,也可以以更受控的方式使用它。始终检查它所做的更改(它会向您显示),特别是对于关键代码。Windsurf 很智能,但并非万无一失。明智地使用,它就像一个了解您整个项目的超智能 IDE,可以跨项目实现想法,大幅提升您的产出。

AI 编码格局已经发生了巨大变化,现在有多个强大的模型在竞争开发人员的注意力,包括来自 Claude、Gemini 和 OpenAI 系列的模型。 曾经可能只有一个模型占据主导地位,而如今的生态系统提供了丰富的选择,每个选择都有独特的优势,使它们适合不同的编码场景。

当今的编码模型通常分为几个类别,基于它们的方法和优势:

这些模型优先考虑快速响应,非常适合实时代码补全和快速迭代。它们通常提供较低的延迟,代价是在复杂任务上的准确性略有降低。

这些模型花更多时间”思考”问题,但在复杂调试、架构决策和多步骤问题解决方面表现出色。具有高级推理能力的模型可以逐步分解复杂的错误。

一些模型不仅可以处理代码和文本,还可以处理图像、图表,甚至视频内容。这使它们在理解可视化文档或处理 UI/UX 元素时特别有价值。

DeepSeek 的突出之处在于提供了与闭源模型相当的 AI 能力水平,无需付费或注册,尽管它可能缺少一些功能,如图像生成或网页浏览能力。

成功的开发人员现在不再寻求单一的”最佳”模型,而是将模型与特定任务相匹配:

对于快速原型设计和通用编码,针对速度和广泛语言支持优化的模型效果很好。

对于复杂的调试和系统设计,能够系统性地追踪逻辑的深度推理模型是一个好选择。

对于处理大型代码库,选择具有广泛上下文窗口的模型,可以保持项目范围的感知能力。

对于预算有限的团队,开源模型无需订阅费用即可提供出色的价值。

许多工具现在支持多种AI模型,包括OpenAI、Claude和Gemini变体,以及专有模型,允许开发者根据手头的任务在它们之间切换。

无论您选择哪种AI模型,某些实践始终能改善结果。首先,提供丰富的上下文。不要只是要求”一个支付处理函数”。相反,分享您的数据模型、现有代码模式、错误处理方法以及任何具体要求。您提供的上下文越多,输出就越能与您的代码库保持一致。

大多数现代编码模型都擅长审查自己的输出。在收到生成的代码后,要求模型检查潜在问题、提出改进建议或解释其推理过程。这种自我批评通常能发现细微的错误或建议优化方案。

利用模型维护对话上下文的能力。从基本实现开始,然后通过后续请求逐步完善它。这种迭代方法通常比试图预先指定所有内容产生更好的结果。

每个模型在处理问题的方式上都有细微差别。有些在解释时更冗长,而另一些则更简洁。有些默认使用较新的语法,而另一些则更保守。了解这些倾向有助于您制定更好的提示。

AI编码领域每月都在演变,新模型定期挑战既有领导者。竞争变得如此激烈,以至于开发者从前所未有的选择和能力改进中受益。最重要的不是选择”完美”的模型,而是理解如何利用可用工具的优势。

许多开发团队现在采用组合方法——利用快速模型处理日常任务,利用强大模型应对复杂挑战,并利用专门模型处理特定领域,如数据库优化或前端开发。一些IDE甚至允许在任务中途无缝切换模型。

成功来自于理解这些选项并策略性地应用它们来加速您的开发工作流程。

Google的Gemini系列通过其原生多模态能力代表了AI辅助开发的根本性转变。与主要在文本和代码上训练的模型不同,Gemini从底层架构上就被设计为能够无缝理解和处理文本、代码、图像、视频和其他数据格式。这使其在视觉上下文与文本信息同等重要的现代开发工作流程中异常强大。

Gemini的多模态特性在Web开发场景中特别有价值。开发者可以分享设计原型的截图,Gemini能够生成与视觉风格完美匹配的像素级实现。它擅长理解图表、图示和UI元素,使其成为将视觉设计转化为功能代码时的理想合作伙伴。这种能力不仅限于简单的图像识别:Gemini可以对视觉元素进行推理,理解设计模式(design patterns),并在整个项目中保持美学一致性。

Gemini 通过流行的编辑器(VSCode、Cursor、Windsurf)以及 Cline 和 Code Assist 等插件与开发工作流程集成,为开发者提供了强大的自定义选项,可以从个人偏好扩展到团队标准。开发者可以为重复性任务创建自定义命令,建立适用于每次代码生成的规则,并在大型代码库中维护一致的编码模式。其慷慨的免费套餐使学生、爱好者和初创公司都能使用,而企业功能则支持复杂的组织需求。

Gemini 在编码领域的独特之处在于其能够深入思考问题的同时保持实用的速度。该模型可以在简单任务的快速响应和复杂挑战的深入推理之间切换,根据手头的问题调整其方法。这种灵活性与其视觉理解能力相结合,使其在全栈开发中特别有效,因为后端逻辑和前端美学同等重要。

Anthropic Claude 的编码辅助方法以透明度和深度推理能力为中心。Claude 系列,特别是 Sonnet 模型,已确立自己在需要仔细分析和逐步解决问题的复杂软件工程任务方面的卓越能力。Claude 的独特之处在于其能够展示思考过程,让开发者能够跟随其推理并在实施解决方案之前验证其逻辑。

Artifacts 功能代表了开发者与 AI 编码助手交互方式的范式转变(paradigm shift)。Claude 不是简单地在聊天界面中提供代码,而是创建一个专用工作空间,可以实时查看、编辑和预览代码。这种交互式环境对于前端开发、数据可视化以及即时视觉反馈可以加速开发过程的任何场景都特别强大。开发者可以在同一对话中迭代设计、测试功能并改进实现。

Claude 在实际软件工程基准测试中表现出色,在错误修复、功能实现和代码重构等任务方面始终位居顶级模型之列。其优势不仅在于生成代码,还在于理解软件项目的更广泛上下文。Claude 可以分析现有代码库、识别模式和反模式(antipattern)、建议架构改进,并保持与既定编码风格的一致性。这使其对于绿地项目(greenfield project)和遗留系统维护都非常有价值。

该模型的内存和上下文管理方法使其能够在扩展的编码会话中建立理解。在处理大型项目时,Claude 可以提取并保留有关代码库结构、设计决策和项目特定模式的关键信息。这种累积的知识使其能够随着开发进展提供越来越相关和符合上下文的建议,让人感觉更像是一个随着时间推移熟悉项目的团队成员,而不是一个无状态的助手。

ChatGPT 已确立自己作为 AI 编码助手中的瑞士军刀地位,其价值不在于专业化功能,而在于其卓越的多功能性和广泛的知识库。它在开发者工具包中的地位是独特的。虽然其他模型可能直接集成到 IDE 中或提供专门的编码环境,但 ChatGPT 作为一个始终可用的编程顾问,开发者在整个工作日都会在浏览器中保持其打开状态。

ChatGPT 的对话界面使其在探索性问题解决和学习方面表现出色。开发者经常使用它进行橡皮鸭调试法(rubber-duck debugging),粘贴有问题的代码并通过自然对话思考问题。其广泛的训练使其能够识别几乎所有常用编程语言、框架和工具的模式。无论是调试正则表达式、理解晦涩的错误消息,还是探索不熟悉的库文档,ChatGPT 都能从其全面的知识库中提供相关见解。

ChatGPT 的优势在于其能够弥合人类意图与代码实现之间的鸿沟。它擅长双向翻译(bidirectional translation)——将自然语言描述转换为可运行的代码,并用简单的英语解释复杂的代码。这使得它在团队内的文档编写、代码审查和知识传递方面非常有价值。开发者可以粘贴不熟悉的代码并获得其功能的清晰解释,或者描述期望的行为并获得跨多种编程范式的适当实现。

该模型的多功能性超越了传统编程语言,延伸到配置文件、脚本、数据格式和领域特定语言(domain-specific languages)。虽然专业编码工具在其专注领域表现出色,但 ChatGPT 在整个软件开发任务范围内提供有价值的帮助。这种广度使其在跨不同技术的边界工作或遇到跨多个领域的问题时特别有用。它在扩展对话中保持上下文的能力允许开发者迭代地探索复杂问题,通过协作对话完善解决方案。

这些强大的 AI 编码助手的可用性代表了软件开发实践的根本性转变。成功的开发者不会将它们视为竞争选项,而是认识到每个模型家族在开发过程的不同方面都带来了独特的优势。当视觉上下文和多模态理解(multimodal understanding)至关重要时,Google 的 Gemini 表现出色,特别是在 UI/UX 开发和处理设计规范时。在需要深度推理、复杂重构和透明问题解决方法的场景中,Anthropic 的 Claude 表现突出。OpenAI 系列模型提供无与伦比的多功能性和广泛知识,使其成为学习、调试和跨领域挑战的理想选择。

现在许多开发团队采用组合策略(portfolio approach),在同一项目中针对不同任务利用不同模型。典型的工作流程可能包括使用 Gemini 将设计原型转换为初始实现,使用 Claude 进行复杂的架构决策和代码审查,使用 ChatGPT 进行一般问题解决和文档编写。这种多模型方法通过将每个工具的优势与特定开发挑战相匹配来最大化生产力。

随着这些模型的持续发展,有效进行 AI 辅助开发的关键不在于选择单一的”最佳”选项,而在于理解如何协调多个 AI 助手来加速和增强软件开发生命周期的每个方面。

这个生态系统还很年轻且快速变化。每隔几个月就会出现新的参与者和能力。关键要点是,你不必从头构建自己的 AI 来利用意图编程(programming with intent)——有许多工具将这种能力带到你的指尖。在本书中,我将讨论各种平台以及它们如何融入氛围编码(vibe coding)工作流程。

重要的是要认识到 AI 辅助开发真正发光的场景——以及它可能仍然不足的地方。让我们探讨一些氛围编码表现出色的理想用例,以及当今 AI 仍然存在困难或需要大量人工干预的情况。

正如某些架构适合某些问题一样,氛围编码在软件开发领域也有其”最佳场景”。

Vibe编程对于从零开始启动一个全新项目来说是一个游戏规则改变者。“零到一”一词(由Peter Thiel推广)指的是从零开始创造全新的东西。借助AI,你可以以闪电般的速度从一张白纸变成一个功能原型。需要建立一个从未存在过的Web应用程序?你可以在一次疯狂的提示会话中生成前端、后端、数据库架构甚至部署脚本的样板代码。这对于目标是快速验证想法的初创公司或黑客马拉松项目来说非常完美。你可以让AI在几分钟内完成这些工作,而不是花费数周时间来设置项目的”脚手架”(所有重复的设置代码)。

许多开发者讲述了他们如何在AI配对程序员的帮助下在一个周末构建了一个MVP(最小可行产品)——这在以前独自工作可能需要一个月的时间。通过快速将想法具体化为工作产品,你可以更快地开始与用户或利益相关者进行测试。AI擅长处理通用的东西(设置路由、基本UI组件、标准CRUD操作),这让你可以专注于产品的新颖方面。

然而,一旦你的MVP获得关注并走向生产环境,你的方法就必须改变。这就是AI辅助工程变得至关重要的地方。虽然vibe编程帮助你快速探索和验证,但现在扩展需要更加深思熟虑的实践。你需要用适当的错误处理重构快速生成的代码,添加全面的测试覆盖率,并建立清晰的架构边界。从原型到产品的过渡标志着从vibe编程的探索性自由到工程的结构化规范的自然演变。聪明的团队会认识到这个拐点并相应地调整他们的AI使用方式——在保持速度的同时引入可持续增长所必需的护栏。

许多软件工程,特别是在业务应用程序中,涉及围绕数据的CRUD——创建、读取、更新、删除——功能。这是AI特别擅长的公式化工作,因为它见过无数的例子。如果你需要向系统添加一个新的”库存”模块,包含CRUD界面和API,vibe编程将处理得非常好。它可以生成数据库迁移、ORM模型、API端点和带验证的UI表单——基本上是全栈——基本上没有错误,因为这些模式在其训练数据中非常常见。即使你的应用程序有自定义规则,你也可以在提示中指定这些规则并获得不错的初稿。结果是:曾经需要一周时间的枯燥连接工作变成了一个下午的提示和测试。对于内部工具或管理面板(本质上是大型CRUD应用程序),考虑到它们通常如此简单却又耗时,你几乎可以完全依赖AI来生成它们。

当这些CRUD操作涉及复杂的业务逻辑、数据验证规则或与现有系统的集成时,工程方法变得至关重要。虽然vibe编程可以快速生成基本结构,但AI辅助工程确保你的库存模块能够正确处理边缘情况,如并发更新,维护引用完整性,并遵循组织既定的模式。例如,你可以使用vibe编程生成初始CRUD脚手架,然后切换到工程模式来实现特定领域的规则,如库存阈值警报、多仓库分配逻辑或与现有身份验证和授权系统的集成。关键是识别何时从快速生成过渡到仔细完善。

需要将两个服务或API集成在一起?这通常涉及阅读文档并编写代码以将数据从一种格式转换为另一种格式。AI模型通常在API文档和代码示例上进行过训练,这意味着它们可以加速集成工作。要求ChatGPT展示如何从语言B调用服务A的API——很可能它会生成带有正确端点甚至可能包含身份验证示例的示例代码。当AI可以建议样板和要处理的边缘情况时,组合多个系统(如将支付网关与订单系统连接或连接第三方分析SDK)变得更容易。它擅长这些标准集成模式。

AI编程助手已经有效地阅读了所有流行框架(frameworks)的手册:React、Angular、Django、Rails、Node/Express、Flutter等等。这意味着如果你使用知名框架,AI可以为这些框架生成符合惯用法的代码。例如,它可以生成一个带有hooks和状态管理的新React组件,或者一个带有适当admin类和serializer的新Django模型。好处是你不必记住每个细节,AI会填补这些空白。Vibe编程在现代Web开发任务中表现尤其出色,比如生成带有正确类的HTML/JSX或连接控制器端点,因为这些是AI模型反复见过的任务。这就像有一个框架专家总是在你身边编写样板代码,而你只需决定功能的具体实现。

有时你需要创建大量相似的代码(比如为某个模式(schema)中的每种类型创建许多相似的端点或类)。这对人类来说可能既繁琐又容易出错。另一方面,AI喜欢重复性结构——一旦你展示一两个示例,它就能一致地生成其余部分。这种批量代码生成可以节省大量时间。例如,如果你要为50种类型的记录编写数据模型类,你可以提供一个示例并要求AI按照该模式为所有50种类型生成类。它很可能会在几秒钟内完美完成。结果是:你避免了一整天的单调编码工作。

虽然vibe编程在某些场景中表现出色,但AI辅助工程(AI-assisted engineering)在其他情况下变得不可或缺。理解这些情况有助于开发者从一开始就选择正确的方法,避免代价高昂的重写或技术债务(technical debt)。复杂的算法实现需要工程方法。当你构建复杂的数据结构、实现性能关键的算法或解决新颖的计算问题时,你需要对实现的每个方面进行精确控制。

在这里,AI充当知识丰富的助手而非代码生成器。你可能会要求它解释算法方法或审查你的实现的正确性,但你保持对架构和优化决策的直接控制。AI帮助你思考问题,而不是完全解决它们。

关键任务系统(mission-critical systems)从一开始就需要工程严谨性。金融交易、医疗应用、安全基础设施和其他高风险领域承受不起vibe编程的探索性特质。在这些环境中,每一行代码都需要仔细考虑、全面测试,并且通常需要符合监管要求。AI通过建议最佳实践、识别潜在漏洞和帮助确保符合标准来提供协助,但开发者保持对实现的严格控制。

这些系统中失败的成本远远超过快速生成带来的任何速度优势。遗留系统集成(legacy system integration)带来了独特的挑战,在这些挑战中工程纪律被证明是必不可少的。当处理几十年前的代码库、专有协议或具有大量技术债务的系统时,vibe编程的模式匹配往往会失败。这些场景需要深入理解现有约束、仔细规划集成点以及有条不紊的重构。AI可以通过解释遗留代码模式或建议现代化策略来提供帮助,但实际实现需要只有结构化工程才能提供的精确性。

性能优化(performance optimization)代表了工程胜过vibing的另一个领域。虽然AI可以快速生成功能性代码,但它很少为性能关键路径产生最优解决方案。内存管理、缓存优化、并行处理和延迟降低等任务需要对硬件、操作系统和算法复杂度有深入理解。在这里,AI最好充当研究助手,帮助你探索优化技术或对不同方法进行基准测试,而你做出关于实现的明智决策。

在这些场景中,AI的模式识别和速度与任务完美契合。本质上,vibe编程在编程中的常见任务(如CRUD或典型的Web应用结构)和受益于快速试错的任务(原型、新想法)上表现出色。这就像有一个初级开发者,他读过每个GitHub仓库,可以立即回忆起通常是如何完成的,并为你编写供审查的代码。这对于快速推进事情来说非常强大。

现代 AI 增强开发的艺术不在于选择其中一种方法,而在于识别何时在它们之间转换。成功的开发者会培养出对这些拐点的直觉。开始一个新功能?从氛围编码(vibe coding)开始快速探索可能性。注意到代码变得复杂或涉及关键系统?切换到工程模式。为客户演示构建概念验证?氛围编码能让你快速完成。将概念验证转换为生产系统?是时候采用工程规范了。

这种流动性——在快速探索和仔细构建之间无缝切换的能力——区分了真正高效的 AI 增强开发者。他们明白氛围编码和 AI 辅助工程是工具箱中的互补工具,各自适用于开发生命周期的不同阶段。目标不是选边站,而是策略性地利用这两种方法,在整个软件开发过程中最大化速度和质量。

尽管当前的 AI 编码工具令人印象深刻,但它们并非魔法。有些类别的问题对于 AI 来说仍然难以可靠地处理,通常需要人类洞察力或传统编码技术。了解这些局限性有助于设定正确的期望,并让你规划何时依赖 AI,何时重新掌控。

这些局限性包括以下几点:

如果你正在处理非常复杂的算法或 AI 可能没有见过的新颖问题,它可能会陷入困境。例如,从研究论文编写全新算法,或者做一些像编写编译器或高度并发系统的事情——这些涉及需要真正理解和通常需要创造性飞跃的复杂逻辑。AI 可以尝试,但它可能会在细节上出错。

在这些复杂领域中,AI 倾向于生成大致正确但不完全正确的代码,这可能导致大量的来回修改。正如第 3 章和第 4 章将讨论的,最后 30% 左右的正确性对 AI 来说很难钉住。这与我所说的 70% 问题有关——AI 能快速让你完成大部分工作,但最后部分很困难。有经验的开发者可能会使用 AI 为这些复杂任务生成骨架或辅助函数,但核心逻辑自己完成。

当前的 AI 模型主要在高级语言和抽象上训练。如果你需要进行底层位操作,为特定微控制器编写高度优化的 C 代码,或生成矢量化 SIMD 指令,AI 可能不可靠。它可能会生成看起来合理但在硬件层面上并不真正优化甚至不正确的代码。

同样,对于内存管理或实时约束之类的事情,AI 没有真正的概念(它不会在脑海中模拟 CPU 缓存)。因此,对于性能关键的代码,你需要彻底测试 AI 的建议或手动编写这些部分。话虽如此,AI 仍然可能通过提供起始模板或解释汇编来提供帮助,但在这些场景中你不能盲目信任它。

如果你使用的是在 AI 训练期间不存在的非常新或晦涩的框架,它就不会知道。在这种情况下,AI 可能会尝试泛化,或者可能生成看起来合适但实际上调用不存在的函数(幻觉)或使用过时版本 API 的代码。例如,如果一个新的 Web 框架版本上个月发布并带有破坏性更改,AI 就不会知道这些更改。它可能会给你旧版本的代码。在这些情况下,你必须依靠文档,甚至可能通过在提示中提供文档中的上下文来帮助训练 AI(基本上是即时教学)。

如果你要求 AI 设计一个完全新颖的用户界面或体验,它在这种创造性飞跃上并不擅长。它可以为已知模式生成 UI 代码(如标准表单或仪表板),但如果你想要一个没有明确先例的创新 UI,AI 可能不会给你带来灵感的东西。它可能只是将熟悉的组件拼接在一起。人类设计师和前端开发者仍然非常需要去构想新的用户体验。从编码角度来说,AI 可以快速为你制作一个标准外观的界面,但对于那种特殊的定制感觉,你需要引导它或手动调整。

有时当需求是隐含的或矛盾的时候,AI 会遇到困难。除了你明确告诉它的内容之外,它对最终目标没有真正的理解。如果需求含糊不清(“让它高效”——这到底意味着什么?),AI 可能会错误地猜测你关心的是什么(例如内存与速度)。人类更擅长澄清意图,特别是与非技术利益相关者沟通时。AI 也可能误解指令,特别是如果存在它不知道的特定领域上下文(如业务规则)。它可能生成一个逻辑上正确的解决方案,但实际上并不能解决真正的问题,因为细微差别在翻译中丢失了。

一个结合这些的好例子场景:想象一下在 Rust(系统级、性能关键)中开发一个新的 3D 图形引擎(复杂系统)。你有用于渲染的新颖算法(独特问题)。AI 可能能帮助编写一些样板代码,但核心部分你主要依赖人类的创造力。AI 可能会帮你开始设置窗口和基本的渲染循环(常见任务),但对于定制部分,你需要采用传统的仔细编码方式,也许可以从 AI 那里以伪代码的形式获得一些算法帮助。如果你让它优化汇编语言中的热循环,你必须验证每一条指令。

AI 也缺乏真正的问题解决洞察力。归根结底,它是模式匹配。所以如果你的问题需要一个恍然大悟的洞察,AI 可能只会四处摸索,呈现看起来像代码但并不能解决问题的东西。这时人类退一步、抽象思考或借鉴真实经验就能挽救局面。一旦你有了洞察,你就可以使用 AI 快速实现它。

理解这些优势和劣势可以确保你在正确的情况下部署氛围编码(vibe-coding)技术。为了最大化成功,利用 AI 擅长的方面(已知模式),并将你的创造力应用于应用程序的独特部分。准备好在 AI 已知会遇到困难的领域进行干预。例如,仔细审查它编写的任何安全敏感代码,因为它可能会遗漏一两个边缘情况。

使用 AI 来补充人类优势:让它处理广度(大量代码、样板代码),而你处理深度(复杂逻辑、架构)。在它擅长的地方将其作为助推器使用,不要害怕在那些更艰难的路段接管方向盘。这既发挥了双方的优势,又产生了最佳结果。知道何时使用 AI 以及何时依靠人类技能,将使你在这个新时代成为一名高效的开发人员。

每一项新技术都有其优势和注意事项。当我们拥抱 AI 辅助开发带来的生产力和创造力提升时,重要的是以细微差别的理解来对待它的局限性和权衡。主要优势包括:

: 项目可以更快地从概念到原型到成品。AI 可以快速生成脚手架代码(如为新项目设置样板代码),因此你可以将更多时间花在应用程序的独特部分上。

: 因为尝试某件事的成本更低(只需向 AI 描述你想要什么并获得快速草稿),开发人员可能会更自由地进行实验。你可以通过以不同方式提示 AI 来原型化问题的多种方法,然后选择最好的一个。这种迭代构思可以带来更具创造性的解决方案。

: LLMs 是在大量编程知识语料库上训练的。它通常”知道”晦涩的 API 或错误消息解决方案。实际上,它可以呈现你可能没有想到的解决方案或想法,使你成为更有效的问题解决者。

: 在团队环境中,AI 助手可以通过生成一致风格的代码来帮助执行编码标准和最佳实践。如果配置了你项目的风格指南,它可以确保每个人的代码遵循类似的模式。即使没有明确的训练,AI 模型通常也会产生惯用代码(因为它们从数百万个示例中学习)。这可以减少代码审查所涉及的工作量,因为它的函数可能看起来很熟悉并且默认遵守常见约定。

需要考虑的一些局限性和权衡包括:

: 这些模型并非万无一失。它们可能会生成看起来正确但有细微错误或低效的代码。它们可能会选择过时的方法,因为它们的训练数据包含了大量较旧的代码。作为开发人员,你必须保持警惕。就像你不会在不理解的情况下从互联网复制粘贴代码一样,你也不应该不假思索地接受 AI 代码。本书的[第二部分]将讨论彻底验证和测试 AI 生成代码的技术。

如果你的提示不够明确,AI 必须猜测你的意图——而它可能猜错。例如,如果你告诉它”对名字列表进行排序”,它可能默认按字母顺序排序,但也许你想要的是其他方式(比如按名字长度排序)。除非你明确说明,否则 AI 无法知道这种差异。这就是为什么提示的明确性([第2章]的主题)至关重要——你需要学会预见哪些细节需要明确说明。

如果新开发人员总是依赖 AI 来编写代码,他们是否还能形成对算法和调试的深入理解?这存在技能退化的风险,类似于依赖 GPS 导航可能会削弱你自己的方向感。为缓解这一问题,重要的是将 AI 作为学习工具使用(关注它提供的代码并询问原因),有时还要在不使用 AI 的情况下练习编码,以确保保留基本技能。

使用基于云的 AI 编码工具通常意味着将你的代码(可能是专有或敏感的)发送到第三方服务进行分析。公司需要考虑这一点。许多工具正在通过允许本地部署模型或保证不存储代码来解决这个问题,但这仍然是一个需要考虑的因素。此外,AI 可能会无意中生成与其训练数据中某些内容非常相似的代码,而这些代码可能受开源许可证(如 GPL)约束。虽然这种情况不太可能(并且已有措施防止逐字输出长内容),但这强调了在集成之前需要审查和理解 AI 产出的必要性。[第8章]深入探讨安全性和可靠性问题。

AI

模型可能反映其训练数据中存在的偏见。在编码环境中,这可能像偏好某些变量名这样无害,也可能像使用假设特定用户属性的示例这样重要。例如,它可能在每个示例变量中都使用

foo/bar(因为许多示例都这样做),或者它可能对用户区域设置做出假设。与其他

AI

应用相比,这在代码生成中通常不是一个大问题,但值得注意这种可能性。更微妙的是,AI

可能偏向于它更常见到的解决方案,即使这些方案不是最适合你的情况。[第9章]讨论偏见和其他道德考量。

并非所有开发人员都能立即适应这种工作方式。编码有其独特的乐趣和艺术性,有些人可能觉得 AI 的介入削弱了这一点。还可能存在最初的不信任——“它真的做对了吗?”——只有良好的实践和时间才能克服。采用 AI 的团队应该允许一段适应期,并鼓励分享经验和技巧。随着时间推移,就像对待任何工具一样,大多数人会找到一个平衡点,在这个平衡点上 AI 的贡献得到重视,人类专业知识则专注于人类最擅长的领域。

转向意图编程的氛围转变为加快软件开发、提高可访问性以及在许多方面使开发更愉快提供了巨大潜力。但要实现这一潜力,需要理解新的动态:如何有效地与 AI 沟通、如何验证其输出,以及如何负责任地将其整合到开发流程中。

我的观点基于使用这些工具的经验和观察众多项目得出,即 AI 的最佳用途在于将创造性的”氛围”与扎实的工程规范相结合。鼓励 AI 能够提供的大胆想法和快速草稿——这些是我们掌握的新超能力。但要用软件开发数十年积累的智慧来引导它们:规划、测试和理解你所构建内容的重要性。

当我们取得这种平衡时,我们就能获得两全其美的效果。我们可以更快、可能更富想象力地构建软件,同时也是我们信任、维护并充满信心发展的软件。这最终就是我们如何在 AI 时代提升我们的技艺:不是在氛围与工程之间二选一,而是掌握两者之间的整个光谱。

接下来,[第2章]探讨制作提示和与 AI 协作的艺术。有了本章的基础概念,你已经准备好探索这个新编程时代的实践方面。这将为后续章节中的实践示例和更深入的提示技术奠定基础。

在vibe coding中,提示词(prompt)就是新的源代码。

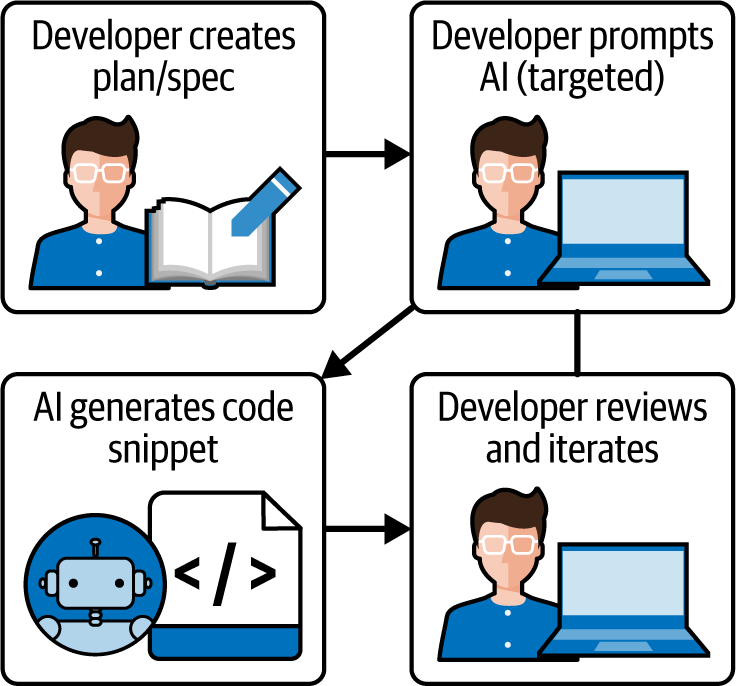

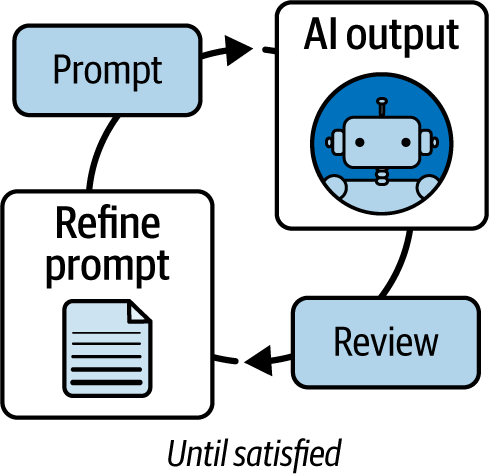

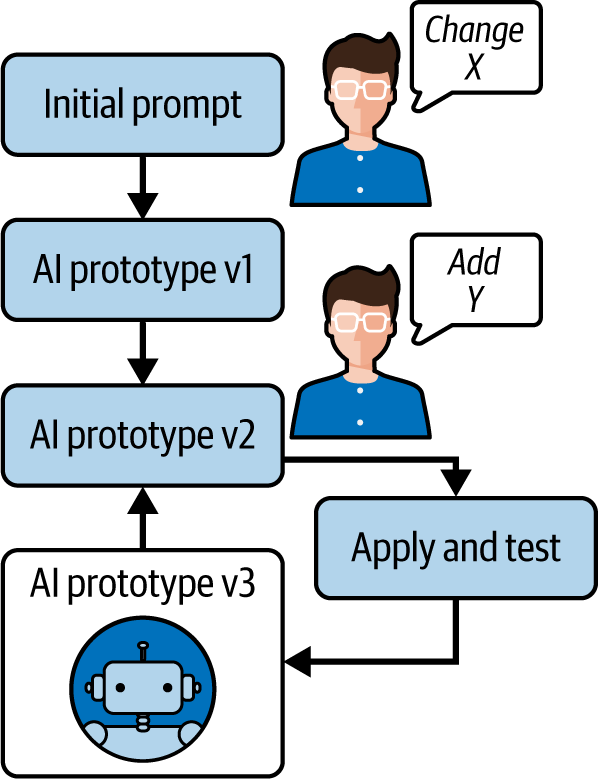

你向AI传达意图的方式直接影响它生成代码的质量。编写好的提示词既是艺术也是科学,通常被称为提示词工程(prompt engineering)。本章将为你提供一些技巧,帮助你充分利用AI编程助手。我们将从提示词为何重要的基本原理开始,然后深入探讨从简单到高级的提示词技巧工具箱。通过学习如何编写有效的提示词以及如何迭代优化它们(图2-1),你将能够更高效、更准确地与AI协同创作。

如果说vibe coding是你与AI模型之间的对话,那么提示词工程(prompt engineering)就是掌握AI语言以获得最佳结果的技能。精心设计的提示词可以决定AI是给出不相关或有bug的代码建议,还是完美的解决方案。掌握提示词工程意味着理解如何有效引导AI、如何提供上下文,以及当第一次回答不够理想时如何与AI迭代。

当你使用AI编程时,本质上是通过AI使用自然语言进行编程。你提供的提示词就像一种高级编程语言,AI解释器随后将其转换为实际代码。就像编译器的输出质量取决于输入的源代码质量一样,AI的输出质量也取决于提示词的质量。

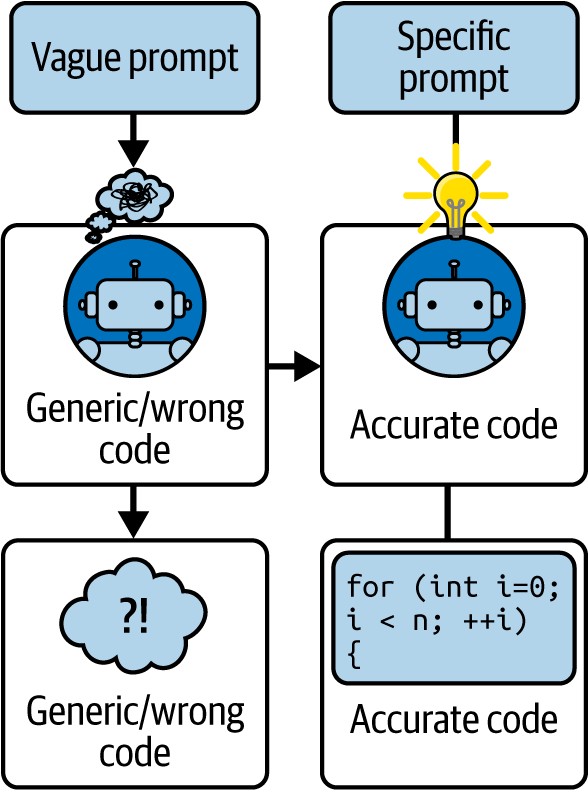

为什么提示词如此重要?尽管LLM(大型语言模型)非常复杂,但它们并不能读心。它们只对给定的输入做出响应。模糊或措辞不当的提示词可能导致不相关或不正确的代码,而清晰且具体的提示词可以在第一次尝试时就产生精准的解决方案。在传统编程中,你花时间思考算法和编写代码;在vibe coding中,你花时间思考如何向AI传达你的需求。这是”编写代码”含义的转变:你可能会写一段话而不是一个函数,但你仍然需要精确和符合逻辑。

可以把编写提示词想象成为一个非常字面化和迂腐的初级开发者编写文档或用户故事,这个开发者会完全(且仅仅)按照文档所说的去做,拥有大量知识但除了他们见过的模式之外没有常识。如果你的指令(提示词)留有解释空间,AI可能会以你意想不到的方式填补空白。因此,学会与AI沟通与学习编程语言的语法一样重要。

提示词至关重要的另一个原因是可重现性和面向未来。如果你发现一个提示词能够可靠地为某个特定模式或任务生成良好的代码,那么这个提示词就成为一项有价值的知识(几乎像代码片段或模板)。你可能会保存它或在类似的上下文中重用它。在团队中,开发者可能会相互分享有效的提示词模式,就像他们分享编程最佳实践一样。

最后,随着模型变得更好、集成度更高,它们可能允许更复杂的交互。擅长提示词编写将使你能够快速利用新功能。例如,一些高级系统允许你附加详细的指令或提供整个参考文档作为模型上下文的一部分。知道如何构建这种输入是充分利用这种能力的关键。

因此,将提示词编写视为一项新的基本技能。在很多方面,提示词编写就是编程。主要区别在于你用AI随后转换为代码的语言(如英语)编写。但你仍然必须清晰、符合逻辑,并在描述中预见边界情况。

提示词编写的黄金法则之一(我将在第3章更全面地阐述)是对你想要的内容要具体和清晰。与人类协作者不同,AI并不会真正理解你提供的文字之外的目标。一个常见的错误是给AI一个非常高层次的提示词,比如”做一个网站”,然后期待奇迹发生。AI在具体细节下工作得更好。

始终假设它对你的项目一无所知,除非你提供相关信息。包含相关细节,如编程语言、框架和库,以及所涉及的具体函数或代码片段。如果有错误,提供确切的错误消息并描述代码应该做什么。任何模糊或可解释的空间都可能导致意外的输出。

例如,不要说”编写一个排序函数”,而应该说:

编写一个Python函数sort_by_lastname(customers),接收一个客户记录列表(每条记录包含first_name和last_name字段),返回按last_name字母顺序排序的列表。包含简要的文档字符串(docstring),并通过将缺失的last_name视为空字符串来处理这种情况。

这个提示词明确了语言(Python)、函数名称和用途、输入结构、排序键、附加要求(文档字符串)以及边界情况。它很可能产生你所需要的结果,或者非常接近。本质上,要像规格说明书编写者那样思考:你对任务的规格说明越精确,AI需要猜测的就越少,你需要修改的次数也就越少。

提高具体性的策略包括:

如果你想要JavaScript的解决方案,明确说明:“编写一个JavaScript函数…”,而不是仅仅说”编写一个函数…“。如果你想要特定框架或版本的代码,包含这些信息(”使用React Hooks…“或”在Python 3中…“)。

你只想要一个函数吗?一个完整的文件或模块?包含测试吗?例如,“仅提供函数实现”和”提供一个完整的可运行脚本”会产生不同的响应。

在登录示例中,我们指定了密码长度和尝试次数限制。考虑边界情况或约束条件并将它们放入提示词中。如果你需要代码针对性能优化或使用特定算法,请说明:“使用O(n)时间和O(1)空间”或”使用二分搜索方法”。

不要在没有明确前置词的情况下使用像它这样的词。不要说”处理它并返回结果”,而应该说”处理数组并返回结果数组”。

如果你希望AI仅输出代码、带注释的代码或包含解释的代码,你可以明确指示:“仅提供代码,不要解释”或”提供代码和每个步骤的简要注释”。

清晰的提示词为AI的成功奠定基础。如果你发现AI的答案经常需要大量修正,检查一下你的提示词是否可能规格说明不足。

以下是不应该做的:

包含无关信息的冗长提示词可能会混淆模型或导致它关注错误的内容。在描述中做到简洁但完整。例如,在编码环境中通常不需要以”你是一位世界级的程序员…“作为开头(有些人在一般的ChatGPT使用中会这样做,但对于编码任务,这通常是不必要的,可能会增加噪音)。

如果某些内容很重要(如线程安全、特殊字符的处理等),请提及它。如果没有提及,假设AI可能不会处理它。

例如,说”编写一些代码来分析数据”可能会导致AI猜测你想要什么分析。相反,应该明确指定:

计算一个数字列表的平均值和标准差。

总之,准确表达你的意思。AI对你真正想要的内容”了解”得越多,它就能提供越好的结果。如果你发现自己必须多次纠正AI,问问自己:我的初始提示词是否可以更清晰?

即使有清晰的提示词,你也不会总是第一次就得到完美的答案。将与AI的交互视为对话或迭代开发过程。这就是我在第1章中提到的反馈循环。

当AI给你代码时,像审查人类编写的代码一样批判性地审查它。它是否满足要求?如果不满足,找出缺少或错误的地方。然后提供反馈或优化后的提示词。这可以在对话式AI中通过简单地继续对话来完成,或者在编辑器中通过编写另一条注释让AI响应来完成。

通过向AI提供反馈,你可以引导它更接近你期望的结果。从某种意义上说,你正在针对你的具体问题即时训练它。高级提示工程就像图2-2中的循环:提示 → AI输出 → 审查 → 改进提示 → AI输出 →…直到满意为止。保持每次迭代的改动较小是有用的;如果你过度改动提示,可能会丢失上一次输出中的一些好的部分。

例如,你可以提示:

编写一个函数,接收一个整数列表并返回它们的总和。

AI随后返回一个函数,但它的代码假设列表非空,并且没有很好地处理空列表。然后你可以回复:

看起来不错。但是,请修改它以在列表为空时返回0。

AI会相应地更新函数。这样,你不必从头开始提示;你只是告诉AI做一个调整。AI已经有了它之前给出的代码的上下文。

如果你使用的是内联助手(inline

assistant),改进可能看起来像编辑代码,也许写一个注释如# TODO: handle empty list,然后看AI是否建议修复。

另一种改进方法是,如果第一次输出不正确,用更多信息重新提示。假设你说”对名字列表进行排序”,它给出了区分大小写排序的代码,但你想要不区分大小写。你可以重新表述:

对名字列表进行不区分大小写的排序。

或者甚至:

之前的代码是区分大小写排序的。修改它为不区分大小写。

在调试中,对于更复杂的逻辑错误(没有明显的错误消息抛出但输出错误),你可以提示AI逐步执行代码。例如:

逐行执行这个函数,跟踪每一步total的值。它没有正确累加—逻辑在哪里出错了?

这是一个”橡皮鸭”调试提示的例子:你实际上是在要求AI模拟人类可能用打印或调试器进行的调试过程。这样的提示通常会揭示微妙的问题,如变量未重置或错误的条件逻辑,因为AI会详细说明每一步的状态。如果你怀疑代码的某个特定部分,你可以聚焦:

解释这里的filter调用在做什么,以及它是否可能排除了比应该排除的更多项目。

让AI扮演解释角色可以在解释过程中暴露错误。

在解释之后,直接要求你需要的内容通常是有效的:

可能是什么导致了这个问题,我该如何修复它?

这邀请AI既诊断又提出解决方案。如果AI的第一个答案不清楚或部分有帮助,不要犹豫提出后续问题:

那个解释说得通。你能展示如何修复代码吗?请提供修正后的代码。

在聊天环境中,AI有对话历史,所以它可以直接输出修改后的代码。如果你使用的是像VSCode中的Copilot或Cursor这样的内联工具而没有聊天,你可以在代码上方写一个注释:

// BUG: 返回NaN,修复这个函数并看它如何自动完成不过一般来说,交互式聊天能产生更全面的解释。

另一种后续模式:如果AI给出了修复但你不理解为什么,询问:

你能解释为什么那个改动解决了问题吗?

这样,你为下次学习,并且你再次确认AI的推理是合理的。

LLM在示例和修正中蓬勃发展。如果你指出什么是错的或给出一个快速示例,AI可以将其纳入:

如果输入是[],它应该返回0,但现在它报错了。

这个迭代过程是正常的。事实上,试图将每个细节塞进一个提示可能不如几轮来回交流有效。利用这一点来发挥你的优势。

在反馈中要有耐心和具体。不要说”不,那是错的”,而是说什么是错的或需要什么:

这段代码没有正确处理负数。它应该在求和时将它们视为0。

另外,如果AI偏离方向,你可以引导它回来:有时重置或重新表述比试图挽救一个完全错误的尝试更容易。运用你的判断。如果AI输出显示它完全误解了你,从头澄清你的提示。

在改进过程中,你也会了解AI如何解释你的提示。这可以告诉你如何编写未来的提示。你可能会意识到,“哦,它把’登录系统’理解为整个UI。下次我会指定仅后端。”

把它想象成调试代码:如果AI输出错误,“bug”可能在你的提示中,而不在AI的处理中。就像当你的代码产生不正确的结果时你会检查和修复它一样,当AI生成意外或不正确的输出时,你应该改进你的提示。你和AI之间的对话就像一个调试会话,每次交流都帮助你确定和修复问题。

假设你有一个简单的 Node.js 函数,用于将用户对象列表转换为按用户 ID 索引的查找映射。然而,它抛出了一个错误。以下是有问题的代码:

// 有bug的函数: 将用户数组转换为按ID索引的映射

function mapUsersById(users) {

const userMap = {};

for (let i = 0; i <= users.length; i++) {

// 注意: 使用 <= 会在最后一次迭代时越界

const user = users[i];

userMap[user.id] = user;

}

return userMap;

}

// 使用示例:

const result = mapUsersById([{ id: 1, name: "Alice" }]);这段代码应该遍历用户数组并构建一个对象,其中键是用户

ID。然而,这里有一个 bug:循环使用了 i <= users.length

而不是 i < users.length。这将导致 users[i]

在最后一次迭代时变为 undefined,很可能导致运行时错误(比如尝试访问

undefined 的 ID 属性)。让我们看看 AI

助手对于这个问题的两种不同提示词会如何响应(见图 2-3)。

以下是一个糟糕提示词的示例:

为什么我的 mapUsersById 函数不工作?

AI 对糟糕提示词的响应(模拟):

没有更多信息很难说。你确定函数调用时传入的是正确的用户数组吗?也许问题在于 users 是空的或者不是数组,导致循环无法正确执行。也可能是在 userMap 上设置属性时出现了错误。确保每个用户都有 id 属性。如果 users 是 undefined 或 null,那也会导致它不工作。

这个回答相当模糊。提示词除了函数名之外没有给出任何细节,所以 AI 只能猜测一些通用原因(“也许数组是空的或不是数组”,“确保每个用户都有 ID”)。它没有识别出实际的 bug。

这就是当问题描述不够具体时得到的响应类型——模型只能重复一些常见的调试技巧。如果你是开发者,这并不太有帮助,因为它没有解决真正的错误。提示词中缺乏上下文和具体性导致了一个通用的答案:本质上是 AI 版本的”你试过重启了吗?“这印证了社区的建议:模糊的提示词会导致不相关或通用的答案。

让我们再试一次:

我有一个 JavaScript 函数

mapUsersById,它应该将用户对象数组转换为按用户 ID 作为键的映射(对象)。然而,当我运行它时会抛出错误。例如,当我传入[ {id: 1, name: "Alice"} ]时,我得到TypeError: Cannot read property 'id' of undefined。以下是函数代码:function mapUsersById(users) { const userMap = {}; for (let i = 0; i <= users.length; i++) { const user = users[i]; userMap[user.id] = user; } return userMap; }它应该返回

{ "1": {id: 1, name: "Alice"} }。bug 是什么,我该如何修复它?

AI 对改进提示词的响应(模拟):

错误 Cannot read property

'id'of undefined 表明在某个时刻,user 是 undefined,然后你尝试访问 user.id。查看你的循环,问题出在循环边界上。你使用了i <= users.length。如果users.length是1(数组中有一个用户),循环会在i = 0和i = 1时运行。当i是1时,users[1]是 undefined(因为数组中唯一的索引是 0)。因此 user 在那次迭代中变成 undefined,user.id抛出TypeError。修复方法是将循环条件改为i < users.length,这样i从0到users.length-1。例如:for (let i = 0; i < users.length; i++) { const user = users[i]; userMap[user.id] = user; }这样,

i对于第一个(也是唯一的)元素将是0,然后循环停止。通过这个改变,你的函数将不再遇到 undefined 的 user,应该能按预期工作,对于给定的输入返回{"1": {id: 1, name: "Alice"}}。

这个响应直接指出了 bug(在循环中使用了

<=)并解释了为什么它会导致 user 变为

undefined。然后它提供了正确的代码解决方案(i < users.length)并确认了预期的结果。改进的提示词之所以成功,是因为它遵循了我们的原则:它指定了语言(JavaScript),描述了函数的目的,包含了确切的错误消息和示例输入,甚至提供了有问题的代码片段。

注意AI如何利用错误信息作为线索,将重点放在循环边界上——有针对性的提示使AI能够进行真正的问题解决,有效地模拟人类调试者的思考方式:“undefined可能从哪里来?很可能来自循环索引。”这具体展示了详细提示的好处。

现在让我们深入了解一些可以增强你提示技能的具体技术。这些就像你在直接指令不够用,或者想以特定方式引导AI时可以使用的模式或配方。

通过掌握这些技术,你可以处理一系列情况:用简单的英语指导AI、给它举例、让它解释或构建输出、或将其设置为不同的思维模式或角色。所有这些都有助于你引导AI准确生成你需要的内容。

提示技术并不相互排斥;你通常会将几种技术结合使用以获得最佳结果,特别是在复杂任务上。

当你使用这些技术时,要根据模型调整你的语气。许多模型对礼貌或中性的指令响应良好。你不需要使用古老或过于正式的语言。直接但礼貌通常有效:“请执行X”或”让我们做Y。“例如,在链式思考(CoT)提示中,一个流行的短语是”让我们一步步思考。“像GPT-4这样的模型会将其识别为显示推理的提示。

零样本提示只是在不提供任何示例或额外指导的情况下,要求模型做某事,只提供指令。本质上,模型是从”零”个示例中解决任务。

何时使用:这是最常见的场景:你只是用简单的语言要求你想要的东西。如果任务是标准的并且提示清晰,这通常就足够了。

示例:

编写一个检查数字是否为质数的Python函数。

这是零样本。AI很可能会使用循环或试除法生成一个质数检查函数。

优点:快速且依赖于模型的学习知识。现代模型在许多编程任务的零样本响应方面表现出人意料地好,特别是如果它们很常见(如质数检查、排序或字符串操作)。

缺点:如果任务不寻常或输出格式很具体,零样本可能在第一次尝试时产生不太符合你需要的结果,因为模型可能有多种解释方式。

通常,对于简单的事情,首先尝试零样本是个好主意。如果结果不对,你可以转向改进或其他技术。

单样本提示意味着你提供恰好一个你想要的示例(输入和期望输出)作为提示的一部分;少样本提示意味着在要求模型对新输入执行任务之前提供几个示例(通常是两到五个)。

这就像向模型展示,“这是我如何解决一个实例的。现在你用类似的方法做下一个。”

何时使用:当模型可能不确切知道你需要的格式或风格,或者当任务有点不寻常时,这种类型的提示很有用。通过给出示例,你减少了歧义。

示例(单样本):假设你正在使用模型可能不太常见的语言或某种特定风格。假设你想要特定格式的伪代码。你的提示可能是:

将以下英文指令转换为类似Python的伪代码。

示例指令:“计算n的阶乘”:

示例伪代码:

function factorial(n):

if n <= 1:

return 1

else:

return n * factorial(n-1)

指令:"在列表中查找最大的数"

伪代码:你提供了一个示例(阶乘)和你想要的格式。现在模型更有可能以类似的格式为”最大数”指令生成伪代码(带有函数,带有if/else或根据需要的循环逻辑)。

示例(少样本):假设你想让AI使用特定的算法。你可以给它一个该算法实际运行的较小示例作为提示。或者如果任务有多个正确答案但你更喜欢某一个,示例可以将其推向那个方向。

少样本提示对于格式化非常强大;例如:

将以下英文语句转换为SQL查询。 1.”获取2020年后雇用的所有员工” → SELECT * FROM Employees WHERE Hire_Date > ‘2020-01-01’; 2. “列出上个月购买过商品的客户姓名” → SELECT Name FROM Customers JOIN Purchases ON … WHERE Purchase_Date > …; 3. “缺货产品的数量” →

这里,一旦你给出两个英语到SQL的示例,AI就可能通过遵循这个模式正确回答第三个查询。少样本示例(few-shot examples)也可以应用于编码:向AI展示你想要的风格的小样本,然后要求更多。这就像在你的提示词(prompt)中给它一个迷你训练数据集。

优点: 你可以实现非常特定风格的输出。这种技术还帮助模型处理涉及遵循模式或重复应用概念的任务。

上下文窗口(context window)这个术语指的是语言模型在单次交互中可以处理的最大文本量(以token计量),包括输入提示词和生成的响应。这代表了当前AI模型的一个限制——一旦你达到这个阈值,模型就无法处理额外的信息。当你在制作提示词时,你包含的所有内容(指令、示例、数据和响应所需的空间)都必须适应这个固定容量。

缺点: 特别是少样本提示会使提示词变长(这会占用上下文窗口)。对于非常大/复杂的示例,它可能会”吃掉”模型的大量容量。但通常一两个小示例是可以的。

提示: 如果你想让模型严格遵守某个输出结构,给出一个示例几乎可以保证它匹配该结构,而不是提供一个你必须解析的自由形式回复。

思维链(Chain-of-thought, CoT)提示涉及要求模型在给出最终答案之前逐步思考或展示其推理过程。换句话说,你鼓励模型分解问题。

何时使用: 这对涉及推理和多步计算的复杂问题很有用,或者当你怀疑模型如果直接跳到答案可能会犯错时。当你想要在输出中获得解释时也很有用。

组合数学(Combinatorial math)处理根据特定规则或约束对对象进行计数、排列和选择。常见问题包括计算排列(permutations)(顺序重要的排列)、组合(combinations)(顺序不重要的选择)和其他计数原理。关键符号包括”n选k”(写作C(n,k)或nCk),表示从n个总项目中选择k个项目的方式数量,使用公式n!/(k!(n-k)!)计算。这些计算经常出现在概率、统计和离散数学应用中。

示例: 与其只是问一个组合数学问题,比如”12选4是多少?“并得到答案,你可以说:

逐步求解12选4。

模型可能会列出:

12选4 = 12!/(4!*8!) = ... = 495在编码中,思维链(CoT)对于棘手的算法任务很有用。你可以尝试以下提示:

逐步解释如何合并两个排序列表,然后提供Python代码。

模型首先会概述如下内容:

我们将使用两个指针从每个列表的头部开始,比较元素,将较小的元素追加到结果列表,并移动该指针,依此类推…

然后它可能会给出代码。这确保它在编码之前已经正确构建了解决方案。

另一个用途是调试或理解输出:

演示判断数字19是否为素数的逻辑,然后给出结果。

模型可能会列出被素数整除的情况,然后得出结论:

19是素数。

优点: 提高需要推理的任务的正确性。有研究证据表明,提示模型”大声思考”可以在数学和逻辑任务上获得更好的结果。它还让你深入了解模型的过程,这可以增强理解或帮助你更信任答案。

缺点: 输出更长(这可能不是你在最终代码中想要的)。此外,一些界面(如典型的代码补全)不适合单独显示推理。这种技术在问答或聊天场景中更常见。然而,你可以指示模型将推理作为注释包含在代码中,这是获得完整注释代码的一种巧妙方式。

角色提示(Role prompting)意味着你要求AI扮演某个可能影响其响应方式的特定身份或角色。

何时使用: 当你想影响答案的风格或细节程度,或获得某个特定视角时,这很有用。例如,扮演”专家”角色的AI可能会给出更高级的解决方案或更多解释,而”初学者”角色可能会让它解释更多基本概念。

示例:

你是一名 Python 教员。解释以下代码,然后将其修改为更符合 Python 风格的版本。

扮演一名安全分析师。这里有一些代码。识别任何安全漏洞。

假装你是一个检查代码风格问题的代码检查工具(linter)。

这可以显著影响响应结果。给 AI 分配安全分析师角色可能会让它关注那些原本不会提及的方面(如数据验证、安全编码实践或潜在漏洞)。教员角色可能会使其提供更清晰的解释,并且可能不会假设你有先验知识。

在编程中,你可能会在请求代码之前这样说:

你是一位精通优化的 C++ 专家程序员,正在指导一名初级开发者。

结果很可能会使用更高级的 C++ 特性,并解释为什么做出某些选择,在技术复杂性和教育清晰度之间取得平衡。

优点:这种技术可以引导答案的语气和深度。这可以将解决方案定制到特定的复杂程度或彻底性。如果你想要一个非常简单的解决方案(告诉它扮演新手,也许它会避免复杂的技巧),或者一个非常优化的解决方案(告诉它扮演性能大师),这很有用。

缺点:有时模型可能会过度关注角色而非必要(“教员”可能会开始解释你已经知道的事情)。此外,某些 AI 安全系统对某些角色描述更敏感——特别是那些可能暗示欺骗、冒充权威或潜在有害活动的描述——尽管像”数据分析师”或”软件工程师”这样直接的技术和专业角色通常不会出现问题。

上下文提示是指给 AI 提供超出直接任务描述之外的额外上下文或信息。AI 模型不会持久记忆你的整个项目,除非你在提示中提供(或通过高级 IDE 集成中的某些集成上下文窗口)。因此,如果你希望 AI 编写适合现有代码库的代码,就需要给它提供该上下文。基本上,你将相关数据或背景作为提示的一部分提供。

何时使用:当解决问题需要了解模型可能不知道或可能无法从训练中正确回忆起的某些数据或定义时使用。或者当你想确保与某些外部信息(如 API 规范或对话的先前部分)保持一致时使用。

示例:

如果你有一个数据结构并希望代码能够使用它,你可以粘贴其定义:

给定以下类,实现函数 X。

class Node:

def __init__(self, value, next=None):

self.value = value

self.next = next

# 现在编写一个函数来计算从 head 开始的链表中的节点数。通过包含类定义,你可以让 AI 更有可能在代码中正确使用

Node.value 和 Node.next。

如果你想使用特定的 API,在提示中包含文档片段:

使用 requests 库从 API 获取数据。(API 返回格式为 {…} 的 JSON)

如果你包含文档中 API 使用的简短示例,AI 可以模仿它。

用于消除歧义:

使用术语

student来指代高中学生,编写一个函数…

如果 student 在上下文中可能有歧义,你已经澄清了它。

优点:你将 AI 定位在你关心的上下文中。如果你提供事实,它就不太可能做出错误的假设。如果 AI 可能不记得或不知道你特定用例的详细信息,这非常有帮助。

缺点:这种技术会使提示变长。此外,模型可能偶尔会将提供的上下文重新输出到答案中(如果不小心,可能会将文档片段中的行复制到代码中)。但通常它会适当地使用它。

提示:如果你有大量上下文(如大型模式或多行代码),有时最好为模型总结关键元素,而不是逐字包含所有内容。这种方法可以帮助你保持在上下文限制内,同时确保模型接收到最相关的信息。然而,如果内容足够小,直接原样包含即可。

在上下文提示中提及约束(constraints)也很有用:性能约束(“优化到 O(n log n) 或更好”)、兼容性约束(“必须在 Python 3.8 上运行”)或库选择(“仅使用标准库,不使用外部依赖”)。这些就像护栏,确保 AI 不会建议超出可接受范围的内容。

元提示(Metaprompting) 是对输出本身给出指令,而不仅仅是解决方案应该做什么。这就像是告诉 AI 如何格式化或处理解决方案。

何时使用: 当您需要特定格式或风格的答案时,或者当您想控制 AI 解决问题的方式时很有用。

示例:

首先用两句话解释方法,然后提供代码。

这确保 AI 不会直接开始写代码:

解决方案中不要使用任何库。

这对解决方案施加了约束:

将输出格式化为 JSON。

如果您使用 AI 生成数据而不是代码,这很有用:

仅提供函数体,不包括定义行。

如果您想将函数插入现有代码,这很方便:

如果输入无效,不要返回错误,而是返回 None。

这不完全是输出格式,但它指示 AI 在某些情况下如何行为。

优点: 您可以准确地得到所需的内容,以您需要的方式,无需额外编辑。这对某些场景至关重要。如果您计划在流水线中自动使用 AI 的输出,那么您真的需要一致的格式。

缺点: 如果指令与模型的默认风格冲突,有时它可能只部分遵循,或者您必须强调它们。例如,即使您说”仅代码,无解释”,偶尔模型也可能包含一点注释之类的。通常,将其表述为直接命令会有所帮助:

不要包含任何解释;仅在单个代码块内输出代码。

像 GPT 这样的模型很好地遵循这一点。

自洽性(Self-Consistency) 更像是一种策略而不是提示风格。其思想是对同一提示获取多个输出,然后决定最佳或最常见的输出。正如 Learn Prompting 的 Sander Schulhoff 所指出的,自洽性利用了这样一个概念:如果您多次询问模型(带有轻微的随机性),并且它的许多答案一致,那么这种共识很可能是正确的。

何时使用: 这对于复杂问题很有用,当您不确定模型的第一个答案是否正确时,特别是如果您自己无法轻易验证它,或者如果您想通过查看它是否重复给出相同答案来从 AI 获得置信度检查。

如何手动使用: 在某些平台上(如 ChatGPT),您可以点击”重新生成答案”。或者您可以将提示复制到新会话中,看看它是否给出相同的结果。如果您得到三个答案,其中两个相同,一个不同,您可能会相信这两个(假设问题有一个正确答案)。

在编程上下文中,如果它为某个确定性任务生成代码,通常每次都会给出非常相似的代码(变量名或风格略有不同)。但如果这是一个算法问题(如”这段代码的输出是什么?“),您可以检查多次运行。

这种技术在非编码任务(如逻辑谜题)中更强大,但值得注意。

另一个角度——集成提示: 您实际上可以在一个提示中要求模型考虑多种可能性:

为这个问题提供两种不同的解决方案。

然后也许您可以看到您喜欢哪一个或测试两者。这就像是一次性的自洽性,因为您得到了多个答案。

优点: 如果多次尝试收敛,这种技术可以增加对解决方案的信心。此外,您可能会获得多样性(如果您想从许多方案中选择最优雅的解决方案,这很好)。

缺点: 进行多次调用并比较输出很耗时。

在实践中,如果我对答案不确定,我通常会以不同的方式重新提问,看看是否得到相同的答案。如果得到了,我会更有信心它是正确的。

ReAct 是一种更高级的提示技术,它结合了推理和行动。它使模型不仅像 CoT 那样思考,而且还采取行动,如进行计算、调用 API 或使用工具。(更多信息请参见 ReAct 提示工程指南)。在当前实践中,这通常与 LangChain 等框架一起使用,其中 AI 可以输出程序解释为操作的特殊格式(如要执行的命令或要运行的查询),然后将结果反馈回来。

对于我们的范围(没有这样的执行环境在循环中),您仍然可以通过指示 AI 首先概述计划,然后输出结果来进行一种形式的 ReAct。它类似于 CoT,但专门面向使用工具或执行子任务。

示例:

使用 Python,确定巴黎的当前天气并打印它。

除非AI具有浏览功能,否则它无法真正获取当前天气。ReAct方法会让AI首先通过陈述来推理问题:

我需要访问巴黎的当前天气数据,这需要调用天气API。

然后AI会尝试使用可用的工具来进行API调用。如果成功,它将收到实际的天气数据;如果没有这样的工具,它可能会承认局限性或使用假设数据。最后,AI会编写Python代码来显示天气信息,整合通过这个推理和行动过程获得的任何数据。

如果没有外部工具访问权限,ReAct对于简单的提示任务可能不太相关。然而,在为您的组织评估AI工具时,确定它们是否可以从互联网访问当前信息是一项关键的能力评估。许多AI模型的知识有截止日期,这意味着它们的训练数据只延伸到特定日期,这可能导致快速变化的主题信息过时。

如果您使用的环境中AI可以执行代码(例如Jupyter集成或类似平台),您可以通过指示系统来实现ReAct:

首先为这个函数编写一个测试,运行它,然后相应地调整代码。

这通过推理步骤(编写测试)、行动(执行测试)和基于结果调整代码来展示ReAct模式。然而,通过纯提示编排这样的工作流需要高级提示技术和适当的技术基础设施。

更简单的用法:您可以模拟一个问答,其中AI有模仿行动的中间步骤:

逐步思考,如果需要的话,进行计算。

这实际上是CoT,但语气更加命令式。

优点:当可用时,它可以解决需要外部信息或迭代试验的问题(例如AI可以通过实际运行代码来纠正自己)。在调试环境中,可以执行代码来测试的AI非常棒。

缺点:没有特定工具,这种技术不太容易获得。如果您只是在普通ChatGPT中这样提示,它要么会想象这些行动,要么只是执行CoT。

对于我们在提示编写中的目的,请记住,一些系统(如OpenAI的工具使用代理或其他系统)是存在的,但在普通提示中,我们主要执行CoT,我们自己处理诸如运行代码或测试之类的行动。

提示技术可以组合使用。例如,您可能会做一个少样本提示,同时在示例中演示CoT。或者您可能将角色与CoT结合起来:

作为一名高级工程师,逐步思考问题,然后给出代码。

现在我们已经探索了各种提示技术,让我们通过一两个场景来看看它们的实际应用,然后讨论如何审查和改进AI的输出(这将引入下一章关于理解和掌握生成代码的内容)。

想象一下您有一个无法正常工作的函数。您可以使用角色和CoT提示的组合:

您是一名Python调试器。让我们逐步思考以找到以下代码中的错误。

接下来是代码。AI可能会对每一行进行分析并精确定位错误。

或者假设您想为一个稍微复杂的算法生成代码,确保它有良好的注释,并且还要获得测试用例。组合提示可能如下所示:

您是一名专业的Python开发人员。让我们逐步解决这个问题。我们需要一个函数

merge_sorted_lists(list1, list2),它将两个排序列表合并为一个排序列表。首先,解释方法,然后提供带注释的Python代码。之后,给出2-3个代码示例测试来演示它的工作原理。

这个单一的提示相当全面。第一句设定了角色。第二句请求逐步推理。第三句给出主要任务。第四句要求提供带解释性注释的代码,第五句甚至要求测试。

AI随后可能会输出一个解释,然后是带内联注释的代码,最后是一些测试用例。这是一个高级用法,但它显示了您如何通过多方面的响应来指导AI。

提示工程(Prompt Engineering)还涉及到知道什么不该问以及如何避免陷阱。如果提示变得太大或包含太多指令,模型可能会感到困惑或截断某些输出。如果你发现它开始忽略提示的某些部分,你可能需要简化或分部分进行。如果AI模型有时会产生不正确的事实或代码(它会”产生幻觉(hallucinate)“),你要学会仔细检查,不要将其作为事实的权威来源。如果你发现它倾向于给出过于冗长的代码,你可以预先用”使解决方案尽可能简洁”来防止。如果它有时使用不存在的函数,你可以指示”仅使用下面列出的API函数”并列出它们。你越了解AI的行为,就越能塑造你的提示以规避任何弱点。

如果任务非常复杂,你也可以将其分解为子任务让AI处理。例如,你可以首先提示:

列出为简单算术表达式语言实现基本编译器的步骤。

一旦AI给出步骤,你就用单独的提示来处理每个步骤,甚至可能在单独的文件或会话中:

现在实现步骤1:词法分析(tokenization)。

这就像与AI进行系统设计:你可以先概述然后细化每个部分。它利用了AI在规划方面的能力(不仅仅是编码)。

在聊天环境中,你有对话历史,称为状态(state)。你可以通过与AI讨论来建立上下文。在IDE补全环境中,上下文主要是你的文件内容和注释。两者都以不同的方式允许累积上下文。如果你需要AI记住所说的内容(比如优化答案),使用对话。如果你想确保它只关注现在相关的内容,使用新的提示或文件上下文。有时清除上下文可以防止模型坚持可能错误的早期假设。

通过在各种示例上练习这些技术,你将熟练掌握何时使用哪种方法:

如果输出格式很重要,给出示例(few shot)或明确的格式指令。

如果逻辑很复杂,使用思维链(CoT)或逐步分解。

如果解决方案的质量可能有所不同,设置角色(如”资深工程师”)以获得更好的风格。

如果模型不配合,也许将提示分成几部分,简化它们,或对约束使用更强硬的措辞。

并非所有提示都是平等的。到目前为止,我们已经看到许多有效提示的例子,但同样有益的是识别反模式(antipattern)——导致AI回复不佳的常见错误。本节涵盖一些常见的提示失败案例以及如何修复它们。

这是经典的”它不工作,请修复它”或”写点做X的东西”而没有足够细节。“为什么我的函数不工作?”这样的问题通常会得到无用的答案。模糊的提示迫使AI猜测上下文,通常会导致通用建议或不相关的代码。

修复方法很简单:添加上下文和具体信息。如果你发现自己提出问题后得到的答案感觉像魔术8球的回应(“你试过检查X吗?”),停下来并用更多细节重新构建你的查询(错误消息、代码摘录、期望与实际结果等)。一个好的做法是阅读你的提示并问:“这个问题是否适用于数十种不同的场景?”如果答案是肯定的,那就太模糊了。让它具体到只能适用于你的场景。

这是相反的问题:一次要求AI做太多事情。例如:

生成一个完整的Node.js应用,包含身份验证、React前端和部署脚本。

或者,在较小的规模上:

一次性修复这5个bug并添加这3个功能。

AI 可能会尝试处理,但你很可能得到混乱或不完整的结果,或者它可能会忽略请求的某些部分。即使它处理了所有内容,响应也会很长且更难验证。

解决办法是拆分任务。优先处理:一次做一件事,正如我们之前强调的那样。这样更容易发现错误并确保模型保持专注。如果你发现自己写的指令段落中多次使用”和”,考虑将其分解为单独的提示词或顺序步骤。

有时用户会提供大量信息但从未明确提出问题或说明他们需要什么,比如只是转储一大段代码片段并说”这是我的代码”。这可能会让 AI 困惑——它不知道你想要什么。

始终包含明确的要求:

识别上述代码中的任何错误。

解释这段代码的作用。

完成代码中的待办事项。

提示词应该有明确的目的。如果你只是提供文本而没有问题或指令,AI 可能会做出错误的假设(比如总结代码而不是修复它等)。确保 AI 知道你为什么向它展示某些代码。即使是简单的补充,如”这段代码有什么问题?“或”请继续实现这个函数”,都能给它方向。

这是一个微妙的问题。有时你可能会要求优化或改进,但没有定义成功的标准——例如,“让这个函数更快”。以什么指标衡量更快?如果 AI 不知道你的性能约束,它可能会微观优化一些无关紧要的东西,或者使用理论上更快但实际上可以忽略不计的方法。或者”让这段代码更清晰”:“更清晰”是主观的。我们通过明确说明目标来处理这个问题,比如”减少重复”或”改进变量名”等。

解决办法:量化或限定改进:

优化这个函数使其以线性时间运行(当前版本是二次时间)。

重构这段代码以移除全局变量并使用类。

基本上,明确说明你要通过重构或功能解决什么问题。如果你让它太开放,AI 可能会解决与你关心的问题不同的问题。

有时 AI 可能会用澄清性问题或假设来回应:

你使用的是 React 类组件(class component)还是函数组件(functional component)?

我假设输入是字符串——请确认。

如果你忽略这些并只是重申你的请求,你就错过了改进提示词的机会。AI 在发出信号表明它需要更多信息。始终回答它的问题或优化你的提示词以包含这些细节。

此外,如果 AI 的输出明显偏离(比如它误解了问题),不要只是逐字重试相同的提示词。花点时间调整你的措辞。也许你的提示词有一个模棱两可的短语或省略了一些关键内容。把它当作对话:如果一个人误解了,你会用不同的方式解释;对 AI 也这样做。

如果你不断改变提问方式或在一次提问中混合不同的格式,模型可能会感到困惑。两个例子包括在指令中在第一人称和第三人称之间切换,或以令人困惑的方式混合伪代码(pseudocode)和实际代码。

尝试在单个提示词中保持一致的风格。如果你提供示例,确保它们被清楚地划分(使用 Markdown 三个反引号标记代码,使用引号标记输入/输出示例等)。一致性有助于模型正确解析你的意图。此外,如果你有首选风格(比如 ES6 与 ES5 语法),请始终如一地提及它;否则,模型可能在一个提示词中建议一种方式,而在稍后建议另一种方式。

在使用聊天时,如果你说”上述函数”或”之前的输出”,请确保引用是清晰的。如果对话很长并且你说”重构上述代码”,AI 可能会失去跟踪或选择错误的代码片段进行重构。

在对话中再次引用代码或明确指定要重构的函数名会更安全。模型的注意力窗口是有限的,尽管许多大语言模型可以引用对话的早期部分,但再次给出明确的上下文可以帮助避免混淆。如果距离代码展示已经过去了一段时间(或若干条消息),这一点尤其重要。

提示的艺术是迭代的和创造性的。随着模型的演进,提示最佳实践可能会改变(例如,未来的模型可能在使用较少文字的情况下更好地理解意图)。但底层原则保持不变:有效沟通,AI就会更好地为你服务。

本质上,掌握提示工程就像掌握一门新的编程语言——与AI交互的指令语言。它是技术写作、前瞻性思维和对提示本身的交互式调试的结合。但一旦你擅长它,AI真的会开始感觉像是你自己思维的延伸,因为你可以以最小的摩擦可靠地提取出你设想的解决方案(甚至是那些你还没有完全设想但可以引导AI去发现的解决方案)。这项技能可能会变得和知道如何使用谷歌搜索或如何使用调试器一样基础——它是氛围编程时代现代开发者技能集的一部分。

如果AI可以解决大约70%的问题,你如何将它作为编程合作伙伴来对待?第三章探讨了开发者如何真正使用AI,并为氛围编程设定了一些”黄金规则”。

基于AI的编程工具在某些任务上表现惊人地出色。它们擅长生成样板代码、编写常规函数,并将项目完成到大部分程度。事实上,许多开发者发现AI助手可以实现一个涵盖大约70%需求的初始解决方案。

Peter Yang在X平台的一篇帖子中完美地捕捉到了我在实践中观察到的情况:

作为非工程师使用AI编程的真实感受:

它可以让你完成70%的工作,但最后30%令人沮丧。它不断前进一步又后退两步,出现新的bug、问题等等。

如果我知道代码是如何工作的,我可能可以自己修复它。但由于我不知道,我质疑自己是否真的学到了什么。

非工程师使用AI编程时发现自己遇到了令人沮丧的瓶颈。他们可以惊人地快速完成70%的工作,但最后30%变成了一场收益递减的练习。

这个”70%问题”揭示了关于AI辅助开发当前状态的一些关键信息。最初的进展感觉很神奇:你可以描述你想要什么,v0或Bolt等AI工具会生成一个看起来令人印象深刻的工作原型。但随后现实出现了。

70%通常是工作中直接的、模式化的部分——遵循常规路径或通用框架的那类代码。正如一位Hacker News评论者观察到的,AI在处理软件的”偶然复杂性”(accidental complexity)(重复性的、机械性的东西)方面非常出色,而”本质复杂性”(essential complexity)——理解和管理问题的固有复杂性——仍然由人类承担。用Fred Brooks的经典术语来说,AI处理的是附带的而不是内在的开发困难。

这些工具在哪里遇到困难?经验丰富的工程师一致报告存在”最后一公里”的差距。AI可以生成一个看似合理的解决方案,但最后30%——覆盖边缘情况、改进架构和确保可维护性——“需要严肃的人类专业知识”。

例如,AI可能会给你一个在基本场景下技术上可行的函数,但除非明确告知,否则它不会自动考虑异常输入、竞态条件(race conditions)、性能约束或未来需求。AI可以让你完成大部分工作,但最后关键的30%(边缘情况、保持可维护性和稳固的架构)需要严肃的人类专业知识。

此外,AI有一个已知的倾向,即生成令人信服但不正确的输出。它可能引入微妙的bug或”幻觉”出不存在的函数和库。Steve Yegge讽刺地将当今的大语言模型比作”疯狂高产的初级开发者”——速度惊人且充满热情,但”可能受到改变思维的药物影响”,容易想出疯狂或不可行的方法。

用 Yegge 的话来说,大语言模型(LLM)可以生成乍看之下很精致的代码,但如果经验较少的开发者天真地说”看起来不错!“并直接使用它,接下来的几周就会出现荒谬(或灾难性)的结果。AI 并不真正理解问题;它只是将通常有意义的模式拼接在一起。只有人类才能辨别一个看似不错的解决方案是否隐藏着长期隐患。Simon Willison 也呼应了这一点,他看到 AI 提出了一个极具迷惑性的巧妙设计,但只有对问题有深刻理解的资深工程师才能识别出它的缺陷。教训是:AI 的自信远远超过了它的可靠性。

至关重要的是,当前的 AI 无法创造出超越其训练数据的全新抽象或策略。它们不会为你发明新颖的算法或创新的架构——它们只是重新组合已知的东西。它们也不会为决策承担责任。正如一位工程师指出的:“AI 没有比其训练数据所包含的’更好的想法’。它们不会为自己的工作负责。”

所有这些意味着创造性和分析性思维——决定构建什么、如何构建以及为什么构建——仍然牢牢属于人类领域。总之,AI 是开发者的力量倍增器(force multiplier),可以处理重复性的 70% 工作,为我们的生产力提供”涡轮增压”。但它不是可以取代人类判断的银弹(silver bullet)。软件工程剩余的 30%——困难的部分——仍然需要只有训练有素、思考周全的开发者才能带来的技能。这些才是需要重点关注的持久技能,[第 4 章]专门讨论这些内容。正如一个讨论所说:“AI 是一个强大的工具,但它不是魔法子弹……人类判断和良好的软件工程实践仍然至关重要。”

我观察到团队在利用 AI 进行开发时有两种不同的模式。我们称之为”引导者(bootstrappers)“和”迭代者(iterators)“。两者都在帮助工程师(甚至非技术用户)缩小从想法到执行(或 MVP)的差距。

首先是引导者,他们通常将新项目从零开始做到 MVP(最小可行产品)。像 Bolt、v0 和截图转代码 AI 这样的工具正在革新这些团队引导新项目的方式。这些团队通常:

结果可能令人印象深刻。我最近看到一位独立开发者使用 Bolt 在极短的时间内将 Figma 设计转换为可工作的 Web 应用。它还没有达到生产就绪状态,但已经足够获取最初的用户反馈了。

第二阵营是迭代者,他们在日常开发工作流程中使用 Cursor、Cline、Copilot 和 Windsurf 等工具。这不太引人注目,但可能更具变革性。这些开发者:

但问题在于:虽然这两种方法都可以显著加速开发,但它们都有一些不会立即显现的隐藏成本。

当你观看资深工程师使用 Cursor 或 Copilot 等 AI 工具工作时,看起来像魔术一样。他们可以在几分钟内搭建整个功能,包括测试和文档。但仔细观察,你会注意到一些关键的东西:他们不只是接受 AI 的建议。他们不断将生成的代码重构为更小、更专注的模块。他们添加 AI 遗漏的全面错误处理和边缘情况处理,加强其类型定义和接口,并质疑其架构决策。换句话说,他们正在应用多年艰苦获得的工程智慧来塑造和约束 AI 的输出。AI 正在加速他们的实现,但他们的专业知识才是使代码保持可维护性的关键。

初级工程师经常错过这些关键步骤。他们更容易接受 AI 的输出,导致我所说的”纸牌屋代码(house of cards code)“——看起来完整,但在现实世界的压力下会崩溃。

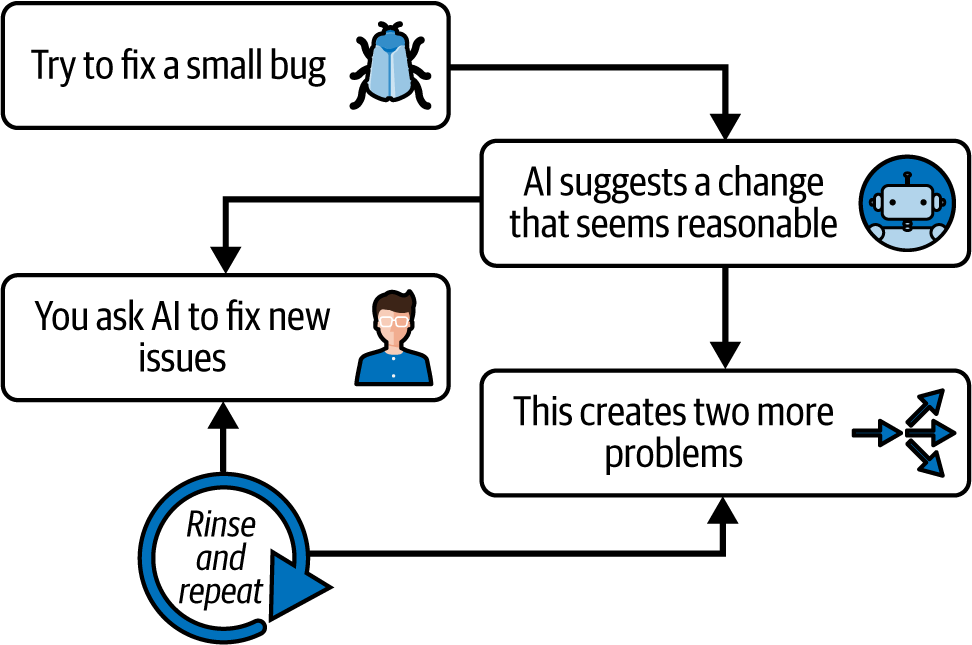

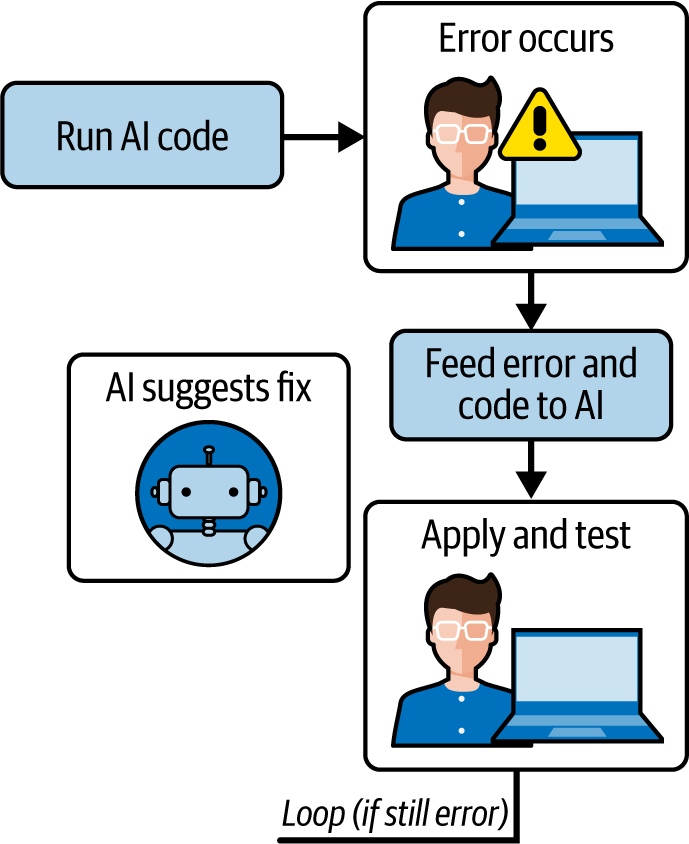

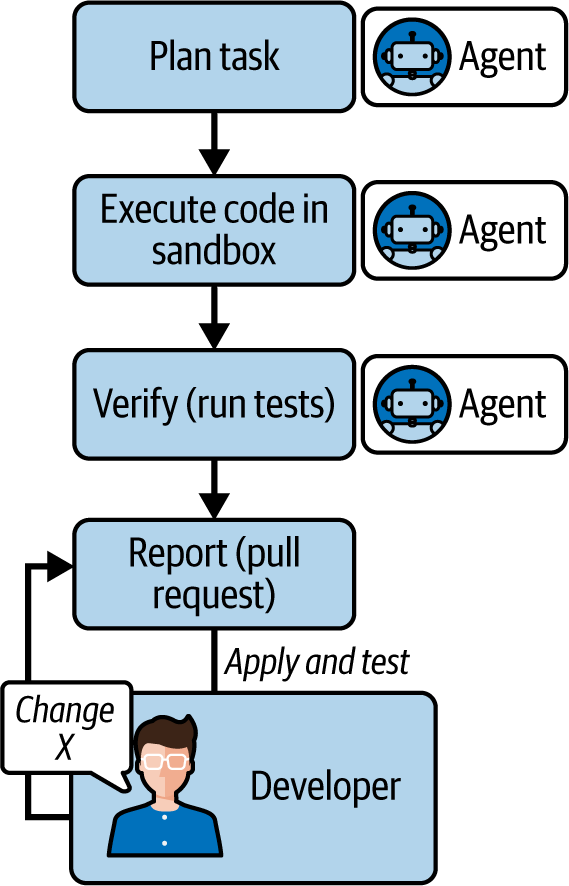

接下来通常发生的事情遵循我称之为”退两步(two steps back)“的可预测反模式(antipattern)(如图 3-1 所示):

你尝试修复一个小错误。

AI 建议一个看起来合理的更改。

这个修复破坏了其他东西。

你要求 AI 修复新问题。

这又产生了两个新问题。

不断重复这个过程。

对于非工程师来说,这种循环特别痛苦,因为他们缺乏理解实际出了什么问题所需的心智模型(mental models)。当经验丰富的开发者遇到 bug 时,他们可以基于多年的模式识别(pattern recognition)来推理潜在的原因和解决方案。如果没有这种背景知识,你基本上就是在玩打地鼠游戏,对付着你并不完全理解的代码。这就是我在本书前言中提到的”知识悖论(knowledge paradox)“:高级工程师和开发者使用 AI 来加速他们已经知道如何做的事情,而初学者试图用它来学习应该做什么。

对于使用 AI 的”自力更生者(bootstrapper)“模式的非工程师来说,这种循环特别痛苦,因为他们缺乏构建 MVP 时解决这些问题所需的心智模型。然而,即使是经验丰富的”迭代者(iterators)“,如果过度依赖 AI 建议而不进行深入验证,也可能陷入这种打地鼠陷阱。

这里有一个更深层次的问题:让 AI 编码工具对非工程师来说易于使用的特性——它们代表你处理复杂性的能力——实际上可能会阻碍学习。当代码”凭空出现”而你不理解底层原理时,你就无法培养调试技能。你会错过学习基本模式的机会。你无法对架构决策(architectural decisions)进行推理,因此你难以维护和演进代码。这会产生一种依赖关系,你需要不断回到 AI 模型来修复问题,而不是培养自己处理这些问题的专业能力。

随着自主 AI 编码代理(autonomous AI coding agents)的出现,这种依赖风险进入了一个新的维度——我将在[第10章]深入探讨这个主题。与当前建议代码片段的工具不同,这些代理代表了软件开发方式的根本转变。在我写这本书的时候,我们正在见证能够以最少的人工监督独立规划、执行和迭代整个开发任务的系统的早期部署。

从辅助型 AI 到自主型 AI 的演变引入了关于开发者专业知识和控制权的深刻问题。当 AI 系统可以处理从初始实现到测试和部署的完整开发工作流时,技能退化(skill atrophy)的风险变得严重。那些严重依赖这些代理而不保持基础知识的开发者,可能会发现自己无法有效地审计、指导或干预 AI 的决策偏离预期结果时的情况。

当我们考虑这些自主系统如何在整个项目中做出级联决策(cascading decisions)时,挑战变得更加复杂。每个单独的选择可能在孤立的情况下看起来都很合理,但累积效应可能会将开发引向意想不到的方向。如果没有及早识别和纠正这些轨迹偏移的专业知识,团队可能会在他们并不完全理解的基础上构建越来越复杂的系统。

正如我们将在后面更深入地探讨的那样,自主编码代理的出现并没有降低软件工程基础知识的重要性——而是放大了它。我们的 AI 工具越强大,我们就越需要保持专业知识,以确保我们仍然是系统的架构师(architects)而不仅仅是操作员(operators)。只有通过对软件原理的深刻理解,我们才能确保这些强大的工具增强我们的能力而不是侵蚀它们。

这正在成为一种模式:团队使用 AI 快速构建令人印象深刻的演示。正常路径(happy path)运行得很好。投资者和社交网络为之惊叹。但当真实用户开始点击操作时呢?那时候问题就出现了。

我亲眼见过这种情况:对普通用户来说毫无意义的错误消息,导致应用程序崩溃的边缘情况(edge cases),从未清理的混乱 UI 状态,完全被忽视的无障碍性(accessibility),以及在较慢设备上的性能问题。这些不仅仅是低优先级的 bug——它们是人们能容忍的软件和人们喜爱的软件之间的区别。

创建真正自助服务的软件——那种用户永远不需要联系支持的软件——需要一种不同的思维方式,这完全关乎打磨(polish)这门失传的艺术。你需要专注于错误消息;在慢速连接和真实的非技术用户身上进行测试;使功能易于发现;并优雅地处理每个边缘情况。这种对细节的关注(也许)无法由AI生成。它来自同理心、经验和对工艺的深切关注。

在我们深入本书第二部分的编码之前,我们需要讨论现代开发实践以及AI辅助编码如何融入团队工作流。毕竟,软件开发不仅仅是编写代码——它是一个完整的工作流,包括规划、协作、测试、部署和维护。而vibe编码(vibe coding)不是一个独立的新奇事物——它可以融入敏捷方法论(agile methodologies)和DevOps实践中,在保持质量和可靠性的同时增强团队的生产力。

在本节中,我们将探讨团队成员如何集体使用vibe编码工具而不会相互干扰,如何平衡AI建议与人类洞察,以及持续集成/持续交付(CI/CD)管道如何整合AI或适应AI生成的代码。我还将涉及版本控制策略等重要考虑因素。

在观察了数十个团队后,以下是我发现在单人和团队工作流中持续有效的三种模式:

在本节中,我将依次介绍每种模式,讨论工作流和成功的技巧。

在你要求AI模型起草任何代码之前,确保团队中的每个人都在同一页面上是很重要的。沟通是关键,这样开发者就不会让他们的AI助手执行冗余任务或生成冲突的实现。

在每日站会(敏捷工作流的主要组成部分)中,不仅值得讨论你正在做什么,还要讨论你是否计划将AI用于某些任务。例如,两个开发者可能正在开发不同的功能,这两个功能都涉及日期格式化的实用函数。如果两人都要求AI创建一个formatDate辅助函数,你可能最终会得到两个相似的函数。提前协调(“我会生成一个我们都可以使用的日期实用工具”)可以防止重复。

成功整合AI工具的团队通常从就编码标准和提示实践达成一致开始。例如,团队可能决定采用一致的风格(代码检查规则、项目约定),甚至将这些指南反馈给他们的AI工具(一些助手允许提供风格偏好或示例代码来引导输出)。正如Codacy博客中提到的,通过让AI熟悉团队的编码标准,你可以获得更统一的生成代码,每个人都更容易使用。在实践层面,这可能意味着在项目README中添加一个”AI使用技巧”部分,在其中注明诸如”我们只使用函数式组件”或”优先使用Fetch API而不是Axios”之类的内容,开发人员在提示AI时可以记住这些。

另一个实践是使用工具的协作功能(如果可用)。一些AI辅助IDE允许用户共享他们的AI会话或至少是他们使用的提示。如果开发人员A通过一个提示获得了复杂组件的良好结果,与开发人员B共享该提示(可能通过问题跟踪器或团队聊天)可以节省时间并确保一致性。

至于使用版本控制,基本原则保持不变——只是有所变化。在现代开发中使用Git(或其他版本控制系统)是不可协商的,这在氛围编码中不会改变。事实上,当AI快速生成代码时,版本控制变得更加重要。提交充当安全网来捕获AI的失误;如果AI生成的更改破坏了某些内容,你可以恢复到以前的提交。

一个策略是在使用AI辅助时更频繁地提交。每次AI产生重要的代码块(如生成功能或进行一些重大重构)并且你接受时,考虑用清晰的消息进行提交。频繁的提交确保如果你需要二分查找问题或撤销AI引入的部分代码,历史记录足够细粒度。

此外,尝试隔离不同的AI引入的更改。如果你让AI在不同领域进行许多更改并将它们全部一起提交,那么在出现问题时就更难以解开。例如,如果你使用代理来优化性能,它还调整了一些UI文本,请分别提交这些内容。(你的两个提交消息可能是”优化列表渲染性能 [AI辅助]“和”更新锻炼完成消息的UI文案 [AI辅助]“)。描述性提交消息很重要;一些团队甚至标记涉及大量AI的提交,只是为了可追溯性。这不是关于责备,而是关于理解代码的起源——标记为”[AI]“的提交可能向审查者表明,代码可能需要对边缘情况进行额外彻底的审查。

本质上,团队应该将AI使用视为开发对话的正常部分:分享经验、成功技术以及关于不该做什么的警告(比如”Copilot建议对X使用过时的库,所以要小心”)。

审查和改进对这种模式至关重要。开发人员应该手动审查和重构代码以提高模块化,添加全面的错误处理,编写详尽的测试,并在改进代码时记录关键决策。下一章将详细介绍这些流程。

传统的结对编程涉及两个人在一个工作站上协作。随着AI的出现,出现了一种混合方法:一个人类开发人员与AI助手一起工作。这种设置可以特别有效,提供了人类直觉和机器效率的融合。

在人类-AI配对中,开发人员与AI交互以生成代码建议,同时审查和改进输出。这种动态允许人类利用AI在处理重复任务方面的速度,例如编写样板代码或生成测试用例,同时保持监督以确保代码质量和相关性。

例如,在集成新库时,开发人员可能会提示AI起草初始集成代码。然后开发人员审查AI的建议,与官方文档交叉参考以验证准确性。这个过程不仅加速了开发,还促进了知识获取,因为开发人员深入参与AI的输出和库的复杂性。

让我们将此与传统的人类-人类结对编程进行比较:

人类-AI配对提供快速代码生成,可以高效处理平凡的任务。它对于独立开发人员或团队资源有限时特别有益。

人人配对 在复杂的问题解决场景中表现出色,这些场景需要细致的理解和协作式头脑风暴。它培养共同的所有权和集体代码理解。

两种方法都有其优点,你可以根据项目的复杂性、资源可用性和开发过程的具体目标来选择。

为了最大化AI辅助开发的好处,请考虑以下实践:

这有助于保持上下文清晰,并确保AI的建议与当前的具体任务相关。

提供清晰具体的指令可以提高AI输出的质量。

定期集成和测试AI生成的代码有助于早期发现问题并保持项目进度。

持续评估AI的贡献,根据需要提供更正或改进,以指导其学习并改善未来的建议。

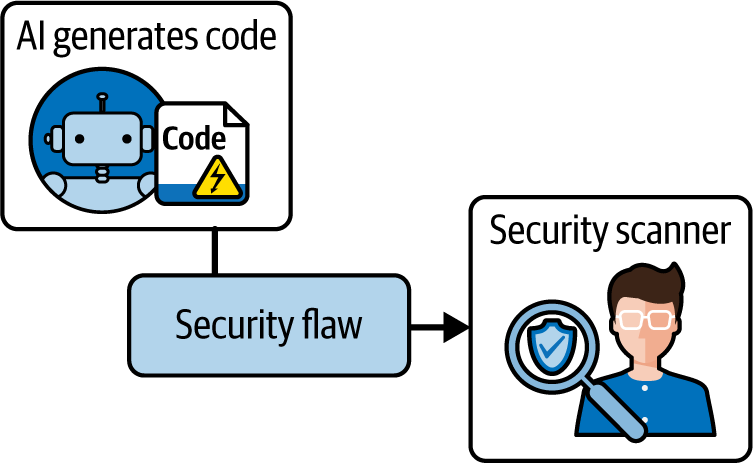

除了代码生成,AI还可以作为有价值的验证者,协助代码审查和质量保证。AI工具可以分析代码中的潜在错误、安全漏洞以及对最佳实践的遵循情况。例如,DeepCode和Snyk的AI驱动代码检查器等平台可以识别缺失输入清理或不安全配置等问题,直接在开发环境中提供可操作的见解。Qodo和TestGPT等平台可以自动生成测试用例,确保更广泛的覆盖范围并减少手动工作。许多AI工具还可以协助监控应用程序性能,检测可能表明潜在问题的异常情况。

通过将AI验证者集成到开发工作流中,团队可以提高代码质量,减少缺陷的可能性,并确保符合安全标准。这种主动的验证方法补充了人工监督,从而产生更强大、更可靠的软件。这些工具通过处理重复和耗时的任务来提高质量保证(QA)流程的效率和有效性,使人工测试人员能够专注于QA中更复杂和更细致的方面。

将AI融入开发过程,无论是作为配对程序员还是验证者,都提供了提高生产力和代码质量的机会。通过深思熟虑地集成这些工具,开发人员可以利用人类和人工智能的优势。

为了最大化AI和人类能力在QA中的好处,我建议以下几个最佳实践:

使用AI进行初步评估和初步扫描,以识别明显的问题。

优先对关键领域进行人工审查,如复杂功能、用户体验和AI局限性。

培养持续协作的环境,让AI工具和人工测试人员协同工作,通过持续的反馈循环来改进AI性能和人类决策。

虽然vibe coding在软件开发中提供了前所未有的速度和创造性自由,但其灵活性本身要求采用结构化方法来确保一致的质量和团队凝聚力。如果没有平衡创造性探索与工程规范的明确指导原则,快速、直观的AI辅助开发可能很快导致混乱。

这些黄金法则来自成功将vibe coding集成到工作流程中的团队的集体经验。它们代表了关于AI擅长的领域、AI遇到困难的领域以及人类判断如何在整个过程中保持必要性的来之不易的见解。这些原则不是限制创造力,而是创建一个框架,让团队能够自信地进行实验,同时保持生产就绪软件所需的标准。

这些规则涉及vibe coding的三个关键维度:人类与AI之间的交互、将AI生成的代码集成到现有系统中,以及培养支持可持续AI辅助开发的团队实践。通过遵循这些指导原则,团队可以利用vibe coding的变革力量,同时避免导致技术债务、安全漏洞或无法维护的代码库的常见陷阱:

: 在与AI交互时,清楚地阐明你的需求、任务和预期结果。精确的提示词产生精确的结果。

: AI生成的代码必须始终与你的原始目标进行核对。在接受之前验证功能、逻辑和相关性。

: 将AI输出视为需要你仔细监督的草稿。提供反馈、完善,并确保质量和正确性。

: 利用AI自动化常规或复杂任务,但在解决问题和做决策时始终保持积极参与。

: 在开始AI驱动的开发之前,与团队就AI使用标准、代码期望和实践达成一致。

: 定期与团队讨论AI经验、技术、成功和陷阱。将AI规范化为集体改进的另一个工具。

: 在版本控制中清楚地识别和分离AI生成的变更,以简化审查、回滚和跟踪。

: 通过让所有贡献都接受相同的严格审查流程来保持一致的标准,提高代码质量和团队理解。

: 除非你完全理解其功能和影响,否则永远不要集成AI生成的代码。理解对于可维护性和安全性至关重要。

: 清楚地记录AI生成代码的基本原理、功能和上下文。良好的文档确保长期清晰度并减少未来的技术债务。

: 记录能够产生高质量AI输出的提示词。维护一个经过验证的提示词库,以简化未来的交互并增强一致性。

: 定期审查和完善你的AI开发工作流。利用过去经验的洞察来持续增强团队的方法。

通过遵守这些黄金法则,你的团队可以有效地利用AI,在保持清晰度、质量和控制的同时提高生产力。

70%问题定义了AI辅助开发的当前状态:这些工具擅长生成样板代码和常规函数,但在最后30%的工作上遇到困难,包括边缘情况、架构决策和生产就绪性。我们确定了两种主要使用模式——快速构建MVP的启动者和将AI集成到日常工作流的迭代者——以及常见的失败模式,如”后退两步”反模式和”演示质量陷阱”,其中令人印象深刻的原型在现实世界压力下失败。

已经出现了三种经过验证的工作流模式:AI作为初稿者(生成然后完善)、AI作为结对程序员(持续协作)和AI作为验证者(人工编写的代码加上AI分析)。Vibe编码的黄金法则提供了重要的防护措施,强调清晰的沟通、彻底的验证、团队协调,以及在合并之前理解所有代码的不可妥协的要求。

个人开发者应该选择一种工作流模式进行系统性实验,同时在日常实践中实施黄金法则。专注于培养第4章中涵盖的持久技能:系统设计、调试和架构——而不是在代码生成上与AI竞争。

团队需要建立AI使用标准,创建有效提示词的共享库,并将AI考虑因素整合到现有的敏捷实践中。定期分享成功和陷阱的知识将帮助团队避免常见陷阱,同时最大化AI的好处。

随着自主AI编码代理(autonomous AI coding agent)的出现,人类的角色将转向架构监督和战略决策。下一章探讨如何最大化这种不可替代的人类贡献,帮助各个级别的工程师作为日益强大的AI系统的合作伙伴而不是竞争对手而蓬勃发展。

1 本章基于最初发表在我的Substack新闻通讯上的一篇文章。参见Addy Osmani,“70%问题:关于AI辅助编码的硬道理”,与Addy Osmani一起提升,2024年12月4日。

你已经看到像Cursor、Cline、Copilot和Windsurf这样的AI编码助手如何改变了软件的构建方式,承担了大部分繁重工作和样板代码——大约70%。1 但是将玩具解决方案与生产就绪系统分开的最后”30%“的工作呢?这个差距包括困难的部分:理解复杂需求、设计可维护的系统、处理边缘情况和确保代码正确性。换句话说,虽然AI可以生成代码,但它经常在工程方面遇到困难。

Tim O’Reilly 在回顾几十年的技术变革时提醒我们,每一次自动化的飞跃都改变了我们如何编程,但并未改变我们为什么需要熟练的程序员。我们面临的不是编程的终结,而是”我们今天所知的编程方式的终结”,这意味着开发者的角色正在演变,而不是消失。

当今工程师面临的挑战是拥抱 AI 在其最擅长领域的能力(前 70%),同时加倍投入剩余 30% 所需的持久技能和洞察力。本文深入探讨专家见解,以识别哪些人类技能仍然至关重要。我们将探讨高级和中级开发者应继续利用什么,以及初级开发者必须投资什么才能在 AI 时代蓬勃发展。

因此,本章的目标是为您提供实用指导,以最大化那不可替代的 30% 的价值,并为各个级别的工程师提供可操作的要点。

如果您是高级工程师,您应该将 AI 编码工具的出现视为放大您影响力的机会——前提是以正确的方式利用您的经验。高级开发者通常拥有深厚的领域知识、对可能出错之处的直觉,以及做出高层技术决策的能力。

这些优势是 AI 无法单独处理的 30% 的一部分。本节探讨经验丰富的开发者如何最大化其价值。

让 AI 处理代码的第一稿,而您专注于架构解决方案,然后完善 AI 的输出。在许多组织中,Steve Yegge 写道,我们可能会看到团队只需要”高级员工”的转变,他们”(a) 描述要完成的任务;即创建提示,以及 (b) 审查结果工作的准确性和正确性”。拥抱这种模式。作为高级开发者,您可以将复杂需求转化为对 AI 助手有效的提示或规范,然后用您的批判性眼光审查生成的每一行代码。您实际上是在与 AI 结对编程——它是快速打字员,但您是大脑。

在审查期间保持高标准:确保代码符合您组织的质量、安全性和性能基准。通过充当架构师和编辑,您可以防止”高审查负担”压倒您。(一个警示说明:如果初级员工只是将原始 AI 输出直接扔给您,请予以回击——建立一个流程,要求他们必须首先验证 AI 生成的工作,这样您就不是唯一的安全网。)

高级工程师经常推动大型项目或处理初级工程师无法单独应对的复杂重构。AI 可以通过处理大量机械性变更或在您的指导下探索替代方案来增强这些工作。Yegge 为这种工作方式引入了术语面向聊天的编程 (CHOP,chat-oriented programming)——“通过迭代提示优化进行编码”,将 AI 作为协作者。利用 CHOP 在您承担的工作上更加雄心勃勃。

拥有 AI 辅助降低了项目值得投入时间的门槛,因为原本可能需要几天的工作现在可以在几小时内完成。因此,高级开发者可以尝试那些总是看似略微遥不可及的”如果能……就好了?“项目。

关键是保持引导性思维:您决定追求哪些工具或方法,并将各个部分整合成一个连贯的整体。您的经验使您能够筛选 AI 的建议——接受那些合适的,拒绝那些不合适的。

另一个高级工程师的关键职责是指导经验较少的团队成员有效使用 AI 以及永恒的最佳实践。你可能拥有通过艰难经验获得的知识,了解初级工程师可能看不到的陷阱,例如内存泄漏、差一错误(off-by-one errors)和并发危险。

由于初级工程师现在可能通过 AI 生成代码,因此教他们如何自我审查和测试这些代码非常重要。通过展示如何彻底测试 AI 贡献来树立榜样,并鼓励质疑和验证机器输出的文化。一些组织(甚至包括律师事务所)已经制定了规则:如果有人使用 AI 生成代码或文字,他们必须披露并自己验证结果——而不是假设高级同事会发现错误。

作为高级工程师,在你的团队中倡导这样的规范:欢迎使用 AI,但需要保持严谨。通过这种方式指导初级工程师,你可以分担一些监督负担,并帮助他们更快地成长到那 30% 的技能水平。

你的广泛经验和背景比以往任何时候都更重要。高级开发人员通常拥有关于公司为什么以某种方式构建事物或行业如何运作的历史知识。这种领域精通能力让你发现 AI 的失误,而新手可能察觉不到。

继续投资于深入理解问题领域。这可能意味着及时了解业务需求、用户反馈或影响软件的新法规。除非你告诉 AI,否则它不会自动纳入这些考虑因素。当你将领域洞察力与 AI 的速度相结合时,就能获得最佳结果。

此外,利用你的远见来引导 AI。例如,如果你知道快速修复会在未来造成维护困难,你可以指示 AI 实现更可持续的解决方案。相信你多年来磨练的直觉——如果一段代码看起来”不对劲”或好得令人难以置信,就深入研究。十次中有九次,你的直觉发现了 AI 没有考虑到的问题。能够预见代码的二阶和三阶效应是高级工程师的标志;不要让 AI 的便利性削弱这种习惯。相反,将其应用于 AI 产生的任何内容。

随着 AI 承担一些编码工作,高级开发人员可以将更多精力投入到工程的人性化方面:与利益相关者沟通、主持设计会议,以及做出将技术与业务战略相结合的判断。Tim O’Reilly 和其他人建议,随着常规编码变得更容易,价值转移到决定构建什么以及如何编排复杂系统上。

高级工程师通常是编排和看到全局的人。承担起这个角色。主动编写架构路线图,评估采用哪些工具(AI 或其他),或定义你组织的 AI 编码指南。这些是 AI 无法完成的任务——它们需要经验、人类判断力,并且通常需要跨团队的共识建设。通过增强你的领导存在感,你确保自己不仅仅是一个代码生成器(可以被另一个工具替代),而是一个指导团队的不可或缺的技术领导者。

简而言之,继续做经验丰富的开发人员最擅长的事情:见树木更见森林。AI 将帮助你砍伐更多树木,但仍然需要有人决定砍哪些树以及如何用木材建造一座稳固的房子。你的判断力、战略思维和指导能力现在比以往任何时候都更重要。有效利用 AI 的高级开发人员可以比不使用的人生产力高得多——但真正出类拔萃的将是那些运用人类优势来放大 AI 输出的人,而不仅仅是让它肆意运行。

正如一位Reddit用户观察到的,“AI是一个编程力量倍增器”,“大大提高了高级程序员的生产力”。倍增效应是真实存在的,但被倍增的是你的专业知识。保持这种专业知识的敏锐性,并将其置于开发过程的中心。

中级工程师可能面临最大的演进压力。许多传统上占用你时间的任务——实现功能、编写测试、调试简单问题——正变得越来越自动化。

这并不意味着过时;而是意味着提升。重点从编写代码转向构建更专业的知识,以下部分将探讨这一点。

随着系统变得更加复杂,理解和管理组件之间的边界变得至关重要。这包括API设计、事件模式(schema)和数据模型——所有这些都需要仔细考虑业务需求和未来的灵活性。深化你的计算机科学基础知识,包括获得对以下学科的深入理解:

这些知识帮助你理解AI生成代码的影响,并做出更好的架构决策。

同时也要学会处理边缘情况和模糊性。现实世界的软件充满了异常场景和不断变化的需求。AI倾向于默认解决一般情况。由开发者来提出”如果…会怎样?“的问题,并探寻弱点。

这里持久的技能是批判性思维和前瞻性——列举边缘情况、预测失败并在代码或设计中解决它们。这可能意味着考虑空输入、网络中断、异常用户操作或与其他系统的集成。

理解业务背景或用户环境将揭示通用AI根本不知道的边缘情况。有经验的工程师习惯性地考虑这些场景。系统地实践测试边界和质疑假设。专注于人类理解仍然至关重要的复杂领域。通用领域包括:

软件工程特定领域包括前端和后端工程、移动开发、DevOps和安全工程等。领域专业知识提供了当前AI工具所缺乏的背景知识,并帮助你更好地决定在何处以及如何应用它们。

虽然LLM可以提供基本的优化建议,但识别和解决系统级性能问题需要对整个技术栈的深入理解,从数据库查询模式到前端渲染策略。随着代码生成变得更加自动化,理解系统如何在生产环境中运行变得更有价值。

关注以下领域:

监控和可观测性(observability)

性能分析与优化

安全实践与合规

成本管理与优化

随着AI编写大量代码,严格审查和测试这些代码的能力变得更加关键。Yegge强调:“每个人都需要对测试和审查代码变得更加认真。”像对待初级开发人员的输出一样对待AI生成的代码:你是代码审查员,负责发现错误、安全漏洞或草率的实现。这意味着要加强你在单元测试、集成测试和调试方面的技能。

编写良好的测试是一项持久的技能,它迫使你理解规范并验证正确性。明智的做法是假设在证明之前什么都不工作。AI通常会产生功能性但未经优化的代码,直到你引导它进行迭代改进。这可能是由于多种原因,包括用于训练编码模型的训练数据并没有尽可能完整地反映所有最佳实践。

培养测试思维:验证每个关键逻辑路径,使用静态分析或代码检查工具,如果AI给出的代码不符合你的质量标准,不要回避重写它。即使你遵循前一章讨论的”AI作为验证器”模式,质量保证也不是一个可以简单外包给AI的领域——这正是人类勤奋的闪光之处。当软件没有按预期工作时,你需要真正的解决问题的能力来诊断和修复它。AI可以协助调试(例如,通过建议可能的原因),但它缺乏对应用程序运行的特定上下文的真正理解。人类测试人员拥有特定领域的知识和对用户期望的理解,而AI目前缺乏这些。这种洞察力在评估潜在问题的相关性和影响时至关重要。诊断复杂的错误通常需要创造性的问题解决和考虑广泛因素的能力——这些都是人类固有的技能。评估软件行为的伦理影响,如公平性和可访问性,需要人类的敏感性和判断力。

能够推理复杂的错误——重现它、隔离原因、理解底层系统(操作系统、数据库、库)——是一项永恒的工程技能。这通常需要对基础知识有深刻的理解(内存和状态如何工作、并发等),初级开发人员必须通过实践来学习。将AI用作帮手(它可能会解释错误消息或建议修复方法),但不要盲目依赖它。在调试时有条不紊地排查问题和应用第一性原理的技能,使优秀的开发人员脱颖而出。这也是一个反馈循环:调试AI编写的代码将教会你下次更好地提示AI或避免某些模式。

软件项目不仅仅是孤立的编码任务;它们存在于用户需求、时间表、遗留代码和团队流程的更大背景中。AI对大局没有天生的感知,比如项目的历史或某些决策背后的理由(除非你明确将所有这些内容输入到提示中,这通常是不切实际的)。人类需要承载这些上下文。

这里的持久技能是系统思维——理解系统一个部分的变化如何影响另一个部分,软件如何服务于业务目标,以及所有活动部件如何连接。这种整体视角让你能够适当地使用AI输出。例如,如果AI建议一个与监管要求或公司惯例相矛盾的巧妙捷径,你会发现它,因为你了解上下文。努力学习项目的背景并阅读设计文档,这样你就可以培养关于什么合适、什么不合适的判断力。

最后,一个元技能(metaskill):学习新工具和适应变化的能力。AI 辅助开发领域正在快速发展。保持开放心态并学习如何有效使用新 AI 功能的工程师将保持领先地位——Tim O’Reilly 建议”渴望学习新技能”的开发者将从 AI 中获得最大的生产力提升。投资于深入学习基础知识并对新技术保持好奇心。这种组合使你能够将 AI 作为工具来使用,而不会变得依赖它。

这是一个平衡的过程:使用 AI 来加速你的成长,但也要偶尔不使用它来练习,以确保你不会跳过核心学习(一些开发者会定期进行”AI 排毒(AI detox)“,以保持他们的原始编码技能的敏锐性)。简而言之,成为那种不断学习的工程师——这是任何时代都能证明职业价值的技能。

当实现时间减少时,在业务需求和技术解决方案之间进行转换的能力变得更加有价值。能够有效地与产品经理、设计师和其他利益相关者沟通的工程师将变得越来越有价值。这里的重点领域包括:

需求收集和分析

技术写作和文档编写

项目规划和估算

团队领导力和指导

中级工程师可能不再花费数天时间实现新功能,而是花时间设计能够优雅处理规模和故障模式的健壮系统。这需要对分布式系统原理、数据库内部机制和云基础设施有深入的理解——这些领域目前 LLM 提供的价值有限。

练习设计解决大规模实际问题的系统。无论代码如何生成,这些技能都保持价值,因为它们需要理解业务需求和工程权衡。

设计一个连贯的系统需要理解权衡、约束以及超越编写几个函数的”大局”。AI 可以生成代码,但不会自动为复杂问题选择最佳架构。

整体设计——组件如何交互、数据如何流动、如何确保可扩展性和安全性——是那 30% 需要人类洞察力的部分;这包括以下内容:

负载均衡(load balancing)和缓存(caching)策略

数据分区(data partitioning)和复制(replication)

故障模式(failure modes)和恢复程序

成本优化(cost optimization)和资源管理(resource management)

高级开发者长期以来一直在磨练这项技能,中级和初级开发者应该积极培养它。从模式和原则的角度思考(如关注点分离和模块化)——这些指导 AI 生成的解决方案走向可维护性。记住,扎实的架构不会偶然出现;它需要有经验的人来掌控方向。

记住,AI 应该成为你工作流程中不可或缺的一部分——这不是应该抵制的东西。将 AI 融入日常工作的实用方法包括:

搭建初始代码结构

快速原型和概念验证(proof of concepts)

结对编程以加快调试和问题解决

建议优化方案和替代方法

处理重复的代码模式,让你专注于架构和设计决策

有一种日益增长的说法认为,中级软件工程师应该”直接退出”——因为随着 AI 处理实现细节,纯工程技能将变得过时。虽然这个结论被夸大了,但关于工程之外技能(如设计)重要性的讨论值得关注。在 2024 年 12 月 X 平台上的一次代表性交流中,@fchollet 写道:

我们即将进入一个可以将测试时计算转化为能力的世界——这在软件历史上是第一次,边际成本将变得至关重要。

对此,@garrytan 回应道:

UX、设计、对工艺的实际投入将在下一个时刻成为中心舞台。

真正做出人们想要的东西。软件和编码不会成为限制因素。创造优秀软件的关键是成为通才(polymath)的能力,以及在多个领域同时保持聪明和高效。

成功的软件创作始终需要的不仅仅是编码能力。正在改变的不是工程的消亡,而是纯实现障碍的降低。这种转变实际上使工程判断力和设计思维变得更加关键,而非相反。

想想是什么让 Figma、Notion 或 VSCode 这样的应用成功。不仅仅是技术卓越——而是对用户需求、工作流程和痛点的深刻理解。这种理解来自以下方面:

用户体验设计思维

深厚的领域知识

对人类心理和行为的理解

考虑性能、可靠性和可扩展性的系统设计

商业模式对齐

最优秀的工程师一直以来都不仅仅是编码者。他们是既理解技术约束又理解人类需求的问题解决者。随着 AI 工具降低实现的摩擦,这种整体性理解变得更加宝贵。

然而,这并不意味着每个工程师都需要成为 UX 设计师。相反,这意味着要培养更强的产品思维能力,与设计师和产品经理建立更好的协作技能。这意味着更多地思考用户,理解他们的心理和行为模式,并学会做出支持用户体验目标的技术决策。你正处于实现技术优雅的阶段:现在要通过密切关注实际用户需求来平衡它。

Tan 继续发帖说:

UX、设计、对工艺的实际投入将在下一个时刻成为中心舞台。

真正做出人们想要的东西。软件和编码不会成为限制因素。创造优秀软件的关键是成为通才的能力,以及在多个领域同时保持聪明和高效。

未来属于那些能够在人类需求和技术解决方案之间架起桥梁的工程师——无论是通过自己培养更好的设计敏感性,还是通过与专业设计师更有效的协作。

如果你是初级或经验较少的开发者,你可能对 AI 感到既兴奋又焦虑。AI 助手可以编写你可能不知道如何自己编写的代码,有可能加速你的学习。然而,有关于“初级开发者之死”的头条新闻,暗示入门级编程工作面临风险。与流行的猜测相反,虽然 AI 正在显著改变早期职业体验,但初级开发者并未过时。

你需要主动培养能力,确保自己贡献的价值超越AI能够产出的内容。随着这些任务日益自动化,通过实现基本的CRUD应用和简单功能来学习的传统路径将会演变。

考虑一个典型的初级任务:按照现有模式实现一个新的API端点。以前,这可能需要一天的编码和测试时间。有了AI辅助,实现时间可能会降到一小时,但关键技能变成了:

充分理解现有系统架构,以便正确指定需求

审查生成的代码以发现安全隐患和边界情况

确保实现与现有模式保持一致

编写验证业务逻辑的全面测试

这些技能无法纯粹通过遵循教程或AI提示来学习——它们需要生产系统的实际经验和资深工程师的指导。

这种演变对早期职业开发者来说既是挑战也是机遇。入门级职位的门槛可能会提高,需要更强的基础知识来有效审查和验证AI生成的代码。然而,这种转变也意味着初级工程师可能在职业生涯早期就能解决更有趣的问题。

以下是如何投资自己以有效应对那30%差距的方法。

依赖AI回答每个问题(“如何在Python中做X?”)而从不真正吸收底层概念,这很诱人。抵制这种冲动。将AI用作导师,而不仅仅是答案售货机。例如,当AI给你一段代码时,询问它为什么选择那种方法,或让它逐行解释代码。

确保你理解数据结构(data structures)、算法(algorithms)、内存管理(memory management)和并发(concurrency)等概念,而不是总是依赖AI。原因很简单:当AI的输出错误或不完整时,你需要自己的心智模型来识别和修复它。如果你没有积极思考AI为什么生成某些代码,你实际上可能学到的更少,阻碍你的成长。所以花时间阅读文档,从头编写小程序,巩固你的核心知识。这些基础知识是持久的;即使你周围的工具发生变化,它们也会为你服务。

要建立真正的信心,有时你必须独自飞行。许多开发者倡导设立”无AI日”或定期限制AI辅助。这确保你仍然可以仅凭自己的技能解决问题,这对于避免技能退化(skill atrophy)很重要。你会发现这迫使你真正思考问题的逻辑,这反过来使你更擅长使用AI(因为你可以更智能地指导它)。

此外,每当你在AI生成的代码中遇到bug或错误时,在要求AI修复之前,先亲自跳进去调试它。通过使用调试器或添加打印语句来查看出了什么问题,你会学到更多。

将AI建议视为提示,而非最终答案。随着时间推移,解决任务中那些棘手的最后部分将培养你在AI困难领域的技能——正是这使你有价值。

作为初级开发者,你可以养成的最佳习惯之一是为代码编写测试。如果你使用AI生成代码,这一点尤为重要。

当你从 LLM 获得一段代码时,不要假设它是正确的——要质疑它。编写单元测试(或使用手动测试)来验证它是否真正处理了需求和边界情况。这样做有两个目的:它能捕获 AI 输出中的问题,并且训练你在信任实现之前先思考预期行为。

你甚至可以使用 AI 来帮助编写测试,但你要定义测试什么。Yegge 的建议关于认真对待测试和代码审查适用于所有级别。如果你培养出仔细验证工作的声誉(无论是否有 AI 辅助),资深同事会更加信任你,你也会避免他们觉得你只是在向他们”倾倒”有问题代码的情况。

实际操作中,开始将测试视为开发的组成部分,而不是事后补充。学习如何使用测试框架,如何进行探索性手动测试,以及如何系统地重现 bug。这些技能不仅让你在 30% 的工作中表现更好,还能加速你对代码实际工作方式的理解。

记住:如果你捕获了 AI 引入的 bug,你刚刚做了 AI 做不到的事情——这就是附加价值。

初级开发者通常专注于”让代码运行起来”。但在 AI 时代,获得一个基本可运行的版本很容易——AI 能做到这一点。更难的部分(也是你应该关注的)是编写可读、可维护和简洁的代码。

开始培养对良好代码结构和风格的敏感度。将 AI 的输出与你知道的最佳实践进行比较;如果 AI 代码混乱或过于复杂,主动重构它。例如,如果 LLM 给你一个做太多事情的 50 行函数,你可以将其拆分为更小的函数。如果变量名不清楚,重命名它们。

本质上,假装你在审查同事的代码,像同事写的一样改进 AI 的代码。这将帮助你内化良好的设计原则。随着时间推移,你会开始以产生更简洁代码的方式提示 AI(因为你会指定你想要的风格)。软件维护者(通常在几个月或几年后工作)会感谢你,你也会证明你的思考超越了”让它运行”——你在像工程师一样思考。保持可维护性正是那 30% 人类驱动工作的核心,所以从职业生涯一开始就把它作为你的关注点。

不可否认,“提示工程”(prompt engineering)——有效地与 AI 工具交互的技能——是有用的。作为初级开发者,你绝对应该学习如何向 AI 提问,如何给它提供适当的上下文,以及如何迭代提示以改进输出(本书的[第 2 章]是一个很好的起点)。这些是能让你脱颖而出的新技能(许多经验丰富的开发者也还在摸索!)。但是,记住善于提示通常是理解问题的代理。如果你发现无法让 AI 做你想要的事,可能是因为你需要先澄清自己的理解。将此作为信号。

一个策略是在要求 AI 实现之前,自己先用简单的英语概述解决方案。此外,尝试不同的 AI 工具(Copilot、Claude 等)来了解它们的优势和劣势。你越熟练使用这些助手,就越有生产力——但永远不要将它们的输出视为绝对正确。将 AI 想象成一个超强版的 Stack Overflow:一个辅助工具,而不是权威。

你甚至可以使用 AI 帮助构建小型个人项目来挑战自己的极限(“我能借助 AI 的帮助构建一个简单的 Web 应用吗?”)。这样做会教你如何将 AI 集成到开发工作流程中,这是带入团队的一项很好的技能。只需在如前所述的时间段内平衡无网络工作。

最后,一个能加速你成长的持久技能是寻求反馈和向他人学习的能力。AI 不会因为你忽略它的建议而生气,但你的人类队友和导师对你的发展是无价的——尤其是在软技能、领导力、沟通和应对办公室政治方面。

不要犹豫向资深开发者询问为什么他们偏好某个解决方案而不是另一个,特别是当它与AI建议的不同时。与更有经验的同事讨论设计决策和权衡——这些对话揭示了经验丰富的工程师如何思考,这对你来说是宝贵的财富。在代码审查中,要特别乐于接受关于你的AI生成代码的评论。如果审查者指出”这个函数不是线程安全的”或”这种方法会有扩展性问题”,花时间去理解根本问题。这些正是AI可能遗漏的东西,而你需要学会发现它们。随着时间推移,你会建立一个心理检查清单。

此外,寻找结对编程(pair programming)的机会(即使是远程)。也许你可以与一位在工作流程中使用AI的资深开发者”结对”——你会观察到他们如何提示AI以及如何纠正它。但更重要的是,你会看到他们如何沟通、引导讨论以及处理微妙的团队动态。对反馈保持开放并主动寻求指导,将帮助你从执行AI能做的任务成长为执行只有人类才能做的高价值任务。从某种意义上说,你正在尝试尽可能高效地获得通常伴随经验而来的智慧。这使你不仅仅是房间里的另一个编码者——而是让你成为团队渴望留住和提升的那种工程师。

构建软件是一项团队运动。AI不参加会议(谢天谢地)——人类仍然必须与其他人交谈以澄清需求、讨论权衡并协调工作。强大的沟通技能和以往一样有价值。练习提出好问题并清晰地描述问题(对同事和对AI都是如此)。

有趣的是,提示AI本身就是一种沟通形式;它要求你精确表达你想要什么。这与一项核心工程技能重叠:需求分析(requirements analysis)。如果你能制定清晰的提示或规范,这意味着你已经思考了问题。

此外,分享知识、编写文档和审查他人的代码都是AI无法替代的协作技能。在未来,随着开发者”与”AI一起工作,团队中的人与人之间的协作——确保正在解决正确的问题——仍然至关重要。一个新兴趋势是,开发者可能会更多地专注于高层设计讨论(通常AI作为参与者)和协调任务,本质上承担更多的指挥者角色。沟通和领导技能将在那个指挥者的位置上很好地服务于你。

值得注意的是,在AI时代,初级开发者需要转变思维方式:你需要从消费解决方案转变为创造理解。在过去,你可能会费力地阅读文档最终编写一个功能;现在AI可以将解决方案直接呈现给你。如果你只是消费它(复制粘贴然后继续),你并没有成长多少。

相反,将每个AI给出的解决方案作为学习案例。剖析它,实验它,并思考你自己可能如何得出它。通过将AI输出不视为终结所有问题的答案,而是作为互动学习材料,你确保你——人类——持续提升。这样,AI不是取代你的成长,而是加速它。

许多专家认为,虽然AI可能会减少对大量初级”代码工”团队的需求,但它也提高了成为初级开发者的门槛。这个角色正在转变为能够有效地与AI合作并快速攀升价值链的人。如果你采纳本节讨论的习惯,你将把自己区分为一个初级开发者,不仅仅带来AI能带来的东西(任何公司都可以通过订阅获得),而是带来洞察力、可靠性和持续改进——未来资深开发者的特质。

为了在AI增强的开发世界中茁壮成长,各个级别的工程师都应该加倍投入AI尚未(还)能够复制的持久技能和实践。无论我们的工具变得多么先进,这些能力都将保持至关重要。特别要关注以下领域:

加强你的系统设计和架构专业知识

练习系统思维并保持对全局的上下文理解

磨练你在批判性思维、问题解决和前瞻性方面的技能

在专业领域建立专业知识

代码审查、测试、调试和质量保证

提高你的沟通和协作技能

适应变化

持续学习,在获得新技能和更新知识的同时保持基础扎实

使用AI

这些技能构成了软件工程中的人类优势。它们是持久的,因为它们不会随着下一个框架或工具的变化而过期;实际上,AI的崛起使它们更加突出。Simon Willison认为,AI辅助实际上使强大的编程技能变得更有价值,而不是更少,因为那些具有专业知识的人可以更有效地利用这些工具。

一台强大的机器在不熟练的人手中可能是危险的或被浪费的,但在有能力的人手中它是变革性的。在AI时代,一位经验丰富的工程师就像一位拥有新的先进副驾驶的资深飞行员:旅程可以走得更快更远,但飞行员仍必须驾驭风暴并确保安全着陆。

软件工程一直是一个持续变化的领域——从汇编语言到高级编程,从本地服务器到云,现在从手动编码到AI辅助开发。每一次飞跃都自动化了编程的某些方面,然而每一次,开发人员都适应了并找到了更多要做的事情。在回应Tim O’Reilly的一篇笔记时,一位HN评论者指出,过去的创新”几乎总是为开发人员带来更多工作、更多增长、更多机会”。AI的崛起也不例外。它不是让开发人员变得无关紧要,而是重塑成功所需的技能集。平凡的70%编码工作正在变得更容易;具有挑战性的30%成为我们价值的更大部分。

为了最大化人类的30%,专注于永恒的工程技能:深入理解问题,设计简洁的解决方案,审查代码质量,并考虑用户和上下文。经验丰富的程序员从AI中获得更多,因为他们知道如何引导它以及当它失败时该做什么。那些将这些技能与AI工具结合起来的人将超越那些只有其中一种的人。事实上,专家们达成的共识是,AI是熟练者的工具:“LLMs是为强大用户(power users)设计的强大工具(power tools)。”这意味着我们每个人都有责任成为那个”强大用户”——培养让我们有效使用这些新工具的专业知识。

最终,软件工程的技艺不仅仅是编写可以工作的代码。它是关于编写运行良好的代码——在真实世界环境中,随着时间推移,在不断变化的需求下。今天的AI模型可以帮助编写代码,但还不能确保代码在所有这些维度上都运行良好。这是开发人员的工作。

通过加倍投入刚才概述的技能,资深开发人员可以继续领导和创新,中级开发人员可以加深他们的专业知识,初级开发人员可以加速他们通往精通的旅程。AI将处理越来越多的例行工作,但你的创造力、直觉和深思熟虑的工程将把原始输出转化为真正有价值的东西。AI是一个强大的工具,但关键在于我们如何使用它。良好的工程实践、人类判断和学习意愿将继续是必不可少的。

在实际操作中,无论你是与一个”渴望的初级”AI进行结对编程来编写你的函数,还是审查一个充满AI生成代码的差异,永远不要忘记应用你独特的人类视角。问问自己:这是否解决了正确的问题?其他人能够理解和维护这个吗?风险和边缘情况是什么?这些问题是你的责任。编程的未来确实将涉及更少的手动输入每个分号,更多的指导和策划——但它仍然需要掌舵的开发人员,他们有智慧正确地完成它。

最终,伟大的软件工程始终关乎问题解决,而不仅仅是编写代码。AI 并没有改变这一点:它只是挑战我们将问题解决能力提升到新的层次。拥抱这一挑战,你将在我们行业的新篇章中蓬勃发展。

[1] 本章基于我首次在 Substack 新闻通讯上发表的两篇文章:Addy Osmani,“超越 70%:最大化 AI 辅助编程中人类的 30%”,Elevate with Addy Osmani,2025 年 3 月 13 日;以及 Addy Osmani,“让你的软件工程职业生涯面向未来”,Elevate with Addy Osmani,2024 年 12 月 23 日。

[2] 要了解更多关于系统思维(systems thinking)的内容,请参阅 Donella H. Meadows,系统思维:入门,第 2 版(Rizzoli,2008);以及 Peter M. Senge,第五项修炼:学习型组织的艺术与实践(Crown,2010)。

[3] 有关此主题的更多信息,请参阅 Mark Richards 和 Neal Ford,软件架构基础,第 2 版(O’Reilly,2025);以及 Mark Richards、Neal Ford 和 Raju Gandhi,深入浅出软件架构(O’Reilly,2024)。

你已经学会了如何提示 AI 生成代码,到目前为止,你可能已经使用这些技术产生了一些代码。现在进入了一个关键阶段:确保代码是正确的、安全的和可维护的。

作为开发者,你不能只是接受 AI 的输出并盲目地交付它。你需要审查它、测试它、可能改进它,并将其与代码库的其余部分集成。本章重点介绍如何理解 AI 提供给你的内容,迭代地编辑和调试它,并完全掌控代码作为项目的一部分。

本章涵盖:

根据你的原始意图解释 AI 的代码

“多数解决方案”现象,或者为什么 AI 生成的代码通常看起来像常见解决方案

审查代码清晰度和潜在问题的技术

当 AI 编写的代码未按预期工作时进行调试

为样式或效率重构代码

编写测试来验证代码的行为

通过掌握这些技能,你将能够自信地将 AI 的贡献集成到你的项目中。

当你获得 AI 的代码时,你的第一步应该是将其与你的意图(你给出的提示)进行比较。代码是否满足你设定的要求?有时 AI 可能会轻微误解或只是部分实现你所要求的内容。

仔细阅读代码。在脑海中或纸上逐步执行它:

追踪它对典型输入的处理。

如果你的提示有多个部分(“做 X 和 Y”),验证 AI 是否全部完成了。

确保 AI 没有添加你未要求的功能——有时它会添加它”认为”有用的额外功能,比如添加日志记录或参数,这可能是好的也可能不是。

就像你对待同事的代码一样,如果有什么不清楚的地方,记录下来。如果你为它的存在寻找一个好的理由,你可能会找到一个。如果找不到,就质疑它或考虑删除它。

例如,如果你要求一个素数检查器,而 AI 代码还为每个数字打印类似”正在检查 7…“的内容,这可能是你如何提示它的副产品或来自其训练数据的模式(一些教程代码会打印其进度)。如果你不想要那个,计划删除它或提示 AI 删除它。

还要确保边缘情况(edge

cases)按你的预期处理。如果你希望它处理空输入,它做到了吗?如果输入可能是

None 或负数,AI 考虑到了吗?

如果你的提示中有什么是模糊的,AI 必须选择一种解释,识别发生这种情况的地方。也许你没有指定输出格式,它选择打印结果而不是返回它们。现在你必须决定是接受它还是修改代码。

这个理解阶段至关重要;不要跳过它。即使你要测试代码,通过阅读来理解它也很重要,因为测试可能无法覆盖所有内容(而且对于一些明显的事情,阅读更快)。

最后,考虑 AI 的假设。AI 通常倾向于”多数”或最常见的解释(这引出我们下一节的内容)。

在大量代码上训练的AI模型通常会生成训练数据中最常见的解决方案(或最符合条件的最简单解决方案)。 我称之为多数解决方案效应(majority solution effect)。它在一般情况下是正确的,但可能不是你特定情况下的最佳选择。

例如,如果你在没有进一步上下文的情况下请求一个搜索算法,AI可能会输出一个基本的线性搜索,因为这很直接且常见。也许你实际上需要二分搜索,但AI不知道效率至关重要,因为你没有说明。线性搜索适用于许多中等情况,但如果性能是关键则不适用。

类似地,AI可能使用全局变量,因为许多简单示例都这样做,但也许在你的项目中,这不是可接受的实践。

要注意AI的解决方案可能针对通用场景进行优化。作为人类开发者,你对AI缺乏的上下文有深入了解。

为了解决这个问题:

识别代码中的假设。如果它假设列表已排序或输入有效,这个假设可以吗?你指定了吗?如果没有,也许它应该包含一个检查。

考虑替代方案:如果你知道解决问题的多种方法(如不同的算法),AI选择了哪一个?是你想要的那个吗?如果不是,你可以提示要求替代方案或直接更改它。

如果AI代码适用于”常规”情况但不适用于对你重要的边缘条件,那就需要修复。例如,也许它没有考虑某些数学运算中的整数溢出。在许多训练示例中,这可能没有被处理,但在你的上下文中,这可能很重要。

理解AI倾向于通用解决方案将使你更擅长审查其代码。它不是魔法或量身定制的;它是对解决方案的非常有根据的猜测。定制是你的工作。

AI生成的代码通常有一些明显的模式。 它可能:

包含比平常更多的注释或措辞奇怪的注释(因为它从教程代码中学习,而教程代码往往有大量注释)

一致地使用某些变量名(如循环中的i、j、k)

以某种冗长的风格编排代码(以涵盖一般情况)

检查这些并考虑它们是否与你项目的风格匹配。 代码在功能上可能没问题,但需要可读性检查。 在该检查中,你可能想要:

重命名变量以更具描述性或与你的代码库保持一致。

删除或优化注释。如果它在一个不言自明的if语句上方添加了像# 检查数字是否为质数这样的注释,你可以删除它。但如果它有一个解释复杂逻辑位的注释,那很好——保留或改进它。

通过运行代码通过linter或formatter(如Python的Black或Go的gofmt)来确保一致的格式化,以匹配你想要的间距和括号样式。

还要查找任何不寻常的结构。 AI是否定义了多个类或函数,而你期望一个?有时它可能将问题分解为多个函数,因为训练示例就是这样做的。如果这过度了,你可以内联它们(或相反)。代码是太聪明还是太简单?AI有时会产生一个非常直接的解决方案,或者偶尔是一个花哨的单行代码。这是否符合你团队的偏好?如果不符合,请相应调整。

其他需要注意的潜在问题包括:

是的,AI也会犯这种错误。例如,循环边界可能很棘手。如果有时间,在脑海中测试一个简单的情况通过循环。

代码是否假设文件成功打开或所有输入都采用正确格式?如果需要,添加错误处理。

性能陷阱

也许AI在大型数据集上使用内循环进行成员检查,尽管存在更好的方法,比如使用集合。AI的解决方案可能是正确的,但不是最优的。