自由能原理在心智、大脑和行为中的应用

Thomas Parr, Giovanni Pezzulo, and Karl J. Friston

The MIT Press Cambridge, Massachusetts London, England

© 2022 Massachusetts Institute of Technology

版权所有。未经出版商书面许可,不得以任何电子或机械方式(包括影印、录制或信息存储和检索)复制本书的任何部分。

MIT出版社感谢为本书草稿提供评论的匿名同行评审员。学术专家的慷慨工作对建立我们出版物的权威性和质量至关重要。我们感激地承认这些其他未署名读者的贡献。

本书由Westchester Publishing Services用Stone Serif和Stone Sans字体排版。

国会图书馆出版物编目数据

姓名:Parr, Thomas, 1993– 作者。| Pezzulo, Giovanni, 作者。| Friston, K. J. (Karl J.), 作者。

书名:Active inference : the free energy principle in mind, brain, and behavior / Thomas Parr, Giovanni Pezzulo, and Karl J. Friston.

描述:Cambridge, Massachusetts : The MIT Press, [2022] | 包含参考文献和索引。

标识符:LCCN 2021023032 | ISBN 9780262045353 (精装本) 主题:LCSH: 知觉。| 推理。| 神经生物学。| 人类行为模型。| 知识论。| 贝叶斯统计决策理论。

分类:LCC BF311 .P31366 2022 | DDC 153—dc23

LC记录可在 https://lccn.loc.gov/2021023032 获取

前言

第一部分

1 概述 2 通往Active Inference的低级路径 3 通往Active Inference的高级路径 4 Active Inference的生成模型 5 消息传递和神经生物学

第二部分

6 设计Active Inference模型的方法 7 离散时间中的Active Inference 8 连续时间中的Active Inference 9 基于模型的数据分析 10 Active Inference作为有感知行为的统一理论

附录A:数学背景附录B:Active Inference方程附录C:Matlab代码注释示例注释参考文献索引

Karl Friston

Active Inference是一种理解有感知行为的方式。你正在阅读这些文字这一事实本身就意味着你正在进行Active Inference——即以特定方式主动采样世界——因为你相信你会学到什么。你用眼睛触摸这一页,仅仅是因为这是能够解决关于你接下来会看到什么以及这些文字传达什么内容的不确定性的那种行动。简而言之,Active Inference将行动引入知觉,将知觉视为知觉推理或假设检验。Active Inference更进一步,将规划视为推理——即推断你接下来会做什么来解决关于你生活世界的不确定性。

为了说明Active Inference的简单性——以及我们试图解释的内容——请将你的指尖轻柔地放在你的腿上。让它们在那里静止一两秒钟。现在,你的腿感觉粗糙还是光滑?如果你必须移动手指才能产生粗糙或光滑的感觉,你就发现了Active Inference的基础。感觉就是触摸。看就是观察。听就是倾听。这种触摸不一定是显性的——我们可以通过将注意力指向这里或那里来隐性地行动。简而言之,我们不仅仅是试图理解我们的感觉;我们必须主动创造我们的感觉系统。在接下来的内容中,我们将看到为什么必须如此,以及为什么我们感知、做或规划的一切都在一个存在命令——自我证明——的范围内。

Active Inference不仅仅关于阅读或认识性觅食。从一个角度来看,它是所有生物和粒子凭借其存在而做的事情。这可能听起来像一个强烈的主张;然而,它说明了Active Inference继承自自由能原理的事实,该原理将存在等同于自我证明,将自我证明等同于一种enactive类型的推理。然而,本书不关心有感知系统的物理学。它的重点是这种物理学对理解大脑如何工作的含义。

这种理解不是一件容易的事,正如几千年的自然哲学和几个世纪的神经科学所见证的那样。虽然人们可以在自组织行为的第一原理解释中找到Active Inference的根源(即类似于汉密尔顿静止作用原理的变分原理),但在询问特定大脑如何工作以及它与另一个大脑有何不同时,第一原理并没有太大帮助。例如,致力于自然选择的进化论在理解我为什么有两只眼睛或说法语方面没有丝毫帮助。本书是关于使用原理来支撑神经科学和人工智能中的关键问题。为了做到这一点,我们必须超越原理,掌握原理所适用的机制。

因此,主动推理——及其伴随的贝叶斯机制——旨在为我们如何感知、规划和行动的问题提供框架。关键的是,它并不试图取代其他框架,如行为心理学、决策理论和强化学习。相反,它希望在一个统一的框架内拥抱所有那些已被证明如此成功的方法。在接下来的内容中,我们将特别关注将心理学、认知神经科学、生成主义(enactivism)、动物行为学等领域的关键构念与主动推理中的信念更新计算——及其相关的过程理论——联系起来。

所谓过程理论,我们指的是关于信念更新如何通过具身大脑及其他地方的神经元(和其他生物物理)过程实现的理论。迄今为止,主动推理的工作提供了一套相当直接的计算架构和仿真工具,既能对大脑功能的各个方面建模,也能让人们测试关于不同计算架构的假设。然而,这些工具只解决了一半的问题。主动推理的核心是一个生成模型——即对外部世界中不可观察的原因如何产生可观察结果——我们的感觉——的概率表征。获得正确的生成模型——作为对任何实验对象或生物的有感知行为的恰当解释——是一个巨大的挑战。

本书试图解释如何应对这一挑战。第一部分建立基本概念和形式主义,在第二部分中会用到——以说明它们如何在实践中应用。简而言之,本书面向那些想要使用主动推理来仿真和建模有感知行为的人,服务于科学研究或者可能的人工智能。因此,它专注于理解和实施主动推理方案所必需的概念和程序,而不会被一方面的有感知系统的物理学或另一方面的哲学所分散注意力。

我有一个坦白要说。我没有写这本书的大部分内容。或者更确切地说,我不被允许写。这本书的议程要求一种清晰明了的写作风格,这超出了我的能力。虽然我被允许插入一些我喜欢的词汇,但接下来的内容证明了Thomas和Giovanni的功力,他们对手头问题的深刻理解,以及重要的是,他们的心理理论——在所有意义上。

我们感谢朋友和同事们的宝贵意见——特别是伦敦大学学院Wellcome人类神经影像中心理论神经生物学小组的过去和现在成员;意大利国家研究委员会认知科学与技术研究所的行动中的认知(CONAN)实验室;以及众多国际合作者,他们对本书所呈现思想的发展起到了不可或缺的作用。这个年轻但不断发展的社区在提供智力支持和动力方面非常慷慨。此外,我们感谢MIT Press的Robert Prior和Anne-Marie Bono在本书准备期间的友好陪伴和建议,以及Jakob Hohwy和其他深思熟虑的审稿人的指导。最后,我们感谢为我们的研究提供资金支持的资助机构:KJF由Wellcome Trust首席研究奖学金资助(编号:088130/Z/09/Z);GP由欧洲研究理事会第820213号拨款协议(ThinkAhead)和欧盟地平线2020研究与创新框架计划第945539号特定拨款协议(人脑项目SGA3)资助。

机会垂青有准备的头脑。 ——路易·巴斯德

本章介绍主动推理寻求解决的主要问题:生物体如何在与环境进行适应性交换的同时持续存在?我们讨论从规范视角解决这个问题的动机,这种视角从第一原理开始,然后展开其认知和生物学含义。此外,本章简要介绍了本书的结构,包括其分为两个部分:第一部分旨在帮助读者理解主动推理,第二部分旨在帮助他们在自己的研究中使用它。

生物体不断与其环境(包括其他生物体)进行相互作用。它们发出改变环境的行动,并从环境中接收感觉观察,如图1.1所示意的那样。

生物体只能通过对行动-感知循环施加适应性控制来维持其身体完整性。这意味着行动以获得与期望结果或目标相对应的感觉观察(例如,对于简单生物而言,伴随安全营养和庇护所的感觉

观察

行动

图1.1

[连接生物与其环境的动作-感知循环的相互关系。][术语][environment][有意保持通用性。在我们讨论的例子中,它可以][包括物理世界、身体、社会环境等。]

生物体,或对更复杂生物体来说的朋友和工作)或帮助理解世界(例如,向生物体提供关于其周围环境的信息)。

与环境进行适应性动作-感知循环对生物体构成了巨大挑战。这主要是由于循环的递归性质,其中每次观察(由前一次动作引发)都会改变我们如何决定下一次动作,以引发下一次观察。控制和适应的可能性很多,但很少是有用的。然而在进化过程中,生物体已经成功发展出适应性策略来面对生存的基本挑战。这些策略在认知复杂程度上各不相同,简单生物体采用更简单和更刚性的解决方案(例如,细菌跟随营养梯度),更高级的生物体采用认知要求更高和更灵活的解决方案(例如,人类为实现远程目标而进行规划)。这些策略在选择和操作的时间尺度上也有所不同——从对环境威胁的简单反应或在进化时间尺度上出现的形态学适应,到在文化或发育学习过程中建立的行为模式,再到那些需要在与动作和感知相当的时间尺度上运行的认知过程(例如,注意力和记忆)。

这种多样性对生物学来说是一种福音,但对大脑和心智的正式理论来说却是一种挑战。总的来说,我们可以对此采取两种观点。一种观点是,不同的生物适应、神经过程(例如,突触交换和大脑网络)和认知机制(例如,感知、注意、社交互动)都是高度特异性的,需要专门的解释。这将导致哲学、心理学、神经科学、行为学、生物学、人工智能和机器人学等领域理论的激增,几乎没有统一的希望。另一种观点是,尽管表现形式多样,但生物体中行为、认知和适应的核心方面可以从第一原理得到连贯的解释。

这两种可能性对应两种不同的研究计划,在某种程度上,也对应不同的科学态度:“整洁派”与”杂乱派”(术语来自Roger Shank)。整洁派总是寻求超越大脑和心智现象(表面)异质性的统一。这通常对应于设计自上而下的规范性模型,从第一原理出发,试图尽可能多地推导出关于大脑和心智的知识。杂乱派则通过关注需要专门解释的细节来拥抱异质性。这通常对应于设计自下而上的模型,从数据开始,使用任何有效的方法来解释复杂现象,包括对不同现象的不同解释。

正如整洁派所假设的那样,是否可能从第一原理解释异质性的生物和认知现象?理解大脑和心智的统一框架是否可能?

本书肯定地回答了这些问题,并推进Active Inference作为理解大脑和心智的规范性方法。我们对Active Inference的处理从第一原理开始,并揭示其认知和生物学含义。

本书包括两个部分。这些部分针对想要理解Active Inference(第一部分)和寻求将其用于自己研究(第二部分)的读者。本书的第一部分在概念上和正式上介绍Active Inference,将其置于当前认知理论的背景中。第一部分的目标是提供对Active Inference的全面、正式和自包含的介绍:其主要构造及其对大脑和认知研究的含义。

本书的第二部分说明了使用Active Inference解释认知现象(如感知、注意、记忆和规划)的计算模型的具体例子。第二部分的目标是帮助读者理解使用Active Inference的现有计算模型并设计新的模型。简而言之,本书分为理论(第1部分)和实践(第2部分)。

Active Inference是表征生物体中贝叶斯最优行为和认知的规范性框架。其规范性特征体现在这样一个观念中:生物体中行为和认知的所有方面都遵循一个独特的命令:最小化其感官观察的惊奇。惊奇必须在技术意义上理解:它衡量智能体当前感官观察与其首选感官观察之间的差异程度——即那些保持其完整性的观察(例如,对鱼来说,在水中)。重要的是,最小化惊奇不能通过被动观察环境来完成:相反,智能体必须适应性地控制其动作-感知循环以获得所需的感官观察。这就是Active Inference的主动部分。

最小化惊讶(surprise)在技术层面上是一个具有挑战性的问题,其原因将在后面变得明显。主动推理(Active Inference)为这个问题提供了一个解决方案。它假设即使生物有机体不能直接最小化它们的惊讶,它们也可以最小化一个代理量——称为(变分)自由能。这个量可以通过神经计算来最小化,以响应(并预期)感觉观察。这种对自由能最小化的强调揭示了主动推理与激发它的(第一)原则之间的关系:自由能原则(Friston 2009)。

自由能最小化似乎是解释生物现象的一个非常抽象的起点。然而,从中可以得出许多形式和经验含义,并解决认知和神经理论中的一些核心问题。这些问题包括:参与自由能最小化的变量如何在神经元群体中编码;最小化自由能的计算如何映射到特定的认知过程,如知觉、动作选择和学习;以及

当主动推理智能体最小化其自由能时会出现什么样的行为。

正如上述主题列表所示,在本书中,我们主要关注生物有机体层面的主动推理和自由能最小化——无论是更简单的(如细菌)还是更复杂的(如人类)——以及它们的行为、认知、社会和神经过程。这种澄清对于将我们对主动推理的处理置于更一般的自由能原则(FEP)的背景下是必要的,该原则讨论了在神经信息处理之外更广泛的生物现象和时间尺度范围内的自由能最小化——从进化到细胞和文化层面(Friston, Levin et al. 2015; Isomura and Friston 2018; Palacios, Razi et al. 2020; Veissière et al. 2020)——这些超出了本书的范围。

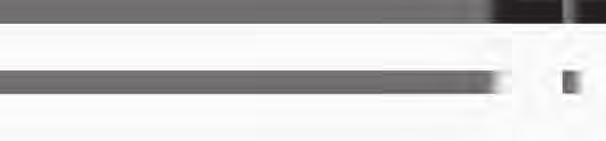

可以通过两条路径来阐释主动推理的动机:高路和低路;见图1.2。这两条路径为主动推理提供了两个不同但高度互补的视角:

• 高路到主动推理始于生物有机体如何在世界中持续存在并适应性地行动的问题,并将

主动推理的两条道路:高路(从右上方开始)和低路(从左下方开始)。

主动推理作为这些问题的规范性解决方案来激发。这种高路视角有助于理解主动推理的规范性本质:生物有机体必须做什么来面对它们的基本生存挑战(最小化它们的自由能)以及为什么(间接地最小化它们感觉观察的惊讶)。

• 低路到主动推理始于贝叶斯大脑(Bayesian brain)的概念,它将大脑视为一个推理引擎,试图优化其感觉输入原因的概率表示。然后它将主动推理作为(否则难以处理的)推理问题的特定变分近似来激发,这具有一定程度的生物学合理性。这种低路视角有助于说明主动推理智能体如何最小化它们的自由能——因此不仅将主动推理展示为一个原则,还展示为认知功能及其神经基础的机制性解释(即过程理论)。

在第2章中,我们阐述了主动推理的低路视角。我们从将知觉视为统计(贝叶斯)推理问题的基础理论(Helmholtz 1866)及其在贝叶斯大脑假设中的现代体现开始(Doya 2007)。我们将看到,为了执行这种(知觉)推理,生物有机体必须配备或体现一个关于如何生成其感觉观察的概率生成模型,该模型编码关于可观察变量(感觉观察)和不可观察(隐藏)变量的信念(概率分布)。我们将把这种推理观点扩展到知觉之外,涵盖动作选择、规划和学习问题。

在第3章中,我们将说明主动推理的互补高路视角。本章介绍了FEP和生物有机体最小化惊讶的必要性。此外,它解释了这个原则如何涵盖自组织的动力学和维持与环境分离的统计边界或马尔可夫毯(Markov blanket)的保持。这对于维持生物体的完整性至关重要,也是它们自创生(autopoiesis)的核心。

在第4章中,我们将更正式地解析主动推理。本章从第2章中贝叶斯大脑的讨论出发,阐述第3章自证明动力学与变分推理之间的数学关系。此外,本章还阐述了两个

用于制定Active Inference问题的生成模型类型。这些包括用于决策制定和规划的部分观察马尔可夫决策过程,以及与感官受体和肌肉接口的连续时间动力学模型。最后,我们看到这些模型中每一个的自由能最小化如何表现为动态信念更新。

在第5章中,我们将从正式处理转向Active Inference的生物学意义。通过从”大脑中发生变化的一切都必须最小化自由能”(Friston 2009)这一前提开始,我们将讨论自由能最小化中涉及的特定量(例如,预测、预测误差和精度信号)如何在神经元动力学中表现。这有助于将Active Inference的抽象计算原理映射到可由生理基质执行的特定神经计算。这对于在此框架下形成假设很重要,并确保这些假设可以通过测量数据得到验证。换句话说,第5章阐述了与Active Inference相关的过程理论。

在本书的第一部分中,我们将讨论Active Inference的几个特征方面。这些突出了它与寻求解释生物调节和认知的替代框架的不同之处——我们在此预览其中一些。

• 在Active Inference下,知觉和行动是实现同一目标的两种互补方式:自由能的最小化。知觉通过(贝叶斯)信念更新或改变你的想法来最小化自由能(和惊讶),从而使你的信念与感官观察兼容。相反,行动通过改变世界使其更符合你的信念和目标来最小化自由能(和惊讶)。这种认知功能的统一标志着Active Inference与其他将行动和知觉彼此孤立对待的方法之间的根本区别。学习是最小化自由能的另一种方式。然而,它与知觉在根本上没有不同;它只是在更慢的时间尺度上运作。知觉和行动之间的互补性将在第2章中详细阐述。

• 除了驱动当前行动选择以改变当前可用的感官数据外,Active Inference框架还容纳了规划——或者说是未来最优行动路线(或策略)的选择。这里的最优性是相对于预期自由能来衡量的,与上述在行动和知觉背景下考虑的变分自由能概念不同。实际上,虽然计算变分自由能依赖于现在和过去的观察,但计算预期自由能还需要预测的未来观察(因此称为预期)。有趣的是,策略的预期自由能包括两个部分。第一部分量化了策略预期解决不确定性的程度(探索),第二部分量化了预测结果与智能体目标的一致性程度(利用)。与其他框架相比,Active Inference中的策略选择自动平衡探索和利用。变分自由能和预期自由能之间的关系将在第2章中详细阐述。

• 在Active Inference下,所有认知操作都被概念化为对生成模型的推理——与大脑执行概率计算的想法保持一致——也称为贝叶斯大脑假设。然而,诉诸于一种特定的近似贝叶斯推理形式——即一种由第一原理驱动的变分方案——为过程理论增加了特异性。此外,Active Inference将推理方法扩展到很少被考虑的认知领域,并为生物大脑可能实现的模型和推理过程的类型增加了一些特异性。在某些假设下,Active Inference中使用的生成模型产生的动力学与计算神经科学中的广泛模型密切对应,如预测编码(Rao and Ballard 1999)和Helmholtz机器(Dayan et al. 1995)。变分方案的具体细节将在第4章中详细阐述。

• 在Active Inference下,知觉和学习都是主动过程,有两个原因。首先,大脑本质上是一个预测机器,它不断预测传入刺激而不是被动地等待它们。这很重要,因为知觉和学习过程总是由先验预测所语境化(例如,预期和意外刺激以不同方式影响知觉和学习)。其次,参与Active Inference的生物主动寻求显著的感官观察来解决它们的不确定性(例如,通过定向它们的传感器或选择信息丰富的学习事件)。知觉和学习的主动特征与当前大多数将它们视为基本被动过程的理论形成对比;这将在第2章中详细阐述。

• 行动本质上是目标导向和有目的的。它从期望的结果或目标开始(类似于控制论中设定点的概念

cybernetics),它被编码为先验预测。规划通过推断满足此预测的动作序列来进行(或等价地,减少先验预测与当前状态之间的任何预测误差)。Active Inference中动作的目标导向特性与早期控制论表述保持一致,但与大多数当前通过刺激-反应映射或状态-动作策略解释行为的理论不同。刺激-反应或习惯性行为随后成为Active Inference中更广泛策略族的特例。Active Inference的目标导向本质将在第2章和第3章中详细阐述。

[•] Active Inference的各种构念在大脑中具有合理的生物学类比。这意味着——一旦为手头的问题定义了特定的生成模型——人们就可以从作为规范理论的Active Inference转向作为过程理论的Active Inference,后者做出具体的经验预测。例如,感知推理和学习分别对应于突触活动的改变和突触效能的改变。预测的精确性(在预测编码中)对应于预测误差单元的突触增益。策略的精确性对应于多巴胺能活动。Active Inference的一些生物学后果将在第5章中详细阐述。

虽然本书的第一部分为读者提供了理解Active Inference的概念和形式工具,第二部分则聚焦于实际问题。具体而言,我们希望为读者提供理解现有的认知功能(和功能障碍)Active Inference模型并设计新模型的工具。为此,我们讨论了使用Active Inference的模型的具体示例。重要的是,Active Inference模型可以在不同维度上变化(例如,采用离散或连续时间表述,平面或分层推理)。第二部分的结构如下:

在第6章中,我们介绍构建Active Inference模型的方法。该方法涵盖了设计有效模型的基本步骤,包括识别感兴趣的系统、最合适的

生成模型形式(例如,表征离散或连续时间现象),以及模型中包含的具体变量。因此,本章提供了支撑后续章节讨论模型的设计原理介绍。

在第7章中,我们讨论解决离散时间表述问题的Active Inference模型;例如,隐马尔可夫模型(HMMs)或部分可观测马尔可夫决策过程(POMDPs)。我们的示例包括感知处理模型和离散觅食选择模型——即在决策点选择左转还是右转以获得奖励。我们还介绍了信息寻求、学习和新奇寻求等主题,这些可以通过离散时间Active Inference来处理。

在第8章中,我们讨论解决连续时间表述问题的Active Inference模型,使用随机微分方程。这些包括感知模型(如预测编码)、运动控制和序列动力学。有趣的是,正是在连续时间表述中,Active Inference的一些最具特色的预测出现了,比如运动生成源于预测的实现以及注意现象可以通过精确性控制来理解的观点。我们还介绍了包含离散和连续时间变量的混合Active Inference模型。这些模型允许同时评估离散选项之间的选择(例如,眼跳的目标)和选择产生的连续运动(例如,眼球运动)。

在第9章中,我们说明如何使用Active Inference模型分析行为实验数据。我们讨论基于模型的数据分析所需的具体步骤,从数据收集到模型表述及其反演,以支持单个参与者或群体层面的数据分析。

在第10章中,我们讨论Active Inference与心理学、神经科学、AI和哲学中其他理论的关系。我们还强调了Active Inference区别于其他理论的最重要方面。

在附录中,我们简要讨论理解本书最技术性部分所需的数学背景,包括Taylor级数逼近、变分Laplace、变分微积分等概念。作为参考,我们还以简洁形式呈现Active Inference中使用的最重要方程。

总之,本书的第二部分展示了使用主动推理(Active Inference)构建生物和认知现象模型的广泛多样性,以及设计新颖模型的方法论。除了特定模型的价值之外,我们希望我们的处理方法能够阐明使用统一的、规范性框架从连贯视角来处理生物和认知现象的价值。最终,这就是规范性框架的真正吸引力:提供统一的视角和指导原则,以协调看似不相关的现象——在本例中,这些现象包括感知、决策、注意力、学习和运动控制,每个现象在任何心理学或神经科学手册中都有独立的章节。

第二部分中突出显示的模型已被选择用于尽可能简单地说明特定要点。虽然我们涵盖了多个模型和领域,从离散时间决策到连续时间感知和运动控制,但我们显然忽略了许多其他同样有趣的模型。文献中存在许多其他主动推理模型,涵盖了诸如生物自组织和生命起源(Friston 2013)、形态发生(Friston, Levin et al. 2015)、认知机器人学(Pio- Lopez et al. 2016, Sancaktar et al. 2020)、社会动力学和生态位构建(Bruineberg, Rietveld et al. 2018)、突触网络动力学(Palacios, Isomura et al. 2019)、生物网络中的学习(Friston and Herreros 2016),以及心理病理状况,如创伤后应激障碍(post-traumatic stress disorder)(Linson et al. 2020)和恐慌症(panic disorder)(Maisto, Barca et al. 2021)等多样化领域。这些模型在许多维度上有所不同:有些更直接与生物学相关,而另一些则不太相关;有些是单智能体模型,而另一些是多智能体模型;有些针对适应性推理,而其他的针对不适应性推理(例如,在患者群体中),等等。

这一不断增长的文献体现了主动推理日益增长的流行性,以及在非常广泛的领域中使用它的可能性。本书的目标是为读者提供在自己的研究中理解和使用主动推理的能力——可能是为了探索其未曾预见的潜力。

本章简要介绍了从规范性视角解释生物问题的主动推理方法——并预览了这一视角的一些含义,这些含义将在后面的章节中展开。此外,本章强调了本书分为两部分,旨在分别帮助读者理解主动推理和在自己的研究中使用它。在接下来的几章中,我们将发展这里概述的低路径和高路径视角,然后深入探讨生成模型的结构和由此产生的消息传递。这些共同构成了原理上的主动推理,并为实践中的主动推理提供了预备知识。我们希望这些章节将说服读者,主动推理不仅提供了理解行为的统一原则,而且还提供了研究自主系统中行动和感知的可行方法。

我的思考首先、最后和始终都是为了我的行动。 ——威廉·詹姆斯(William James)

本章通过从亥姆霍兹(Helmholtzian)——或者也许是康德式(Kantian)——的”感知作为无意识推理”(Helmholtz 1867)观点以及在贝叶斯脑假设下最近出现的相关思想开始介绍主动推理。它解释了主动推理如何包含和扩展这些思想,通过将不仅仅是感知,还包括行动、规划和学习都视为(贝叶斯)推理的问题,并通过推导出对这些原本难以处理问题的原则性(变分)近似。

将大脑视为”预测机器”,或者是推理和预测世界外部状态的统计器官,有着悠久的传统。这个想法可以追溯到”感知作为无意识推理”(Helmholtz 1866)的概念。最近,这被重新表述为”贝叶斯脑”假设(Doya 2007)。从这个角度来看,感知不是将感官状态(例如,来自视网膜)纯粹自下而上转导为对外界事物的内部表征(例如,作为神经元活动模式)。相反,它是一个推理过程,将关于感觉最可能原因的(自上而下)先验信息与(自下而上)感官刺激相结合。推理过程作用于世界状态的概率表征,并遵循贝叶斯定理,该定理规定了在感官证据下的(最优)更新。感知不是一个被动的由外向内过程——其中信息从我们感官上皮的”外界”印象中提取。它是一个建构性的由内向外过程——其中感觉被用来确认或否认关于它们如何产生的假设(MacKay 1956, Gregory 1980, Yuille and Kersten 2006, Neisser 2014, A. Clark 2015)。

反过来,执行贝叶斯推理需要一个生成模型——有时被称为前向模型。生成模型是统计理论中的一个构造,用于生成关于观测的预测。它可以表述为观测 y 和产生这些观测的世界隐藏状态 x 的联合概率 P(y, x)。后者被称为隐藏或潜在状态,因为它们无法直接观测到。这个联合概率可以分解为两个部分。第一个是先验 P(x),它表示有机体在看到感官数据之前对世界隐藏状态的知识。第二个是似然 P(y | x),它表示有机体关于观测如何从状态中产生的知识。贝叶斯定律告诉我们如何结合这两个要素,实质上是将先验概率 P(x) 更新为接收观测后隐藏状态的后验概率 P(x | y)。对于需要基础概率理论简要回顾的读者,框 2.1 提供了一个总结。

贝叶斯推理是一个广泛的主题,出现在统计学、机器学习和计算神经科学等学科中。对相关主题的完整论述超出了本书的范围,但对于那些希望深入理解的人来说,有很好的资源可用(Murphy 2012)。然而,所有这一切都基于一个简单的规则。为了说明这个规则,我们考虑一个贝叶斯感知推理的例子(图 2.1)。想象一个人强烈相信她面对的是一个苹果。这个信念对应一个先验概率,简称先验。这个先验包括归因于苹果假设的概率和分配给替代假设的概率。在这个例子中,我们的替代假设是它不是苹果而是一只青蛙。在数值上,先验概率分布为苹果分配 0.9,为青蛙分配 0.1。注意,由于我们假设只有两个合理的(互斥的)假设,它们必须加起来等于一。这个人还配备了一个似然模型,该模型为青蛙会跳跃而苹果不会这一事实分配高概率。这个似然指定了从两个隐藏状态(青蛙或苹果)到两个观测(跳跃或不跳跃)的(概率)映射。

框 2.1

概率推理由两个关键规则支撑:概率的和规则与乘积规则,分别如下:

∑ P(x) = 1 x

P(x)P(y | x) = P(x, y)

和规则说明所有可能事件(x)的概率必须和(或积分)为一。乘积规则说明两个随机变量(x 和 y)的联合概率可以分解为一个变量的概率(P(x))与给定第一个变量时第二个变量的条件概率(P(y | x))的乘积。条件概率是如果我们知道另一个变量(这里是x)所取值时一个变量(这里是y)的概率。

我们可以从这些简单规则中得出两个重要结果。第一个是边际化操作。第二个是贝叶斯定律。边际化允许我们从联合分布中获得两个变量中只有一个变量的分布:

∑ P(x,y) = ∑ P(y)P(x | y) = P(y)∑ P(x| y) = P(y) x x x

乘积规则 和规则

y 的概率被称为边际概率,我们将此操作称为边际化掉 x。贝叶斯定律可以直接从乘积规则中获得:

P(x)P(y| x) = P(x,y) = P(y)P(x | y)

乘积规则 乘积规则

这让我们能够在先验与条件分布(似然)以及相关的边际和另一个条件分布(后验)之间进行转换。简单地说,贝叶斯定律只是说两个事物的概率等于给定第二个事物时第一个事物的概率乘以第二个事物的概率,这与给定第一个事物时第二个事物的概率乘以第一个事物的概率相同。

跳跃)。先验和似然一起构成了这个人的生成模型。

现在想象这个人观察到她的苹果-青蛙跳跃了。贝叶斯定律告诉我们如何从先验形成后验信念,考虑到跳跃的似然性。这个规则表达如下:

P(x | y ) = P(x)P(y | x) / P(y ) (2.1)

P(x = 青蛙) P(x = 苹果) P(x = 青蛙 | y = 跳跃) P(x = 苹果 | y = 跳跃)

0.1 0.9 观察跳跃 0.9 0.1

苹果 青蛙P(y = 跳跃 | x = 苹果) 0.01 P(y = 跳跃 | x = 青蛙) 0.99

P(y = 不跳跃 | x = 苹果) 0.99 P(y = 不跳跃 | x = 青蛙) 0.01

左上: 生物体的先验信念 P(x) 关于它将看到的物体,在进行任何观察之前,即对两种可能性的分类分布:苹果(概率0.9)和青蛙(概率0.1)。右上: 生物体在观察到物体跳跃后的后验信念 P(x | y)。后验信念可以在似然函数 P(y | x) 下使用贝叶斯定理计算。这显示在先验和后验下方,并指定如果物体是苹果,它跳跃的概率非常小(0.01),而如果它是青蛙,跳跃的概率要高得多(0.81)。(图中的概率条并非完全按比例绘制。)在这个特定情况下,从先验到后验的更新幅度很大。

在图2.1的似然模型下,分配给青蛙的后验概率是0.9,分配给苹果的概率是0.1。如框2.1所强调的,方程2.1的分母可以通过对分子进行边际化来计算。使用我们的苹果-青蛙示例,我们借此机会解释两种不同的惊讶(surprise)概念——这两种概念在Active Inference中都很重要。第一种,我们简称为惊讶,是负对数证据,其中证据是观察的边际概率。在我们的示例中,这是在生成模型下观察到任何跳跃行为的负对数概率。从贝叶斯角度来看,惊讶是一个非常重要的量。它衡量模型与其试图解释的数据的拟合程度有多差。直观地说,

我们可以计算出在我们的模型下观察到的(跳跃)行为的概率。记住,这个模型对苹果分配了非常高的先验概率,对青蛙分配了低先验概率。因此,我们跳跃的边际概率如下:

P(y = jumps) = ∑P(x,y = jumps) x

= ∑P(x)P(y = jumps| x) x

= P(x = frog )P(y = jumps|x = frog ) (2.2)

= 0.1 × 0.81 + 0.9 × 0.01 = 0.09

这意味着,在这个模型下,我们只会期望在100次观察中大约9次观察到跳跃行为。因此,如果我们相信图2.1中的模型,观察到这种现象应该感到惊讶。我们可以用惊讶度(ℑ)来量化这一点。这由 ℑ(y = jumps) = −ln P(y = jumps) = −ln(0.09) = 2.4 nats给出。这个数字越大,模型作为手头观察的恰当解释就越差。这让我们可以根据数据比较模型。例如,考虑一个替代模型,我们有先验信念认为青蛙100%的时间都能看到。按照方程2.2中相同的步骤,我们计算出大约0.2 nats的惊讶度。这是这些数据的更好模型,因为观察结果不那么令人惊讶。基于证据(或惊讶度)对模型进行评分的程序通常被称为贝叶斯模型比较。对于更复杂的模型,惊讶度的形式可能不那么简单。表2.1提供了一系列概率分布的惊讶度形式(省略常数)——除了我们示例中的分类概率之外。至关重要的是,这让我们可以谈论支持范围与此处使用的简单示例不同的概率分布的惊讶度。这很重要,因为世界生成感觉数据的方式因数据类型而异。我们可能因为遇到我们不期望看到的某人的面孔而感到惊讶(分类分布),或者我们可能因为外面比我们预期的更冷而感到惊讶(连续分布)。表2.1可以看作是我们在后续章节构建生成模型时可支配的概率分布组合。更一般地说,它说明了惊讶是一个可以针对任何给定概率分布族进行评估的概念。

表2.1 概率分布和惊讶度

| 分布 | 支持 | 惊讶度(ℑ) |

|---|---|---|

| 高斯分布 | x ∈ ℝ | ½(x − μ)ᵀΠ(x − μ) |

| 多项分布¹ | xᵢ ∈ (0, . . . , N) | −∑xᵢ ln dᵢ |

| i ∈ {1, . . . , K} | ||

| ∑xᵢ = N | ||

| 狄利克雷分布² | xᵢ ∈ (0,1) | ∑(1 − αᵢ)ln xᵢ |

| i ∈ {1, . . . , K} | ||

| ∑xᵢ = 1 | ||

| 伽马分布 | x ∈ (0,∞) | (bx + (1 − a) ln x) |

注释:1. 特殊情况包括分类分布(K > 2,N = 1),二项分布(K = 2,N > 1),和伯努利分布(K = 2,N = 1)。2. 特殊情况是贝塔分布(K = 2)。

第二种惊讶概念(稍微令人困惑地)被称为贝叶斯惊讶。这是衡量我们在观察后必须更新信念程度的指标。换句话说,贝叶斯惊讶量化了先验概率和后验概率之间的差异。这提出了如何量化两个概率分布不相似性的问题。来自信息论的一个答案是使用Kullback-Leibler (KL) 散度。这定义为两个对数概率之间的平均差异:

D_{KL}[Q(x)||P(x)] ≜ E_{Q(x)}[ln Q(x) − ln P(x)] (2.3)

这里的 E 符号表示平均值(或期望值),如框 2.2 中所述。使用 KL 散度,我们可以量化示例的贝叶斯惊讶:

D [KL] [P(x| y) || P(x)]

= P(x = frog | y = jumps) ln [P(x = frog | y = jumps) − ln P(x = frog )] (2.4)

= 0.9 ln(0.9) [− ln(0.1)] + 0.1 ln(0.1) [− ln(0.9)]

≈ 1.8 nats

这衡量了信念更新的量,而不是简单地衡量观察结果的不可能性。为了突出惊讶和贝叶斯惊讶之间的区别,考虑一下如果我们坚持先验信念,即我们总是会看到苹果,会发生什么。贝叶斯惊讶将为零,因为先验信念

主动推理的低级路径 21

框 2.2 期望值

引用随机变量 x 的期望值是很有用的,通常记作 Ex。这是变量可以假设的所有值的加权平均值,按其概率加权。对于离散随机变量(只能取可数个可能值),这由加权和给出:

Ex = ∑ xP(x)

例如,对于只能假设两个值(1和2)且概率相等为 1/2 的离散(数值)变量,这是 Ex = 1 × 1/2 + 2 × 1/2 = 3/2。

对于连续随机变量(可以取无限多个值),求和被积分替代。期望值也可以应用于随机变量的函数,而不是直接应用于变量。例如,如果我们有一个函数 f(x),其中 x 具有某种连续分布,期望值定义如下:

E[f(x)] = ∫ f(x)p(x) dx

我们将在本书中使用这种记号,其中函数 f(x) 通常是对数概率或对数概率比。

是如此确信,以至于我们在观察后根本不更新它。然而,惊讶程度非常大(4.6 nats),因为苹果跳跃是极不可能的。

注意,虽然我们基于一个非常简单的生成模型说明了贝叶斯推理,但它适用于任何复杂性的生成模型。在第 4 章中,我们将重点介绍支持主动推理中大多数应用的两种生成模型形式。

有两个重要点将上述推理方案与感知的生物学和心理学理论联系起来。首先,讨论的推理程序需要编码预测(来自先验)的自上而下过程和编码感觉观察(通过似然调节)的自下而上过程的相互作用。这种自上而下和自下而上过程的相互作用使推理观点区别于仅考虑自下而上过程的替代方法。此外,它

第 2 章 22

在现代感知的生物学处理中是核心的,例如预测编码(在第 4 章中讨论),这是这里讨论的更一般的(贝叶斯)推理方案的特定算法(或过程级别)实现。

其次,贝叶斯推理是最优的。最优性相对于被优化(即最小化)的成本函数来定义,对于贝叶斯推理,这被称为变分自由能——与惊讶密切相关。我们在第 2.5 节中回到这一点。通过明确考虑隐藏状态的完整分布,它自然地处理不确定性,因此避免了仅考虑隐藏状态点估计(例如,x 的平均值)的替代方法的局限性。一种这样的替代方法是最大似然估计,它简单地选择最可能产生手头数据的隐藏状态。这样做的问题是,这样的估计忽略了隐藏状态的先验合理性和围绕估计的不确定性。贝叶斯推理不会受到这些局限性的影响。然而,尽管在客观评估模型是否适合目的时使用了惊讶,但重要的是要认识到推理本身是主观的。推理的结果在任何客观意义上都不一定准确(即,有机体的信念可能实际上不对应于现实),至少有两个重要原因。首先,生物生物基于有限的计算和能量资源运作,这使得精确的贝叶斯推理变得难以处理。这需要近似,排除了精确贝叶斯最优性的保证。这些近似包括变分后验的概念——基于称为平均场近似的东西——这是第 4 章的核心。

最优性被认为是主观的第二个原因是,机体基于主体的生成模型(generative model)运作,该模型描述了观察结果是如何生成的,但这个模型可能与生成其观察结果的真实生成过程(generative process)相符,也可能不相符。这并不是说生成模型应该对应于生成过程。实际上,可能存在一些模型能够为手头的数据提供更好的(例如,更简单的)解释,而不是实际生成这些数据的过程——这可以通过它们的相对惊讶度来量化。一个很好的例子是错觉(illusions),对于错觉,人们会对视觉输入找到一个更简单的解释,这与调皮的心理物理学家精心设计视觉刺激的方式有关。

生成模型本身可能会随着新经验的获得而被优化。这可能会收敛到生成过程,也可能不会。图2.2说明了

[从 http://direct.mit.edu/books/oa-monograph/chapter-pdf/2004455/c001300_9780262369978.pdf 下载,访客于2022年4月2日访问] [通往主动推理的低阶路径 23]

[模型] [隐藏] [过程] [隐藏]

[状态] [状态]

x [y] [x*]

[推断]

[状态] [u] [观察]

[行动]

生成过程和生成模型。两者都代表了在给定隐藏状态(x)的情况下可能生成感觉数据(y)的方式,并通过从x到y的箭头表示因果关系。区别在于,过程是数据生成的真实因果结构,而模型是用来对数据原因进行推断的构造(即,使用观察结果来得出推断状态)。生成模型和生成过程的隐藏状态是不同的。机体的模型包括关于隐藏状态的一系列假设(x),这些假设不一定包括生成过程的隐藏状态x∗的真实值。换句话说,我们用来解释感觉的模型可能包括外部世界中不存在的隐藏状态,反之亦然。行动(u)是基于在生成模型下做出的推断而生成的。这里行动被显示为生成过程的一部分,对世界进行改变,尽管它是从模型下得出的推断中选择的。

这一点以及真实环境偶然性(或生成过程)与机体无法接触到的机体世界生成模型之间的差异。在这个特定例子中,生成过程处于机体无法接触到的真实状态x*中。然而,机体和世界是相互耦合的,x*生成机体感知到的观察y。机体可以使用这个观察y和贝叶斯法则来推断生成模型中某些解释变量或隐藏状态的(后验概率)。在图中,我们将x*和x都称为隐藏状态,强调两者都是不可观察的。然而,它们存在微妙的差异:前者是机体生成模型的一部分,而后者是生成过程的一部分,机体无法接触到。此外,x*和x不一定存在于同一空间中。可能外部世界的隐藏状态取值超出了大脑可用解释空间的范围。相反,可能大脑的解释包括

[从 http://direct.mit.edu/books/oa-monograph/chapter-pdf/2004455/c001300_9780262369978.pdf 下载,访客于2022年4月2日访问] [24 ] [[第2章]]

外部世界中不存在的变量。例如,前者可能是5维的,后者是2维的,或者一个可能是连续的,另一个是分类的。

生成模型和过程之间的区别对于将关于推断最优性的心理学声明置于背景中很重要——在这些声明有效的程度上——在贝叶斯观点下,这总是取决于机体的资源。我们所说的资源是指其特定的生成模型,以及有限的计算和记忆资源。

到目前为止的讨论对所有贝叶斯大脑理论都是共同的。然而,我们现在介绍主动推理(Active Inference)提供的简单但根本性的进展。这从上面讨论的相同推断视角开始,但扩展到将行动视为推断。这个想法源于贝叶斯推断最小化惊讶度(或等价地,最大化贝叶斯模型证据)的概念。到目前为止,我们考虑了通过执行推断来计算惊讶度时会发生什么——并根据模型最小化惊讶度的能力来选择模型。然而,惊讶度不仅依赖于模型,还依赖于数据。通过对世界采取行动来改变数据生成的方式,我们可以通过选择在我们模型下最不令人惊讶的那些数据来确保模型适合目标。

配备了产生行动的机制,有机体能够与其环境进行相互交换;见图2.2。在动物中,这种机制采用运动反射回路的形式。基本上,对于每个行动-感知循环,环境向有机体发送一个观察。有机体使用(近似的)贝叶斯推理来推断其最可能的隐藏状态。然后它产生一个行动并将其发送到环境中,试图使环境变得不那么令人惊讶。环境执行该行动,产生新的观察,并将其发送给有机体。然后,一个新的循环开始。这里的顺序描述是为了教学目的而写的;重要的是要意识到这些实际上不是离散的步骤,而是连续的动力学过程。

主动推理超越了对感知和行动具有相同(推理)性质的认识。它还假设感知和行动都合作实现单一目标——或优化一个函数——而不是像更常见假设的那样有两个不同的目标。在

[Downloaded from http://direct.mit.edu/books/oa-monograph/chapter-pdf/2004455/c001300_9780262369978.pdf by guest on 02 April 2022] [主动推理的低路 25]

主动推理文献中,这个共同目标已经以各种(非正式和正式)方式被描述,包括最小化惊讶、熵、不确定性、预测误差或(变分)自由能。这些术语彼此相关,但有时它们的关系并不立即明确,造成一些困惑。此外,这些术语在不同的语境中使用;例如,预测误差最小化在生物学语境中使用,其目标是解释大脑信号,而变分自由能最小化在机器学习中使用。

在接下来的两节中,我们将澄清主动推理智能体通过感知和行动最小化的单一量是变分自由能。然而,在某些条件下,人们可以将变分自由能减少到其他概念,如生成模型与世界之间的差异,或期望与观察之间的差异(即预测误差)。我们将在2.5节正式介绍变分自由能。为简单起见,2.4节专注于感知和行动最小化生成模型与世界之间差异的方式。

建立了基于贝叶斯推理的感知和行动之后,我们现在转向推理目标的问题。换句话说,推理在优化什么?在认知科学中,通常假设感知和行动等不同认知功能优化不同的目标。例如,我们可以假设感知最大化重构的准确性,而行动选择最大化效用。相反,主动推理的一个基本见解是感知和行动都服务于完全相同的目标。作为第一个近似,感知和行动的这个共同目标可以表述为最小化模型与世界之间的差异。有时这以预测误差的形式操作化。

为了理解感知和行动如何减少模型与世界之间的差异,再次考虑一个期望看到苹果的人的例子(图2.3)。她产生一个自上而下的视觉预测(例如,关于看到红色的东西而不是跳跃的东西)。这种视觉预测与感觉(例如,跳跃的东西)进行比较——这种比较导致差异。

[Downloaded from http://direct.mit.edu/books/oa-monograph/chapter-pdf/2004455/c001300_9780262369978.pdf by guest on 02 April 2022] [26] [[第2章]]

[预测] [观察]

[差异]

[感知:] [行动:] [改变信念] [改变世界]

[图2.3] [感知和行动都最小化模型与世界之间的差异。]

这个人可以用两种方式解决这种差异。首先,她可以改变对所看到事物的想法(即青蛙)以适应世界,从而解决差异。这对应于感知。其次,她可以注视最近的苹果树,看到非常像苹果的东西。这也解决了初始差异,但以不同的方式。这需要改变世界——包括她的注视方向——和后续的感觉以适应她心中的想法,而不是改变她的想法以适应世界。这是另一个适应方向。这是行动。

虽然在苹果和青蛙的世界中改变注视方向似乎不如改变想法那么令人信服,让我们考虑另一个例子:一个期望他的体温在某个范围内的人通过中央温度感受器感知到高温。这是令人惊讶的,呈现出需要解决的重大差异。如前面的例子一样,他有两种方式来最小化这种差异,分别对应感知(改变想法)和行动(改变世界)。在这种情况下,简单地改变想法似乎不是很适应性的,但采取行动降低体温(例如,通过打开窗户)是适应性的。

这说明了在主动推理中,边缘概率或惊奇(例如,关于体温)的概念具有超越标准贝叶斯处理的意义,吸收了诸如稳态和变稳态设定点等概念。从技术上讲,主动推理主体配备了模型,这些模型对它们偏好访问的状态或偏好获得的观察结果分配高边缘概率。对于鱼来说,这意味着在水中的高边缘似然。这意味着

有机体隐含地期望它们采样的观察结果在其舒适区内(例如,生理界限内)。

总结来说,我们已经讨论了在任何时间点上,我们如何通过感知和行动最小化我们的模型与我们的世界之间的差异。我们是调整信念还是调整数据,取决于我们持有这些信念的信心。在我们的苹果例子中,信念以足够的不确定性被持有,因此将被更新而不是被付诸行动。相比之下,在温度例子中,我们对我们的核心温度相当有信心,因为它支撑着我们的存在。这种信心意味着我们更新我们的世界以符合我们的信念。然而,在主动推理中,感知和行动比这种处理方式所暗示的更加协作。为了理解为什么会这样,下一节将从受限的差异(或预测误差)概念转向更一般的变分自由能概念——这是主动推理实际最小化的量,它包含预测误差作为特殊情况。

到目前为止,我们已经在旨在最小化惊奇的贝叶斯方案内讨论了感知和行动。然而,支持感知和行动的精确贝叶斯推理在大多数情况下在计算上是难以处理的,因为两个量——模型证据(P(y))和后验概率(P(x | y))——由于两个可能的原因无法计算。首先,对于复杂模型,可能有许多类型的隐藏状态都需要边缘化,使问题在计算上难以处理。其次,边缘化操作可能需要分析上难以处理的积分。主动推理诉诸于可处理的贝叶斯推理的变分近似。

变分推理的形式化将在第4章中展开。在这里,足以说进行变分贝叶斯推理意味着用两个可以高效计算的量来替代两个难以处理的量——后验概率和(对数)模型证据——即近似后验Q和变分自由能F。近似后验有时被称为变分或识别分布。负变分自由能也被称为证据下界(ELBO),特别是在机器学习中。

最重要的是,贝叶斯推理的问题现在变成了优化问题:变分自由能F的最小化。变分自由能是一个植根于统计物理学的量,在主动推理中起着基本作用。在公式2.5中,它被记作F[Q, y],因为它是近似后验Q的泛函(函数的函数)和数据y的函数:

F[Q,y] = − E[Q][(][x][)][ln P(y,x)] − H[Q(x)] 能量 熵

= D[KL][Q(x) || P(x)] − E[Q][(][x][)][ln P(y |x)] (2.5) 复杂性 准确性

= D[KL][Q(x) || P(x | y)] − ln P(y) 散度 证据

变分自由能乍看可能是一个抽象概念,但当它被分解为认知科学中更直观和熟悉的量时,它的性质和在主动推理中所起的作用就变得明显了。这些关于变分自由能的视角都提供了关于自由能最小化意味着什么的有用直觉。我们在这里简要勾勒这些直觉,因为当我们在本书第二部分讨论例子时它们将变得重要。

公式2.5的第一行显示,关于Q的最小化需要与生成模型(能量)的一致性,同时还要保持高后验熵。后者意味着,在缺乏数据或精确先验信念的情况下(这些只影响能量项),我们应该对世界的隐藏状态采用最大不确定性信念,符合Jaynes的最大熵原理(Jaynes 1957)。简单地说,当我们没有信息时,我们应该不确定(采用高熵信念)。术语能量继承自统计物理学。具体来说,在Boltzmann分布下,系统采用某种配置的平均对数概率与该配置相关的能量成反比——即,将系统从基线配置移动到这种配置所需的能量。

第二行强调了自由能最小化作为为感官数据寻找最佳解释的解释,这必须是能够准确解释数据的最简单(最小复杂性)解释(参见Occam剃刀)。复杂性-准确性权衡

在多个领域中反复出现,通常在数据分析的模型比较情境中。在统计学中,有时使用其他模型证据的近似方法,如贝叶斯信息准则或赤池信息准则。当我们描述如何在基于模型的数据分析过程中使用自由能进行模型比较时——以及在结构学习和模型约简的情境中——复杂性-准确性权衡将变得重要。从认知角度来看,推断具有最小复杂性的解释也很重要。这是因为人们可以假设更新所知(先验)以适应数据需要认知成本(Ortega and Braun 2013, Zénon et al. 2019);因此,与先验偏差最小的解释是可取的。

从这个观点来看,复杂性成本就是贝叶斯惊奇。换句话说,“我改变想法”的程度由先验和后验之间的散度来量化。这意味着对我的感觉的每一个准确解释都会产生复杂性成本,而这个成本衡量贝叶斯信念更新的程度。因此,变分自由能衡量准确性和复杂性之间的差异。

最后一行将自由能表示为负对数证据的界限(见图2.4)。如图左侧所示,自由能是负对数证据的上界,其中界限是Q与如果可能进行精确(而非变分)推理所获得的后验概率之间的散度。图的右侧显示随着散度减少,

自由能

F[Q, y] = D[KL][Q(x) || P(x | y)] - ln P(y)

散度 证据

感知:改变 行动:改变信念以最小化 观测以散度 最大化证据

图2.5 感知和行动在最小化变分自由能中的互补作用

自由能接近负对数证据(惊奇)——如果近似后验Q与精确后验P(x | y)匹配,则等于惊奇。这为感知推理作为通过尽可能优化我们的近似后验Q来降低自由能的一种方式提供了形式化动机。

方程2.5的最后一行显示,感知推理不是最小化自由能的唯一方法。我们也可以通过行动改变感官数据来改变对数证据项。这种分解从认知角度来看很有趣,因为最小化散度和最大化证据分别对应于感知和行动这两个互补的子目标;见图2.5。注意如果我们用P(x | y)替换Q,上述所有表达式都成为刻画负对数证据的方式,推广到精确推理的情况。

总之,主动推理(Active Inference)相当于通过感知和行动最小化变分自由能。这种最小化允许有机体使其生成模型适应它采样的观测。这种适应既是感知充分性(由散度项表示)的衡量,也是对外部状态的主动控制——在这种意义下,它允许有机体将自己维持在由生成模型定义的合适的偏好状态集合中。表达这一点的另一种方式是诉诸散度与

证据分解的自由能。将负对数证据等同于惊奇,并注意到最小可能散度是零,我们看到自由能是惊奇的上界。这意味着它只能大于或等于惊奇。当有机体(通过感知)最小化其散度时,自由能成为惊奇的近似。当有机体额外改变它收集的观测(通过行动)使其更相似于先验预测时,它最小化了惊奇。

变分自由能具有回顾性方面,因为它是过去和现在观测的函数,而不是未来观测的函数。虽然它促进基于过去数据对未来的推理,但它不直接促进基于预期未来数据的前瞻性推理形式。这在规划和决策制定中很重要。在这里,我们基于预期带来的未来观测推断最佳行动或行动序列(策略)。做到这一点需要我们用期望自由能的概念来补充我们的生成模型。

预期自由能将主动推理扩展到包含一种本质上前瞻性的认知形式:规划。规划一系列行动,比如从迷宫中逃脱所需的一系列移动,需要考虑人们期望收集的未来观察。例如,可能行动路线的后果包括向右转后看到死胡同,或者经过三次左转后看到出口。每个可能的行动序列被称为策略。这突出了主动推理在行动和策略之间做出的重要区别。前者是直接影响外部世界的东西,而后者是关于行为方式的假设。这意味着主动推理将规划和决策视为推断该做什么的过程。这将规划牢固地带入贝叶斯推理的领域,意味着我们必须像之前一样指定先验和似然(第2.1节)。然而,替代青蛙和苹果的是行为策略(我更可能朝池塘看还是朝树看?)。在本节中,我们首先简要处理似然——即追求策略的后果——然后转向先验。这就是预期自由能发挥作用的地方。

依赖策略的结果并不是立即可得的(它们在未来),但可以通过将生成模型的两个组件链接在一起来预测它们。第一个是我们关于隐藏状态如何作为策略函数变化的信念。我们将在第4章详细讨论这一点。现在,我们使用符号x来表示隐藏状态随时间的序列或轨迹,并且我们将轨迹以生物追求的策略(π)为条件。这意味着我们模型的动态部分由P(x | π)给出。从我们之前的青蛙-苹果例子中,策略可能是去池塘或果园的决定,这改变了遇到青蛙与苹果的概率。

模型的第二个组件是通常的似然分布。这描述了在每个可能状态下期望哪些观察(例如,跳跃或不跳跃,以青蛙或苹果为条件)。通过结合这两个组件,有机体可以间接地运用其生成模型来进行”如果”或反事实模拟,模拟其可能行动或策略的后果——例如,“如果我去池塘会发生什么?”对状态进行边际化,这给我们策略的边际似然或证据(P(y~ | π)),或这个量的自由能近似。换句话说,了解策略如何影响状态转换让我们能够计算在该策略下观察序列的似然。正如我们在方程2.1中看到的,我们需要将这个似然与先验概率结合来计算追求策略的后验概率。

主动推理将这个规划问题分解为两个连续的操作。第一个是为每个策略计算分数。第二个是形成关于追求哪个策略的后验信念。前者定义了关于要追求策略的先验信念,其中最佳策略具有高概率,最差策略具有低概率。在主动推理下,策略的好坏由相关的负预期自由能评分——就像模型拟合的好坏由该模型的负自由能评分一样。策略的预期自由能(G)与变分自由能(F)不同,因为计算前者需要考虑未来的、依赖策略的观察。相比之下,后者只考虑现在和过去的观察。因此,计算预期自由能涉及使用生成模型预测如果执行每个策略将产生的未来观察——直到某个规划视界。此外,由于策略在多个时间步骤中展开,每个策略预期自由能的最终测量必须整合该策略的所有未来时间步骤。

每个策略的预期自由能可以转换为质量分数(通过取其负值),并且对于进行主动推理的智能体直接可用作先验。这是因为——与物理学中势能概念一致——预期自由能在对数概率空间中表示。将其转换为关于策略的信念(或概率分布)就是指数化(以撤销对数)和归一化(以确保与框2.1中求和规则的一致性)的问题。与较低预期自由能相关的策略被分配较高概率,成为有机体期望追求的策略。

最终,推断我们正在追求特定策略对我们预测的感官数据有后果。例如,包含弯曲我肘部的策略需要关于来自肱二头肌和肱三头肌的本体感受输入的预测。这提供了规划和行动之间的联系,因为与计划相关的预测转化为解决与测量的本体感受数据差异的行动(见第2.3节)。

到目前为止,我们一直假设在规划过程中,生物体根据策略的期望自由能来评估策略。然而,我们一直在回避期望自由能实际上是什么这个问题。就像变分自由能一样,期望自由能可以用几种数学上等价的方式进行分解。每种分解都为这个量提供了不同的视角。

G( π ) = − E[Q][(]x [!][,][y] [!][|] [ ( | y ! ) || ( | )]] [π] [)] D [KL] [ Q x ! , π Q x ! π − E[Q] [(][y] [!][|] | )] [π] [)] [ln P ( y ! C ! [信息增益] [实用价值]

= E[Q] ( [!][|] [ [π] [)]H[ P(y ! | x !)]] + D[KL][Q(y ! |π ) || P(y ! |C)] [风险(结果)] [期望模糊性]

≤ E ! [Q] [(] ! x [!] [|] [ H [ P ( y |)]] [π] [)] x + D[KL][Q(x !|π ) || P(x !|C)] (2.6) [风险(状态)] [期望模糊性]

= − E[Q][(]x [!][,][y] [!][|][π] [)][lnP(y ! ,x ! | C)] − H[Q(x ! | π )] [熵] [期望能量]

Q(x !,y ! | π ) ! Q(x !|π )P(y ! | x !)

其中第一种分解从直觉上来说可能是最有用的,因为它将寻求新信息的价值(即探索)用与寻求偏好观测的价值(即开发利用)完全相同的单位(nats)来表达,从而解决了行为心理学中经典的开发-探索困境。通过最小化期望自由能,这些项之间的相对平衡决定了行为主要是探索性的还是开发利用性的。注意实用价值作为对观测的先验信念出现,其中C参数包括偏好。先验信念和偏好之间(可能不直观的)联系在第7章中详细阐述;目前我们注意到这个项可以被视为期望效用或价值,假设有价值的结果是表征每个智能体的结果类型(例如,37°C的体温)。

信息增益项继承自我们在2.5节中考虑的散度,它确保自由能是惊奇的上界。然而,有一个转折:我们不是最小化散度,而是想要选择最大化期望散度的策略——因此是信息增益。这种转换是由于我们现在对尚未观测到的结果的对数概率取平均。这是一个微妙的点,可以通过结果角色的转换来理解。当评估结果的自由能时,结果是后果。然而,当评估期望自由能时,结果扮演原因的角色,因为它们是未来隐藏但解释现在决策的变量。

随后的信息增益惩罚那些从观测到状态存在多对一映射的观测——即在不同状态下可以获得相同观测——因为这妨碍了精确的信念更新。在人工智能和机器人学中,带来相同观测的状态(例如,看起来相同的迷宫的两个T型路口)有时被称为别名化状态,通常用简单方法(即没有推理或记忆的刺激-响应)很难处理。问题在于我们无法仅从当前观测就知道我们处于哪个状态。主动推理首先避免陷入这样的情况,因为它们的信息增益潜力很低。

一个简单的例子可能有助于阐明信息增益(或认识价值)和实用价值之间的区别,并强调为什么在大多数现实情况下,实用价值和认识价值需要协同追求。想象一个想要浓缩咖啡的人,他知道镇上有两家好咖啡店:一家只在周一到周五开放,另一家只在周末开放。如果他不知道今天是星期几,他必须首先选择一个具有认识价值并解决他不确定性的行动(即看日历的认识行动)——只有在那之后才选择一个具有实用价值并带来奖励的行动(即去正确咖啡店的实用行动)。这个场景说明了在大多数不确定情况下,人们必须首先执行认识行动来解决不确定性,然后才能自信地选择实用行动。不考虑选择的认识可供性的策略选择方法只能使用随机数生成器来选择策略——往往会错过他们的浓缩咖啡。因此,只考虑实用价值的方案通常局限于没有认识不确定性的情况,比如一个已经知道星期几的人可以直接前往正确的咖啡店。

方程2.6中的第二个分解是基于风险和期望模糊性的。这些术语是复杂性和不准确性的类似概念:风险是期望复杂性,模糊性是期望不准确性。风险是经济学中的一个常见概念,对应于政策与其后果之间可能存在一对多映射的事实——即在同一政策下,可能(偶然地)获得几种不同的结果。一个例子是具有随机奖励的赌博场景(例如,独臂老虎机),其中人们可能知道奖励分布——比如说,10%的时间会获得奖励。这在经济学中被称为风险情况,因为在相同的行动(拉杠杆)之后,可能获得两种不同的观察结果(奖励或无奖励)。这意味着必须选择能够适应不确定性的政策或计划。在风险敏感方案——如主动推理——中,游戏是选择其概率结果在KL散度意义上匹配个人先验偏好的政策。简而言之,当复杂性和风险都是偏离先验信念的度量时,最小化复杂性成本就变成了最小化风险。

类似地,模糊性对应于由于状态和结果之间的模糊映射而导致的期望不准确性。如果预期结果的分布高度分散(或熵增),即使我们完全确信地知道产生这些结果的状态,映射仍然是模糊的。例如,抛硬币时正面或反面的概率,在晴天或雨天的条件下,将是最大模糊的,因为天气与正面或反面的50-50概率之间没有关系。因此,不可能通过观察反面来获得关于天气的信息。

[Downloaded from http://direct.mit.edu/books/oa-monograph/chapter-pdf/2004455/c001300_9780262369978.pdf by guest on 02 April 2022] [36] [[第2章]]

通过观察反面。请注意,大多数情况都具有风险和模糊性——这意味着状态与结果之间以及政策与结果之间存在多对一的映射。回想一下,结果(观察)是唯一可以被观察到的变量类型。主动推理自动处理这些情况,因为期望自由能包含风险和模糊性项。

方程2.6的第三行突出了期望自由能的另一种表述,通过将风险重新表达为关于状态的信念与根据状态定义的偏好之间的散度。这种形式的一个吸引人的特点是,它可以重新排列成期望能量和熵,类似于变分自由能(方程2.5)。虽然这种关系很有吸引力,但这种表述的缺点是它假设状态空间是先验已知的,这样先验偏好可以与状态相关联。在大多数情况下,这不是问题,在状态或结果方面定义偏好的选择几乎没有实际意义。然而,通常的做法是根据结果来指定偏好——允许状态空间本身被学习,同时保持外在动机。

总之,期望自由能可以用风险和模糊性以及实用价值和认识价值来分解。这些分解很有意思,因为它们允许对主动推理处理的各种情况进行正式理解。此外,它们有助于理解主动推理如何包含几种决策方案——这些方案可以通过忽略期望自由能的一个或多个组件来获得(图2.6)。如果移除先验偏好,实用价值就变得无关紧要,所有行动都由认识可供性驱动——因此这样的方案只能处理不确定性的解决。一旦先验偏好被移除,(负)期望自由能在注意探索的背景下被称为期望Bayesian surprise,在自主学习的背景下被称为内在动机。如果移除模糊性,产生的方案对应于控制理论中的风险敏感或KL控制。最后,如果同时移除模糊性和先验偏好,剩下的唯一命令就是最大化观察(或状态,如果使用方程2.6第三行的表述)的熵。这可以解释为不确定性采样(或保持选择开放)。主动推理显示了这些方案之间的正式关系以及它们适用的(有限)情况。

[Downloaded from http://direct.mit.edu/books/oa-monograph/chapter-pdf/2004455/c001300_9780262369978.pdf by guest on 02 April 2022] [主动推理的低路径 37]

G[(][][) = –] Q [ln ] [ | ][(] ỹ [| )] [[] P [(] *ỹ**C* [)][]][ – ]*D**KL* [[]Q ]Q[ (]x[ |][][) || ]Q[ (]ỹ[ | ][][) ]Q[ (]x[ | ][][)][]]

[1] [2] [3] [4] [5]

[2 3 4 5] [1] [3 4 5]

D *D**KL* [[]Q[(] ỹ [|] ) || ]P[ (] ỹ [|][ C] )][]] KL [[] Q [(] ỹ[ | ]x [) ]Q[ (] x[ | ][][) || ]Q[ (] ỹ[ | ][][) ]Q[ (] x[ | ][][)] [][-]风险敏感政策 [[] [= ]Q [(] ỹ [| )] D KL [[] Q [(] x[ | ]ỹ, [) || ]Q[ (] x[ | ][][)] []]] KL控制

BAYESIAN惊奇 [1]

最优BAYESIAN设计 [[][ln][ P][ (] ỹ [|][ C] )][]]

信息最大化 BAYESIAN决策理论 原理

期望效用理论

图2.6

虽然我们已经仔细分解了预期自由能量,使得不同的人可能会以不同方式理解这个函数,但没有对错之分的分解方式。在本书的后半部分,我们将看到为什么某种类型的自主系统必须在存在的过程中选择看起来像是在最小化预期自由能量的行动。这种观点意味着认识性(探索性)与实用性(开发性)要求之间没有特权地位——风险与歧义性之间也没有。这些(可能是错误的)二分法只是同一存在硬币的两面。

在介绍了变分自由能量和预期自由能量这两个不同概念后,我们现在可以考虑它们共同实现了什么。这代表了通向主动推理的低路的终点,从无意识推理的概念开始,经过贝叶斯大脑、感知与行动的二元性,最后到作为推理的规划。

[从 http://direct.mit.edu/books/oa-monograph/chapter-pdf/2004455/c001300_9780262369978.pdf 下载,访客于2022年4月2日] [38] [[第2章]]

变分自由能量是主动推理的核心。它衡量内部生成模型与(当前和过去)观察之间的拟合程度。通过最小化变分自由能量,生物体最大化了它们的模型证据。这确保了生成模型成为环境的良好模型,并且环境符合该模型。

预期自由能量是为规划评分替代策略的一种方法。这本质上是前瞻性的——它考虑可能的未来观察——以及反事实的——可能的未来观察以人们可能追求的策略为条件。预期自由能量衡量相对于首选(未来)状态和观察的行动策略的合理性。通过根据负预期自由能量为策略评分,参与主动推理的生物体有效地相信它们追求这个量最低的行动路线。从心理学角度来说,这意味着生物体对策略的信念直接对应于其意图——它通过行动来实现。

从概念角度来看,我们可以将变分自由能量和预期自由能量的最小化与两个推理回路联系起来,一个嵌套在另一个内部。变分自由能量最小化是主动推理的关键(外部)回路,足以优化感知和关于策略的信念。主动推理代理还可以配备一个关于其行动后果的生成模型,该模型需要对预期自由能量进行评估(内部回路)。这种规划未来的能力通过为策略提供概率值来支持前瞻性的行动选择形式(Friston, Samothrakis, and Montague 2012; Pezzulo 2012)。

主动推理是一个理论,描述了活物如何通过感知和行动来最小化惊讶——或惊讶的可处理代理变分自由能量——从而维持其存在。在本章中,我们试图从感知作为推理的贝叶斯处理开始激发这一想法,并将其扩展到行动领域。贝叶斯推理基于感官观察如何生成的生成模型,该模型编码(概率性地)有机体对世界的隐含知识——形式化为先验信念以及在替代状态和策略下的预期结果。

[从 http://direct.mit.edu/books/oa-monograph/chapter-pdf/2004455/c001300_9780262369978.pdf 下载,访客于2022年4月2日] [通向主动推理的低路 39]

主动推理的特定观点迫使我们重新审视贝叶斯推理中先验的通常语义。预期状态是首选的,包括有机体的生存条件(例如,特定生态位的目标状态),而它们的反面——惊讶状态——是不受欢迎的。通过这种方式,通过实现它们的期望,主动推理代理确保了自己的生存。鉴于先验概念与支撑有机体存在的条件之间的重要联系,我们也可以说在主动推理中,代理的身份与其先验是同构的。这个术语在本书后面会变得更加熟悉。

注意,在这个观点中,惊讶(或有时称为惊讶度)是信息论的正式构造,不一定等同于(民间)心理学构造。粗略地说,有机体的状态与先验(编码首选状态)的差异越大,就越令人惊讶——因此主动推理相当于有机体(或其大脑)必须主动最小化其惊讶以保持生存的想法。在某些条件下,惊讶最小化可以被解释为减少模型与世界之间的差异。更一般地,在主动推理中实际最小化的量是变分自由能量。变分自由能量是惊讶的(上界)近似,可以使用化学或神经元消息传递以及有机体生成模型可用的信息来有效最小化。

重要的是,perception(感知)和action(行动)都通过互补的方式最小化变分自由能:通过精细化它们的(后验信念)估计,以及通过执行选择性采样预期内容的行动。此外,Active Inference还通过遵循与最小模糊性和风险相关的策略来最小化预期自由能。预期自由能随后将Active Inference扩展到前瞻性和反事实推理形式。这完成了我们沿着通往Active Inference的低路径的旅程。在第3章中,我们将走高路径,基于第一原理和自组织达到同样的结论。

生存机器如果能够模拟未来,就比那些只能基于公开试错学习的生存机器领先一步。公开试验的问题在于它需要时间和能量。公开错误的问题在于它往往是致命的。模拟既更安全又更快速。 ——理查德·道金斯

在第2章中,我们引入自由能作为执行近似贝叶斯推理的手段(即通往Active Inference的低路径)。在这里,我们从另一个角度引入自由能,即高路径,它颠倒了这种推理:它从统计物理学的第一原理和有机体必须维持自身存在——即避免意外状态——的核心要求出发,然后引入自由能最小化作为这个问题的计算可行解决方案。本章揭示了变分自由能最小化与近似贝叶斯推理中模型证据最大化(或自证明)之间的形式等价性,揭示了自由能与贝叶斯适应系统观点之间的联系。最后,它讨论了Active Inference如何提供一个新颖的第一原理视角来理解(最优)行为。

Active Inference是关于活体有机体如何通过最小化意外——或意外的可处理代理,变分自由能——通过感知和行动来维持其存在的理论。从第一原理出发,它提出了一种新颖的基于信念的方案来理解行为和认知,这具有许多经验含义。

任何适应系统的一个重要前提条件是它必须与环境保持某种分离和自主性——没有这种分离,它将简单地消散、溶解,从而屈服于环境动力学。在没有这种分离的情况下,就没有需要最小化的意外;必须有某种东西感到意外,也必须有某种令其意外的东西。换句话说,至少存在两个事物——系统和环境——并且这些可以相互区分。表达系统与环境其余部分分离的一种形式化方法是马尔可夫毯的统计构造(Pearl 1988);见框3.1。

框3.1 马尔可夫毯

马尔可夫毯是本书中一个重要的重复概念(Friston 2019a, Kirchhoff et al. 2018, Palacios et al. 2020)。技术上,毯子(b)定义如下:

μ ⊥ x|b ⇔ p(μ, x |b) = p(μ |b)p(x|b)

高路径到Active Inference从这样一个前提开始:为了生存,任何活体有机体都必须将自己维持在一套合适的偏好状态中,同时避免环境的其他非偏好状态。这些偏好状态首先和最重要的是由生态位特定的进化适应所定义。然而,正如我们稍后将看到的,在高级有机体中,这些也可以扩展到学习的认知目标。例如,为了生存,鱼必须保持在舒适区中,该舒适区对应于宇宙所有可能状态的一个小子集:它必须待在水中。同样,人类必须确保他们的内部状态(例如,体温和心率等生理变量)始终保持在可接受范围内——否则他们将死亡(或更准确地说,将变成其他东西,比如尸体)。这个可接受范围或舒适区规定性地定义了某物必须处于的特征状态才能成为那个东西。

活体有机体通过在多个层面上对其状态(例如体温)施加主动控制来解决这个基本生物学问题,这些层面从自动调节机制如出汗(生理学)到认知机制如购买和消费饮料(心理学)再到文化实践如分发空调系统(社会科学)。

从更正式的角度来看,Active Inference将生存的生物学问题——或解释——表述为意外最小化。这种表述基于信息论中意外状态的技术定义——本质上,意外状态索引那些在活体有机体舒适区之外的状态。然后它提出自由能最小化作为有机体或适应系统最小化感官遭遇意外的实用和生物学基础方法。

[这以两种不同但等效的方式说明了,如果已知][b][,则变量][μ]与变量[是条件独立的。换句话说,如果我们知道][b],了解[不会给我们提供关于][μ][的任何额外信息。这方面的一个常见例子是马尔可夫链,其中过去导致现在导致未来。在这种情况下,过去可能仅通过现在影响未来。这意味着,如果了解过去的情况(假设我们知道现在),不会获得关于未来的任何额外信息。]

为了在已知条件依赖性的系统中识别马尔可夫毯,我们可以遵循一个简单的规则。给定变量的毯包括其父变量(它依赖的变量)、其子变量(依赖于它的变量),以及在某些情况下,其子变量的其他父变量。

简而言之,马尔可夫毯是调节系统与其环境之间所有(统计)相互作用的变量集合。图3.1展示了动态设置中马尔可夫毯的解释。这里的条件独立性得到了动力学约束的补充,因此流动不依赖于毯另一侧的状态。

图3.1中的马尔可夫毯将适应性系统的内部状态(即大脑活动)与环境的外部状态区分开来。此外,它识别了两种额外状态,标记为感觉状态和主动状态,它们形成了(统计上)分离内部和外部状态的毯。统计分离意味着,如果我们了解主动和感觉状态,外部状态将不会提供关于内部状态的任何额外信息(反之亦然)。在动力学设置中,这通常被解释为内部状态不能直接改变外部状态,但可以通过改变主动状态来间接实现。同样,外部状态不能直接改变内部状态,但可以通过改变感觉状态来间接实现。

这是对经典动作-感知循环的重新阐述,其中适应性系统及其环境(仅)可以分别通过动作和观察进行相互作用。这种重新表述有两个主要好处。

主动状态

u· = fu (x, u, y) + ωu

外部状态 内部状态

x· = fx (x, u, y) + ωx µ· = fµ (µ, u, y) + ωµ

感觉状态

y· = fy (µ, u, y) + ωy

b = (u, y)

毯状态

图3.1

动态马尔可夫毯,将适应性系统(这里是大脑)与环境分离。每组状态的动力学由确定性流决定,该流被指定为一个函数(f),给出平均变化率和额外的随机波动(ω)。箭头表示每个变量对其他变量变化率的影响方向(技术上是相关雅可比矩阵的非零元素)。这只是一个例子;人们可以使用马尔可夫毯将整个有机体与环境分离,或将多个马尔可夫毯相互嵌套。例如,大脑、有机体、二元组和社区可以用相互嵌套的不同马尔可夫毯来构想(参见Friston 2019a; Parr, Da Costa, and Friston 2020的正式处理)。令人困惑的是,不同领域使用不同的变量记号;有时,感觉状态记为s,外部状态记为η,主动状态记为a。这里我们选择了与本书其他章节一致的变量。

首先,它形式化了适应性系统的内部状态独立于环境动力学的事实,因此可以抵制其影响。其次,它为适应性系统最小化惊讶的方式提供了框架:它突出了它们可以访问的内部、感觉和主动状态。具体来说,惊讶是相对于感觉状态定义的,而内部和主动状态动力学是最小化感觉状态惊讶的手段。

这里需要注意的关键点是,适应性系统的内部状态与外部状态具有形式关系。这是由于马尔可夫毯两侧的某种对称性,因为两者都影响并受到毯状态的影响。其结果是,我们可以在给定毯状态的条件下,构造内部和外部状态的条件概率分布。因为这些都以相同的毯状态为条件,我们可以将期望的内部和外部状态对彼此关联起来。换句话说,平均而言,内部和外部状态获得了一种(广义)同步性——正如我们可能预期的,在木梁的两端各挂一个钟摆。随着时间的推移,当它们同步时,每个钟摆通过木梁的间接影响变得能够预测另一个(Huygens 1673)。图3.2为这种关系提供了图形化的直觉。这意味着,如果我们可以写出独立的条件概率分布

![图:显示两个图表,左图标为x|b和x,右图标为µ|b和µ,展示了变量在不同条件下的分布]

主动推理的高阶路径 45

[40] [x | ] [P][(][µ|b][)] [[][µ][]]

x [20]

[0]

[Probability]

[–20]

[–40]

[–100 –50] [0] [50] [100] [–8] [–7 –6 –5 –4]

[µ] x

图3.2

Markov blanket的平均内部状态与外部状态分布之间的关联。顶部:假设条件概率的线性高斯形式,这些图显示了给定blanket状态下外部和内部状态条件分布的样本。粗黑线表示给定相关blanket状态下这些变量的平均值。左下:相同的数据被绘制出来,以说明通过共享Markov blanket实现的内部和外部状态的同步——这里是一种反向同步。虚线和黑十字说明,如果我们知道平均内部状态(垂直线),我们就能确定平均外部状态(水平线)以及围绕此点的分布。右下:我们可以将平均内部状态与外部状态的分布关联起来。

给定它们的Markov blanket时,外部和内部状态的分布使得两个状态通过这个blanket变得相互具有信息性。

这种同步性使内部状态看起来像是在表示(或建模)外部状态——这与第2章中介绍的惊讶最小化概念相关联。这是因为惊讶取决于感觉数据如何生成的内部模型。回顾一下,最小化感觉观察的惊讶(负对数概率)等同于最大化模型的证据(边际似然),这就是该模型下感觉观察的概率。这种惊讶最小化的概念可以从两个等效的角度——贝叶斯和自由能角度来理解,我们接下来将讨论这些角度。

在贝叶斯视角下,具有Markov blanket的智能体似乎在建模外部环境,即内部状态(平均而言)对应于外部系统状态的概率表示——一个近似的后验信念(图3.2)。内部状态的动力学对应于外部状态的一种(近似)贝叶斯推断形式,因为它们的运动改变了相关的概率分布,这是通过感觉(或Markov blanket术语中的感觉状态)如何生成的隐式生成模型实现的。如果我们重新确立智能体由内部和blanket状态构成的概念,我们就可以谈论智能体的生成模型。

重要的是,智能体的生成模型不能简单地模仿外部动力学(否则智能体将简单地遵循外部耗散动力学)。相反,该模型还必须指定智能体存在的偏好条件,或智能体必须访问的状态区域以维持其存在,或在占据特征状态方面满足其存在标准。这些偏好状态(或观察)可以被指定为模型的先验——这意味着模型隐含地假设,如果它满足存在标准,其偏好的(先验)感觉更可能发生(即不太令人惊讶)。这意味着它具有隐含的乐观偏见。这种乐观偏见对于智能体超越对外部动力学的简单复制,规定支撑其偏好或特征状态的主动状态是必要的。

在这种表述下,人们可以将最优行为(相对于先验偏好)表述为通过感知和行动最大化模型证据。

实际上,模型证据总结了生成模型对感觉的拟合或解释程度。良好的拟合表明模型成功地解释了其感觉(这是推断的描述性方面);同时,它实现了其偏好的感觉,因为它们不太令人惊讶(这是推断的规范性方面)。这种良好的拟合是惊讶最小化的保证,因为最大化模型证据P(y)在数学上等同于最小化惊讶:ℑ(y) = −ln P(y)。

更简洁地重新表述上述论点的方法是说任何适应性系统都参与”自我证明”(Hohwy 2016)。这里的自我证明意味着行动以收集与内部模型一致的感觉数据(即为内部模型提供证据),从而最大化模型证据。

3.3.1 作为最小作用量哈密顿原理的惊讶最小化

在前面的章节中,我们已经断言惊讶必须被最小化,但没有详细说明为什么会这样。虽然自我证据化的底层物理学细节超出了本书的范围(详见Friston 2019b),但我们在这里提供一个简要概述。这些原理基于这样的理念:具有马尔可夫边界的生物生命体在时间中持续存在,抵抗环境波动的扩散效应。马尔可夫边界的持续存在意味着边界状态的分布在时间上保持恒定。简单来说,这意味着感觉(或主动)状态偏离该分布下高概率区域的任何偏差,都必须通过状态的平均流(这正是图3.1中流动的确定性部分)来纠正。用物理学家的表达方式,处于稳态的随机系统参与的动力学(平均而言)沿着一个能量函数(或哈密顿量)下降,该函数可解释为负对数证据或惊讶。这就像一个球从山顶的高重力势能滚向山谷中的低能量区域。见图3.3。

对于图3.3左侧显示的系统,每当波动导致移动到一个较不可能的状态时,这种移动就会被沿概率梯度向上的移动所纠正,使得系统在更大比例的时间里占据概率密集区域。这里的关键见解是,该系统通过最小化惊讶(平均而言)来维持感觉状态在狭窄范围内——这与右侧的系统形成对比,后者的惊讶无限增长。

惊讶最小化使活的生物体能够(暂时地)抵抗热力学第二定律,该定律指出熵——或

系统状态的分散——总是增长。这是因为,平均而言,熵是惊讶的长期平均值,平均而言,观察值对数概率的最大化等价于(香农)熵的最小化:

H[P(y)] = E[P(y)][ℑ(y)] = −E[P(y)][ln P(y)] (3.1)

确保感觉状态的一小部分以高概率被占据,等价于维持特定的熵。这是自组织系统的一个定义特征,正如控制论理论长期以来所认识的。

从生理学家的角度来看,惊讶最小化形式化了稳态的概念。当传感器值离开其最优范围时,负反馈机制启动,逆转这些偏差。从控制角度来看,我们可以根据某些期望的稳态概率密度来解释最优行为。换句话说,如果我们定义一个偏好结果的分布,最优行为将涉及系统向该分布的演化和维持。

正如我们在第2章中看到的,自由能是惊讶的上界,这表明可以通过在面对随机波动时最小化自由能来获得最优行为。

回想一下,自由能和惊讶之间的差异是精确后验概率(即给定边界状态的外部状态分布)和近似后验概率(即给定平均内部状态的外部状态分布)之间的散度。因此,内部状态的运动可以被视为最小化散度,这使得主动状态平均而言能够最小化伴随感觉状态的惊讶。换句话说,自由能最小化产生的最优行为是最不令人惊讶的,遵循从当前状态到期望状态的最小作用量路径——即应用于行为的最小作用量哈密顿原理。

图3.3显示了一个配备随机吸引子的系统的非常简单的例子。这类似于恒温器,在控制论术语中,恒温器只有一个设定点,无法学习或规划。主动推理旨在使用相同的解释机制来涵盖更复杂和更具适应性的系统。在这里,最简单系统和更复杂系统之间的差异可以归结为它们吸引子的不同形状——从固定点到越来越复杂的游走动力学。从这个角度,我们可以理解生物有机体是在不断寻求过度稳定和过度分散之间的折衷——而主动推理旨在解释这种折衷是如何实现的。

物理学家E. T. Jaynes著名地论证了推理、信息论和统计物理学是同一事物的不同视角(Jaynes 1957)。在前面的章节中,我们讨论了贝叶斯和统计物理学视角如何提供两种等价的方式来理解惊奇最小化和最优行为——有效地将一种认知形式添加到Jaynes的三位一体中。这种不同思想流派之间的等价性很有吸引力,但对于不熟悉相关形式主义的人来说可能会令人困惑,因为在这些形式主义中,许多不同的词被用来指代相同的量。为了帮助揭开这个谜团,在本节中我们详细阐述了贝叶斯和统计物理学视角及其认知解释之间的主要等价关系;参见表3.1的总结和框3.2。

表3.1 统计物理学、贝叶斯推理和信息论——及其认知解释

| 统计物理学 | 贝叶斯推理和信息论 | 认知解释 |

|---|---|---|

| 最小化变分自由能 | 最大化模型证据(或边际似然);最小化惊讶度(或自信息) | 感知和行动 |

| 最小化期望自由能;哈密顿最小作用原理 | 推断最可能(或最不惊人)的行动过程 | 作为推理的规划 |

| 达到非平衡稳态 | 执行近似贝叶斯推理 | 自我证明 |

| 能量函数上的梯度流;自由能上的梯度下降 | 模型证据上的梯度上升;惊讶度上的梯度下降 | 神经元动力学 |

框3.2 统计物理学和主动推理中的自由能

自由能的概念在统计物理学中被广泛用于表征(例如)热力学系统。尽管主动推理使用完全相同的方程,但它应用这些方程来表征智能体的信念状态(相对于生成模型)。因此,当我们谈论主动推理智能体最小化其(变分)自由能时,我们指的是改变其信念状态的过程,而不是(例如)其身体粒子的过程。为了避免误解,我们使用术语变分自由能,因此采用了在机器学习中更常见的术语。另一个更微妙的要点是,自由能概念通常在平衡统计热力学的背景下使用。主动推理针对的是生物有机体——或非平衡稳态系统——这些系统是开放的,具有与环境连续、相互的交换特征。这是一个令人兴奋的新兴领域(Friston 2019a)。

第一个重要的等价关系是贝叶斯推理中模型证据最大化(或边际似然)和变分自由能最小化之间的等价关系——两者都最小化惊奇。当人们诉诸于变分推理——难解推理问题的特定近似解——时,这种等价关系就变得明显。变分推理通过最小化自由能将推理问题重新转化为优化问题。自由能的最小值是近似精确解的最佳点。正式表达这一点阐明了三个量之间的关系:

ℑ(y|m) = −ln P(y| m) ≤ D[KL][Q(x) || P(x| y,m)] − ln P(y| m) (3.2)

在等式3.2中,与第2章不同,我们明确地将所有量条件化于模型m,以强调这些依赖于我们拥有(或是)关于y如何生成的模型,如果使用不同的模型,这些量会发生变化。这些量的等价性提出了为什么区分它们有用的问题。主要原因是,与模型证据不同,变分自由能可以高效地最小化。

回忆第2章中提到的,变分自由能仅在KL散度项变为零时才完全等价于负模型证据或惊讶度。这并不总是可能的,但可以使其接近零。因此,在寻找越来越好的Q(x)值的过程中,变分自由能也更接近地近似惊讶度。我们已经多次提到这一点,因为强调自由能和惊讶度之间的中心关系很重要,这是本书的基础。具体而言,自由能是惊讶度的上界。它可以等于或大于惊讶度——其中大于的程度由KL散度来量化。

这个有趣的方面是,任何最小化其惊讶度的系统,包括图3.2中的非常简单的系统,也在最小化自由能,其中Q(x)总是设置为等于精确后验概率——即,将KL散度设为零。认知系统和非认知系统之间差异的一个观点是,后者总是有零KL散度,而认知系统必须经历(感知)过程来最小化这个项,然后它们的行动才能保证最小化惊讶度。请注意,最小化散度是感知唯一能做的事情。这给内部状态的运动带来了很大的重视,使得它们参数化的分布(图3.2)尽可能接近精确后验。然而,感知无法最小化变分自由能的第二个(证据)组成部分,该组成部分对应于实际惊讶度,因为它无法改变已收集的感觉。只有通过以改变感觉的方式行动,agent才能最小化变分自由能的第二个(证据)组成部分并解决其惊讶度——或者等价地,最大化其模型证据。这强调了在自我证明中,给定内部状态下主动状态的运动。

一个例子有助于说明这一点。想象你的生成模型预测给定饥饿程度下血液中葡萄糖水平的分布,相对较高与较低的葡萄糖水平分别与饱腹感和饥饿感相关。此外,想象这个模型给饱腹感赋予更高的先验概率,因此给相对较高的葡萄糖水平赋予更高概率——使低葡萄糖水平令人惊讶。想象你最初对自己的饥饿程度不确定,并感觉到低血糖。感知导致推断你饿了并体验到饥饿感——关闭KL散度。然而,感知无法进一步减少你的惊讶度——以及你先验期望的高葡萄糖水平和你感知到的低葡萄糖水平之间的差异——因为它无法作用于你的感觉(低葡萄糖)或其原因(生理学)。你只能通过行动来改变你收集的感觉(的隐藏来源)来最小化你的惊讶度——例如,通过吃甜点。

总之,感知可以通过减少近似和真实后验之间的差异来最小化变分自由能,但无法在最小化惊讶度方面走得更远。惊讶度最小化的下一步需要通过行动来改变人们收集的感觉,这就是推理超越感知并变得主动的地方。

另一个重要的等价性是期望自由能的最小化与推理最可能的行动路线或策略之间的等价性。这超越了指定状态空间中最不令人惊讶的部分,并处理到达该部分或位置的替代路线可能有多令人惊讶。这些替代路径以策略的形式表达,这些策略本质上是跨状态的轨迹。重要的是,在主动推理中,策略的对数概率被设置为与该策略被追求时的期望自由能成比例。这意味着最可能或最不令人惊讶的路径是(设置为)最小化期望自由能的路径。这个公式等价于物理学中定义作用量的方式,在那里它通过能量的积分(或和)来评分路径的概率。虽然物理系统可能追求假设轨迹的空间,但它实际遵循的路径是使作用量最小化的路径——即,Hamilton最小作用量原理。主动推理和Hamilton最小作用量原理之间的这种类比在下一节中展开。

在最优控制、强化学习和经济学等领域中,行为的优化源于状态的价值函数,遵循Bellman方程(Sutton和Barto 1998)。本质上,每个状态(或状态-动作对)被分配一个价值,它表示一个状态对agent来说有多好。状态(或状态-动作对)的价值通常通过试错学习,通过计算从这些状态开始多少次——以及在多长时间后——获得奖励。行为包括通过到达高价值状态来优化奖励获取,因此利用学习历史。

相比之下,在主动推理中,行为是推理的结果,其优化是信念的函数。这种表述统一了(先验)信念和偏好的概念。如上所述,使用期望自由能的概念相当于赋予智能体一种隐含的先验信念,即它将实现其偏好。因此,智能体对某种行动路线的偏好简单地变成了对它期望做什么以及在未来会遇到什么的信念——或者是对它将访问的未来状态轨迹的信念。这用(先验)信念的概念取代了价值的概念。如果一个人有强化学习(其中价值和信念是分离的)或贝叶斯统计(其中信念不包含任何价值)的背景,这是一个看似奇怪的举动。然而,这是一个强有力的举动,至少有三个原因。

首先,它自动包含了目的性(或目的论)行为的自洽过程模型,这类似于控制论的表述。如果我们为主动推理智能体赋予某种先验偏好,那么它将采取行动来实现这些偏好——因为这是唯一的行动路线

与其先验信念一致,即它将采取行动来实现其期望。请注意,由此产生的(偏好的)行动路线或策略在实验设置中是直接可测量的,而价值函数或先验信念需要被推断,因此是一种更间接的,如果不是同义反复的测量。

其次,将行为视为信念的函数(概率分布)自动包含了诸如信念程度和不确定性等概念。这些概念支撑着适应性行为的重要方面,但在贝尔曼表述中不能直接获得。同样地,这种表述在建模顺序动力学和巡游行为方面提供了更多的灵活性,这些在状态价值函数方面更难建模(Friston, Daunizeau, and Kiebel 2009)。

第三,在这种表述中,最优行为遵循统计物理学中的最小作用量哈密顿原理。实际上,主动推理朝着行为是信念函数这一思想更进了一步:它还假设行为变成一个能量函数——主动推理智能体最可能的行动路线是最小化自由能的路线。一个深刻的结果是,生物体根据哈密顿最小作用量原理行为:它们遵循阻力最小的路径,直到达到稳态(或状态轨迹),正如随机动力系统的行为所示(如图3.3所示)。这是一个基本假设,将主动推理与基于贝尔曼表述的行为和认知替代理论区分开来。

值得简要概述我们在哈密顿物理学和主动推理之间建立类比的含义。这在三个层面上是有意的。首先是主动推理对行为和生命科学提供的进步,可与拉格朗日和哈密顿表述对牛顿力学描述提供的进步相比较。虽然牛顿力学最初是用微分方程表述的——包括牛顿著名的表达加速度与力成正比的第三定律——通过考虑动力系统保守什么,为力学提供了一个补充视角。然后可以从这些守恒定律推导出牛顿动力学。这些为进一步的理论进展提供了一个视角,它们构成了随机、相对论和量子物理学部分的基础。类似地,主动推理通过指定量——自由能——来重新表述可能以前由一系列微分方程构建的神经元和行为动力学,

可以从中推导出这些动力学。正如不同类型的哈密顿量导致不同类型的物理学一样,基于不同生成模型的自由能导致不同的神经元和行为动力学。

哈密顿物理学和主动推理之间的第二个连接点来自哈密顿量和概率测度之间更直接的关联。这里的想法是将守恒的哈密顿量与系统的能量关联起来。记住我们迄今为止(这里和第2章)称为能量的量都具有负对数概率的形式。这反映了对能量的解释,即简单地作为系统任何给定配置的不可能性的测度。在这种观点下,能量守恒和概率守恒是等价的定律。当耗散系统——通过马尔可夫毯与外部状态耦合——移动到低能量或高概率的状态时,我们可以直接将能量或哈密顿量与惊奇关联起来。因此,主动推理就是应用于某种系统(具有马尔可夫毯的系统)的哈密顿物理学。

这些表述之间的第三种关联是变分计算,它支撑了能量与动力学之间的关联。当哈密顿物理学表达为最小作用量原理时,这一点最为明显,其中作用量指的是拉格朗日量沿路径的积分。关键是,这个作用量是路径的泛函。这里,路径是时间的函数,其输出是粒子在该时间点在该路径上的位置和速度。(确定性)粒子所遵循的路径使这个作用量最小化。类似地,主动推理基于这样的理念:信念(本身是隐藏状态的函数)必须最小化自由能泛函。这里的关键接触点是,在两种情况下,函数(路径或信念)都必须相对于泛函(分别是作用量或自由能)进行优化。这将两者都置于变分计算的背景中,变分计算是数学的一个分支,致力于寻找泛函的极值。在物理学中,这导致了欧拉-拉格朗日方程。在主动推理中,我们得出变分推理程序。

在第3.2节中,我们强调了主动推理的范围涉及那些与环境有某种分离的系统,并看到这转化为马尔可夫毯的存在。在第3.3节中,我们强调了这种毯子的持续存在需要(平均)最小化(感官)状态意外性的动力学。由于这可以被解释为自我证明,我们得出结论:行为由可以被解释为生成模型的稳态分布决定,该模型描述了(感官)数据是如何生成的。

这告诉我们一些非常重要的事情。每个生成模型都应该与不同类型的行为相关联。因此,不同类型的行为可以通过指定不同的生成模型来解释——以及隐含地表明该系统会发现什么令人意外。此外,不同种类的生成模型可能对应于具有不同复杂度水平的适应性或认知生物(Corcoran et al. 2020)。驱动图3.3中动力学的那种非常简单的生成模型提供了一种最小的认知形式,因为它们无法考虑替代(或反事实)轨迹的可能性。此外,这些模型是浅层的,因为它们只在一个时间尺度上提供推理。相比之下,分层生成模型在多个时间尺度上提供推理。在分层或深度模型中,较高分层级别的动力学通常编码变化较慢的事物(例如,我正在阅读的句子),并为变化较快的事物(例如,我正在阅读的单词)提供背景,这些事物在较低的分层级别中表示(Kiebel et al. 2008; Friston, Parr, and de Vries 2017)。

我们需要在模型中包含什么来导出我们会与能动性和有感知系统相关联的那种更复杂的行为?一个答案是建模替代未来的能力,或事件可能发生的不同方式——并在其中进行选择。反过来,考虑可能的未来需要一个具有某种时间深度并明确表示行动后果的生成模型。将这一点纳入模型将确保符合这些未来中最可能的行为。考虑这些替代方案的(反事实)能力可能是将与有感知系统相关的稳态与更简单生物区分开来的因素。当替代未来涉及我们可以控制的事物时,我们将这些称为策略或计划。正如我们在第2章中看到的,区分这些计划的一种方法是在模型中纳入一个先验信念,即预期自由能最低的那些策略是最合理的。这提供了一种在稳态下用马尔可夫毯表征某种系统的方法——这似乎很好地对应于像我们这样的系统。

通过强调自由能最小化,主动推理统一并扩展了三个看似不相关的理论视角。

首先,主动推理符合生命和认知的生成式理论,这些理论强调行为的自组织和与环境的自创生(autopoietic)相互作用,确保活的有机体保持在可接受的边界内(Maturana and Varela 1980)。主动推理提供了一个正式框架,解释活的有机体如何通过自组织统计结构——马尔可夫毯——来抵抗其状态的分散,这种结构既提供有机体与环境之间的相互交换,同时也分离(在某种意义上保护)有机体状态与外部环境动力学的完整性。

其次,主动推理符合控制论理论,这些理论将行为描述为有目的和目的论的。目的论意味着行为由一个机制内部调节,该机制持续测试目标是否实现,如果没有,则引导纠正行动(Rosenblueth et al. 1943, Wiener 1948, Ashby 1952, G. Miller et al. 1960, Powers 1973)。类似地,主动推理智能体使用感知和行动来最小化偏好状态和感知状态之间的差异。主动推理通过指定实际最小化的是智能体可以测量的统计量——变分自由能——来提供最小化过程的规范性和可行性描述,在某些条件下,这对应于预测误差,或期望和感知之间的差异。这意味着将控制论控制表述为一个前瞻性过程——这引出了下一个观点。

第三,主动推理符合将控制描述为基于环境模型的前瞻性过程的理论——可能在大脑中物理实现(Craik 1943)。主动推理假设智能体使用(生成)模型来构建指导感知和行动的预测,并评估其未来(和反事实)行动可能性。这一假设与良好调节器定理(Conant and Ashby 1970)一致,该定理说任何控制器都应该拥有——或者本身就是——环境的良好模型。主动推理在(近似)贝叶斯推理和(变分

[Downloaded from http://direct.mit.edu/books/oa-monograph/chapter-pdf/2004456/c002400_9780262369978.pdf by guest on 02 April 2022] [58 ] [[第3章]]

和期望)自由能最小化的严格特征化下,调和了这些基于模型的大脑和行为观点。此外,主动推理在很大程度上与意念运动理论(ideomotor theory)(Herbart 1825, James 1890, Hoffmann 1993, Hommel et al. 2001)一致,该理论指出行动始于想象过程,是预测性表征(行动后果的)触发行动——而不是像刺激-反应理论中的刺激(Skinner 1938)。主动推理将这一观念置于推理框架中,其中行动源于信念(关于未来);这有许多含义,比如为了触发行动,必须暂时减弱感觉证据(否则会证伪触发行动的信念)(H. Brown et al. 2013)。

这些框架的调和很有趣,因为它们经常被认为是对立的。例如,自组织和目的论在生物学中经常被视为不相容的。此外,具身认知理论(enactive theories)倾向于淡化表征和控制,而这却是大多数基于模型的推理理论的核心构念。主动推理从一个不寻常的角度形式化了适应性智能体的自生成动力学(autopoietic dynamics),同时考虑自组织和预测。通过连接不同的观点,主动推理可能帮助我们理解它们如何相互阐释。

主动推理从第一原理出发,并展开它们来解释从最简单到最复杂的适应性和生命系统所表达的行为和认知。在简单和复杂生物的连续体中,主动推理在那些最小化变分自由能的生物和那些同时最小化期望自由能的生物之间划了一条线。

任何主动采样感觉以最小化变分自由能的适应性系统等价于主动为其生成模型收集证据的智能体,即自证据智能体(self-evidencing agent)(Hohwy 2016)。这些系统能够通过实现基本稳态过程提供的设定点来避免耗散、自我调节和生存。这些系统能够产生复杂多样的行为形式,也可以具有很高的适应性水平(在病毒的情况下已经很明显)。一些可能具有分层生成模型,允许推断在不同时间尺度上变化的事件,从更快的(在较低的分层级别)到更慢的

[Downloaded from http://direct.mit.edu/books/oa-monograph/chapter-pdf/2004456/c002400_9780262369978.pdf by guest on 02 April 2022] [通往主动推理的高阶之路 59]

(在更高级别)——因此可以发展出处理其所经历事物的复杂策略。然而,这些生物也受到根本限制,因为它们的生成模型缺乏时间深度——或明确规划和考虑未来的能力(尽管它们可以隐含地这样做,例如,作为遗传进化的结果)——因此它们总是生活在现在。

一个被赋予时间深度的生成模型为期望自由能最小化打开了大门——或者用心理学术语来说,就是规划。在主动推理(Active Inference)中,这不仅仅意味着适应性的增强:它至少意味着一种原始形式的能动性(agency)。对于适应系统而言,最小化期望自由能等同于拥有这样的(隐含)先验:自己是一个自由能最小化智能体——但行动是为了最小化未来的自由能。当这种(先验)信念进入生成模型时,适应系统就能够形成关于自己在未来应该如何行为以及将追求哪些轨迹的信念。换句话说,它变得能够在替代未来中进行选择,而不是像上述最简单的智能体那样,仅仅选择如何处理感知到的当下。因此,这种时间深度转化为心理深度。要问生物体如何在最简单和最复杂的适应系统之间的连续体中分布——以及它们能表达什么形式的主动推理——这是一个经验性问题。

3.9 总结

本章的主要议题可以总结如下:生物体必须确保它们只访问其特征性或首选状态。如果将这些首选状态定义为期望状态,那么可以说生物体必须最小化其感官观察的惊奇度(并维持最优熵;见方框3.3)。

要做到这一点,需要智能体对环境动态行使一定的自主权,并配备一个将其内部状态与环境外部状态分离的马尔可夫毯(Markov blanket)(即表达两者之间的条件独立性)。马尔可夫毯内的智能体可以与环境进行相互的(行动-感知)交换。这些交换由主动推理理论正式描述,其中感知和行动都最小化惊奇度。它们可以通过配备一个概率生成模型来做到这一点,该模型描述了它们的

第3章

第3章

方框3.3

熵最小化和开放式行为

主动推理基于这样的前提:生物体努力维持相对秩序(或负熵)、可控性和可预测性,尽管它们沉浸在一个自然力量产生持续波动的环境中——以及永无止境的熵侵蚀威胁。这种主动追求秩序的最基本表现是生理稳态,关键生理参数需要保持在可行区域内。然而,最小化熵不应该等同于僵化的反应库(如自主稳态反应),而是相反的,特别是在高等生物体中。我们可以发展开放式的新颖行为库来追求我们原始的稳态命令——例如,生产和购买好酒来满足口渴和其他需求。这有时被称为”异态平衡”(allostasis)(Sterling 2012)。

更广泛地说,我们主动追求某种秩序和可控性本身,不必参考特定的稳态命令——或许是因为保持秩序促进了许多这样的命令。我们主动雕刻我们的生态位,使其更可预测和更少令人惊讶。这在我们构建物理空间(如避难所和城市,为不受控制的自然力量提供庇护)和文化空间(如有法律和道德规范的社会,为无政府主义社会力量提供庇护)的方式中是显而易见的。在所有这些例子中,我们通常需要接受一些短期熵或惊奇度的增加(如当我们建造新东西或转变社会立场时),以确保其长期减少。这帮助我们理解惊奇度最小化的基本要求如何不与认识命令和寻求新奇、好奇和探索行为相冲突,而是促进它们,我们认识到这些对许多物种都是核心的。

认识命令变得明显的第一种方式是在变分自由能最小化期间。分解自由能的方法之一是将其表达为近似后验下期望的吉布斯能量减去近似后验的熵。换句话说,智能体正在努力增加熵。虽然这似乎是矛盾的,但如果考虑到这是智能体(近似后验)信念的熵,矛盾就消失了。这可以理解为尽可能准确地解释事物的命令,但也要”保持选择开放”,避免承诺任何特定解释,除非这是必要的——即最大熵(maximum entropy)原理(Jaynes 1957)。

认识动态变得明显的第二种方式是在期望自由能最小化期间,其中——有趣的是——有两个符号相反的熵。这些包括后验预测熵(给定选择我对可能遇到的结果有多不确定),必须最大化——如同变分自由能中对状态信念的要求——以及给定状态下结果的条件熵(策略所蕴含的模糊性),必须最小化。虽然在变分自由能最小化期间,命令是最大化(当前)信念的熵,

主动推理的高阶道路 61

方框3.3(续)

我对给定选择会遇到什么结果有多不确定,必须最大化——如同在变分自由能中对状态的信念——以及给定状态下结果的条件熵(策略蕴含的模糊性)必须最小化。虽然在变分自由能最小化期间,命令是最大化(当前)信念的熵,

在最大化期望自由能(expected free energy)的过程中,势在必行的是选择能够最小化(未来)信念模糊性的行动。这产生了认识论的、好奇的、寻求新奇的和信息觅食行为,这些行为支持不确定性解决或生成模型的改进——这反过来从长远来看最小化了惊讶(Seth 2013; Friston, Rigoli et al. 2015; Seth and Friston 2016; Schwartenbeck, Passecker et al. 2019)。

感觉观察是如何生成的。该模型定义了惊讶——或者更好的说法是,一个可处理的代理,变分自由能,它可以被有效地测量和最小化。

一个Active Inference智能体似乎在生成模型下执行(近似)贝叶斯推断,并最大化其模型的证据——也就是说,它是一个自证明智能体。推断的前瞻性部分通过选择预期在未来最小化自由能的行动路线或政策来实现。这种形式主义导致了关于(最优)行为的新观点,基于最小作用量的哈密顿原理——一个将Active Inference连接到统计物理学、热力学和非平衡稳态领域的(第一)原理。

一切事物都应该尽可能简单,但不能过于简单。 — 阿尔伯特·爱因斯坦

本章以更正式的处理方式补充了前几章对Active Inference的概念处理。具体而言,它阐述了自由能与贝叶斯推断之间的关系、Active Inference中典型使用的生成模型形式,以及从为这些模型最小化自由能而获得的动力学。一个关键焦点是时间如何在生成模型中表示。我们将看到在连续时间中构建的生成模型与将时间视为事件序列的生成模型之间的区别。最后,我们阐述了推断消息传递的思想,这支撑了神经生物学中的重要理论——包括预测编码。

在前两章中,我们概述了Active Inference与神经科学中其他既定范式之间的一些重要联系。在第2章中,我们专注于贝叶斯大脑的概念(Knill and Pouget 2004, Doya 2007)——它最密切的相关概念之一——这提供了一种从更正式的角度思考主动推断某些后果的有用方式。具体而言,它帮助我们构建参与Active Inference的智能体必须解决的问题。广泛地说,这些是推断世界状态(感知)和推断行动路线(规划)的问题。虽然很容易将贝叶斯最优性等同于精确的贝叶斯推断,但精确推断通常在计算上是难以处理的,甚至是不可行的。在认知心理学和人工智能应用中,通常考虑有限形式的推断和理性。我们在第3章中强调了一些例子。在贝叶斯框架下,这转化为使用近似推断。这些方法包括抽样方法和变分方法——Active Inference就是基于此的。在本节中,我们回顾贝叶斯推断及其变分表现形式的基本要素(Beal 2003, Wainwright and Jordan 2008)。通过这样做,我们希望为自由能的作用提供一些直觉,并强调生成模型在对世界进行推断方面的重要性。

本章比第1-3章更技术性,需要一点线性代数、微分和泰勒级数展开。那些对细节感兴趣或需要复习的读者可以参考附录以获得必要的背景知识。那些不想深入研究理论基础的读者可以跳过本章。我们会解释每个方程的关键含义——因此即使不跟随正式论证,也应该能够理解其中重要的概念要点。

一个很好的起点是贝叶斯定理。回想第2章,该定理表达了先验和似然乘积与后验和边际似然乘积之间的等式关系。这在方程4.1中重现:

P(x)P(y|x) = P(x|y)P(y) (4.1) P(y) = ∑P(y|x)P(x) , x = ∑P(y|x)P(x) x x

方程4.1的第一行是贝叶斯定理。第二行显示边际似然(或模型证据)P(y)可以直接从先验和似然计算得出。这说明先验和似然——它们共同构成生成模型——足以让我们计算模型证据和后验概率。尽管如此,这样做并不总是容易的。方程4.1中的求和(或积分,如果处理连续变量)在计算或解析上可能是难以处理的。解决这个问题的一种方法——变分推断的起点——是将这个潜在困难的积分问题转换为优化问题。要理解其工作原理,我们需要诉诸詹森不等式,它说”平均值的对数

主动推理的生成模型 65

ln x 2

ln x

≥ [ln x]

ln x 1

x1 x x 2

图4.1

对数函数为Jensen不等式提供直观理解。如果我们只有两个数据点(x1和x2),我们可以取它们的平均值(Ex)然后求其对数,或者我们可以对每个数据点取对数然后取这些的平均值(E[ln x])。后者(E[ln x])将始终低于前者(ln Ex),这是由于对数函数的凹性,除非数据点相同(此时平均值的对数和对数的平均值相等)。这个不等式对任何数量的数据点都成立。

总是大于或等于对数的平均值。“图4.1为此提供了图形化直观理解。

为了利用这个性质,我们可以重写方程4.1,在第二行求和项内乘以一个任意函数(Q)除以它自身(这等价于乘以1,所以等式仍然成立)并对等式两边取对数。从数学上讲,这没有改变任何东西。然而,我们现在可以将表达式解释为两个概率之间比值的期望(E)[3],从而利用Jensen不等式:

ln P(y) = Q(x) ∑

ln P(y, x)

x Q(x)

= ⎡ P(y, x) ⎤ ⎡ P(y, x)⎤ ln E (4.2)

Q (x) Q (x) E ⎢ ⎥ ≥ ln ! − F[Q, y ] ⎢ ⎥

⎣ Q (x) Q(x) ⎦ ⎣ ⎦

这个方程的第二行使用了我们有一个对数期望的事实,根据Jensen不等式,这必须始终大于或等于对数的期望。这种做法有时被称为

66 第4章

重要性采样。这个不等式的右边被称为(负)变分自由能:[4]自由能越小,它越接近负对数模型证据。考虑到这一点,我们可以将贝叶斯定理(方程4.1)写成对数形式,在后验分布下取其平均值,并揭示这与方程4.2的量之间的关系:

ln P(x,y ) = ln P(y) + ln P(x| y ) ⇒

EP(x|y )[ln P(x,y)] = ln P(y) + EP(x|y)[ln P(x| y)] (4.3)

EQ(x)[ln P(x,y)] = − F[Q, y ] + EQ (x)[lnQ(x)]

第二行来自这样的事实:y的对数概率不是x的函数,所以在后验分布下取期望不会改变这个量。方程4.3为自由能和Q分布的作用提供了一些直观理解——这两个量在没有变分近似的情况下很难计算。前者起到负对数模型证据的作用,而后者表现得好像它是后验概率。更正式地,我们可以像在第2章中一样重新排列自由能,以量化自由能和模型证据之间的关系:

F[Q, y ] = DKL[Q(x) || P(x | y )] − ln P(y ) ! ### ” ### $ !” # $ #

D KL[Q(x) || P(x | y)] = EQ(x) [ 散度 对数模型证据 (4.4) ln Q(x) − ln P(x | y )]

方程4.4的第一行显示了用KL散度和负对数证据表达的自由能。KL散度在第二行中定义为两个对数概率之间的期望差异。这通常用作衡量两个概率分布彼此有多大差异的指标。

有时,自由能的使用直接以这种散度来证明。论证是这样的:如果我们的目标是执行近似贝叶斯推理,我们需要找到一个最匹配精确后验的近似后验。因此,我们可以选择两者之间散度的度量——其中方程4.4中的KL散度是一个例子——并最小化它。由于我们不知道精确的后验,我们不能直接使用这个散度。一个解决方案是加上对数证据项,它可以与对数后验结合形成联合概率(我们确实知道这个,因为这是生成模型)。结果就是自由能。

主动推理的生成模型 67

从这个角度来看,一个有趣的结果是在使用哪种散度度量上存在一些模糊性。如果我们想让近似和精确后验尽可能接近,我们可以使用另一个KL散度,其中Q和P被交换,或者从一个大的散度族中选择,每个都强调分布之间差异的不同方面。然而,第3章中阐述的想法强调了自证据对参与主动推理的系统的重要性。因此,我们主要寻找一个可处理的证据最大化方案,只是次要地寻求最小化散度。从这个角度来看,使用哪种散度度量没有模糊性。这来自于Jensen不等式的使用。

为了计算自由能,我们需要三个要素:数据、变分分布族以及生成模型(包含先验和似然)。在本节中,我们概述两种非常通用的生成模型,用于主动推理(Active Inference),以及自由能相对于每种模型所采取的形式。第一种处理关于分类变量(例如,对象身份)的推理,并被表述为事件序列。第二种处理关于连续变量(例如,亮度对比度)的推理,并使用随机微分方程在连续时间中进行表述。在详细说明这些模型之前,我们回顾一种图形化形式化方法,它表达了生成模型所隐含的依赖关系。

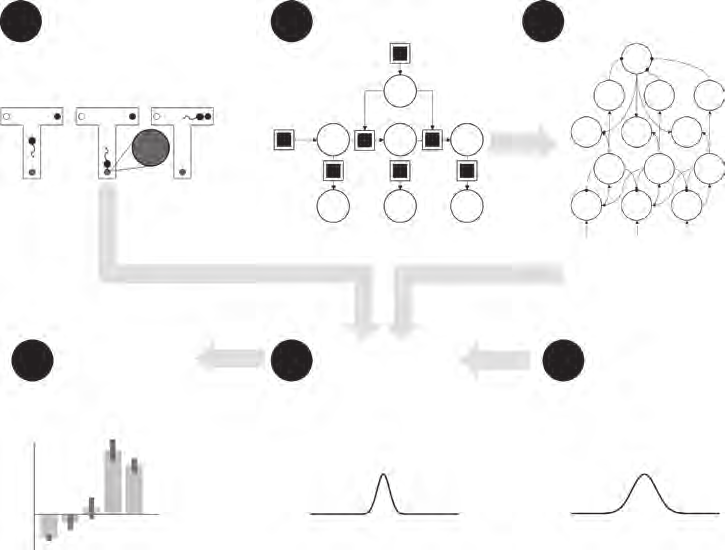

图4.2显示了几个以因子图形式表达的生成模型示例,选择这些示例是为了对可以用这种方式表达的各种内容提供一些直觉理解。这些将生成模型的因子(例如,先验和似然)表示为正方形,将模型中的变量(隐藏状态或数据)表示为圆形。箭头表示这些变量之间因果关系的方向。左上角的图显示了这些模型可以采取的最简形式,其中隐藏状态(x)导致数据(y)。此模型中的先验显示为因子1,似然为因子2。其他图通过引入附加变量扩展了这一想法。在右上角,z扮演第二个隐藏状态的角色,因此y依赖于x和z的状态。

作为示例,考虑临床诊断测试。在此设置中,左上角的简单图可以解释为疾病的存在或缺失

图4.2 (图形)概率模型中变量之间的依赖关系。圆形代表随机变量(即我们持有信念的事物);正方形代表描述这些变量之间关系的概率分布。从一个圆形通过正方形指向另一个圆形的箭头表明第二个圆形中的变量依赖于第一个圆形中的变量,且这种依赖关系被正方形所代表的概率分布所捕获。

疾病(x)和测试结果(y)。然后先验就是疾病的流行率,而似然指定了测试的性质。这些包括其特异性(在没有疾病的情况下阴性结果的概率)和敏感性(在存在疾病的情况下阳性结果的概率)。然后我们可以从获得测试结果的机制角度来思考模型——从因子图的顶部到底部。首先,我们从具有已知疾病流行率的人群中抽样一个人。如果他们患有疾病,他们将以测试敏感性给定的概率产生真阳性测试结果,否则产生假阴性。如果他们没有疾病,他们将以特异性给定的概率产生真阴性,否则产生假阳性。

继续同样的示例,我们可以解释其他因子图。在右上角面板中,x和z可能是两种不同疾病的存在或缺失,其中任何一种都可能给出阳性测试结果。在左下角,w扮演数据的角色。y和w都由x生成,可以代表(例如)对同一疾病过程具有信息性的两种不同诊断测试。最后,右下角的图将x和v都视为隐藏状态,但引入了层次结构,其中v导致x导致y。在这里,我们可以将v视为为疾病x的存在或缺失提供背景或易感因素(例如,基因多态性),该疾病可通过测量y进行检测。原则上,我们可以向此层次结构添加任意数量的变量。

这种生成模型通常用于静态感知任务,如对象识别或线索整合。用于主动推理的生成模型在一个重要方面有所不同:它们随着新观察的采样而随时间演化,而添加的观察(通过行动)依赖于对模型中变量的信念。这有两个关键含义。首先,条件依赖关系包括给定时间的隐藏变量对先前时间的隐藏变量的依赖关系。其次,这些模型有时将关于”我如何行动”的假设作为隐藏变量包含在内。

图 4.3 以因子图形式(Loeliger 2004, Loeliger et al. 2007)展示了主动推理中使用的两种基本动态生成模型(Friston, Parr, and de Vries 2017)。上图显示了部分可观测马尔可夫决策过程(POMDP),它表达了一个状态序列(s)随时间演化的模型。在每个时间步,当前状态条件依赖于前一时间的状态和当前正在执行的策略(π)。这里的策略可以被认为是索引可能遵循的替代轨迹或动作序列。每个时间点都关联一个观测(o),该观测仅依赖于该时间的状态。这种模型在处理顺序规划任务时非常有用——例如,迷宫导航(Kaplan and Friston 2018)——或涉及在替代选项之间进行选择的决策过程(例如,场景分类[Mirza et al. 2016])。

图 4.3 的下图显示了一个非常相似的图形模型,但以连续时间表达。该模型不是将轨迹表示为一系列状态,而是表示状态(x)的当前位置、速度和加速度(以及连续的时间导数)。这些值(称为运动的广义坐标)可以用来通过泰勒级数展开重构轨迹(关于在此上下文中泰勒级数近似的介绍,请参见附录A)。这里状态与其时间导数之间的关系依赖于(缓慢变化的)原因(v),它们起着与上述策略类似的作用。如前所述,

两个动态生成模型(使用与图 4.2 相同的图形符号),我们将在本书的其余部分中引用。上图:部分可观测马尔可夫决策过程(POMDP),以随时间演化的状态序列定义(由下标索引)。下图:连续时间模型,由随机微分方程隐含的类型(撇号表示法表示时间导数)。

状态生成观测(y)。符号的差异(s, π, o vs. x, v, y)用于强调在离散时间中演化的分类变量与在连续时间中演化的连续变量之间的差异。同样,从这里开始,我们将对连续变量的概率密度使用小写 p 和 q,对分类变量的分布使用大写 P 和 Q。4.4 节和 4.5 节将更详细地解释这些模型,并将展示在每种情况下自由能的最小化如何导致描述推理过程动力学的方程组。

在本节中,我们重点关注上述概述的离散时间模型。这对于理解处理分类推理和在替代假设之间进行选择的一系列认知过程非常重要。这种形式化还促进了对经典利用-探索问题的研究,并说明了主动推理如何解决这个问题。

如图 4.3 所示,POMDP 表达了依赖于策略的隐藏状态序列随时间的演化。要正式指定这个过程,我们需要说明图中每个方形因子节点的形式。首先,我们描述每个这些因子。然后我们将它们组合来表达构成生成模型的联合分布。

与第 2 章给出的贝叶斯规则简单例子一样,我们可以将因子分为表示似然的因子和组合形成先验的因子。似然与之前使用的相似,表达了给定状态(隐藏)的结果(可观测)的概率。如果结果和状态都是分类变量,似然是一个分类分布,由矩阵 A 参数化:

P(oτ | sτ ) = Cat(A) (4.5) Aij = P( oτ = i | sτ = j )

这里的第二行详细说明了 Cat 符号的含义(即分类分布的规范)。这说明了图 4.3 中标记为”2”的节点。隐藏状态序列的先验(使用 ∼ 符号表达)依赖于两件事:初始状态的先验(由向量 D 指定)和关于一个时间的状态如何转换到下一个时间状态的信念(指定为矩阵 B):

P(s1:τ | π ) = P(s1) ∏τ=1 P(sτ+1 | sτ, π) (4.6) P( s1 ) = Cat( D ) P(sτ+1 | sτ, π ) = Cat( Bπτ )

这些共同构成了图4.3中的”3”个节点。注意,转换条件依赖于所选择的策略。因此,我们可以将方程4.6的先验与方程4.5的似然解释为表达行为序列的模型(π)。为了让我们能够在这些模型之间进行选择(即形成计划),我们需要关于最可能序列的先验信念。

对于一个自由能最小化的生物体,一个自洽的先验是:最可能的策略是那些将导致未来最低预期自由能(G)的策略:

P(π) = Cat(π[0])

Gπ[0] = σ(−G)[π] = G(π) = −E[Q!][D[KL][(so!) || (s π[Q]! | Q! |, π)]] − E[Q!][ln P(o![C])]

Q!(o, s |π)! P(o | s)Q(s |π)[τ][τ][τ][τ][τ]

这个方程对Active Inference具有根本重要性,值得更深入地解释。前两行表达了每个策略的先验概率,由π[0]参数化,与该策略相关的负预期自由能相关。softmax函数(σ)强制归一化(即确保策略上的概率之和为一)。方程4.7的最后两行表达了预期自由能的形式。

注意这与自由能的函数形式(方程4.4)的相似性——带有结果的对数概率和KL散度。这里的关键区别是期望是相对于后验预测密度而取的,如最终等式所定义。这个分布表达了未来状态和观察的联合概率。关键是,这意味着我们可以计算未来的预期自由能——这是我们无法用变分自由能做到的,因为变分自由能依赖于(现在和过去的)观察。此外,注意结果上的分布依赖于参数(C)和KL散度符号的反转,这是在后验预测概率下期望的结果。最后一点可能会造成一些困惑,所以值得明确说明为什么会这样。在变分自由能的上下文中,KL散度是近似后验的对数概率与精确后验的对数概率之间的期望差异(方程4.4)。预期自由能中的类似项是近似后验与我们基于整个结果轨迹获得的精确后验之间的期望差异,使用当前后验信念作为先验。展开这个,我们得到:

E[Q!][Qs!|π ln()] − lnQ[(]s! | o!,π)]

= E[Q(o!|π)]E[Q(s!|o!,π)][Qs!|π ln()] − lnQ[(]s! | o!,π)]

= −E[Q(o!|π)]E[Q(s|o!,π)][lnQs! | o!, π)] − Q[(]s!|π)]

= −E[Q!][D[KL][(s! | o!, π) || (s!π)]]

这里我们看到必须采用期望的顺序很重要。它引发了相对于变分自由能中类似项的符号反转。这支撑了两个量之间的重要差异。预期自由能通过选择那些导致信念大幅改变的观察来最小化,相反,变分自由能在观察符合当前信念时被最小化。这是在已经收集的数据基础上优化信念(变分自由能最小化)与选择最能优化信念的数据(预期自由能最小化)之间的差异。

这重申了Active Inference使用两个构造:变分自由能(F)和预期自由能(G),它们在数学上相关但发挥不同和互补的作用。变分自由能是随时间最小化的主要量。它相对于生成模型进行优化,该模型可以包括策略(或动作序列)。与所有其他隐藏状态一样,智能体需要为策略分配先验概率——因为策略只是生成模型中的另一个随机变量。Active Inference使用一个先验,该先验(宽泛地说)等价于相信人们将在未来最小化自由能的信念:即预期自由能。换句话说,预期自由能为策略提供先验,因此是最小化变分自由能的前提条件。

在第2章中,我们看到,与变分自由能一样,预期自由能可以通过多种方式重新排列来揭示各种解释。在这里,我们专注于将其解释为与策略相关的风险和模糊性之间的差异。这等价于方程4.7中的表达式:

G(π) = −E[Q!][D[KL][(s!, o!) || (s π Q! | π)]] − E[Q!][ln P(o![C])]

= E[Q!][H[P(o! | s!)]] + D[KL][Q(o|π) || P(o![C])] 信息增益 实用价值风险 预期模糊性 (4.9)

回顾第2章,其中第一个表达了寻求新信息(即探索)和寻求偏好观察(即开发)之间的权衡。通过最小化期望自由能,这些项之间的相对平衡决定了行为是主要表现为探索性还是开发性的。注意实用价值作为关于观察的先验信念出现,其中这个分布的C参数

可以选择来反映我们感兴趣表征的系统类型(根据其特征或偏好结果状态)。根据方程4.9的第二行,我们可以将方程4.7重写为以下线性代数形式:

π [0] = σ (−G)

G [π] = H i s[πτ] + o i [πτ] ς [πτ]

ς [πτ] = ln o lnC [πτ] −[τ]

H = −diag(A i ln A)

P(o | C) Cat(C ) [τ] = (4.10) [τ]

Q(o | ) [τ] π = Cat(o ), o As [πτ] [πτ] =[πτ]

Q(s[τ] | π ) = Cat(s[πτ] )

[Q(s ) Cat( ), s [τ] = s [τ] = [∑]] π s [π][πτ] [π]

方程4.10的第一行使用softmax(归一化指数)运算符从期望自由能向量构造一个概率分布(用充分统计量π [0]参数化),其和为一。第二到四行以线性代数记号表达期望自由能的组成部分。第五行显示关于观察的先验信念是分类分布(其充分统计量在C向量中给出)。第六到八行指定线性代数量和相关概率分布之间的关系。完成生成模型的规范后,我们现在可以用上述变量表达自由能:

F = π i F

F F [π] = [πτ] (4.11) [τ] [∑]

F [πτ] = s i s [πτ] (ln[πτ] − ln A i o B s [τ] − ln [πτ][πτ −][1])

将其分解为时间求和是由于隐含的平均场近似,该近似假设我们可以将近似后验分解为因子的乘积:

[Q s ! [( )]] | π = [∏] Q s [(] | [τ]π [)] (4.12) [τ]

在对数形式中,这变成一个求和,就像方程4.11一样。这种因式分解是变分推理中的许多可能性之一,代表最简单的选择。在实践中,这通常稍有细微差别,如附录B中详述。

到目前为止,我们已经定义了离散时间生成模型的四个关键成分。这些是似然性(A)、转移概率(B)、关于观察的先验信念(C)和关于初始状态的先验信念(D)。一旦指定了这些概率分布,就可以采用通用消息传递方案来最小化自由能并求解POMDP。为了在给定策略下对隐状态进行推理,我们设置辅助变量(v)的变化率(代表对数后验(s))等于负自由能梯度。然后使用softmax(归一化指数)函数从v计算s。

s[πτ] = σ (v ) [πτ]

v[πτ] = . ε − ∇

[πτ] [s] [πτ] ! F (4.13)

= ln A i o [τ] + lnB[πτ]s[πτ −][1] + lnB i [πτ +] [1] s[πτ +][1] − ln s[πτ]

方程4.13可以被视为变分消息传递的一个例子(见框4.1)。为了更新关于策略的信念,我们找到最小化自由能的后验:

∇ [π] F = 0 ⇔ [(4.14) σ π = ( − G − F )]

对于最简单的POMDP形式,方程4.13和4.14可以用于求解任何概率矩阵集的Active Inference问题;这些可以被认为分别描述感知和规划。我们将在本书的第二部分更详细地展开这一点,其中我们将提供Active Inference在感知和规划(以及其他认知功能)方面的具体例子。

图4.4对方程4.10、4.13和4.14的图形表示暗示了大脑中自由能最小化的可能神经元实现——如果将节点解释为神经元群体,边缘解释为突触,消息解释为突触交换。在后面的章节中,我们将考虑将此扩展到因式分解状态空间、深度时间模型,以及生成模型本身参数的优化(学习)。

在前面的部分中,我们处理了Active Inference在特定生成模型选择下所采取的形式。这些POMDP是一种有用的方式来

我们在第3章中遇到了Markov blanket的概念。然而,在这里简要回顾这个想法是值得的。它涉及多个相互作用变量的系统。给定变量的Markov blanket包括与其相互作用的变量子集。如果我们了解这个子集的一切,对这个子集之外任何东西的了解都不会增加我们对感兴趣变量的知识。这里的相关性在于,我们可以基于其Markov blanket的局部信息,在图形模型中对变量进行推理。变量x的blanket是那些导致x的变量(parents,

[ρ][(][x][)), 由][x][ 引起的变量(][ children][,][κ ][(][x][)),以及][x][的子节点的父节点。使用这种表示法,用于近似推理的两种最常见贝叶斯消息传递方案定义如下:]

[变分消息传递]

[ln][Q]([)] [=] [E][Q][(][ρ]([))][[ln] [P][(][x][|] [ρ][(][x][))]] [+] [E][Q][(][κ]([))][Q][(][ρ][(][κ]([)))][[ln] [P][(][κ][(][x][)|] [ρ][(][κ][(][x][)))]]

[Q][(][x][)]

这涉及来自的马尔可夫毯所有组成部分的消息,包括父节点(通过给定其父节点的条件概率)和子节点。后者依赖于的子节点给定其所有父节点的条件概率——其中包括。注意期望包括子节点的子节点和父节点。由于子节点的父节点包括[,我们除以][Q]([) 以确保期望仅包括毯子。]

[信念传播]

[ln][Q]([)] [=] [ln] [µ][κ] ([)] [+] [ln] [µ][ρ] ([)]

[µ][κ] ([)] [=] [E][µ][κ] [(][κ]([))][µ][ρ] [(][κ] ([))][[][P][(][κ] ([)|] [ρ][(][κ] ([)))]]

[µ] [x][(][κ] ([))]

[µ][ρ] ([)] [=] [E][µ] [P] x [ρ] x [ρ] [(] [ρ] [(] x [))] [µ] [κ] [(] [ρ] [(] x [))] [[] [(] [|] [(][))]]

[µ] [x][(][ρ][(][x][))]

[这与变分消息传递具有大致相同的结构,但使用消息的递归定义,使得每个消息(][μ][a][(][b][) 是从][a][到][b][的消息)依赖于其他消息(到][a][的消息)。这具有方向性方面,使得从][a][到][b][的消息依赖于到][a][的所有消息,除了来自][b][的消息(因此在期望中有除法)。注:这里对期望算子的略微非标准使用使我们能够(1)涵盖离散和连续变量,(2)突出变分消息传递和信念传播之间的形式相似性。]

[主动推理的生成模型 77]

[ε][(][i][+2)] [动力学]

[] ([+1)]

[ς][(][i][+1)]

[ς] [ς] [ς] [τ] [–1] [τ][τ][+1]

[s][(][i][+1)]

[ε][(][i][+1)] [[s] [s] [s] [τ] [–1] [τ] [τ] [+1]]

[层次结构]

[] [s] [s] [s] i [τ] [–1] [τ] [+1]

[ς][(][i][)]

[s][ ε] [ε] [ε] [τ] [–1] [τ][τ][+1] i [)]

[ε][(][i][)]

[o][τ][–1] [o][τ] [o][τ][+1]

[õ]

[图4.4]

[贝叶斯消息传递。][右:][正文中概述的信念更新方案中不同变量之间的依赖关系。直观地,关于每个策略下每个时间的状态的当前信念与基于其他时间状态信念(1)和当前结果预测的信念进行比较以计算预测误差。这些误差然后驱动这些信念的更新(2);给定每个策略下状态的信念,我们可以计算预期自由能的梯度(3)。这些与每个策略下预测的结果(图中省略)相结合,以计算关于策略的信念(4)。使用贝叶斯模型平均,我们可以计算在策略上平均的状态后验信念(5)。这个消息传递的高级总结省略了一些可以包含的中间连接(例如,连接(4)可以展开以明确包含预期自由能的计算)。][左:][该方案可以分层扩展(为简单起见,在时间步长和策略上折叠)。关键思想是更高级别的网络可能预测较低级别的状态和策略,并使用这些来推断发生这些情况的上下文。我们将在第7章进一步展开这个想法。]

[78 ] [[第4章]]

阐述一系列推理问题,包括支撑规划和决策制定的问题。然而,当涉及与真实环境交互时,用分类变量在离散时间中描述的模型就不够了。这是因为感官输入和运动输出是连续演化的变量。为了解决这个问题,我们现在转向不同类型的生成模型。我们对这些模型应用完全相同的思想,即变分自由能的梯度下降,以找到类似的消息传递方案。

## 4.5.1 预测编码的生成模型

为了激发用于连续状态的生成模型的形式,我们从以下一对方程开始:

x = . f (x,v ) + ωx (4.15)

y = g(x,v ) + ω[y]

第一个方程表达隐藏状态随时间的演化,根据确定性函数(f (x, v))和随机波动(ω)。第二个方程表达数据从隐藏状态生成的方式。在每种情况下,波动都假设为正态分布,给出动力学和似然的以下概率密度:

p(x | x,v) = . N (f (x,v ), Πx )

p(y | x,v ) = (4.16) N ( g(x,v ), Π[y] )

精确度(Π)项是波动的逆协方差。这两个方程构成了工程中Kalman-Bucy滤波器的生成模型基础。然而,这类方案受到时间上不相关波动假设(即Wiener假设)的限制。这对于生物系统中的推理是不合适的,因为生物系统中的波动本身是由动态系统生成的,具有一定的平滑度。我们可以通过不仅考虑隐状态的变化率和当前数据值,还考虑它们的速度、加速度和后续时间导数来解决这个问题——即广义运动坐标(Friston, Stephan et al. 2010; 见框4.2):

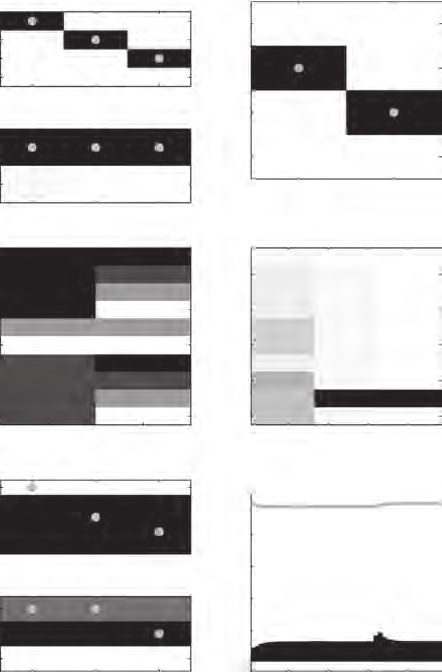

为了表示连续时间中的轨迹,广义运动坐标提供了一个简单的参数化方法。这基于围绕当前时间的多项式(泰勒级数)展开,给出一个让我们能够外推到最近过去和近期未来的函数。图4.5中的图显示了某个空间(x)中随时间(τ)的轨迹作为实线。从左到右,它们显示了用一个、两个和三个坐标(x的连续时间导数)表示的广义运动坐标中的轨迹。这是虚线。这里的展开是围绕初始时间点。随着每个连续的广义坐标,我们得到轨迹在近期未来的更准确近似。对于大多数应用,大约六个广义坐标就足够了。

x [(τ)] ≈ x₀ x [(τ)] ≈ x₀ + τx’₀ x [(τ)] ≈ x₀ + τx’₀ + (τ²x’’₀)/2

x = f(x, v) + ω y = g(x, v) + ω x’ = f’(x’, v’) + ω’ y’ = g’(x’, v’) + ω’ x’’ = f’‘(x’‘, v’‘) + ω’’ y’’ = g’‘(x’‘, v’‘) + ω’’ (4.17) ⋮ xi = fi + ωi yi = gi + ωi

这些广义坐标可以通过将轨迹(再次使用~符号)表示为一个向量更简洁地总结,该向量的元素对应于上述连续导数:

Dx̃ = f(x̃, ṽ) + ω̃ ⎫ p(x̃|ṽ) = N(Df, Πx) ⎬ ⇒ (4.18) ỹ = g(x̃, ṽ) + ω̃ ⎭ p(ỹ|x̃, ṽ) = N(g, Πy)

在方程4.18中,D是一个在主对角线上方有1、其他地方为0的矩阵。这有效地将向量的所有元素向上移动,可以被认为是导数算子。广义精确度矩阵可以基于我们对波动平滑度的假设来构建,详见附录B。配备了对隐因(v)的先验(其相关性将在下面变得更清楚),这让我们可以写下这个生成模型的自由能:

F[μ,y] = -ln p(y, μ̃x, μ̃v) = ½ε̃ᵀΠε̃ = ½(ε̃yᵀΠyε̃y + ε̃xᵀΠxε̃x + ε̃vᵀΠvε̃v) (4.19)

ε̃ = ⎡ε̃y⎤ = ⎡y - g(μ̃x, μ̃v)⎤ ⎢ε̃x⎥ ⎢Dμ̃x - f(μ̃x, μ̃v)⎥ ⎣ε̃v⎦ ⎣μ̃v - η⎦

Π = ⎡Πy ⎤ ⎢ Πx ⎥ ⎣ Πv⎦

在方程4.19中,μ项表示x和v项的近似后验密度的模式。自由能在第一行采用如此简单形式的原因是我们采用了拉普拉斯近似,详见框4.3。简而言之,这将所有概率密度视为高斯分布,通过泰勒级数展开,这等价于假设我们在分布模式附近操作。方程的第二行用精确度加权预测误差的平方来表达对数概率。这省略了所有相对于后验模式为常数的项。第三行按照对数似然、给定v的x的对数概率和v的对数先验来展开。

因为在拉普拉斯近似下,近似后验的方差是模式的解析函数,我们可以相对于模式优化自由能。思考这个问题的一个简单方法是我们只需要找到每个状态的最大后验(MAP)估计[5]。这些是后验分布的均值,可以通过拉普拉斯近似配备其精确度而无需进一步推理(见框4.3)。

拉普拉斯近似依赖于与框4.2中描述的广义运动坐标类似的原理。其思想是自由能可以通过围绕后验模式(μ)的二次展开来近似。在一维中,这如下所示:

[F][[][y][,] [q][]] [=] [E][q]([)][[ln][q][(][x][)] [−] [ln] [p][(][y][,][x][)]]

≈ [⎢] [E] [q] [(] x [)][ln] [q][(][µ][)] [+] ( [−] [µ][)] ∂ [ln] [q][(][x][)] [+] [1] x [⎡] [⎢] [=] [µ] [2] x ( [−] [µ][)][2] [∂][2] [ln] [q][(][x][)] [x][=][µ] [!] [##] ["] [##] [$] [⎣]

[−][ln] [p][(][y][,] [µ][)] [−] ( [−] [µ][)] ∂ [ln] [p][(][y][,][x][)] [−] [1] ( [−] [µ][)][2] [∂][2] x [ln] [p][(][y][,] x [=] [µ] 2[)] [⎥] x [=] [µ] [⎥] [⎦] [⎢] [=][0] [⎤]

假设二次展开是充分的,这等价于说我们可以将概率视为高斯分布(因为高斯密度的对数是二次的)。明确这一点后,我们可以将上述简化为以下形式:

[q] [−][1] [(] x [)] [=] [N] [(] [µ] [,] [∑] [)]

[F] [1] [⎡] [[] [y] [,] [µ] []] [=] [−] [ln2] [π ∑ −] [ln] [p] [(] [y] [,] [µ] [)] [−] [tr] [2] x [ln] [p][(][y][,] [x][)] [⎤] [∑∂] [⎣] x [=] [µ] [2] [⎦]

在二次假设下,唯一依赖于模式的项是第二项。省略其他项得到方程4.19中的表达式。一旦我们知道了模式,我们可以通过以下展开直接找到近似后验的精度:

[ln] [q][(][x][)] [≈] [ln] [p][(][x][|] [y][)]

[=] [ln] [p][(][x][,] [y][)] [−] [ln] [p][(][y][)]

≈ [ln] [p][(][µ][,][y][)] [+] ( [−] [µ][)] i [∂] x [ln] [p][(][x][,] [y][)] [x][=][µ] [!] [##] ["] [##] [$] [=] [0]

[⇒] [+] [1] [2] ( [−] [µ][)] i [∂][2] x [ln] [p][(][x][,] [y][)] ( [µ][)] [ln] [p][(] [y][)] x [=] [µ] [−] [−] [−] [1] [1] [q] [(] x [)] [∝] [−] [(] x [)] [∑] [µ] [e] [2] [−] [µ] i [(] x [−] [)] [−] [,] [∑] [1] [=] [− ∂] [2] x [ln] [p] [(] x [,] [y] [)] x [=][µ]

这告诉我们后验精度简单地等于在后验模式处评估的联合概率的二阶导数。

µ !" − Dµ = ! −∇ [µ] [!]F

= ∇ p(y !, ! [µ] [!] ln µ)

⎡ [= −∇ ε ! i ! ! [µ] [!] Π ε [(4.20) ! ! ! !] µ !" g ε ! i ! x − D µ ! ⎡ − + x ⎤ ∇ i ! [µ] [!] Π ε x [y] [y] D Π ∇ i x x ! [µ] [!] f Π x x ε x ⎤ ⎢ ⎥ = ⎢ ⎥ µ !" ⎢ [v] − D µ ! ! ⎢ ! ∇ g ! i ! ! ⎣ [v] ⎦ ⎥ ! ⎥ ⎣ [µ] [!] Π ε [v] [y] ! [y] + ∇ i [µ] [!] f Π ε ! [v] x x − Π [v] ε [v] ⎦]

Downloaded from http://direct.mit.edu/books/oa-monograph/chapter-pdf/2004457/c003400_9780262369978.pdf by guest on 02 April 2022 82 第4章

与我们在离散时间方案中看到的梯度下降相比,方程4.20的左侧是μ的变化率与应用于此的导数算子之间的差异。这是因为当自由能最小化时,如果与变化率相关的后验模式非零,那么后验模式的变化率为零是没有意义的。换句话说,“模式的运动应该是运动的模式”在自由能最小值处。这确保了当自由能最小化时[[]] µ µ =[[+][1]]。

我们可以比方程4.20更进一步,将隐藏原因(v)视为正由更高层次生成的数据,具有更慢的动力学(使得v在较低层次看起来不会改变)。通过这样做,我们可以将一系列方程链接在一起:

⎡ ⎡ ! ⎤ ! ⎤ ⎢ ⎥ ⎢ ⎥ [(] µ "# [(] i [)] [)] ∇ i [)] i " [(] i [−] [1)] [(] i [−] [1)] " " Π i ⎢ [v] ε " i [v] − D i Π [(] [)] [(] x ε " [(] i [)] " x + ∇ [(] i [)] f [(] i [)] i Π [)] ε " [(] i [)] x x x − D µ " [(] i x ⎥ [(] i [)] g " ⎢ [µ] ["] [µ] ["] = x x ⎥ ⎢ ⎥ ⎢ µ i "# [(] i [)] [(] [)] [v] − D µ " i ⎥ ⎢ [v] ∇ i [(] i [−] [1)] [(] [−] [1)] " i [)] i " " ⎢ [(] i [)] g " [(] [)] i " Π [v] ε " [v] + ∇ [(] ⎥ [(] i [)] f Π [(] i [)] [(] i x ε " [(] i [)] x − Π [)] [v] ε " [(] i [)] [v] ⎥ [µ] ["] [v] [µ] ["] ⎢ [v] ⎥ ⎢ ⎥ ! (4.21) ⎣ ⎦ ⎢ ! ⎥ ⎣ ⎦

⎣ "([)] µ([)] i [1)] [(] ⎢ ⎥ i [+] [1)] [(] i [+] [1)] [v] ⎢ ⎢ = ⎥ ε ⎡ ε([)] D " ([)] ( x ⎤ µ x − f) ⎤

⎦ " [v] − g [(] [+] (µ "x , µ "[v] )⎥ ⎣ ⎦

ε "[(0)] [v] $ " ε[y]

图4.6图形化地强调了隐藏状态(x)在一个层次级别内连接时间导数的作用,以及隐藏原因(v)在连接层次级别的作用。在这个预测编码方案中(Rao和Ballard 1999, Friston和Kiebel 2009),更高层次向更低层次发送下行预测,较低层次计算这些预测中的误差并将这些误差传回层次结构上方以更新信念。

为了完成我们对主动推理语境下预测编码的概述,我们需要纳入动作。鉴于我们的目标是最小化自由能,而动作的结果是我们改变了感觉数据,我们有以下公式:

u = . −∇

[u]F [(4.22)]

= −∇ ! ! [u] y ( u ) i Π[y]ε ![y]

这个方程说明我们通过动作最小化自由能,而自由能中唯一直接依赖于动作的部分是预测误差的最低层次。换句话说,动作简单地满足下行

Downloaded from http://direct.mit.edu/books/oa-monograph/chapter-pdf/2004457/c003400_9780262369978.pdf by guest on 02 April 2022 主动推理的生成模型 83

[ε] i [(][+1)]

[v] [Dynamics]

[ε] ([+1)]

x [µ][[1]] [µ][[2]] [µ][[3]]

[(] [[v] [v] [v] [+1)]]

[µ] i

[ε][(][i][)]

[v] [ε][[1]] [ε][[2]] [ε][[3]]

[层级结构]

[µ] [(] [[µ][[1]] [[2]] [[3]] [µ] [µ] i [)] x x x]

[ε] i [(][)]

x [[1]] [[2]] [[3]] [ε] [ε] [ε]

[µ] ([)] [y] [y] [y]

[ε] ([)]

[y]

[y] [[1]] [[2]] [[3]] [y] [y]

[y]

图4.6

广义预测编码方案的消息传递。左图:根据感觉数据计算预测误差,显示这些误差如何在层级结构中向上传播。较高层级向较低层级发送预测,这些预测可以与感觉数据进行比较以计算这些误差。右图:层级结构的单一层说明了代表不同阶广义运动的神经元群体如何相互作用。

通过最小化动作的预测与观察到的感觉后果之间的误差来对数据进行预测。一种理解方式是,仿佛我们为预测编码方案在层级结构的最低层配备了经典反射弧(Adams, Shipp, and Friston 2013)。在这种设置下,主动推理(Active Inference)只是预测编码加上反射弧。从神经生物学角度来看,这个想法是感觉传入神经进入脑干或脊髓并与运动神经元形成突触。感觉输入的下行预测从皮层传播到运动神经元,运动神经元的输出取决于其皮层和感觉输入之间的差异。

从计算角度来看,反射弧是最简单的控制器形式之一;它们纠正预测和观察到的本体感觉信号中的偏差。更复杂的运动行为需要生成预测序列并使用反射弧按顺序实现这些预测。这种机制使主动推理区别于其他生物运动控制方案,如最优控制,后者不基于预测编码,使用比反射弧更复杂的逆模型和控制器(Friston 2011)。主动推理的另一个独特特征是它摒弃了最优控制(和强化学习)中使用的价值或成本概念;这些完全被吸收到(通常更具表达性的)先验概念中(进一步讨论见第10章)。

本章概述了支持主动推理的基本形式化思想。要记住的关键信息是,(近似)贝叶斯推理可以被框定为最小化一个称为变分自由能的量。这依赖于一个生成模型,该模型表达我们关于数据如何生成的信念。我们已经研究了可以根据手头推理问题使用的生成模型的两种形式:具体来说,这取决于我们是否对分类变量或连续变量感兴趣。两者的自由能最小化解决方案都可以用神经元群体之间的消息传递来解释,包括从连续模型衍生的广义预测编码方案。最后,我们注意到自由能不仅可以通过改变信念来最小化——使它们与数据保持一致——还可以通过对世界采取行动来使数据更符合信念。在后续章节中,我们将运用这里介绍的形式化方法,并将它们应用到更具体的设置中,提供机会来探索这里阐述的广泛概念的扩展。

基本上有两种动物:动物,以及没有大脑的动物;后者被称为植物。它们不需要神经系统,因为它们不主动移动,不会在森林火灾中拔起根系逃跑!任何主动移动的生物都需要神经系统;否则它会很快死亡。 ——鲁道夫·利纳斯(Rodolfo Llinas)

在第4章中,我们看到了变分推理对两种生成模型所采取的形式。在本章中,我们关注由这些推理动力学产生的过程理论:解释大脑如何实现变分推理的理论。这种贝叶斯信念更新实现的核心是贝叶斯消息传递的概念,它包含信念传播和变分消息传递等方案。支撑这些方案的思想是,并非所有事物都直接依赖于所有其他事物。相反,生成模型中的每个变量依赖于相对较少的其他变量。类似地,大脑表现出稀疏的连接结构,其中任何神经元的活动只依赖于与它共享突触的那些神经元。本章重点讨论我们如何将与变分推理相关的稀疏消息传递映射到生物计算的稀疏连接结构。

让我们从第4章的技术材料中退一步,将注意力转向伴随主动推理的过程理论。区分原理(即自由能的最小化)和关于如何实现这一原理的过程理论是重要的。

在特定系统(如大脑)中实现。后者让我们能够发展可通过经验数据来检验的假设。为了阐述主动推理在大脑中可能表现的方式,我们将第4章末尾看到的消息传递与突触通信等同起来,并将梯度下降的动力学与神经元活动等同起来。本章的双重目标是向具有技术背景的读者介绍主动推理的神经生物学,并向生物学家强调理论对实践神经科学的相关性。我们强调,本章并非主动推理过程理论的最终结论(Pezzulo, Rigoli, and Friston 2015, 2018; Friston and Buzsaki 2016; Friston and Herreros 2016; Friston, FitzGerald et al. 2017; Friston, Parr et al. 2017; Parr and Friston 2018b; Parr, Markovic et al. 2019);它只是与当前可获得证据最一致的解释。我们的目标也不是认可特定的过程理论,而是说明如何运用第1-4章中阐述的思想来构建可通过神经生物学测量来验证的假设。

本章组织如下。首先,在5.2节中,我们考虑皮质微回路的作用。这是一个功能单元,包含几个相互连接的神经元群体。连接模式在许多皮质区域中重复出现。我们强调这种刻板回路与图4.4和4.6的消息传递架构之间的关系——它们本身在层级水平上重复出现。在5.3节中,我们转向效应器系统和主动推理下的运动控制表述。这涉及运动皮质如何调节脊髓和脑干反射弧以产生有目的的行为。5.4节涉及与皮质下结构(如丘脑和基底神经节)相关的思想——它们在规划和决策中发挥重要作用。然后在5.5节中,我们考虑突触效能的调节,包括神经递质在精度优化中的作用以及塑性变化在学习中的作用。最后,在5.6节中,我们回到层级的主题以及决策制定与运动生成之间的关系。

在第4章中,我们看到介导变分推理的信念更新方程可以用(神经元)网络来解释。所呈现的推理方案——对于连续和分类模型——每个都产生

一种刻板的回路,其结构在层级生成模型中重复出现。类似地,大脑皮质的架构具有刻板结构(Shipp 2007)。新皮质分为六层(或层板),从浅层(靠近大脑表面)到深层(更靠近皮质下白质)编号。每层的特征是特定细胞类型和连接模式的存在(Zeki and Shipp 1988, Felleman and Van Essen 1991, Callaway and Wiser 2009);这种连接在图5.1中单个皮质柱的示意图中得到总结。

大脑一个区域的皮质柱连接到其他区域的柱和皮质下结构。皮质区域通常以层级形式描述,(粗略地说)将最接近感觉输入或运动输出的区域分配到层级的最低层。当我们远离这些区域时——例如,从初级视觉皮质到次级视觉皮质——我们沿层级上升。这种层级概念由图5.1所示的层板特异性连接结构所支持。来自较低皮质区域或感觉(初级)丘脑核团的上行投射(即连接)倾向于靶向第IV层的棘突星形细胞。较低皮质区域从其浅表锥体细胞(第II层和第III层)产生上行连接。来自较高皮质区域的下行投射靶向较低区域的浅表层和深层,起源于深层(第VI层)锥体细胞。此外,第V层的深层锥体细胞(Betz细胞)投射到各种其他目标,包括皮质下核团——如基底神经节和次级丘脑核团——以及脊髓运动神经元。

图5.1中的中间示意图显示了从预测编码网络(图4.4)到皮质层板解剖结构的一种可能映射(Friston, Parr, and de Vries 2017)。这有点复杂难以解释,但要点如下。到第IV层棘突星形细胞的上行输入与隐藏原因的预测误差(ε(i)v)相关。来自第III层浅表锥体细胞的上行输出代表层级下一层的相同预测误差(ε(i+1)v)。

下行输入代表来自更高层级的预测(g(i+1)),而下行输出是对较低层级的预测(g(i))。在最低层级,我们看到来自第V层的下行预测,这与左侧显示的对脊髓运动神经元的输出一致。我们将在5.3节中回到这一点。回想第4章,隐藏原因的作用是将在多个不同时间尺度上运行的模型的层级层次连接起来。这与隐藏状态形成对比,隐藏状态的作用是

II s(i) SP II μ(i) μ(i) vx

III ε(i+1) SP II s(i) v

皮层第IV层 SS II ε(i) i) ε(i) v ε(x

V (i) ς(i) DP μ(1) μ(1) ovx

VI μ(i) DP i) ) v μ(s(ix

初级丘脑 基底神经节 ε(i) g(i) g(1) A(i)s(i-1) s(i) (i) G v

低级皮层区域 次级丘脑

脊髓运动神经元

图5.1

典型皮层微回路图示,展现了推理消息传递与大脑皮层架构之间的关系。左图:基于Miller 2003; Haeusler and Maass 2007; Shipp 2007, 2016; 以及Bastos et al. 2012的综合分析的简化示意图(参考这些论文获取该综合分析所依据的神经解剖学观察的总结)。圆形箭头表示抑制;普通箭头表示兴奋性连接。神经元群大致分为浅层锥体细胞(SP)、深层锥体细胞(DP)、有刺星形细胞(SS)和抑制性中间神经元(II)。中图:支撑分层预测编码的消息传递。右图:解决部分可观察马尔可夫决策过程(POMDP)所需的消息传递。

在特定时间尺度的动态中——这与它们在图5.1中列内(within-column)连接性的固有作用一致。

消息传递的不对称性很重要,因为它对上行和下行活动之间的差异提供了经验预测。其中一个预测是,我们可能期望这些消息通过不同时间频率的神经活动来传递。原因在于从期望中计算预测误差所需的操作是非线性的(Friston 2019b)。这种非线性是由于使用非线性函数(g)计算预测,这些函数倾向于增加信号的频率(例如,正弦波平方时频率加倍)。由此产生的预测是上行

l

ε(i) (i+1) (i+1) ε ε v v v

浅层 (i-1) (i) (i+1) ε ε ε x x x

μ(i-1) (μi) (i+1) μ v v v

深层 i(i-1) μ μ()) (i+1) μ x x x

图5.2

图5.1中间所示预测编码方案的简化版本,展开显示了三个皮层区域之间的消息传递。重点在于消息传递的不对称性,虚线显示上行消息(预测误差),实线显示下行消息(预测)。图5.1是该示意图的更精细版本,包括了此处显示的多突触连接中的中间神经元。在此图中,对层状特异性进行粗粒化并将皮层相对于第IV层分为浅层和深层,恢复了许多读者熟悉的预测编码方案。

消息——来自误差单元——可能在比下行消息——来自期望单元——更高的频段中测量到(参见图5.2)。这与测量到的频谱不对称性一致,其中上行连接通常与γ频率相关,下行连接与α或β频段相关(Arnal and Giraud 2012; Bastos, Litvak et al. 2015)。

图5.1右侧的示意图显示了POMDP模型消息传递作为皮层微回路的解释。这与预测编码架构具有相似的结构,期望(s)在浅层和深层锥体细胞中表示,并在皮层层级中上下传播。此外,第IV层的误差单元(ε)接收上行信号。与预测编码风格的架构相比,区域间传递的消息是期望的混合而非误差(Friston, Rosch et al. 2017; Parr, Markovic et al. 2019)。然而,

通过更新期望来最小化误差(即自由能梯度)的整体结构得以保持。这种消息传递区分了基于策略条件的期望(下标π)和策略下的平均期望。要从前者转换到后者,我们还需要关于策略(π)的后验信念。我们将在5.4节中回到这一点,但现在值得强调这种消息传递与能够计算这些信念的皮层下结构对浅层皮层的靶向性的一致性。

在图5.1中,请注意左侧的架构与中间和右侧的消息传递方案之间缺乏一对一的映射关系。例如,中间和左侧之间似乎存在差异:左侧列中的下行输入到达第II层和第IV层,但中间图形中的输入针对第III层。这突出表明,消息传递方案所暗示的连接可能不会表现为单个突触。针对第III层的下行抑制性连接可能由投射到第IV层抑制性中间神经元的兴奋性投射,以及这些中间神经元到第III层的投射的组合介导。这种双突触通路解决了两种架构之间的明显差异。

在第5.3节和第5.4节中,我们讨论第V层神经元在运动和计划中的作用,分别对应于它们的脊髓(或脑干)和皮层下投射。在第5.5节和第5.6节中,我们讨论神经消息传递随时间调节的方式,然后回到分类和连续推理的微回路之间的关系。

图5.1左侧的示意图显示皮层的第V层投射到脊髓锥体神经元,这可以被解释为一种预测(Adams, Shipp, and Friston 2013)。这在图5.3中得到了详细说明,该图显示了这个回路的脊髓组成部分;我们看到基于初级运动皮层第V层Betz细胞编码的期望的预测。这从传入脊髓背角的本体感觉输入中被减去,产生本体感觉预测误差。这种误差驱动肌肉活动,导致其自身的抑制——因为本体感觉数据改变以符合预测。将运动命令作为预测的概念是主动推理(Active Inference)的核心,因为它突出了

图5.3

与调节脊髓运动反射的主动推理相关的神经解剖学。从运动皮层第V层的Betz细胞(上位运动神经元)开始,锥体束携带运动皮层期望所涉及的运动下本体感觉输入的预测。束交叉并突触——有时是多突触——到脊髓腹角的下位运动神经元。从到达脊髓背角的本体感觉传入信号中减去预测,产生一个误差,该误差表明需要多少肌肉收缩来满足预测。然后下位运动神经元引起这种肌肉收缩(或放松),确保产生的本体感觉数据与下行预测匹配。

动作和感知的双重性。动作部分是通过改变数据来最小化预测和感觉数据之间的任何差异。这表明我们生成运动所需要的唯一东西就是对如果执行该运动将产生的感觉后果的预测。本体感觉预测误差总是可以通过反射(而不是信念更新)来解决这一事实,为初级运动皮层第IV层颗粒细胞稀少提供了可能的解释(Shipp, Adams, and Friston 2013)。

这种运动控制的一个重要方面是感觉衰减(sensory attenuation)的概念(Brown et al. 2013)。考虑启动新运动的问题。要做到这一点,我们需要能够预测我们正在运动。然而,在我们运动之前,手头的本体感觉数据与这个假设相矛盾,可能会促使其修订。因此,我们需要一种方法来防止感觉数据更新我们的期望,这样我们就可以持有(最初是错误的)我们正在运动的信念,以便这种信念可以通过动作来实现(参见观念运动现象(ideomotor phenomena))。这意味着我们需要能够通过降低本体感觉数据的增益来远离它们。从技术上讲,这种增益由预测这些数据的精确度(方差的倒数)给出。为了衰减这一点,我们需要下行运动束不仅预测数据,还要预测这些数据的精确度——或对这些数据的置信度,降低这种精确度来启动运动。这被称为感觉衰减,可以被认为是感觉注意的补充,为我们提供忽略某些预测误差的能力,比如由扫视眼球运动产生的误差(这里感觉衰减被称为扫视抑制(saccadic suppression))。衰减失败被认为是一系列神经和精神综合征的核心,包括被动现象(passivity phenomena)(Pareés et al. 2014),以及在最极端的情况下——精神分裂症的紧张状态和帕金森病中启动运动的失败。

除了向脊髓的投射外,皮质第V层还投射到其他几个结构。其中包括纹状体(Shipp 2007, Wall et al. 2013)——这是位于大脑深部的一个结构,由尾状核和壳核组成。纹状体是一个复杂网络结构的输入核团,这个网络被称为基底神经节。中等棘状神经元是纹状体的功能单位,接受来自皮质的输入并投射到基底神经节的其他核团。这些神经元分为两种类型——表达D1多巴胺受体的和表达D2受体的——多巴胺增强前者的活动并抑制后者的活动。前者细胞是通过基底神经节直接通路的起源,通过单个抑制性突触连接到输出核团(内侧苍白球和黑质网状部)。D2细胞产生间接通路,这是一个稍微复杂的过程,包含两个抑制性和一个兴奋性突触。纹状体抑制外侧苍白球,外侧苍白球本身抑制下丘脑核(STN)。STN投射到基底神经节输出,这意味着输出核团被直接通路抑制,被间接通路去抑制。由于这些核团本身是抑制性的,激活表达D1的纹状体神经元的净结果是去抑制行为,而这种行为会被表达D2的神经元抑制(Freeze et al. 2013)。

鉴于我们已经将本体感觉预测与向脊髓的投射相关联,我们应该将什么信息与第V层向纹状体的投射相关联?检查图5.1提供了一个可能的解决方案。预测结果(o)和偏好结果与预测结果之间的差异(ς)显示在该层中,结合计算策略的期望自由能(G)。在纹状体中计算后者与基底神经节参与规划的观念一致——即评估替代行动方案。图5.4显示了策略评估的信息传递映射到基底神经节解剖结构的一种可能方式。

从图5.4中要得出的关键点是,如第4章所述,策略的后验概率(π)——这里显示在内侧苍白球中——基于其期望自由能进行计算。这种模式遵循从皮质第V层通过纹状体到基底神经节输出核团的直接通路。然而,还有一些额外的细节。在图4.4左侧显示的分层方案中,我们看到关于高层状态的期望可以影响关于低层策略的信念。图5.4在左侧显示了这一点,其中高层状态下的期望观察用于形成经验先验(E),这些先验独立于期望自由能影响策略选择。我们将在第7章回到这个问题,但主要观点是我们对在特定情境中如何行动有信念。当我们再次发现自己处于相同情境时,这些先验期望往往会偏置策略评估——很像习惯形成。在这种意义下,E和G的影响可以分别被视为习惯性和目标导向的驱动。在强化学习中(Lee et al. 2014),这些有时被称为”无模型”和”基于模型”的系统。[1]将这些与基底神经节的直接和间接通路相关联有一个有趣的后果:这意味着多巴胺调节两者的平衡。记住多巴胺倾向于促进直接通路和特定策略的执行(Moss and Bolam 2008)——推测是那些与最低期望自由能相关的策略。相比之下,低多巴胺可能有利于间接通路中的情境敏感先验,其作用是抑制给定情境中不合理的策略。在某种意义上,纹状体多巴胺可以被认为是调节推断该做什么和不该做什么之间平衡的(Parr 2020)。

上述观点与多巴胺能系统的扰动一致;严重帕金森病中多巴胺的耗竭导致运动不能——无法执行特定策略——而外源性多巴胺激动剂促进冲动行为(Frank 2005; Galea et al. 2012; Friston, Schwartenbeck et al. 2014)。此外,这与基底神经节功能的概念模型一致。例如,Nambu(2004)建议直接通路介导内侧苍白球的快速和聚焦抑制,随后是广泛和缓慢的兴奋,这分别导致基底神经节目标的兴奋和抑制。这被认为确保了一个”中心-周围”模式,促进具有高特异性的运动程序,这与快速过程计算期望自由能促进行动和较慢通路传达经验先验的更广泛情境化一致。

关于图5.4的最后一个观察是,有两个层次的皮层层级(上标)贡献于同一个基底神经节回路。这表明在间接通路神经元的靶向中存在时间上较慢的区域,但对直接通路既有快速又有缓慢的影响。当我们上升皮层层级时,神经元倾向于代表较慢的动力学。例如,我们可能预期额叶皮层区域比顶叶区域代表更长的时间尺度。这与皮层输入到基底神经节通路的解剖分布一致(Wall et al. 2013)。间接通路中的这种时间粗粒化通过空间粗糙性得到补充,直接通路中等棘神经元表现出更大的树突分支(Gertler et al. 2008),实现了更精细的调节。因此,图5.4的解剖结构得到了临床病理学(例如,帕金森病)和细胞形态学证据的支持。

除了基底神经节,许多其他重要的皮层下结构也参与神经元信息传递。在下一节中,我们将讨论神经调节系统起源的那些结构;我们将通过简要涉及丘脑来结束本节。我们无法对这个高度复杂的结构给予充分的阐述;然而,我们可以概述一些基本原理。

丘脑通常分为初级和次级核团。图5.1显示初级丘脑核团可以发挥与较低皮层区域相同的作用,即它们靶向皮层的第IV层并接收来自第VI层深层锥体细胞的输入(Thomson 2010, Olsen et al. 2012)。一个例子是视觉系统中的外侧膝状核,通常被认为是眼睛和视觉皮层之间的中继站。像那些代表预测误差的神经元一样,它既接收来自眼睛的感觉信息,也接收来自皮层的反向投射,这可以被理解为预测。二级丘脑核团包括背内侧核和枕核,它们分别与额叶和后部皮层相互作用。这些可能在预测感觉或高阶输入的二阶统计量(即精度和方差)中发挥作用,并与图形-背景区分任务相关联(Kanai et al. 2015)。简单地说,这表明丘脑分为初级和次级核团可能是一阶和二阶统计量分化的表现。

结构神经解剖学很重要,但它只为我们提供了神经处理图像的一部分,因为连接的存在并不能告诉我们太多关于它如何被使用的信息。例如,考虑图5.4中显示的黑质的作用。它对纹状体连通性产生的调节效应支持基底神经节的非常不同的输出,这取决于释放的多巴胺量。这种形式的突触效能的快速调节可以与学习中发生的较慢但更持久的变化形成对比。在本节中,我们关注突触效能可以改变的这两种方式。

精度(precision)是理解神经调节的重要概念(Feldman and Friston 2010)。我们在第4章和上面关于感觉衰减的讨论中涉及了这一点,我们看到它作为预测误差的乘法权重发挥作用。更广泛地说,精度是对概率分布置信度的衡量。两者之间的关系很简单。如果我们对数据如何从隐状态生成有非常精确的信念,那么通过观察数据,我们对隐状态的信念可以比我们对这些信念不确信时更多地得到更新。

图5.4 通过使用POMDP生成模型的基底神经节进行与主动推理相关的策略选择的信息传递的直接和间接通路。来自大脑皮层的通路最终进行策略估计。直接通路(右侧)从皮层到纹状体到内侧苍白球。间接通路(左侧)从皮层到纹状体到外侧苍白球到丘脑下核(STN)到内侧苍白球。两条通路都存在于双侧;此外,显示了黑质致密部(SNpc)调节两者之间的平衡。(注:这是基底神经节连通性的简化。)

当信念更新表现为神经元放电的变化时,更精确的似然分布表现为对给定感觉刺激的神经响应增加。这对于从注意力(Parr and Friston 2019a)到多感觉整合(Limanowski and Friston 2019)的认知功能至关重要。

这种关于突触增益控制的观点告诉我们一些简单但重要的信息。如果精度是生成模型中某个分布的属性,那么应该有与不同分布相关联的不同精度。这在直觉上是合理的,因为我们对感觉的可靠性、事物动态演变的方式,甚至对我们如何行动的把握程度可以有不同的信心(Parr and Friston 2017b)。我们在基底神经节多巴胺能信号传导的背景下看到了最后一点。相关精度越大,我们越有信心我们的策略将最小化预期自由能。

如果多巴胺能系统的作用之一——起源于中脑的黑质致密部和腹侧被盖区——是发出做什么的信心信号,那么其他神经调质系统是否也起类似的作用?表5.1总结了将精度与神经调质系统相关联的证据——以及有时用于这些精度的符号。具体而言,来自Meynert基底核的胆碱能系统似乎发出某些似然分布精度的信号。来自蓝斑的去甲肾上腺素能系统似乎在发出时间转换精度信号方面发挥作用。血清素能系统似乎不太明确,但可能与先验偏好的精度有关。

能够将这些精度与神经调质系统相关联为什么有用?答案有三个方面:它让我们解释观察到的生物学现象,形成假设,并开发无创方法来测量精度。我们将强调这三者的各一个例子。首先,关于对观察到的生物学现象的解释,多巴胺信号的实证测量著名地看起来像”奖励预测误差”(Schultz 1997)——动物的多巴胺在接收到意外的果汁或看到表明即将到来果汁的线索时增加。Active Inference为这些发现提供了另一种解释(Schwartenbeck, FitzGerald, Mathys, Dolan, and Friston 2015)。获得奖励(或满足我们的偏好)或遇到表明未来奖励的线索增强了我们的信心,即我们正在追求一个最小化预期自由能的策略。这种信心的增加表现为多巴胺的峰值。

其次,关于假设的形成,一个例子涉及与路易体痴呆相关的胆碱能信号传导的减少(Parr, Benrimoh et al. 2018)——这种情况导致复杂的视觉幻觉。对此的一个合理解释是,病理学在较高视觉皮层中的积累引起了这些区域的预测与初级视觉皮层活动之间的不匹配。这种不匹配降低了对相关似然分布的信心,并导致胆碱能信号传导的丢失。这种精度丢失的结果是基于感觉数据更新信念的失败,意味着感知失去了由感觉提供的约束。这可以解释这种情况下幻觉知觉的发展。

第三,关于精度参数的无创测量,一个例子是计算表型的识别。中央神经化学活动有许多外周表现,

| 神经递质 | 精度 | 证据 |

|---|---|---|

| 乙酰胆碱 | 似然(ζ) | • 丘脑皮层传入神经上存在突触前受体(Sahin et al. 1992, Lavine et

al. 1997) • 视觉诱发反应增益的调节(Gil et al. 1997, Disney et al. 2007) • 药理学操作下有效连接性的变化(Moran et al. 2013) • 药理学操作下行为反应的建模(Vossel et al. 2014, Marshall et al. 2016) |

| 去甲肾上腺素 | 转换(ω) | •

持续前额叶(延迟期)活动的维持(需要精确的转换概率)依赖于去甲肾上腺素(Arnsten

and Li 2005, Zhang et al. 2013) • 对令人惊讶(即不精确)序列的瞳孔反应(Nassar et al. 2012, Lavín et al. 2013, Liao et al. 2016, Krishnamurthy et al. 2017, Vincent et al. 2019) • 药理学操作下行为反应的建模(Marshall et al. 2016) |

| 多巴胺 | 策略(γ) | • 在纹状体中等棘状神经元上突触后表达(Freund et al. 1984, Yager et

al. 2015) • 计算fMRI揭示中脑活动与精度变化(Schwartenbeck, FitzGerald, Mathys, Dolan, and Friston 2015) • 药理学操作下行为反应的建模(Marshall et al. 2016) |

| 血清素 | 偏好或内感受似然(χ) | • 受体在内侧前额皮层第V层锥体细胞上表达(Aghajanian and Marek 1999,

Lambe et al. 2000, Elliott et al. 2018) • 内侧前额皮层区域深度参与内感受处理和自主调节(Marek et al. 2013, Mukherjee et al. 2016) |

来源: Parr and Friston 2018.

包括自发眨眼率与多巴胺之间的关系(Karson 1983)以及瞳孔大小与去甲肾上腺素之间的关系(Koss 1986)。最近探索后者的工作(Vincent et al. 2019)已经证明了理想贝叶斯观察者预期推断的转换精度与瞳孔收缩和扩张动力学之间的关系。这意味着我们可以通过这种外周测量来探测某人的隐式生成模型(即经验先验信念)。

虽然精度的快速变化很重要,但这是优化有效连接的粗糙方法;它导致信号增益的增加或减少,但仅此而已。如果我们想改变信号的解释方式,我们需要依赖学习。我们将在第7章详细讨论这个问题。然而,基本思想是我们不仅对世界的状态持有信念,还对决定变量间依赖关系的固定(或缓慢变化)参数持有信念(Friston, FitzGerald et al. 2016)。这些信念的基础是表示时变变量(如隐藏状态或结果)的神经群体之间突触连接的效能。当我们观察到一个我们认为是由给定状态生成的结果时,我们可以更新关于连接两者的参数的信念,反映它们在未来共同出现概率的增加。换句话说,我们得到两个神经元群体之间突触的加强。结果就是Hebb的著名格言(意译):“一起激发的细胞,连接在一起。”

图5.1的一个重要特征是,在预测编码和边际消息传递方案中,进入和离开皮层柱的连接都与似然分布相关。相比之下,转换概率和连续动力学取决于微电路内的连接。这表明学习动力学应该导致内在连接的改变,而学习观察模型应该修改外在连接。使用动态因果建模等技术——这些技术允许从神经成像数据评估有效连接测量——可以将这些假设付诸检验(Tsvetanov et al. 2016, Zhou et al. 2018)。这突出了这种过程理论的作用:它们让我们超越抽象理论化,形成具体的可检验假设。

最后,值得强调的是从神经层次结构低层的连续表征转向高层的分类变量。关键在于我们考虑的离散和连续消息传递方案可能在大脑中共存,因为我们能够持有分类类型的信念(例如,识别物体是什么或人是谁),同时能够与连续变化的感觉受体和效应器接口(例如,肌肉长度或视觉亮度对比)。这反映在神经生理学中,一些神经元对特定刺激具有选择性,而其他神经元则与刺激强度成比例地变化。

一个有趣的观察是我们与周围世界的接口在连续域中,这意味着大脑中任何层次结构的最低层必须是连续的。话虽如此,我们在图5.4中看到基底神经节的策略选择可以被框定为一个离散过程,在替代运动之间进行选择。这告诉我们可以将运动视为离散轨迹组合成有目的的行动。虽然最低层可能处理肌肉长度的必要变化,下行输入基于关于进行哪种运动的决定。从生成模型的角度来看,这意味着将关于世界的替代(离散)假设与这些假设所蕴含的(连续)动力学联系起来。在第8章中,我们将从计算角度回到如何将这些结合起来的问题。在这里,我们只是注意到我们离感觉受体越远,在神经系统中越倾向于发现离散化的表征。实际上,神经生理学中经典感受野的存在可以被解释为世界处于感知状态空间某个特定制度的概率表征——一个由感受野平铺并因此分割成许多小类别的状态空间。图5.5将这些方案结合在一起,作为本章提出思想的总结。

本章试图概述第4章生成模型所暗示的消息传递方案与推理、行动和规划的神经生物学之间的连接点。我们通过

图5.5

[推理剖析(基于 Friston, Parr, 和 de Vries 2017)连接了][来自图5.1–5.4的示意图,提供了本章思想的总结。通过皮质和基底神经节的两个层级][循环突出了习惯—基于更高层级输入—与更多情境敏感、目标][导向(探索性和利用性)行为之间的区别,后者由预期自由能][最小化产生。注意关于策略的推理对][s][的影响,实现了][正文中提到的策略下的贝叶斯模型平均。这种从基底神经节到皮质的投射][可能由中间结构(如丘脑)介导。在右侧,基于分类POMDP的消息被转发到][连续预测编码网络中,参与动作生成。每个分类][状态都与连续变量的替代预测相关联,并][对预测误差有贡献。相反方向的消息计算][相关分类结果(][o][)的后验概率,这取决于基于][策略依赖结果(][o][π ][)的先验、关于策略(][π][)的信念,以及][可能从连续水平的后验期望][( ][μ ][)和方差(未显示)计算出的连续轨迹的似然。这里可以][包含更多连接;例如,除了习惯(][E][),目标选择(第4章中的][C][)][本身可能也依赖于更高的层级水平,导致动机的层级][控制(详见 Pezzulo, Rigoli, 和 Friston 2018)。]

[从 http://direct.mit.edu/books/oa-monograph/chapter-pdf/2004458/c004100_9780262369978.pdf 下载,访客于2022年4月2日] [102 ] [[第5章]]

将消息传递与神经元通信联系起来?它允许我们基于我们假设大脑正在反转的生成模型做出经验预测。这可能采取诱发反应的形式—在向大脑呈现感觉刺激时在头皮上可测量的电位变化—其时间过程将取决于该刺激引起的信念更新量。或者,计算神经成像方法可用于将模拟推理与那些表现出相似时间动态的脑区域相关联(Schwartenbeck, FitzGerald, Mathys, Dolan, 和 Friston 2015)。建立这种关联对于理解病理学—以及计算性(即神经性和精神性)疾病的治疗学—很重要,允许从生物学角度表达功能性病理学。

最后,值得承认的是,大脑的很多部分在本章中明显缺席—部分是由于篇幅原因,但也因为神经科学是一个正在进行的工作。有许多机会来扩展(甚至替换)本章给出的描述。在某种程度上,我们可以从这里看到的内容进行外推。例如,杏仁核的某些部分在细胞结构上等同于基底神经节核。这是否意味着有一类策略由杏仁核评估?这个结构对于自主神经系统策略是否就像基底神经节对于骨骼肌肉运动域中的策略一样?其他结构(如枕部)是否对其他(例如心理)类别的策略发挥类似作用?我们应该如何理解与图5.1中六层结构不同的皮质结构?小脑和海马结构各自表现出不同但刻板的微电路(Wesson 和 Wilson 2011)。我们应该将这些视为相同贝叶斯消息传递方案的解剖学重新排列,还是它们处理生成模型的不同方面(Pezzulo, Kemere, 和 van der Meer 2017; Stoianov et al. 2020)?我们提出这些问题不是为了提供任何答案,而是为了突出理论神经生物学未来研究的一些令人兴奋的途径。Active Inference及其相关的过程理论提供了一个严格的形式和概念框架来解决这些问题。

[从 http://direct.mit.edu/books/oa-monograph/chapter-pdf/2004458/c004100_9780262369978.pdf 下载,访客于2022年4月2日]

[给我六个小时砍倒一棵树,我会花前四个小时磨斧子。]

[— 亚伯拉罕·林肯]

本章提供了构建Active Inference模型的四步方法,讨论了实现模型时必须做出的最重要的设计选择,并为这些选择提供了一些指导。它作为本书第二部分的介绍,该部分将说明几个使用Active Inference的特定计算模型及其在各种认知领域中的应用。

由于Active Inference是一种规范性方法,它试图从第一原理尽可能多地解释行为、认知和神经过程。一致地,Active Inference的设计哲学是自上而下的。与计算神经科学的许多其他方法不同,挑战不是逐个模拟大脑,而是找到描述大脑试图解决的问题的生成模型。一旦问题以生成模型的形式得到适当形式化,问题的解决方案就会在Active Inference下出现—伴随着关于大脑和心智的预测。换句话说,生成模型提供了感兴趣系统的完整描述。由此产生的行为、推理和神经动力学都可以通过最小化自由能从模型中导出。

生成建模方法在几个学科中用于认知模型的实现、统计建模、实验数据分析、

和机器学习(Hinton 2007b; Lee and Wagenmakers 2014; Pezzulo, Rigoli, and Friston 2015; Allen et al. 2019; Foster 2019)。在这里,我们主要关注设计能够产生相关认知过程的生成模型。我们在之前的章节中已经看到了这种设计方法。例如,使用预测编码的生成模型,感知被视为对感觉最可能原因的推断;使用在离散时间中演化的生成模型,规划被视为对最可能行动路线的推断。根据关注的问题(例如,空间导航中的规划或视觉搜索中的眼跳规划),人们可以调整这些生成模型的形式,为其配备不同的结构(例如,浅层或分层)和变量(例如,关于配置中心或自我中心空间位置的信念)。重要的是,在对生成模型形式的不同假设下,主动推断可能呈现出许多不同的面貌。例如,关于模型在离散或连续时间中演化的假设会影响消息传递的形式(见第4章)。这意味着生成模型的选择对应于关于行为和神经生物学的具体预测。

这种灵活性很有用,因为它允许我们使用相同的语言来描述多个领域中的过程。然而,从实践角度来看,这也可能令人困惑,因为必须做出许多选择才能找到感兴趣系统的适当描述级别。在本书的第二部分中,我们将通过一系列主动推断计算机模拟的说明性示例来尝试解决这种困惑。本章介绍了设计主动推断模型的一般方法,突出了一些关键的设计选择、区别和对立,这些将在后续章节描述的计算模型数值分析中出现。

设计主动推断模型需要四个基础步骤,每个步骤都解决一个特定的设计问题:

我们在建模哪个系统? 首先要做的选择总是感兴趣的系统。这可能并不像看起来那么简单;它依赖于识别该系统的边界(即马尔可夫毯)。什么算作主动推断代理(生成模型),什么算作外部环境(生成过程),以及它们之间的接口(感觉数据和行动)是什么?

生成模型最适当的形式是什么? 接下来三个实践挑战中的第一个是决定是否更适合从分类(离散)推断或连续推断的角度来思考过程,这促使在主动推断的离散或连续时间实现(或混合)之间做出选择。然后我们需要选择最适当的层次深度,这促使在浅层与深层模型之间做出选择。最后,我们需要考虑是否有必要为生成模型配备时间深度和预测依赖于行动的观察的能力以支持规划。